SAN JOSÉ, Kalifornien, 18. März 2025 /PRNewswire/ — Vention, Entwickler der weltweit einzigen Full-Stack-Software- und Hardware-Automatisierungsplattform, präsentiert seine KI-gestützte Bin-Picking-Technologie erstmals auf der NVIDIA GTC, der weltweit führenden Entwicklerkonferenz für Künstliche Intelligenz (KI).

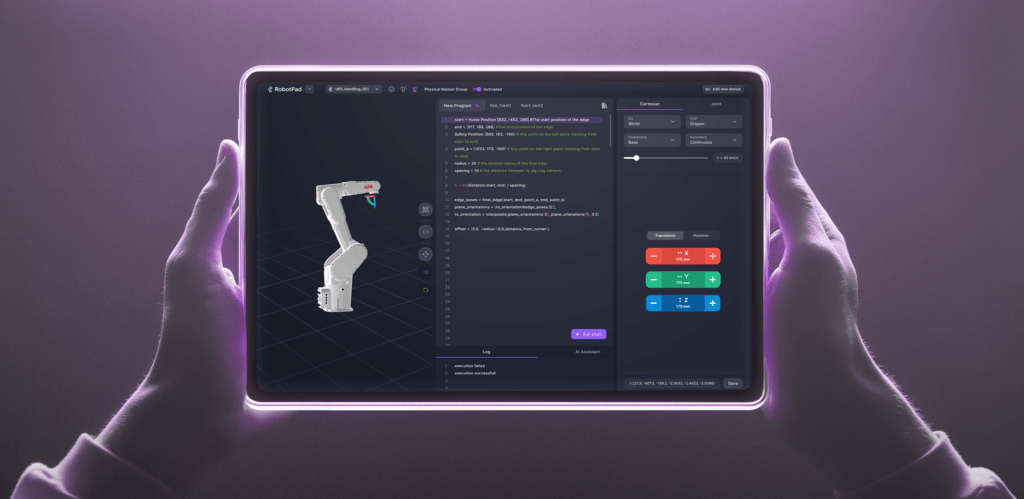

Dieses neue, KI-gesteuerte Verfahren ersetzt aufwendige und kostenintensive individuelle Programmierlösungen und erleichtert Unternehmen die Einführung von Automatisierungstechnologie. Die Markteinführung der KI-gestützten Bin-Picking-Technologie ist im weiteren Verlauf des Jahres geplant.

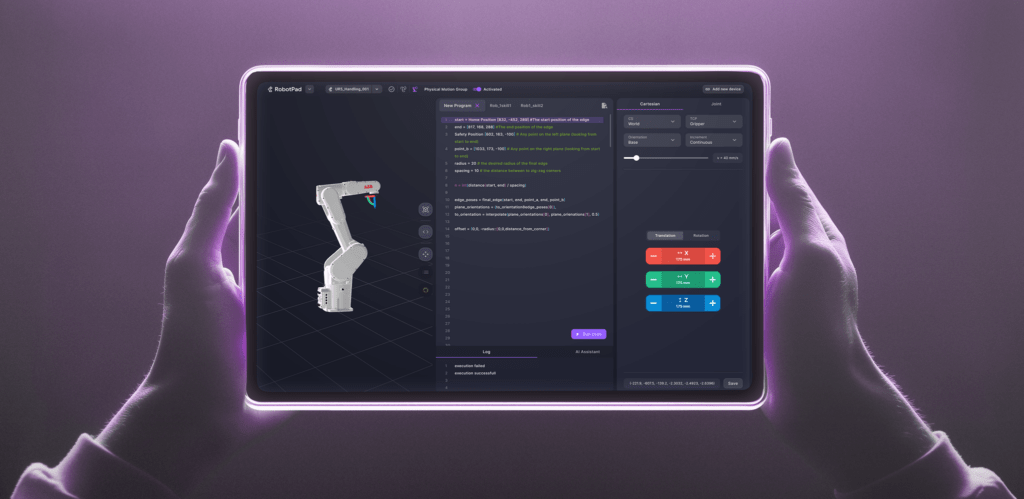

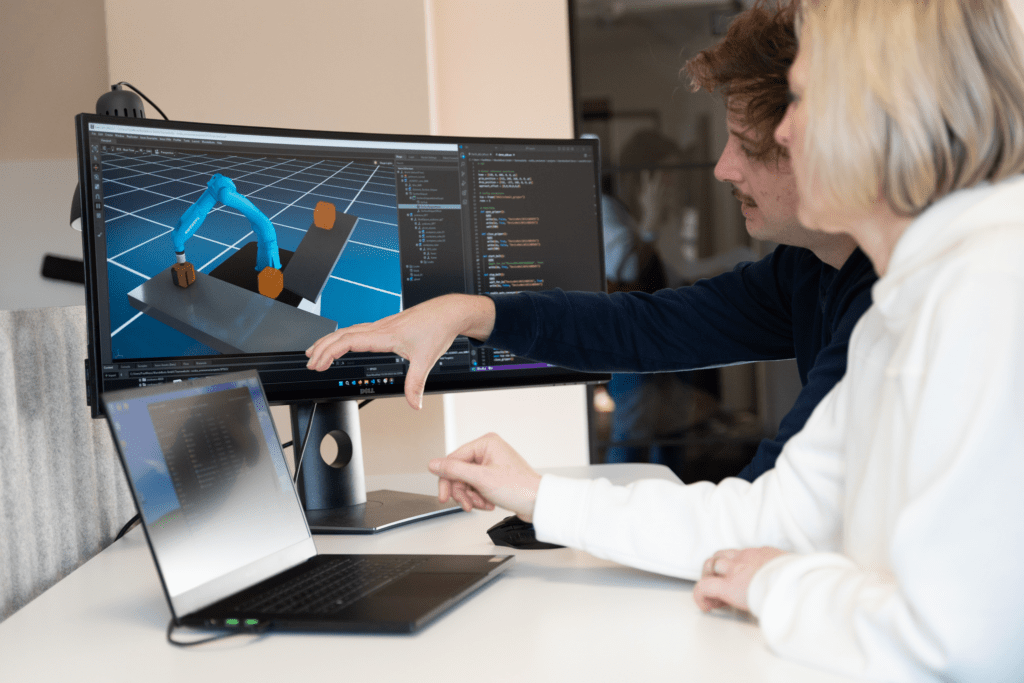

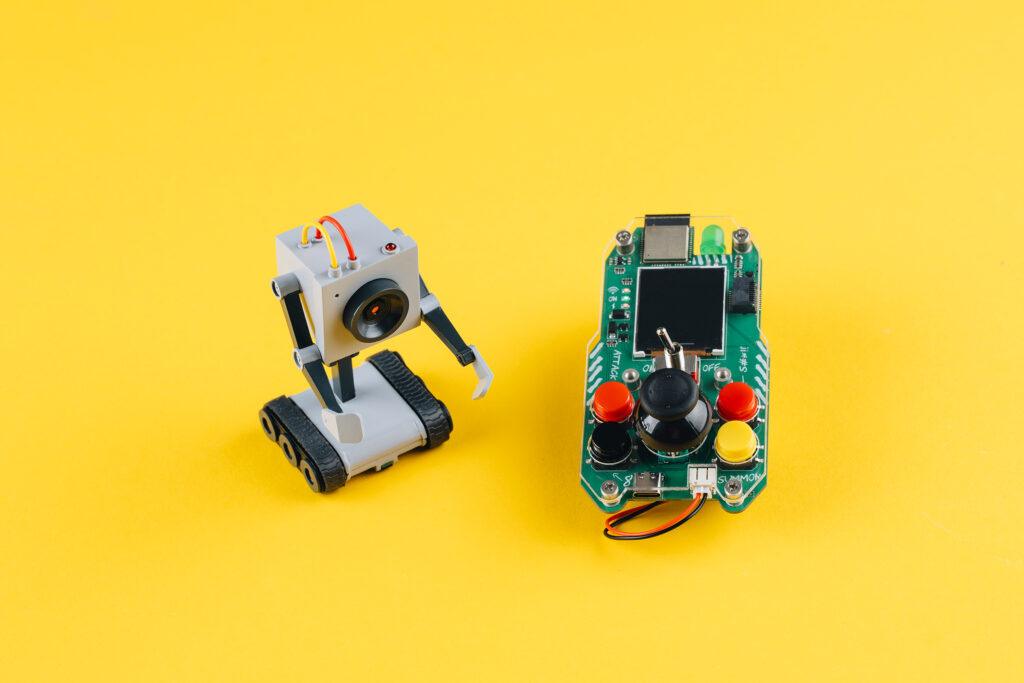

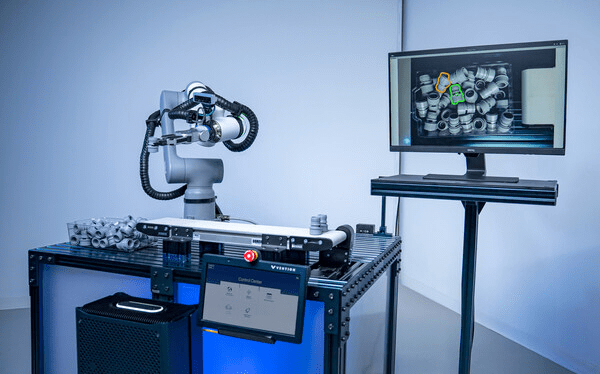

In einer Live-Demonstration wird ein ABB GoFa™ CRB 15000-Roboter – ausgestattet mit einem Vision-System, Finger-Greifern und verbunden mit einem Vention MachineMotion AI-Controller – seine autonomen Fähigkeiten unter Beweis stellen. Mithilfe einer hochgeladenen CAD-Datei des zu verarbeitenden Bauteils versteht der Roboter, wie er das Bauteil erkennen, auswählen, greifen und mit branchenführender Präzision organisieren kann. Diese autonome Funktionalität wird durch leistungsstarke KI-Modelle ermöglicht.

„KI entwickelt sich in rasantem Tempo weiter und hilft Vention dabei, Automatisierung für Unternehmen jeder Größe noch zugänglicher zu machen“, erklärt Etienne Lacroix, Gründer und CEO von Vention. „Unsere neueste Innovation, die Hardware-Integration mit NVIDIA-KI-Modellen kombiniert, geht über reines Identifizieren und Greifen hinaus – sie fügt Intelligenz und Organisation hinzu, wodurch teure Integrations- und Programmieraufwände reduziert werden. Das macht Bin-Picking-Automatisierung für Hersteller erschwinglicher.“

„Generative KI und Simulationstechnologien haben einen Wendepunkt erreicht, um physische KI-Anwendungen in der Produktion voranzutreiben“, sagt Deepu Talla, VP of Robotics bei NVIDIA. „Mit der NVIDIA Isaac Robotics-Plattform bringt Vention die neuesten KI-Innovationen in Fabriken jeder Größe – sowohl für High-Mix- als auch für High-Volume-Fertigung.“

Entdecken Sie hier das KI-gestützte Bin-Picking-Demo-Video.

KI zur Lösung realer Herausforderungen

Die Demonstration ist Teil eines laufenden Entwicklungsprojekts mit McAlpine & Co. Ltd, einem langjährigen Vention-Kunden und führenden britischen Hersteller von Sanitärprodukten mit über 100 Jahren Erfahrung. Das Unternehmen sucht nach einer Automatisierungslösung für Bin-Picking und Maschinenbestückung.

John Gordon, General Manager von McAlpine & Co. Ltd, betont die Herausforderungen, die mit der Automatisierung des Bin-Picking-Prozesses verbunden sind, obwohl es sich auf den ersten Blick um eine einfache Aufgabe handelt: „McAlpine & Co. Ltd war auf der Suche nach einem Automatisierungspartner, dem wir vertrauen können, um unsere Vision umzusetzen: innovative Lösungen, die unseren hohen Qualitätsstandards entsprechen. Im Zentrum dieser Vision steht eine kollaborative Arbeitsumgebung, in der Maschinen arbeitsintensive und repetitive Aufgaben übernehmen, sodass sich unsere Mitarbeiter auf wertschöpfende Tätigkeiten konzentrieren können. Nach dem erfolgreichen Abschluss unseres ersten Automatisierungsprojekts mit Vention sind wir überzeugt, dass nun der richtige Zeitpunkt gekommen ist, um gemeinsam eine hochmoderne, KI-gestützte Bin-Picking-Lösung zu entwickeln.“

Vention Intelligence – Schnellere Wertschöpfung für Hersteller

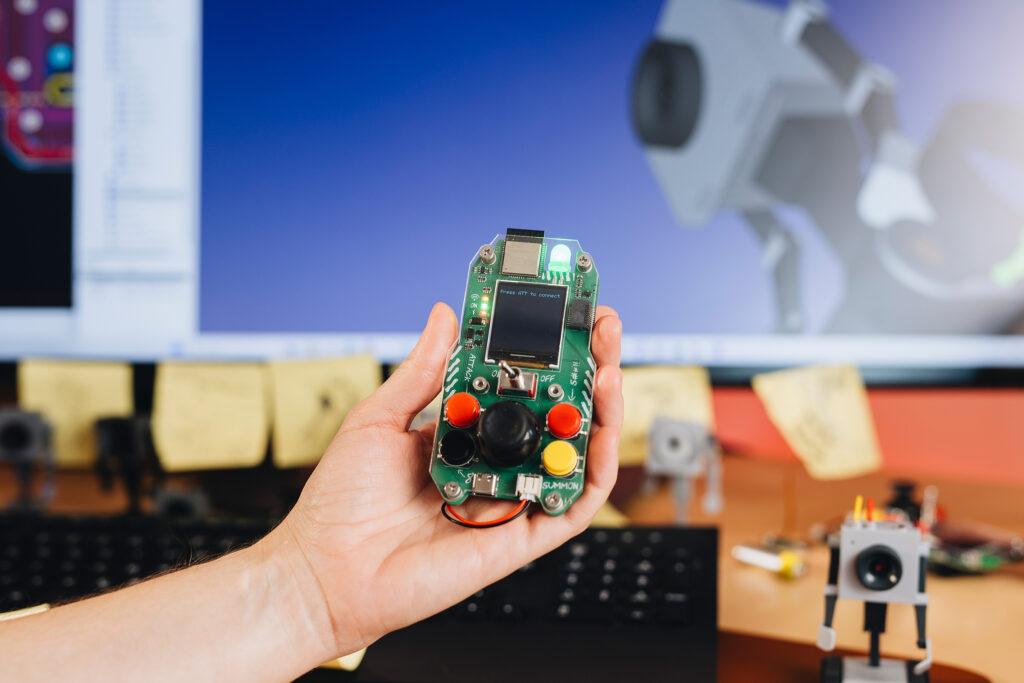

Der MachineMotion AI-Controller von Vention, basierend auf der NVIDIA Jetson Orin Module-on-Compute-Plattform, bildet das Rückgrat der neuen Entwicklung – er ermöglicht die Echtzeitverarbeitung, die für eine autonome Bin-Picking-Automatisierung im industriellen Maßstab erforderlich ist. Dieses Steuerungssystem geht über herkömmliche SPS-basierte Automatisierung hinaus und verkürzt die Implementierungszeit erheblich.

Durch die Integration modernster, KI-gestützter NVIDIA Isaac CUDA-Bibliotheken und Modelle wie FoundationPose stellt Vention sicher, dass Hersteller von den neuesten KI-Fortschritten profitieren, die jetzt in den Markt eintreten.

„Unsere Strategie, KI-Technologien nahtlos in bestehende Automatisierungslösungen zu integrieren, stellt sicher, dass wir neue Modelle schnell in unsere schlüsselfertigen und anpassbaren Arbeitszellen einbinden können – und damit unseren Kunden aus der Fertigungsindustrie einen Wettbewerbsvorteil verschaffen.“ – François Giguère, Chief Technology Officer bei Vention.

Für weitere Informationen besuchen Sie: www.vention.com/autonomous-operator