Mehr Informationen unter: https://www.iais.fraunhofer.de/de/branchen-themen/themen/intelligente-prozessautomatisierung/gen-ai-robotersteuerung.html

Schlagwort-Archive: AI

KI-Gestenerkennung mit IDS NXT Kamera lässt igus ReBel Roboter Stein, Schere, Papier gegen Mensch spielen

Enhancing Drone Navigation with AI and IDS uEye Camera Technology

AI-driven drone from University of Klagenfurt uses IDS uEye camera for real-time, object-relative navigation—enabling safer, more efficient, and precise inspections.

The inspection of critical infrastructures such as energy plants, bridges or industrial complexes is essential to ensure their safety, reliability and long-term functionality. Traditional inspection methods always require the use of people in areas that are difficult to access or risky. Autonomous mobile robots offer great potential for making inspections more efficient, safer and more accurate. Uncrewed aerial vehicles (UAVs) such as drones in particular have become established as promising platforms, as they can be used flexibly and can even reach areas that are difficult to access from the air. One of the biggest challenges here is to navigate the drone precisely relative to the objects to be inspected in order to reliably capture high-resolution image data or other sensor data.

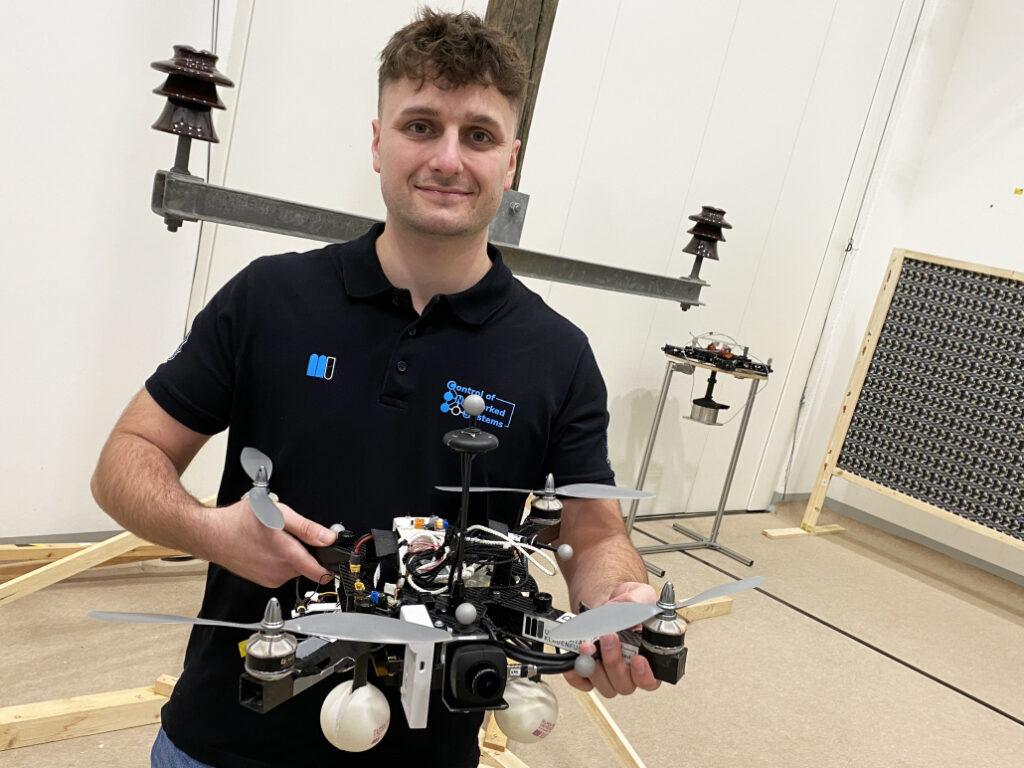

A research group at the University of Klagenfurt has designed a real-time capable drone based on object-relative navigation using artificial intelligence. Also on board: a USB3 Vision industrial camera from the uEye LE family from IDS Imaging Development Systems GmbH.

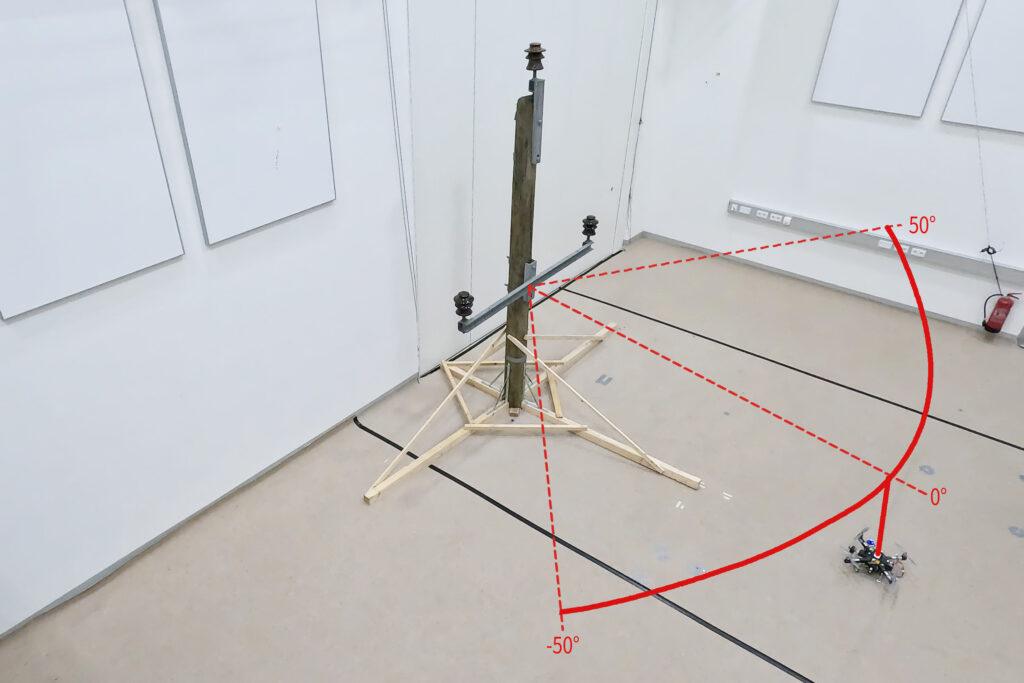

As part of the research project, which was funded by the Austrian Federal Ministry for Climate Action, Environment, Energy, Mobility, Innovation and Technology (BMK), the drone must autonomously recognise what is a power pole and what is an insulator on the power pole. It will fly around the insulator at a distance of three meters and take pictures. „Precise localisation is important such that the camera recordings can also be compared across multiple inspection flights,“ explains Thomas Georg Jantos, PhD student and member of the Control of Networked Systems research group at the University of Klagenfurt. The prerequisite for this is that object-relative navigation must be able to extract so-called semantic information about the objects in question from the raw sensory data captured by the camera. Semantic information makes raw data, in this case the camera images, „understandable“ and makes it possible not only to capture the environment, but also to correctly identify and localise relevant objects.

In this case, this means that an image pixel is not only understood as an independent colour value (e.g. RGB value), but as part of an object, e.g. an isolator. In contrast to classic GNNS (Global Navigation Satellite System), this approach not only provides a position in space, but also a precise relative position and orientation with respect to the object to be inspected (e.g. „Drone is located 1.5m to the left of the upper insulator“).

The key requirement is that image processing and data interpretation must be latency-free so that the drone can adapt its navigation and interaction to the specific conditions and requirements of the inspection task in real time.

Semantic information through intelligent image processing

Object recognition, object classification and object pose estimation are performed using artificial intelligence in image processing. „In contrast to GNSS-based inspection approaches using drones, our AI with its semantic information enables the inspection of the infrastructure to be inspected from certain reproducible viewpoints,“ explains Thomas Jantos. „In addition, the chosen approach does not suffer from the usual GNSS problems such as multi-pathing and shadowing caused by large infrastructures or valleys, which can lead to signal degradation and thus to safety risks.“

How much AI fits into a small quadcopter?

The hardware setup consists of a TWINs Science Copter platform equipped with a Pixhawk PX4 autopilot, an NVIDIA Jetson Orin AGX 64GB DevKit as on-board computer and a USB3 Vision industrial camera from IDS. „The challenge is to get the artificial intelligence onto the small helicopters.

The computers on the drone are still too slow compared to the computers used to train the AI. With the first successful tests, this is still the subject of current research,“ says Thomas Jantos, describing the problem of further optimising the high-performance AI model for use on the on-board computer.

The camera, on the other hand, delivers perfect basic data straight away, as the tests in the university’s own drone hall show. When selecting a suitable camera model, it was not just a question of meeting the requirements in terms of speed, size, protection class and, last but not least, price. „The camera’s capabilities are essential for the inspection system’s innovative AI-based navigation algorithm,“ says Thomas Jantos. He opted for the U3-3276LE C-HQ model, a space-saving and cost-effective project camera from the uEye LE family. The integrated Sony Pregius IMX265 sensor is probably the best CMOS image sensor in the 3 MP class and enables a resolution of 3.19 megapixels (2064 x 1544 px) with a frame rate of up to 58.0 fps. The integrated 1/1.8″ global shutter, which does not produce any ‚distorted‘ images at these short exposure times compared to a rolling shutter, is decisive for the performance of the sensor. „To ensure a safe and robust inspection flight, high image quality and frame rates are essential,“ Thomas Jantos emphasises. As a navigation camera, the uEye LE provides the embedded AI with the comprehensive image data that the on-board computer needs to calculate the relative position and orientation with respect to the object to be inspected. Based on this information, the drone is able to correct its pose in real time.

The IDS camera is connected to the on-board computer via a USB3 interface. „With the help of the IDS peak SDK, we can integrate the camera and its functionalities very easily into the ROS (Robot Operating System) and thus into our drone,“ explains Thomas Jantos. IDS peak also enables efficient raw image processing and simple adjustment of recording parameters such as auto exposure, auto white Balancing, auto gain and image downsampling.

To ensure a high level of autonomy, control, mission management, safety monitoring and data recording, the researchers use the source-available CNS Flight Stack on the on-board computer. The CNS Flight Stack includes software modules for navigation, sensor fusion and control algorithms and enables the autonomous execution of reproducible and customisable missions. „The modularity of the CNS Flight Stack and the ROS interfaces enable us to seamlessly integrate our sensors and the AI-based ’state estimator‘ for position detection into the entire stack and thus realise autonomous UAV flights. The functionality of our approach is being analysed and developed using the example of an inspection flight around a power pole in the drone hall at the University of Klagenfurt,“ explains Thomas Jantos.

Precise, autonomous alignment through sensor fusion

The high-frequency control signals for the drone are generated by the IMU (Inertial Measurement Unit). Sensor fusion with camera data, LIDAR or GNSS (Global Navigation Satellite System) enables real-time navigation and stabilisation of the drone – for example for position corrections or precise alignment with inspection objects. For the Klagenfurt drone, the IMU of the PX4 is used as a dynamic model in an EKF (Extended Kalman Filter). The EKF estimates where the drone should be now based on the last known position, speed and attitude. New data (e.g. from IMU, GNSS or camera) is then recorded at up to 200 Hz and incorprated into the state estimation process.

The camera captures raw images at 50 fps and an image size of 1280 x 960px. „This is the maximum frame rate that we can achieve with our AI model on the drone’s onboard computer,“ explains Thomas Jantos. When the camera is started, an automatic white balance and gain adjustment are carried out once, while the automatic exposure control remains switched off. The EKF compares the prediction and measurement and corrects the estimate accordingly. This ensures that the drone remains stable and can maintain its position autonomously with high precision.

Outlook

„With regard to research in the field of mobile robots, industrial cameras are necessary for a variety of applications and algorithms. It is important that these cameras are robust, compact, lightweight, fast and have a high resolution. On-device pre-processing (e.g. binning) is also very important, as it saves valuable computing time and resources on the mobile robot,“ emphasises Thomas Jantos.

With corresponding features, IDS cameras are helping to set a new standard in the autonomous inspection of critical infrastructures in this promising research approach, which significantly increases safety, efficiency and data quality.

The Control of Networked Systems (CNS) research group is part of the Institute for Intelligent System Technologies. It is involved in teaching in the English-language Bachelor’s and Master’s programs „Robotics and AI“ and „Information and Communications Engineering (ICE)“ at the University of Klagenfurt. The group’s research focuses on control engineering, state estimation, path and motion planning, modeling of dynamic systems, numerical simulations and the automation of mobile robots in a swarm: More information

Model used:USB3 Vision Industriekamera U3-3276LE Rev.1.2

Camera family: uEye LE

Image rights: Alpen-Adria-Universität (aau) Klagenfurt

© 2025 IDS Imaging Development Systems GmbH

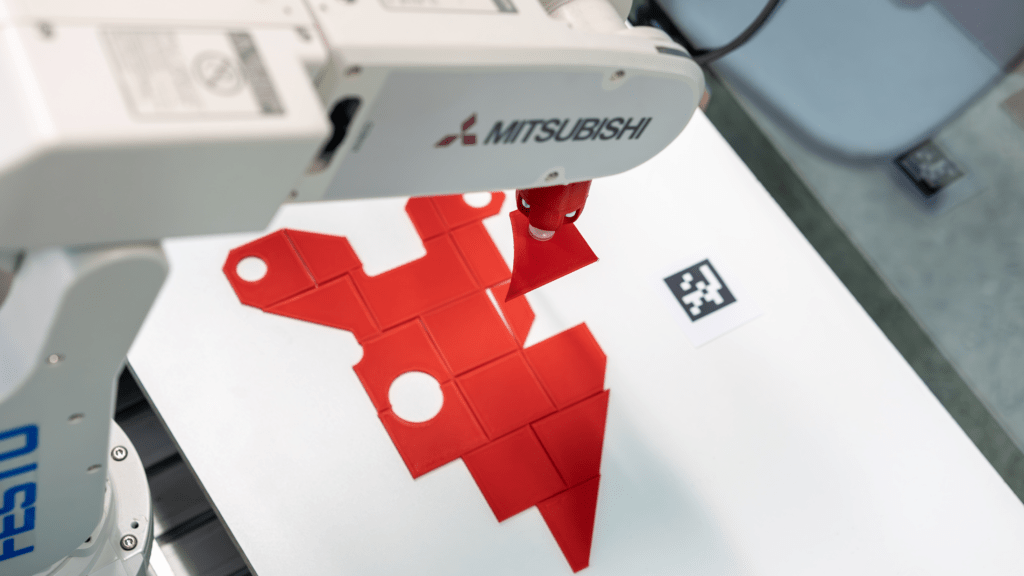

Roboter automatisiert Pick-and-Place-Prozesse mit KI-gestützter Bildverarbeitung

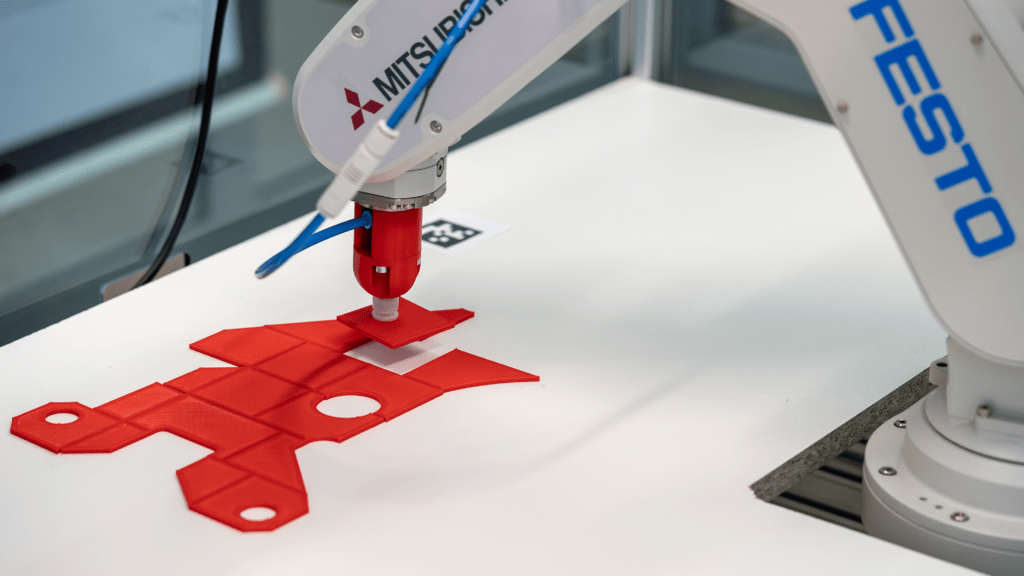

Pick-and-Place-Anwendungen sind ein zentrales Einsatzgebiet der Robotik. Sie werden häufig in der Industrie genutzt, um Montageprozesse zu beschleunigen und manuelle Tätigkeiten zu reduzieren – ein spannendes Thema für Informatik Masteranden des Instituts für datenoptimierte Fertigung der Hochschule Kempten. Sie entwickelten einen Roboter, der Prozesse durch den Einsatz von künstlicher Intelligenz und Computer Vision optimiert. Auf Basis einer Montagezeichnung ist das System in der Lage, einzelne Bauteile zu greifen und an vorgegebener Stelle abzulegen – vergleichbar mit einem Puzzle. Anschließend können die Teile dort manuell durch einen Mitarbeiter verklebt werden.

Zwei IDS Industriekameras liefern die nötigen Bildinformationen

Mithilfe von zwei uEye XC Kameras und einer KI-gestützten Bildverarbeitung analysiert das System die Umgebung und berechnet präzise Aufnahme- sowie Ablagekoordinaten. Eine der Kameras wurde dazu über der Arbeitsfläche platziert, die andere über der Entnahmestelle. Konkret verarbeitet eine KI-Pipeline die Bilder der beiden Kameras in mehreren Schritten, um die exakte Lage und Ausrichtung der Objekte zu bestimmen. Mithilfe der Computer-Vision-Algorithmen und neuronalen Netzen erkennt das System relevante Merkmale, berechnet die optimalen Greifpunkte und generiert präzise Koordinaten für die Aufnahme und Ablage der Objekte. Zudem identifiziert das System die Teile eindeutig, indem es ihre Oberfläche segmentiert und die Konturen mit einer Datenbank abgleicht. Darüber hinaus nutzt es die Ergebnisse, um eine Annäherung an bereits abgelegte Teile zu ermöglichen. Die Automatisierungslösung reduziert damit die Abhängigkeit von Expertenwissen, verkürzt Prozesszeiten und wirkt dem Fachkräftemangel entgegen.

Kameraanforderungen

Schnittstelle, Sensor, Baugröße und Preis waren die Kriterien, die für die Wahl des Kameramodells entscheidend waren. Die uEye XC kombiniert die Benutzerfreundlichkeit einer Webcam mit der Leistungsfähigkeit einer Industriekamera. Sie erfordert lediglich eine Kabelverbindung für den Betrieb. Ausgestattet mit einem 13-MP-onsemi-Sensor (AR1335) liefert die Autofokus-Kamera hochauflösende Bilder und Videos. Eine wechselbare Makro-Aufsatzlinse ermöglicht eine verkürzte Objektdistanz, wodurch die Kamera auch für Nahbereichsanwendungen geeignet ist. Auch ihre Einbindung war denkbar einfach, wie Raphael Seliger, Wissenschaftlicher Mitarbeiter der Hochschule Kempten, erklärt: „Wir binden die Kameras über die IDS peak Schnittstelle an unser Python Backend an.“

Ausblick

Zukünftig soll das System durch Reinforcement Learning weiterentwickelt werden – einer Methode des maschinellen Lernens, die auf Lernen durch Versuch und Irrtum beruht. „Wir möchten gerne die KI-Funktionen ausbauen, um die Pick-and-Place Vorgänge intelligenter zu gestalten. Unter Umständen benötigen wir dafür eine zusätzliche Kamera direkt am Roboterarm“, erläutert Seliger. Geplant ist zudem eine automatische Genauigkeitsprüfung der abgelegten Teile. Langfristig soll der Roboter allein anhand der Montagezeichnung alle erforderlichen Schritte eigenständig ausführen können.

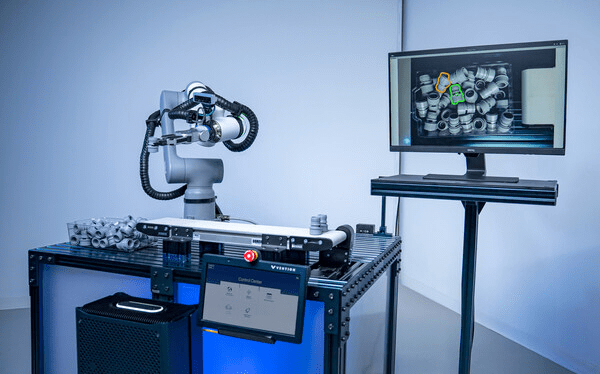

Vention stellt KI-gestützte Bin-Picking-Technologie vor – Live auf der NVIDIA GTC 2025

SAN JOSÉ, Kalifornien, 18. März 2025 /PRNewswire/ — Vention, Entwickler der weltweit einzigen Full-Stack-Software- und Hardware-Automatisierungsplattform, präsentiert seine KI-gestützte Bin-Picking-Technologie erstmals auf der NVIDIA GTC, der weltweit führenden Entwicklerkonferenz für Künstliche Intelligenz (KI).

Dieses neue, KI-gesteuerte Verfahren ersetzt aufwendige und kostenintensive individuelle Programmierlösungen und erleichtert Unternehmen die Einführung von Automatisierungstechnologie. Die Markteinführung der KI-gestützten Bin-Picking-Technologie ist im weiteren Verlauf des Jahres geplant.

In einer Live-Demonstration wird ein ABB GoFa™ CRB 15000-Roboter – ausgestattet mit einem Vision-System, Finger-Greifern und verbunden mit einem Vention MachineMotion AI-Controller – seine autonomen Fähigkeiten unter Beweis stellen. Mithilfe einer hochgeladenen CAD-Datei des zu verarbeitenden Bauteils versteht der Roboter, wie er das Bauteil erkennen, auswählen, greifen und mit branchenführender Präzision organisieren kann. Diese autonome Funktionalität wird durch leistungsstarke KI-Modelle ermöglicht.

„KI entwickelt sich in rasantem Tempo weiter und hilft Vention dabei, Automatisierung für Unternehmen jeder Größe noch zugänglicher zu machen“, erklärt Etienne Lacroix, Gründer und CEO von Vention. „Unsere neueste Innovation, die Hardware-Integration mit NVIDIA-KI-Modellen kombiniert, geht über reines Identifizieren und Greifen hinaus – sie fügt Intelligenz und Organisation hinzu, wodurch teure Integrations- und Programmieraufwände reduziert werden. Das macht Bin-Picking-Automatisierung für Hersteller erschwinglicher.“

„Generative KI und Simulationstechnologien haben einen Wendepunkt erreicht, um physische KI-Anwendungen in der Produktion voranzutreiben“, sagt Deepu Talla, VP of Robotics bei NVIDIA. „Mit der NVIDIA Isaac Robotics-Plattform bringt Vention die neuesten KI-Innovationen in Fabriken jeder Größe – sowohl für High-Mix- als auch für High-Volume-Fertigung.“

Entdecken Sie hier das KI-gestützte Bin-Picking-Demo-Video.

KI zur Lösung realer Herausforderungen

Die Demonstration ist Teil eines laufenden Entwicklungsprojekts mit McAlpine & Co. Ltd, einem langjährigen Vention-Kunden und führenden britischen Hersteller von Sanitärprodukten mit über 100 Jahren Erfahrung. Das Unternehmen sucht nach einer Automatisierungslösung für Bin-Picking und Maschinenbestückung.

John Gordon, General Manager von McAlpine & Co. Ltd, betont die Herausforderungen, die mit der Automatisierung des Bin-Picking-Prozesses verbunden sind, obwohl es sich auf den ersten Blick um eine einfache Aufgabe handelt: „McAlpine & Co. Ltd war auf der Suche nach einem Automatisierungspartner, dem wir vertrauen können, um unsere Vision umzusetzen: innovative Lösungen, die unseren hohen Qualitätsstandards entsprechen. Im Zentrum dieser Vision steht eine kollaborative Arbeitsumgebung, in der Maschinen arbeitsintensive und repetitive Aufgaben übernehmen, sodass sich unsere Mitarbeiter auf wertschöpfende Tätigkeiten konzentrieren können. Nach dem erfolgreichen Abschluss unseres ersten Automatisierungsprojekts mit Vention sind wir überzeugt, dass nun der richtige Zeitpunkt gekommen ist, um gemeinsam eine hochmoderne, KI-gestützte Bin-Picking-Lösung zu entwickeln.“

Vention Intelligence – Schnellere Wertschöpfung für Hersteller

Der MachineMotion AI-Controller von Vention, basierend auf der NVIDIA Jetson Orin Module-on-Compute-Plattform, bildet das Rückgrat der neuen Entwicklung – er ermöglicht die Echtzeitverarbeitung, die für eine autonome Bin-Picking-Automatisierung im industriellen Maßstab erforderlich ist. Dieses Steuerungssystem geht über herkömmliche SPS-basierte Automatisierung hinaus und verkürzt die Implementierungszeit erheblich.

Durch die Integration modernster, KI-gestützter NVIDIA Isaac CUDA-Bibliotheken und Modelle wie FoundationPose stellt Vention sicher, dass Hersteller von den neuesten KI-Fortschritten profitieren, die jetzt in den Markt eintreten.

„Unsere Strategie, KI-Technologien nahtlos in bestehende Automatisierungslösungen zu integrieren, stellt sicher, dass wir neue Modelle schnell in unsere schlüsselfertigen und anpassbaren Arbeitszellen einbinden können – und damit unseren Kunden aus der Fertigungsindustrie einen Wettbewerbsvorteil verschaffen.“ – François Giguère, Chief Technology Officer bei Vention.

Für weitere Informationen besuchen Sie: www.vention.com/autonomous-operator

Robots-Blog showing all the robots at Spielwarenmesse Nuremberg 2025

Noch schneller zum günstigen Robotiksystem: Neuer KI-Roboterberater für RBTX.com ist online

Interaktiver KI-Berater nutzt Anwendungsdatenbank und verkürzt die Suche nach Komponenten für kostengünstige Roboterlösungen

Köln, 11. Dezember 2024 – igus hat die Online-Plattform RBTX.com um einen neuen KI-Chatbot erweitert. Der interaktive Berater soll es Unternehmen mit wenig Vorerfahrung und technologischem Know-how ermöglichen, schnell und sicher Low-Cost-Automationslösungen zusammenzustellen, um ihre Wettbewerbsfähigkeit zu stärken. Erste User zeigen sich von der intuitiven KI-Lösung begeistert.

Viele Unternehmen wissen bereits, dass Automation enorme Potenziale bietet, um den Herausforderungen einer sich schnell verändernden Arbeitswelt zu begegnen. Doch die entscheidende Frage bleibt: Wie setzt man sie um? RBTX liefert die Antwort: Auf dem Online-Marktplatz finden sich über 500 Roboterlösungen, von denen 95 Prozent weniger als 12.000 Euro kosten. Hier können auch Unternehmen ohne Vorkenntnisse in der Robotik kostengünstige Low-Cost-Automation-Lösungen (LCA) nach dem Plug-and-Programme-Prinzip zusammenstellen. „Mit RBTX wollen wir Schritt für Schritt alle Barrieren aus dem Weg räumen, die Unternehmen beim Einstieg in die Automation im Weg liegen“, sagt Alexander Mühlens, Prokurist und Leiter Geschäftsbereich Low-Cost-Automation bei igus. Entscheidend ist hier beispielsweise, für eine garantierte Interoperabilität aller angebotenen Komponenten zu sorgen, die Fehlkäufe nahezu unmöglich macht. „Ein weiterer Schritt auf diesem Weg ist nun die Einführung eines neuen KI-Beraters, der mit Interessierten in Interaktion tritt, um die Suche nach Komponenten in einem immer größer werdenden Sortiment zu verkürzen.“

KI-Berater arbeitet mit Erfahrungsdaten hunderter erfolgreicher LCA-Projekte

Der neue KI-Chatbot auf https://chat.rbtx.de unterstützt Nutzer durch eine schriftliche Interaktion dabei, passende LCA-Komponenten zu finden. Dabei greift die Künstliche Intelligenz auf die Erfahrungsdaten von hunderten Projekten zurück, die Unternehmen mithilfe von RBTX bereits erfolgreich automatisiert haben. Entsprechend zielführend sind die Antworten. Ein Beispiel: Eine kleine Werkstatt leidet unter Arbeitskräftemangel und möchte die Beladung ihrer CNC-Maschine mit Rohlingen automatisieren. Der Technikleiter des Betriebs bemüht den neuen KI-Chatbot und stellt ihm die Frage: „Welcher Roboter eignet sich für die Beladung meiner CNC-Maschine?“ Innerhalb weniger Sekunden liefert die KI die Antwort: „Der robolink Roboterarm von igus wäre hier eine geeignete Lösung. Der Arm bewegt sich über fünf Achsen, hat eine Reichweite von 790 Millimetern, eine Geschwindigkeit von sieben Picks pro Minute und kann die Lage der Bauteile mithilfe einer 3D-Kamera wahrnehmen. Der Preis beginnt bei 2.766 Euro.“ Nach dieser Antwort fragt der Nutzer, welcher Greifer passend wäre. Der KI-Berater antwortet: „Ein Parallelgreifer von Zimmer wäre eine geeignete Wahl.“ In einem solchen natürlich anmutenden Dialog stellen sich Nutzer sukzessive ihre individuelle LCA-Lösung zusammen.

„Erste Nutzer zeigen sich vom neuen KI-Berater begeistert“

Unternehmen, die mit Automation experimentieren, geben sich vom neuen KI-Chatbot begeistert. „Viele Kunden haben uns bereits das Feedback gegeben, dass sie mit dem KI-Roboterberater in einen Dialog getreten sind. Er hat ihnen ein besseres Gespür für die Möglichkeiten der Low-Cost-Automation gegeben und die Suche nach den passenden Komponenten wesentlich beschleunigt“, freut sich Mühlens. „Wir planen deshalb, den KI-Berater in Zukunft um zusätzliche Funktionen zu erweitern.“ So soll es beispielsweise möglich sein, dass der Berater Bilder und Videomaterial von Referenzen in seine Antworten einbettet und LCA-Komplettlösungen mit einem Richtpreis entwickeln kann.

Avishkaar Game Builder

The Avishkaar Game Builder is a platform specifically designed for young developers to enable them to create AI-powered games. This platform offers an intuitive user interface based on visual, block-based programming. This makes it easily accessible even for beginners who have no prior knowledge of programming. The platform not only encourages learning programming skills but also creativity and problem-solving skills.

A special feature of the Avishkaar Game Builder is the integration of AI elements into game development. Users can create games that respond to gestures or body movements, enabling an interactive and innovative gaming experience. This is supported by the AMS Play system that leverages advanced technologies such as motion detection.

The platform is primarily aimed at children aged 10 and above and offers numerous tutorials and learning resources to help them get started. Through this playful approach to technology, young people will not only learn the basics of game development but also advanced concepts such as artificial intelligence and animation.

Avishkaar Game League 2024

The Avishkaar Game League 2024 is an international competition aimed at young developers and encourages them to showcase their skills in game development. This year’s edition is themed ‚Rise of the Machines‘ and revolves around the theme ‚AI Becomes Self-Reliant‘. Participants are expected to develop games that incorporate the concept of AI getting out of control.

India’s 1st AI Powered Game Design Engine for Kids

The competition aims to encourage creativity and innovation. Teams from different countries compete against each other using the Avishkaar Game Builder and the AMS Play system to develop their games. The competition provides a platform for collaboration and exchange between young developers worldwide.

Competition structure

– **Registration:** Registration for the Avishkaar Game League 2024 started on October 25, 2024.

– **Theme:** „Rise of the Machines“ – Participants develop games around the topic of AI.

– **Platform:** Participants use the AMS Play Game Builder to create their games.

– **Prizes:** In addition to trophies and medals, winners can also win gadgets, mentoring sessions and other valuable prizes.

Aims of the competition

The competition not only promotes technical knowledge in the areas of programming and AI, but also important soft skills such as teamwork, problem solving and creativity. By developing games, participants learn how to use modern technologies in a hands-on way.

The **Avishkaar Game Builder** offers children an exciting opportunity to immerse themselves in the world of game development while leveraging modern technologies such as AI. The **Avishkaar Game League 2024** complements this learning platform with an international competition that brings young talents together and gives them a stage to showcase their skills. Both initiatives help nurture future innovators and prepare them for a technological future.

To participate in the competition challenge free of charge, use the code „ROBOTSBLOG“

India’s 1st AI Powered Game Design Engine for Kids

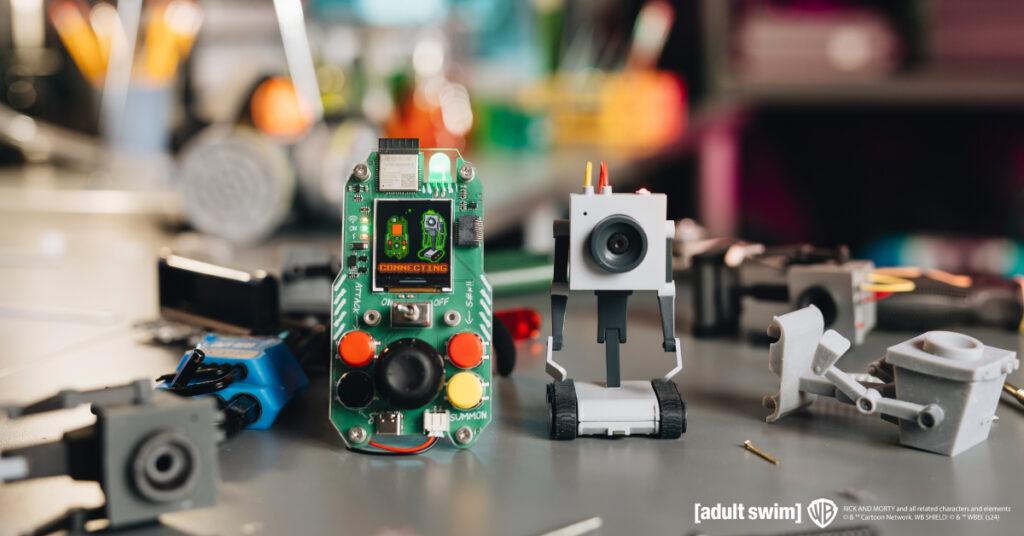

Geek Club und CircuitMess bringen dir deinen eigenen Rick & Morty Butter Bot

Nach einer Reihe erfolgreicher Kickstarter-Kampagnen haben sich Geek Club und CircuitMess erneut zusammengeschlossen, um ein aufregendes neues Projekt zu starten: ein AI-gesteuerter Tischroboter, der speziell für Fans von Rick und Morty entwickelt wurde.

Zagreb, Kroatien – November 2024 – Geek Club und CircuitMess freuen sich, den offiziellen Start ihrer Kickstarter-Kampagne für den Butter Bot bekannt zu geben, einen revolutionären Roboter, der von künstlicher Intelligenz gesteuert wird. Er ist inspiriert vom berühmten Roboter aus der beliebten Adult Swim-Serie Rick und Morty, der erstmals in Staffel 1, Folge 9 zu sehen war. Dieses innovative Produkt ist offiziell von Warner Bros. Discovery Global Consumer Products (WBDGCP) lizenziert, wodurch der kultige Butter Bot auf eine Weise zum Leben erweckt wird, wie es Fans noch nie zuvor gesehen haben.

Vom Bildschirm in die Realität: Eine Partnerschaft, die den Butter Bot zum Leben erweckt

Die gemeinsame Liebe zur Serie Rick und Morty unter den Teams von CircuitMess und Geek Club führte zu diesem Projekt. Beide Unternehmen erkannten die Gelegenheit, einen geliebten Charakter auf eine Weise zum Leben zu erwecken, die sowohl der Serie treu bleibt als auch technologisch innovativ ist. Sie wählten den Butter Bot aufgrund seines ikonischen Status und seines Potenzials für interaktive, lehrreiche und unterhaltsame Anwendungen. Durch die Umwandlung eines einfachen Butter-überreichenden Roboters in einen multifunktionalen AI-Begleiter wollten sie ein Produkt schaffen, das sowohl bei Fans als auch bei Technikbegeisterten Anklang findet und nahtlos Humor und Funktionalität miteinander verbindet.

Von Mars bis Multiversum: Das nächste Kapitel für CircuitMess und Geek Club

Diese Zusammenarbeit war ein logischer Schritt für beide Unternehmen nach dem großen Erfolg des vorherigen Kickstarter-Projekts – dem NASA Perseverance AI-powered Mars Rover. Beide Unternehmen erstellen lehrreiche STEM-DIY-Kits für Kinder und Erwachsene, um das Erlernen von STEM-Fähigkeiten einfacher und unterhaltsamer zu gestalten. Während sich CircuitMess hauptsächlich auf Spielzeuge konzentriert, sind die Produkte von Geek Club immer robotik- und raumfahrtthemenbezogen.

„Die Zusammenarbeit mit WBDGCP bei diesem Projekt war ein spannender nächster Schritt in unserer Partnerschaft mit CircuitMess“, sagt Nico, Mitbegründer von Geek Club, und teilt seine Begeisterung: „Der Butter Bot ist ein Beweis dafür, was passiert, wenn Kreativität, Technologie und Fan-Leidenschaft aufeinandertreffen. Wir freuen uns darauf, die Unterstützung und das Engagement der Community zu erleben, während wir unsere Kickstarter-Kampagne starten.“

Geek Club ist ein amerikanisches Unternehmen, das sich auf das Design und die Herstellung von DIY-Roboterbausätzen spezialisiert hat, die ihre Nutzer in Löten und Elektronik schulen. Ihr Fokus liegt hauptsächlich auf Raumfahrt und Robotik, mit dem Ziel, das Erlernen von Ingenieursfähigkeiten für ihr junges und erwachsenes Publikum einfach und unterhaltsam zu machen.

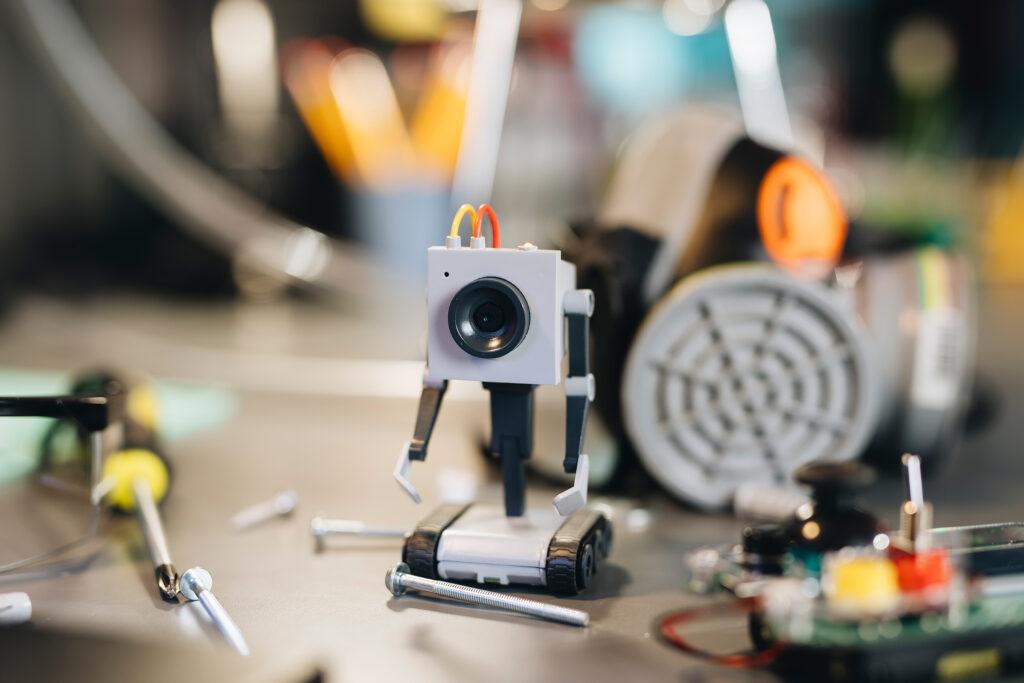

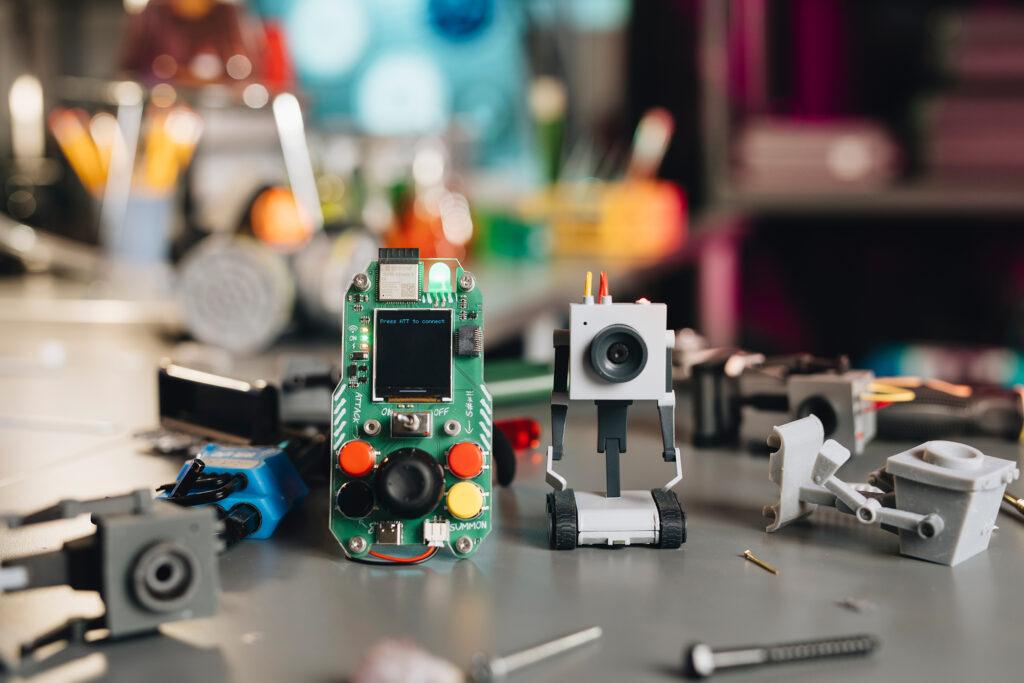

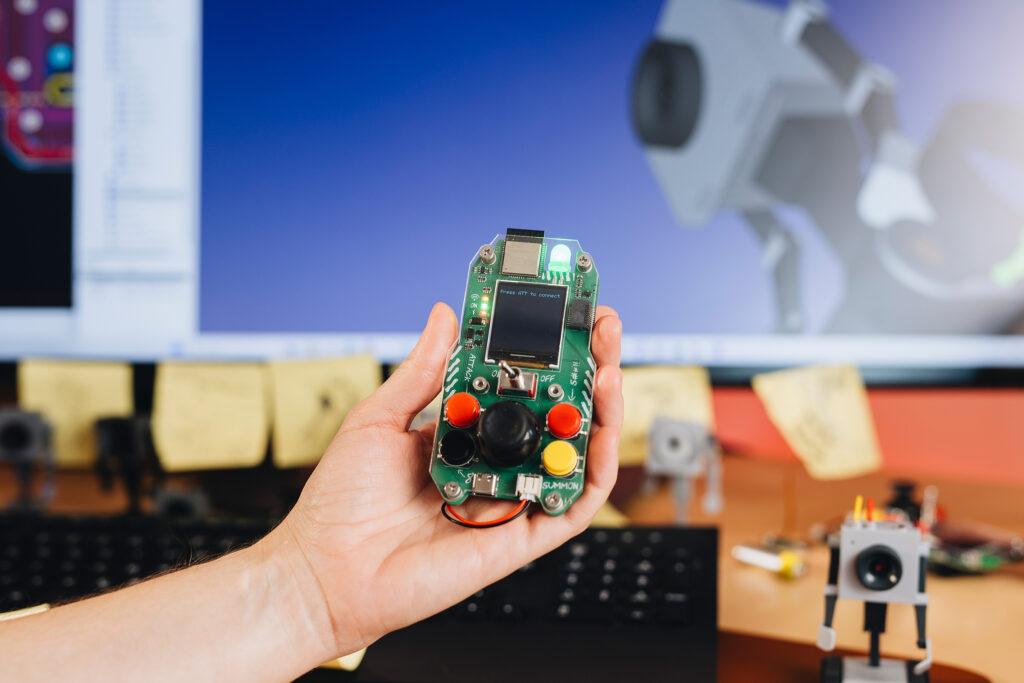

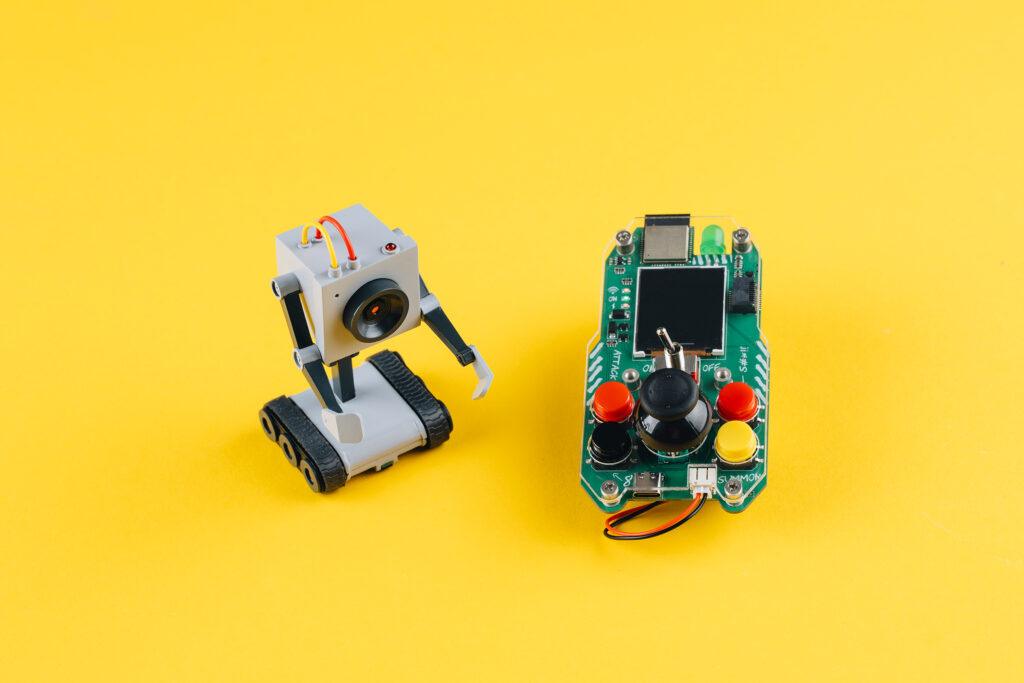

Mehr als Butter: Vorstellung des AI-gesteuerten Butter Bot

Der Butter Bot ist nicht nur ein einfacher Roboter, dessen einzige Aufgabe es ist, wie in der Serie Butter zu überreichen. Er wird mit einer einzigartigen Fernbedienung geliefert, die präzises Manövrieren ermöglicht und gleichzeitig eine Live-Übertragung von der Kamera des Roboters bietet. Dieser interaktive Roboter verfügt über fortschrittliche AI-Funktionen und ist damit ein vielseitiger Begleiter in jeder Umgebung.

„Den Butter Bot aus Rick und Morty in die reale Welt zu bringen, war eine unglaubliche Reise“, sagt Albert Gajšak, CEO von CircuitMess, und drückt seine Begeisterung für den Launch aus: „Wir haben viel Herzblut in die Entwicklung eines Produkts gesteckt, das nicht nur dem Originalcharakter Ehre macht, sondern auch eine völlig neue Ebene der Interaktivität und Funktionalität hinzufügt. Wir können es kaum erwarten zu sehen, wie die Fans ihn nutzen und genießen werden.“

Bis heute hat CircuitMess zahlreiche lehrreiche Produkte entwickelt, die Kinder und Erwachsene dazu ermutigen, zu erschaffen, anstatt nur zu konsumieren. Sie haben erfolgreich 7 Kickstarter-Kampagnen abgeschlossen und tausende Geeks weltweit glücklich gemacht. Die Kits von CircuitMess sind eine einzigartige Kombination von Ressourcen, um auf unterhaltsame und aufregende Weise etwas über Hardware und Software zu lernen.

Die Kickstarter-Kampagne für den Butter Bot bietet Unterstützern exklusive Frühbucherpreise und spezielle Belohnungen.

Für weitere Informationen und zur Unterstützung des Projekts besuchen Sie die Kickstarter-Seite von Butter Bot hier (https://www.kickstarter.com/projects/albertgajsak/rick-and-mortytm-butter-bot-an-ai-powered-desk-robot) oder schauen Sie sich die Websites von Geek Club und CircuitMess an, um alle anderen Kits zu sehen.

Über Geek Club

Geek Club ist ein Team von Designern und Ingenieuren, das von den Mitbegründern Nicolas Deladerrière und Nikita Potrashilin geleitet wird. Ihre Mission ist es, elektronische Konstruktionskits für neugierige Köpfe in über 70 Ländern weltweit zu entwickeln. Ihre Inspiration kommt meist von der NASA und anderen Weltraumagenturen der Welt, und sie hoffen, den Geist ihrer Fans weiter zu fördern, ihre Fähigkeiten zu stärken und ihr Wissen über Elektronik und Weltraum zu erweitern.

Ihre Vision ist es, mit ihren weltraumthematischen STEM-Kits eine Welt von Erfindern für die nächste Technologiegeneration zu schaffen. Mehr erfahren Sie unter www.geekclub.com.

Nicolas Deladerrière, Mitbegründer von Geek Club

E-Mail: [email protected]

Über CircuitMess

CircuitMess ist ein Technologie-Startup, das 2017 von Albert Gajšak und Tomislav Car nach einer erfolgreichen Kickstarter-Kampagne für MAKERbuino gegründet wurde.

CircuitMess beschäftigt junge, ehrgeizige Menschen und ist kürzlich in ein neues Büro in der kroatischen Hauptstadt Zagreb umgezogen. Dort suchen sie nach talentierten Einzelpersonen, die ihnen helfen, einzigartige elektronische Produkte zu entwickeln und Technologie auf unterhaltsame und aufregende Weise für die breite Masse zugänglich zu machen. Mehr erfahren Sie unter www.circuitmess.com.

Albert Gajšak, Mitbegründer und CEO von CircuitMess

E-Mail: [email protected]

Über Rick and Morty

Rick und Morty ist eine Emmy®-preisgekrönte halbstündige animierte Hitkomödie des Senders Adult Swim, die einem soziopathischen genialen Wissenschaftler folgt, der seinen von Natur aus ängstlichen Enkel auf gefährliche Abenteuer im ganzen Universum mitnimmt. Rick Sanchez lebt bei der Familie seiner Tochter Beth und bringt ständig ihren Ehemann Jerry, ihre Enkelin Summer und ihren Enkel Morty in intergalaktische Eskapaden.

In den Hauptrollen spielen Ian Cardoni, Harry Belden, Sarah Chalke, Chris Parnell und Spencer Grammer.

Über Warner Bros. Discovery Global Consumer Products

Warner Bros. Discovery Global Consumer Products (WBDGCP), Teil der Revenue & Strategy-Abteilung von Warner Bros. Discovery, erweitert das mächtige Portfolio der Unterhaltungsmarken und -franchises des Unternehmens in das Leben der Fans auf der ganzen Welt. WBDGCP arbeitet weltweit mit erstklassigen Lizenznehmern an preisgekrönten Programmen für Spielzeug, Mode, Wohnkultur und Verlagswesen, die von den größten Franchises der Warner Bros.-Film-, Fernseh-, Animations- und Spiele-Studios, HBO, Discovery, DC, Cartoon Network, HGTV, Eurosport, Adult Swim und mehr inspiriert sind.

Mit innovativen globalen Lizenz- und Merchandising-Programmen, Einzelhandelsinitiativen und Werbepartnerschaften ist WBDGCP eine der führenden Organisationen für Lizenzierung und Einzelhandelsmerchandising weltweit.