Mehr Informationen unter: https://www.iais.fraunhofer.de/de/branchen-themen/themen/intelligente-prozessautomatisierung/gen-ai-robotersteuerung.html

Archiv der Kategorie: Development

Robots-Blog trifft Alexander Mühlens und igus ersten humanoiden Roboter „Iggy Rob“ auf der automatica

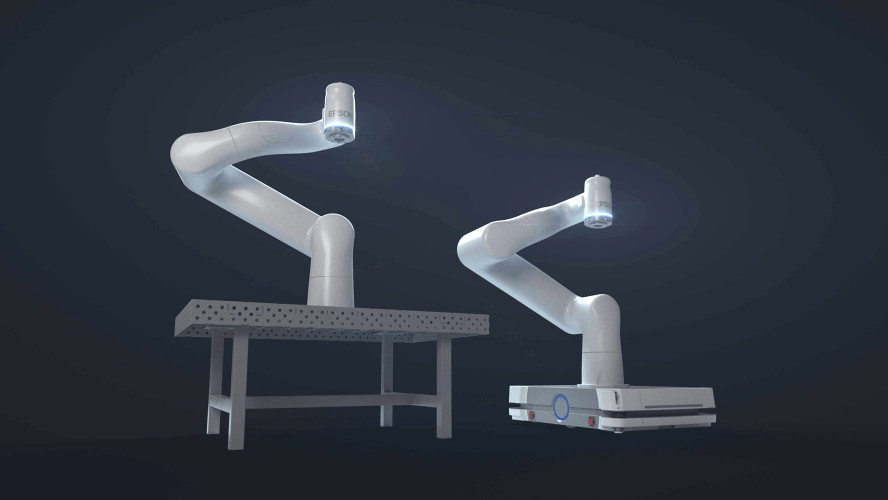

Volker Spanier präsentiert neuen Epson 6-Achs-Roboter Cobot AX6 im Robots-Blog Interview auf automatica 2025

KI-Gestenerkennung mit IDS NXT Kamera lässt igus ReBel Roboter Stein, Schere, Papier gegen Mensch spielen

Automatica 2025: Vention erweitert Angebot mit Robotiklösungen von Franka Robotics

MÜNCHEN, 17. Juni 2025 /PRNewswire/ — Vention, Anbieter der weltweit einzigen vollständig integrierten Software- und Hardware-Plattform für industrielle Automatisierung, erweitert sein Robotik-Portfolio um kollaborative Roboter der Franka Robotics GmbH, einer Tochtergesellschaft der in München ansässigen Agile Robots SE.

- Vention hat sein Roboterangebot um kollaborative Roboter der Franka Robotics GmbH erweitert, einem in Deutschland ansässigen Hersteller von Präzisions-Cobots, die in der Forschung und Entwicklung beliebt sind.

- Vention und Franka Robotics zeigen auf der Automatica PCB-Tests mit einem Franka Research 3 (FR3)-Roboter für die präzise und sichere Automatisierung empfindlicher Elektronik.

- Darüber hinaus präsentiert Vention KI-gestütztes Bin-Picking und ein All-in-One-Steuerungssystem für Bewegung, Bildverarbeitung, Sensorik und KI.

- MachineMotion™ AI, Ventions Steuerung der dritten Generation, feiert ihre Europapremiere mit einer KI-gestützten Bin-Picking-Demonstration auf einem ABB GoFa – inklusive intelligenter Teileerkennung und Greifpräzision im Submillimeterbereich.

- Modulare Roboterzellen für Maschinenbestückung und Palettierung werden ebenfalls gezeigt – mit führenden Robotermarken wie Universal Robots und FANUC.

- Besucher von Stand B4.307 erhalten kostenlosen Zugang zu MachineBuilder 101™, dem neuen Zertifikatskurs von Vention zur Planung, Simulation und Inbetriebnahme von Automatisierungslösungen auf der Vention-Plattform.

Franka Robotics hat sich mit seinem beliebten FR3-Roboterarm als führende Plattform in der akademischen Forschung etabliert und ist mittlerweile die bevorzugte Wahl für Doktoranden, KI-Forscher und Robotik-Labore. Mit der Aufnahme von Franka Robotics-Anwendungen in das eigene Portfolio erweitert Vention sein Angebot gezielt, um der starken Nachfrage von Hochschulen, Forschungseinrichtungen und innovationsgetriebenen Unternehmen gerecht zu werden, die bereits im Vention-Ökosystem arbeiten.

Vention präsentiert auf der Automatica 2025 (vom 24. bis 27. Juni) in München erstmalig eine Live-Demonstration mit einem FR3-Roboter von Franka Robotics (Stand B4.307).

„Wir sind stolz, Franka Robotics im Vention-Ökosystem begrüßen zu dürfen“, sagt Francois Giguere, Chief Technology Officer von Vention. „Der sehr gute Ruf von Franka Robotics im akademischen Umfeld passt perfekt zu unserer Mission, die industrielle Automatisierung zugänglicher und intuitiver zu gestalten. Wir freuen uns über die Zusammenarbeit mit einer angesehenen deutschen Marke – Deutschland hat die Geschichte von Vention von Anfang an maßgeblich geprägt, und diese Partnerschaft markiert ein spannendes neues Kapitel auf unserem Weg.“

„Die Partnerschaft mit Vention ermöglicht es uns, die Reichweite unseres Roboters Franka Research 3 einem breiteren Anwenderkreis im akademischen Bereich und in innovativen Anwendungen zugänglich zu machen“, erklärt Henrik Hermann, Vertriebsleiter bei Franka Robotics. „Gemeinsam setzen wir uns dafür ein, innovative, benutzerfreundliche Automatisierungslösungen zu liefern, die unseren Kunden neue Möglichkeiten in der Robotik und KI eröffnen.“

Der FR3 ist ein benutzerfreundlicher, kompakter und leichter (18 kg) Roboterarm mit sieben Freiheitsgraden. Er ist sicher, hochflexibel und damit ideal für Laborumgebungen mit begrenztem Platzangebot. Dank seiner drehmomentgeregelten Gelenke verfügt er über eine Echtzeit-Kraftsensorik, mit der er Kräfte wahrnehmen und darauf reagieren kann. Dies ist entscheidend für die Forschung zur Mensch-Roboter-Interaktion, das Lernen durch Demonstration sowie die Durchführung kontaktintensiver Aufgaben mit empfindlichen Komponenten.

Vention auf der Automatica 2025

Vention zeigt auf der Automatica insgesamt vier Live-Demonstrationen, die die vollständig integrierte Automatisierungsplattform des Unternehmens in der Praxis erlebbar machen – durch die Kombination aus intuitiver Software, modularer Hardware und den KI-gestützten Funktionen von MachineMotion™ AI.

MachineMotion™ KI & NVIDIA-Technologie – Leistungsstarke Bewegungssteuerung

Nach der NVIDIA GTC 2025 und der Automate in den USA stellt Vention seine KI-gestützten Bin-Picking-Demonstration mit einem ABB GoFa CRB 15000 erstmals auf einer europäischen Messe vor. Auf Basis von MachineMotion™ AI, NVIDIA Jetson Computing sowie CUDA-beschleunigten Isaac-Bibliotheken und -Modellen von NVIDIA deckt die Live-Demonstration von Vention fortschrittliche Robotik, KI-basierte Bewegungssteuerung und skalierbare Schulungsszenarien ab – und zeigt, welchen konkreten Mehrwert KI bei der praktischen Implementierung robotergestützter Lösungen in der Fertigung bietet. Die Anwendung erreicht eine Greifgenauigkeit im Submillimeterbereich bei ungeordneten Fertigungsteilen – ideal für High-Mix-/Low-Volume-Produktionsumgebungen.

Modulare Demos für praxisnahe Anwendungen

Im Rahmen Automatica wird Vention den FR3-Arm von Franka Robotics bei Leiterplattentests auf einer Vention-Workstation vorführen und die Präzision und schonende Handhabung für empfindliche Elektronik und feinmotorische Aufgaben demonstrieren.

Darüber hinaus erleben Besucher vollständig integrierte, anpassbare Roboterzellen für:

- 7th Axis Range Extender – für mehr Reichweite und Flexibilität bei Anwendungen wie Maschinenbestückung, Montage und Verpackung.

- Rapid Series Palletizer – aufgebaut auf einer Teleskopsäule und optimiert mit der neuesten Version 4.5 der MachineApp-Software von Vention.

Die Live-Demonstrationen finden in Halle B4, Stand 307 statt.

Weitere Informationen auf Vention.com.

automatica 2025: erster kollaborativer Roboter von Epson

Düsseldorf, 10. Juni 2025 – Epson, ein führender Anbieter von Roboter- und Automatisierungstechnik, stellt auf der automatica 2025 seine erste kollaborative Industrieroboterlösung vor. Diese ermöglicht in Branchen wie Fertigung, Logistik und dem sich schnell entwickelnden Life-Science-Sektor eine wirkungsvolle Interaktion zwischen Mensch und Maschine und steigert so die Effizienz und Produktivität. Die Lösung wird ab Herbst 2025 als erstes kollaboratives Roboter-Komplettpaket von Epson angeboten, welches den neuen, aus Carbon-Leichtbau bestehenden 6-Achs-Roboter AX6-A901S sowie die kompakte Epson RC-A101-Steuerung inklusive dem Programmiersystem AX-Portal umfasst.

„In den stark wachsenden Bereichen Biowissenschaften und pharmazeutische Industrie sind präzise Arbeitsabläufe und ein strenges Hygienemanagement von größter Bedeutung“, erklärt Volker Spanier, Head of Manufacturing Solutions von Epson. „Um auch diese Anforderungen zu erfüllen, ist der neue kollaborative Roboter von Epson reinraumtauglich. Dank seiner präzisen Bewegungen erlaubt die Maschine daher auch in Laboren und pharmazeutischen Einrichtungen die Verrichtung selbst komplizierter Aufgaben.“

Wichtige Produktmerkmale des kollaborativen Roboters AX6-A901S von Epson:

- Ausbalanciertes Design: Der AX6-A901S bewegt eine Nutzlast von bis zu 6 kg bei einer Armlänge von 900 mm. Er besitzt ein besonders leichtes und kompaktes Design, sodass sowohl sein Transport als auch seine Integration in bestehende Produktionslinien sehr einfach sind. Dank der kompakten Abmessungen lässt er sich auch in beengten Umgebungen einsetzen.

- Kompakter und leichter Controller: Der Epson RC-A101-Controller ist für die Installation auf fahrerlosen Transportfahrzeugen (AGVs) und autonomen, mobilen Robotern (AMRs) geeignet. Er hat die Abmessungen B 440 x T 205 x H 135 mm und wiegt weniger als 6 kg. Auch dieses kompakte Design ermöglicht eine sehr platzsparende Installation.

- Kompatibel zu verschiedenen Stromquellen: Der kollaborative Roboter ist mit Stromquellen von 100 bis 230 VAC bzw. 48 VDC kompatibel, sodass er in Umgebungen mit verschiedenen Stromquellen installiert werden kann.

- Reinraumkompatibilität: Der AX6-A901S besitzt die Reinraumklasse 5 nach ISO 14644-1 und die Schutzart IP54. Das glatte Gehäusedesign ohne Schraubenlöcher und scharfe Kanten minimiert die Staubansammlung und damit das Kontaminationsrisiko in Reinraumumgebungen.

- Python-Programmierung: Die Programmierumgebung unterstützt die weit verbreitete Programmiersprache Python. Diese Kompatibilität vereinfacht die Integration in alle F&E-Umgebungen und die Inbetriebnahme. Auch wird so das Erlernen einer neuen Programmiersprache unnötig.

Spanier fasst zusammen: „Epsons Engagement für die Weiterentwicklung der Robotik resultiert in diesem kollaborativen Roboter, der auch sehr komplexe Aufgaben sicher ausführt. Damit erfüllen wir die wachsende Nachfrage der Labor- und Pharmaindustrie und weiteren Branchen. Diese Maschine stellt einen bedeutenden Fortschritt auf dem Weg zur Verbesserung des Epson Angebotes im Bereich der industriellen Automatisierung dar. Unsere Roboter erfüllen dabei auch die strikten Anforderungen des Life-Science-Sektors und gewährleisten Sicherheit und Präzision bei jeder Interaktion zwischen Mensch und Maschine.“

Zu den neuen Robotern gibt es am 24. Juni eine Pressekonferenz am Epson Stand 311 in Halle B5

Weitere Informationen zu den Robotiklösungen von Epson:

automatica 2025 | Epson Europe

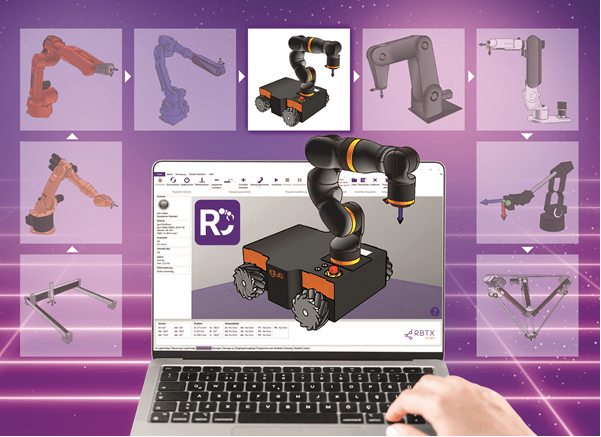

RobotCtrl: Einfachere Steuerung für alle Robotik-Hersteller

Die igus Steuerungssoftware für herstellerunabhängige Robotik wächst – Lebai, Hitbot und Lynx Motion jetzt verfügbar

Köln, 3. Juni 2025 – Automatisierung muss nicht kompliziert sein – mit RobotCtrl wird sie für Unternehmen jeder Größe noch zugänglicher. Durch die intuitive Steuerungssoftware von igus lassen sich auf dem Online-Robotik-Marktplatz RBTX erhältliche Roboter unabhängig vom Hersteller einheitlich bedienen und Zubehör wie Kameras, Greifer oder Roboterzellen integrieren. Damit reduziert RobotCtrl die Bedienungskomplexität und den Integrationsaufwand für Einsteiger und Profis erheblich. Neu hinzugekommen ist die Unterstützung der Robotikhersteller Lebai, Hitbot und Lynx Motion.

Als führender Marktplatz für Robotik und Automatisierung vereint RBTX über 175 Anbieter und mehr als 850 Roboter und Komponenten an einem Ort. Ob Greifer, Sensoren oder komplette Robotersysteme – hier finden Interessierte alles, was sie für ihre Automatisierung benötigen. Mit der von igus entwickelten RobotCtrl wird die Integration und Steuerung von Low-Cost-Automatisierung noch flexibler und einfacher als je zuvor. Auf RBTX erhältliche Roboter können mit der Software einheitlich programmiert und gesteuert werden. Nutzer profitieren von einer verringerten Einarbeitungszeit, da sie nur eine einzige Software beherrschen müssen. Die Möglichkeit, Roboter verschiedenster Hersteller mit nur einer Steuerung zu programmieren, spart allerdings nicht nur Zeit und Schulungskosten, sondern eröffnet Unternehmen auch neue Möglichkeiten für eine herstellerunabhängige Automatisierungsstrategie. Dank des modularen Aufbaus unterstützt RobotCtrl verschiedene Roboterkinematiken unterschiedlicher Hersteller, darunter igus, Fanuc, KUKA und viele mehr. Dies ermöglicht eine nahtlose Integration verschiedener Robotiksysteme in bestehende Produktions- und Automatisierungslösungen. Die Bewegungsabläufe der Roboter können auf einer 3D-Oberfläche simuliert werden – ohne dass der Roboter physisch angeschlossen sein muss. „Dies erleichtert die Planung und Entwicklung neuer Prozesse und ermöglicht es Automatisierungsstrategien effizient zu testen bevor sie in die Praxis umgesetzt werden“, macht Alexander Mühlens, Leiter Geschäftsbereich Low-Cost-Automation bei igus, deutlich. „Unternehmen können somit schneller auf Marktanforderungen reagieren, Produktionsprozesse effizienter gestalten und so Kosten sparen.“

Roboter-Programmierung leicht gemacht

RobotCtrl wurde bereits erfolgreich mit führenden Herstellern getestet. Nutzer können somit sicher sein, dass sie mit einer bewährten und zuverlässigen Software arbeiten. Ein weiterer Vorteil von RobotCtrl ist die benutzerfreundliche grafische Oberfläche, die eine intuitive Programmierung erlaubt. Dank einer Drag-and-Drop-Funktion können Bewegungsabläufe einfach erstellt und angepasst werden. Dies reduziert den Programmieraufwand und macht die Software auch für Anwender ohne tiefgehende Programmierkenntnisse leicht verständlich. Besonders für kleine und mittelständische Unternehmen, die bisher vor der Komplexität der Robotik zurückgeschreckt sind, bietet RobotCtrl eine praxisnahe und kosteneffiziente Lösung. „Unser Ziel ist es, Automatisierung so einfach und zugänglich wie möglich zu gestalten“, stellt Alexander Mühlens heraus. „Mit RobotCtrl ermöglichen wir Unternehmen jeder Größe, einen kostengünstigen und flexiblen Einstieg in die Automatisierung.“

Weitere Informationen zu RobotCtrl und mehr als 650 erfolgreich durchgeführte Anwendungsbeispiele finden sich auf der Plattform RBTX: rbtx.com

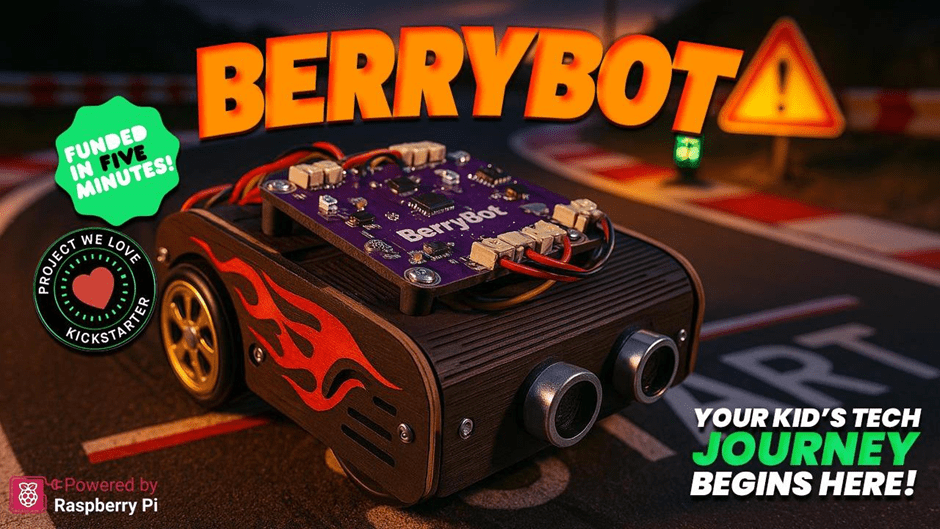

BerryBot: STEM Education for Young Engineers with a wooden robot

Robotistan, a pioneer in innovative educational solutions, has introduced a new STEM robot called BerryBot. Designed to help children develop coding and robotics skills, this creative and educational robot offers practical experiences in science, technology, engineering, and mathematics (STEM).

A New Era in Robotics Education

BerryBot is more than just a robot; it’s a learning platform that nurtures creativity and problem-solving skills. With its compact and customizable design, BerryBot allows users to paint and personalize their robot, thanks to its wooden body.

The wooden structure not only reflects an eco-friendly design approach but also allows children to shape their robots according to their own style. BerryBot is designed to be flexible enough for both classroom and home use.

Key Features

BerryBot’s innovative features support the development of both technical and creative skills:

- Customizable Wooden Body:

- Kids can paint their robots to reflect their unique style.

- Durable and sustainable construction.

- Versatile Coding Options:

- Block-based programming for beginners.

- Advanced programming with Python and Arduino IDE.

- User-friendly interface for an easy learning process.

- Multi-Mode Movement:

- Line-following, sumo, and free movement modes.

- Real-time visual feedback via the LED matrix display.

- Wireless control through Bluetooth connectivity.

An Educational Tool Combining Coding Skills with Creativity

BerryBot offers young aspiring engineers a fun and educational experience. While creating different movement scenarios, children not only enhance their problem-solving skills but also develop creative projects.

Thanks to BerryBot’s multi-mode structure, users can program the robot’s movement capabilities in various ways. This feature transforms BerryBot from being just a toy to a valuable educational tool that encourages creative thinking.

Mehmet Akçalı, Marketing and Product Director at Robotistan, highlighted the educational features of BerryBot:

„BerryBot offers a practical and fun way for children to step into the world of STEM. Combining coding skills with creative projects, this robot will become an indispensable educational tool for both teachers and parents.“

He also mentioned a special opportunity for early supporters:

„We’re thrilled to announce our Kickstarter campaign, where backers can take advantage of the Early Bird offer. Additionally, as part of our commitment to supporting STEM education, for every 10 pledges, we will gift one BerryBot to a school or an educational organization in need. This way, our supporters not only get an amazing educational robot but also help inspire the next generation of young innovators.“

Shaping the Engineers of the Future

As the importance of STEM education continues to grow, innovative tools like BerryBot are preparing young minds for the future. With its fun yet educational nature, BerryBot strengthens children’s coding, algorithmic thinking, and problem-solving skills while also inspiring creative projects.

Robotistan emphasizes that BerryBot is not just an educational robot but also a platform where children can express themselves. Produced with this vision in mind, BerryBot is ready to make a difference both at home and in educational environments.

To learn more about BerryBot and to be among the first to own it and take advantage of the Early Bird offer, visit the Kickstarter page!

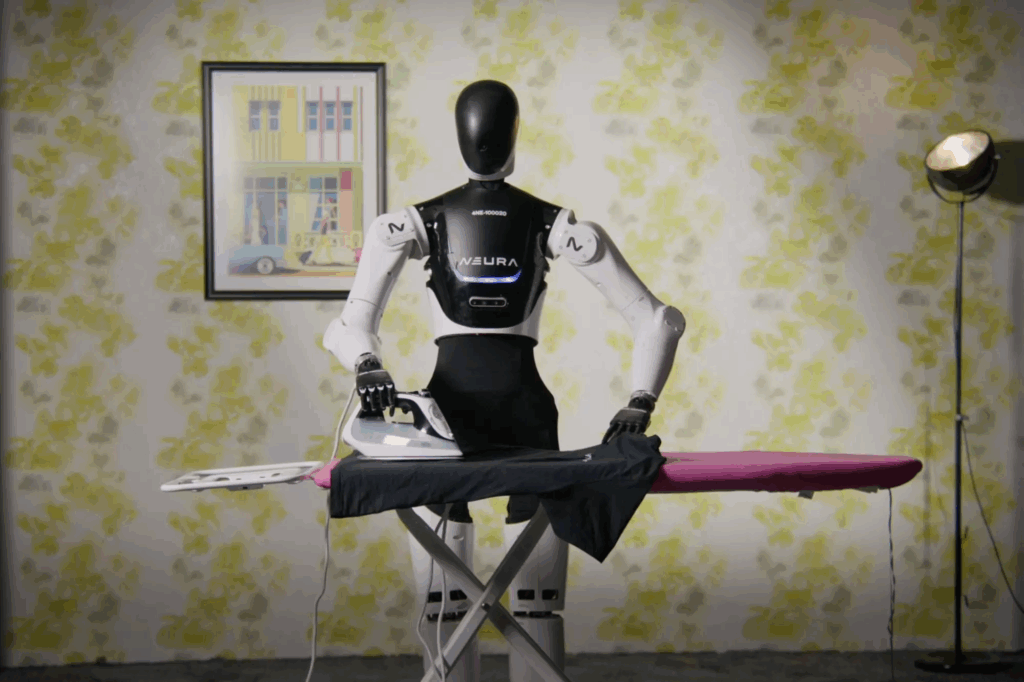

Men in Blech statt Mann am Band: Ambitionierte Ziele für die Massenfertigung von Humanoiden

Die Entwicklung im Bereich humanoider Roboter schreitet mit einer beeindruckenden Dynamik voran. Das Kräftemessen zwischen den USA und China sowie Fortschritte im Bereich der KI, der Batterieentwicklung und der Mechanik befeuern die Performance der Men in Blech. Auf der automatica wird deutlich werden, wie weit diese Entwicklung bereits fortgeschritten ist.

Was die Humanoiden im Reich der Mitte zu leisten im Stande sind, konnten sie jüngst bei einem Halbmarathon in Peking unter Beweis stellen. Auf der gut 21 Kilometer langen Laufstrecke traten rund 20 humanoide Roboter erfolgreich gegen Menschen an. Mit dem Wettlauf hat die Volksrepublik ihr Ziel erreicht, sich als einer der führenden Anbieter menschenähnlicher Roboter zu präsentieren.

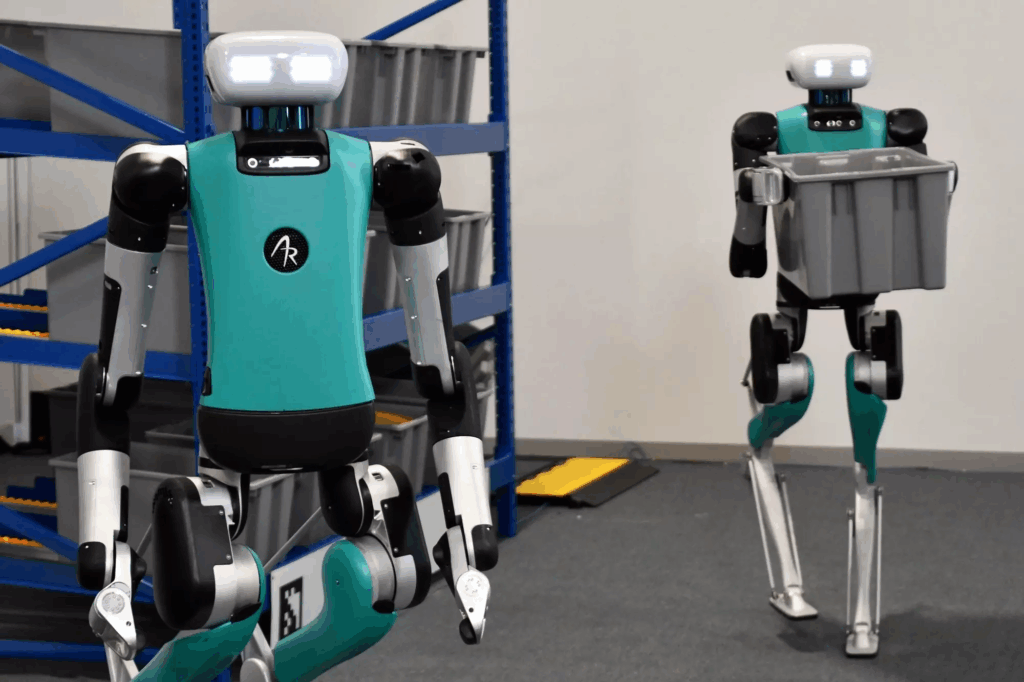

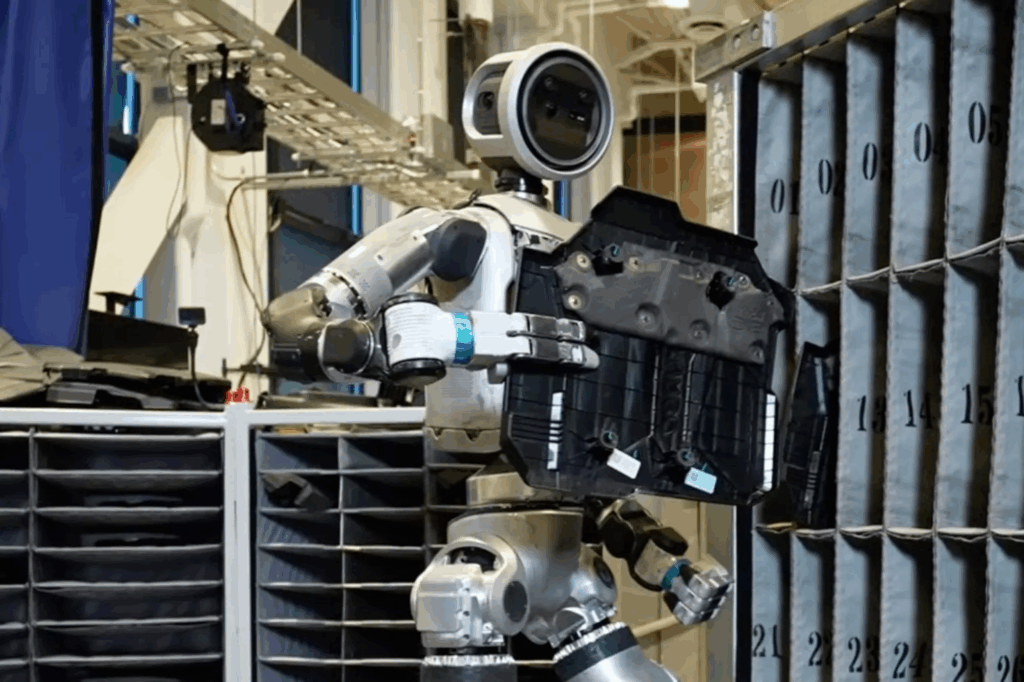

Zwei Beine ermöglichen maximale Flexibilität und Mobilität

Aber gerade ein Halbmarathon führt zwangsläufig zu einer oft gestellten Frage: Warum haben Humanoide Beine? Wäre es nicht effizienter, Radantriebe zu nutzen? Weshalb die meisten Humanoiden dennoch mit zwei Beinen ausgestattet sind, erklärt Jonathan Hurst, Chief Robot Officer bei Agility Robotics: „Zweibeinige Roboter sind für die Koexistenz mit dem Menschen konzipiert und bieten eine Vielseitigkeit und Mobilität, die über das hinausgeht, was Radantriebe leisten können. Durch den Einsatz von Beinen können sich Humanoide an komplexe Umgebungen anpassen, Treppen steigen, Bordsteine überwinden und ein breites Aufgabenspektrum erfüllen.“ Digit, der Humanoide von Agility, ist bereits in vielen Applikationen vorwiegend in Logistikzentren im Einsatz wie beispielsweise bei amazon und GXO Logistics. Mit einer Körpergröße von 1,75 m und einem Gewicht von etwa 64 kg kann Digit komplexe Aufgaben wie das Heben von Lasten mit einem Gewicht von bis zu 16 kg ausführen. Und dank fortschrittlicher Sensorik, darunter LIDAR und Kameras, kann er auch selbstständig navigieren. Über Digit und die Frage, wie Humanoide Lücken in der Automatisierungskette schließen können, spricht auch Melonee Wise, Chief Product Officer bei Agility Robotics, auf dem automatica Forum in Halle A5. Anwendungsorientiert referiert direkt im Anschluss Carolin Richter, Head of Next Generation Robotics bei der BMW Group, über die Erfahrungen des Unternehmens mit konkreten Praxiseinsätzen von Humanoiden.

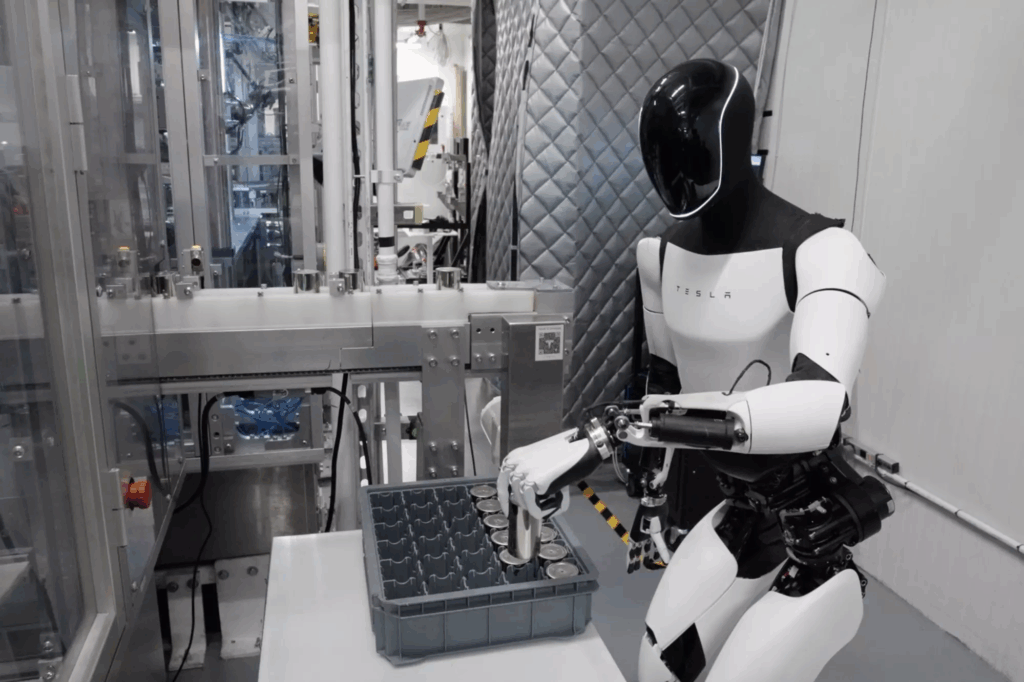

USA mit Vorreiterrolle in der Technologieentwicklung

Wie Digit kommen weitere hochentwickelte Humanoide aus den USA, darunter Atlas von Boston Dynamics, Optimus von Tesla, Figure 01 und 02 von Figure AI und Apollo von Apptronik. Sie alle arbeiten bereits in Piloteinsätzen in der Automobilindustrie. „Wir entwickeln die fortschrittlichsten und leistungsfähigsten humanoiden Roboter der Welt, die den Menschen auf sinnvolle und revolutionäre Weise zur Seite stehen“, sagt Jeff Cardenas, CEO und Mitbegründer von Apptronik. Aber viel Kapital und potente Mitstreiter sind nötig, um diese Entwicklungen voranzutreiben. Gerade konnte Apptronik eine Finanzierungsrunde von mehr als 350 Millionen Dollar abschließen. Kooperationen mit der NASA, NVIDIA, Google DeepMind und auf der Anwenderseite mit Mercedes-Benz und GXO Logistics sollen sicherstellen, dass Apptronik in diesem Zukunftsmarkt weiter ganz vorne mitspielen wird.

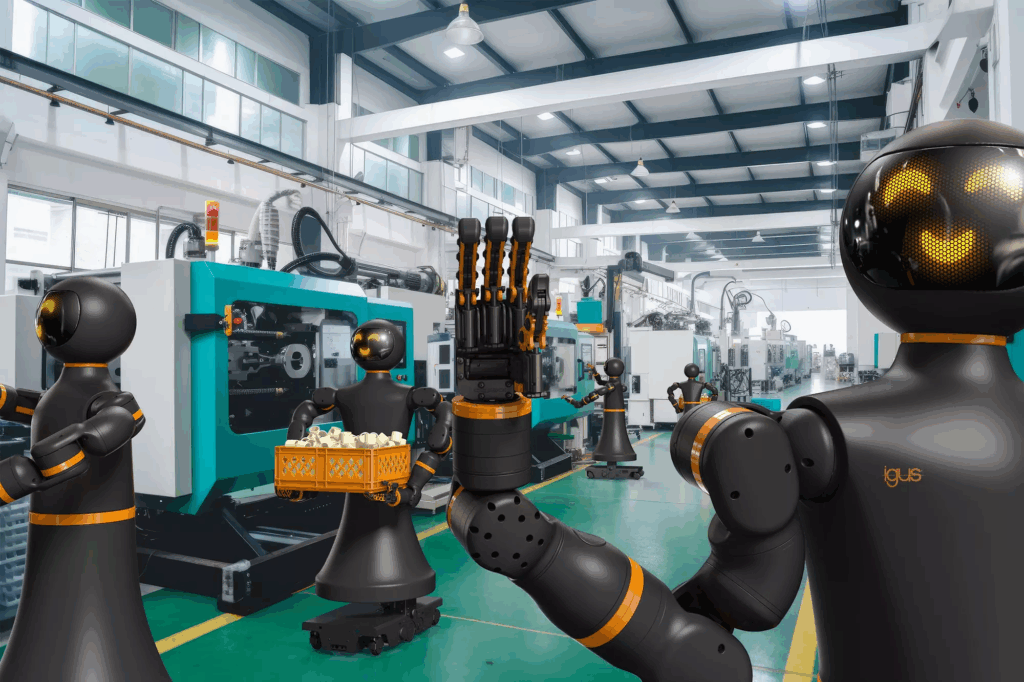

Deutschland mit Aufholbedarf bei humanoider Robotik

Zwar spielt Deutschland auf dem Weltmarkt für Humanoide keine Schlüsselrolle, dennoch belegt die automatica, dass es auch hier vielversprechende Entwicklungen gibt. Denn neben dem 4NE-1 von Neura Robotics, der bereits 2023 auf der automatica debütierte, werden dieses Jahr weitere Humanoide den Weg nach München finden. Einer von ihnen kommt aus Köln und hört auf den Namen „Iggy Rob“. Igus bietet seinen ersten humanoiden Roboter für knapp unter 50.000 Euro an. Möglich wird dies nach Herstellerangaben durch die Kombination aus hauseigenen Komponenten wie den ReBeL Cobots für die Roboterarme und der mobilen Basis ReBeL Move. Sein Einsatzspektrum reicht von der Assistenzrobotik über Fabrikautomation bis hin zu Bildung und Forschung. Igus will Iggy Rob im eigenen Unternehmen für die Automation von Spritzgießmaschinen nutzen.

© Messe München GmbH

Mit Spannung erwartet wird auch der Messeauftritt des Instituts für Robotik und Mechatronik des Deutschen Zentrums für Luft- und Raumfahrt. Hier forscht man intensiv an der Weiterentwicklung in der humanoiden Robotik. Die jüngsten Ergebnisse werden auf der automatica zu sehen sein. Aufhorchen lässt auch die jüngst geschlossene Kooperation des Instituts mit Siemens. „Diese strategische Partnerschaft ist ein weiteres Beispiel für Transfer von Robotiktechnologien aus der Raumfahrt in industrielle Anwendungen“, sagt Institutsleiter Alin Albu-Schäffer. „Die enge Vernetzung mit führenden deutschen Industriepartnern wie Siemens ist essenziell, um die Wettbewerbsfähigkeit der europäischen Robotik auch in der Zukunft, angesichts der rasanten Entwicklungen in USA und China, zu sichern.“

Humanoide Roboter: ein gigantischer Wachstumsmarkt

Tesla sieht sich mit seinem humanoiden Roboter Optimus als Technologieführer. Dieser bewegt sich elegant, ist schnell und besitzt eine hochflexible Fünffinger-Hand. Musk hält Einsätze im Haushalt oder in der Kinderbetreuung bald für möglich und auch Goldman Sachs sieht für den weltweiten Markt für Humanoide hohes Potential. Demnach könnte dieser bis 2035 auf 38 Milliarden US-Dollar steigen. Neben US-amerikanischen Unternehmen verfolgt auch die Volksrepublik ambitionierte Ziele und will innerhalb der nächsten drei Jahre zum Weltmarktführer im Bereich humanoider Roboter aufsteigen. Mittelfristig sollen in China fünf Prozent aller Jobs von Humanoiden übernommen lassen. Das würde dem Einsatz von rund 35 Millionen Einheiten entsprechen. Bereits heute sind in Chinas Unternehmen Humanoide von Unitree, AgiBot, Engine AI, Fourier oder Ubtech in unterschiedlichen Applikationen und Branchen im Einsatz.

Branchenprimus Unitree bringt als einer der ersten Hersteller weltweit mit dem G1 einen kleinen Humanoiden zum spektakulär niedrigen Preis auf den Markt. So soll die Basisversion des 1,3 Meter großen und 35 kg leichten G1 in China nur 16.000 Euro kosten, hierzulande werden dann daraus wohl eher knapp 30.000 Euro. Und je nach Ausbaustufe kann sich dieser Preis schnell mehr als verdoppeln. Das Interesse am G1 ist groß, wie Unitree-Marketingmanagerin Qian Yuqi verrät: „Es gibt bereits Bestellungen aus dem In- und Ausland. Zunächst dürften vor allem wissenschaftliche Forschungseinrichtungen unseren Roboter einsetzen, aber auch Industriebetriebe können sich vorstellen, G1 für einfache Arbeiten zu nutzen.“

Die Entwicklung zeigt: Die Zeit für Humanoide und damit für eine neue Ära der Automation ist gekommen. Dank KI sind sie bereits jetzt in der Lage, einen Teil der Aufgaben zu übernehmen, die bislang Menschen vorbehalten waren. Die automatica verspricht spannenden Einblicke, was Humanoide zu leisten im Stande sind und wie ihr Einsatz die Arbeitswelt beeinflussen kann.

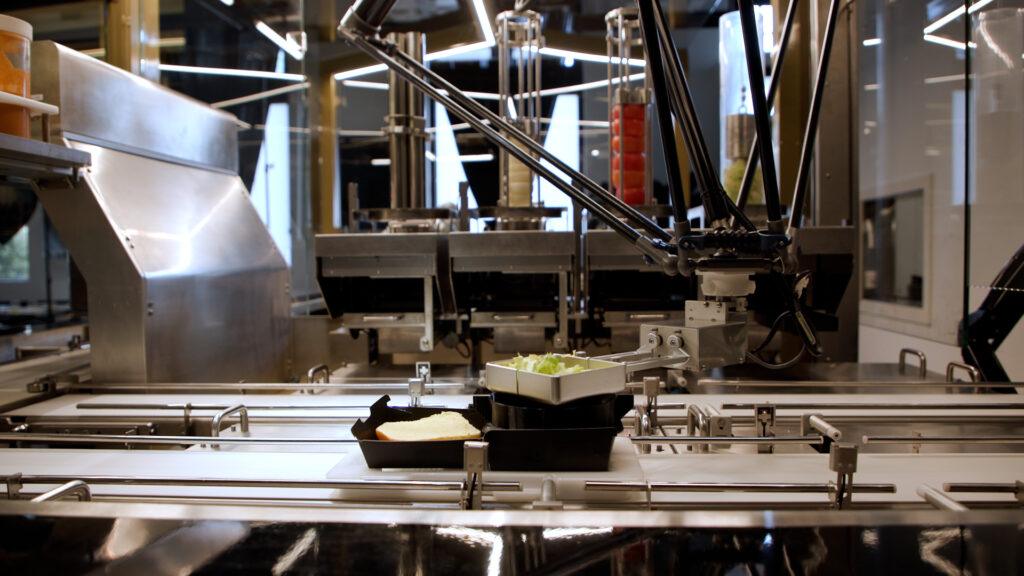

Fast Food automatisiert zubereitet: ABB und BurgerBots präsentieren Burger-Roboter

Mit BurgerBots, einem richtungsweisenden Restaurantkonzept, das im kalifornischen Los Gatos realisiert wurde, serviert ABB die Zukunft des Fast Food. In der automatisierten Küche, die stets perfekt zubereitete Burger produziert, stellen der ABB-Deltaroboter IRB 360 FlexPicker sowie der kollaborative ABB-Roboter YuMi die Speisen mit hoher Präzision und Geschwindigkeit zusammen. Gleichzeitig wird der Bestand an Zutaten genau überwacht, sodass sich das Personal ganz auf das Kundenerlebnis konzentrieren kann.

„Die Integration von ABB-Robotern in das Restaurantkonzept von BurgerBots zeigt, welches enorme Potenzial die Automatisierung über das Fabrikumfeld hinaus bietet“, betont Marc Segura, Leiter der Robotics-Division von ABB. „Die Gastronomiebranche ist äußerst dynamisch und anspruchsvoll, und unsere Technologie ermöglicht ihr eine Konsistenz, Effizienz und Zuverlässigkeit auf industriellem Niveau. Laut unserer Umfrage sind 89 Prozent der Führungskräfte und 73 Prozent der Arbeitskräfte im Gastgewerbe offen für die Integration von Robotik, um Aufgaben innerhalb ihres Betriebs zu automatisieren2. Wenn Roboter wiederkehrende und zeitaufwändige Aufgaben übernehmen, kann sich das Personal auf das konzentrieren, worauf es am meisten ankommt – dem Gast ein unvergessliches gastronomisches Erlebnis zu bieten.“

Die kompakte Roboterzelle ist ein Novum in der automatisierten Essenszubereitung, da sie zwei Robotertypen nahtlos mit einem intelligenten Bestandsüberwachungssystem verknüpft. Bei jedem Bestelleingang wird ein frisch gebratenes Burger-Patty auf einem Brötchen in eine Burger-Box gelegt. Die Box wird anschließend auf einem Transporttablett platziert, das mit einem QR-Code versehenen ist. Während sich das Tablett auf einem Förderband bewegt, gibt der IRB 360 FlexPicker in Windeseile und auf hygienische Weise die gewünschten Beläge hinzu – gemäß der im QR-Code gespeicherten Daten. Anschließend übernimmt YuMi die Fertigstellung des Burgers. Pro Burger dauert der gesamte Vorgang lediglich 27 Sekunden.

Die ABB-Robotersteuerung lässt sich zudem nahtlos in nicht-robotische Systeme einbinden. Sie ermöglicht eine Bestandsüberwachung der Zutaten, darunter Zwiebeln, Tomaten, Salat und Saucen, in Echtzeit und sorgt so für einen reibungslosen Ablauf und ein effizientes Küchenmanagement.

Eine der größten Herausforderungen für Restaurantbesitzer besteht heutzutage darin, Personal zu finden und an sich zu binden3. Eine hohe Fluktuation, steigende Lohnkosten und die Monotonie bestimmter Aufgaben im sogenannten „Back-of-House“-Bereich setzen Gastronomiebetriebe nach wie vor unter Druck. Die Automatisierung bietet nicht nur eine Möglichkeit, Personallücken zu schließen, sondern kann durch Reduzierung manueller Tätigkeiten und Verbesserung von Arbeitsabläufen auch dabei helfen, Jobs in der Gastronomie nachhaltiger und attraktiver zu gestalten.

Eine kürzlich von ABB Robotics in Auftrag gegebene Umfrage zeigt, dass ein Umdenken in diese Richtung stattfindet. Demnach sind 67 Prozent der Beschäftigten im Gastgewerbe der Ansicht, dass Robotik und Automatisierung zum Einsatz kommen sollten, um den Umfang an monotonen, schmutzigen und gefährlichen Arbeiten zu reduzieren4. Während 63 Prozent den Gedanken, dass Robotik ihren Job vereinfachen könnte, interessant finden, würden 65 Prozent der Befragten Roboter an ihrem Arbeitsplatz begrüßen, wenn dies die Arbeitssicherheit erhöhen würde.

Die Idee zu BurgerBots stammt von der Unternehmerin Elizabeth Truong, die den Standort in Los Gatos als ersten Schritt zu einem breiteren kommerziellen Rollout sieht. „Die Vision war es, Konsistenz, Transparenz und Effizienz in die Gastronomie zu bringen. Für Restaurantbesitzer bedeutet das einen besseren Einblick in die Lebensmittelkosten, genauere Prognosen und letztendlich eine bessere Entscheidungsfindung. Ich glaube, dass in den kommenden fünf Jahren die meisten Restaurants über irgendeine Form der robotergestützten Automatisierung verfügen werden, sei es bei der Zubereitung im Back-of-House-Bereich, der Zusammenstellung oder auch im Front-of-House-Service. Es wird dann weniger eine Neuheit als vielmehr eine Notwendigkeit sein.“

BurgerBots ist die neueste in einer Reihe robotergestützter Innovationen für den Gastronomiebereich. Die Zusammenarbeit von ABB mit dem Unternehmen RoboEatz an der ARK – einer autonomen robotergestützten Küche, die in der Lage ist, Hunderte von Mahlzeiten mit minimalem menschlichem Eingriff zuzubereiten – demonstriert das Potenzial für eine hocheffiziente, hygienische und individualisierbare Essenszubereitung. Darüber hinaus unterstützt ABB das Unternehmen Makr Shakr bei der Realisierung von Barkeeper-Robotern, die schon bald in Lokalitäten rund um den Globus auf gekonnte Weise Getränke mixen werden. Diese Anwendungen sind nur zwei Beispiele dafür, wie die Robotik das Gastgewerbe dank Schnelligkeit und Konsistenz transformiert.

Die erste BurgerBots-Zelle ist mittlerweile in einem Restaurant in der Innenstadt von Los Gatos in Kalifornien in Betrieb. Weitere Informationen stehen unter www.burgerbots.com zur Verfügung.