Mehr Informationen unter: https://www.iais.fraunhofer.de/de/branchen-themen/themen/intelligente-prozessautomatisierung/gen-ai-robotersteuerung.html

Archiv der Kategorie: Education & Studies

Spielerische Robotik-Ausbildung: igus Low-Cost-Automation bewährt sich im Schulalltag

Georg-Simon-Ohm-Berufskolleg setzt auf ReBeL Cobots und Education Kits von igus, um Schülern einen einfachen Einstieg in die Roboter-Programmierung zu ermöglichen

Köln, 17. Juni 2025 – Junge Menschen für Technik begeistern: Dieses Ziel verfolgt der Kunststoffspezialist und Robotikhersteller igus mit seinen Bildungsangeboten speziell für Schulen, Hochschulen und Universitäten. Dazu zählt auch das ReBeL Education Kit: Ein Lernpaket, das Schülern und Studierenden den spielerischen Einstieg in die Robotik mithilfe des ReBeL Cobots ermöglichen soll. Zum Einsatz kommen die Education Kits unter anderem am Georg-Simon-Ohm-Berufskolleg in Köln. So bekommen die Schüler die Möglichkeit, erste Programmierkenntnisse zu erwerben und praxisnahe Anwendungen zu erproben.

Von Elektrotechnik über Datenbankwissen bis hin zur Softwareentwicklung: Die Ausbildung zum Informationstechnischen Assistenten am Georg-Simon-Ohm-Berufskolleg in Köln umfasst ein vielseitiges Lehrprogramm. Dazu gehört auch das Programmieren von Robotern, um den Schülern besondere Qualifikationen in der Automatisierungstechnik zu vermitteln. „Für unsere Robotik-Klasse kamen bisher humanoide Robotiksysteme zum Einsatz, die jedoch mit der Zeit störungsanfällig geworden sind“, erklärt Kevin Meyer, Lehrer für Elektrotechnik und Robotik am Georg-Simon-Ohm-Berufskolleg. „Daher brauchten wir Ersatz für die alten Systeme und haben uns gezielt auf die Suche nach Roboterarmen gemacht, die einfach zu bedienen sind und realitätsnahe Anwendungsszenarien ermöglichen.“ Fündig wurde das Berufskolleg schließlich beim Kölner Kunststoffspezialisten igus.

Programmieren lernen mit realitätsnahen Anwendungsbeispielen

„igus war uns bereits für seine Energieketten bekannt, doch bei unserer Suche sind wir dann auch auf das Low-Cost-Automation-Angebot gestoßen und haben gleich einen Beratungstermin vor Ort ausgemacht“, erzählt Kevin Meyer. Auf der 400 Quadratmeter großen Customer Test Area können Kunden zahlreiche Automationslösungen aus der Praxis in Aktion sehen und gemeinsam mit den Robotik-Experten von igus die Machbarkeit ihrer geplanten Anwendung testen. Die Wahl fiel schließlich auf zehn ReBeL Cobots mit sechs Achsen inklusive Education Kits. „Roboter gibt es auf dem Markt zwar viele, aber die Alternativen waren für unsere Zwecke entweder zu klein oder zu teuer. Zudem war für uns auch eine leichte Bedienbarkeit wichtig.“ Der ReBeL Cobot mit einem Gewicht von nur 8,2 Kilogramm, einer Traglast von zwei Kilogramm und einer Reichweite von 664 Millimetern ist in der vollausgestatteten Plug-and-Play-Variante bereits für 4.970 Euro erhältlich. Im Education Kit enthalten sind über 100 Stunden Lernmaterial und Projektplatten, die auf eine Arbeitsfläche montiert werden. Anhand derer lassen sich unterschiedliche Szenarien mit Realitätsbezug programmieren: ob Behälter in ein Hochregal sortieren, Bauteile eines Fahrrads vom Förderband nehmen und an der entsprechenden Stelle einsetzen oder die Qualitätskontrolle am Fahrrad. Die kostenlose und lizenzfreie igus Robot Control Software ermöglicht zudem eine einfache Bedienbarkeit und erleichtert den Einstieg in die Roboterprogrammierung.

Lernende gezielt auf die moderne Arbeitswelt vorbereiten

Die ReBeL Cobots und Education Kits sind inzwischen seit einem Jahr in vier Robotik-Klassen des Berufskollegs im Einsatz. „Die meisten Schüler arbeiten sehr gerne mit den Robotern. Die Bedienung war am Anfang für manche noch eine Herausforderung, aber am Ende haben es alle geschafft“, erzählt Kevin Meyer. Die Software sei visuell sehr anschaulich und ermögliche den Schülern, schnell kleine Fortschritte zu machen. Alexander Mühlens, Leiter Geschäftsbereich Low-Cost-Automation bei igus betont: „Uns liegt die Förderung des Roboternachwuchses sehr am Herzen, daher freuen uns solche Projekte immer besonders. Mit unserem breiten Bildungsangebot möchten wir Schulen, Hochschulen und Universitäten dabei unterstützen, theoretisches Wissen praxisnah zu vermitteln und Lernende gezielt auf die moderne Arbeitswelt vorzubereiten.“

Mehr Informationen zum Robotik-Bildungsangebot von igus finden Sie hier:

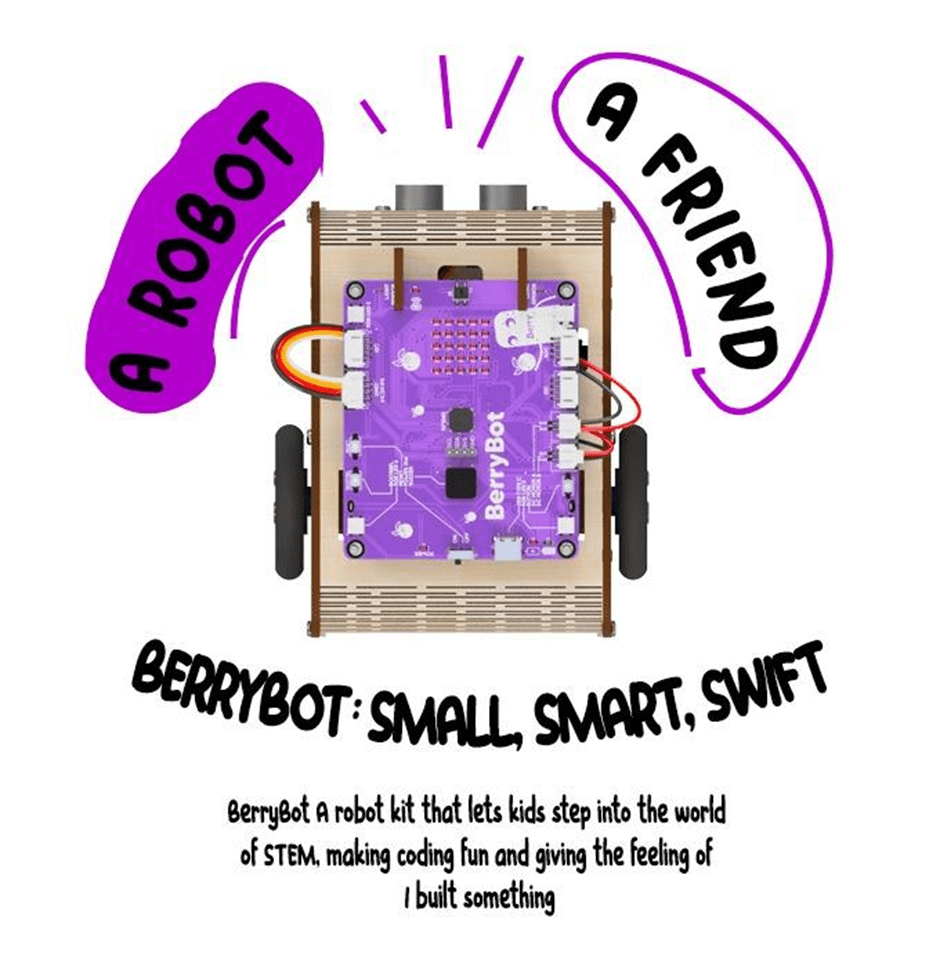

BerryBot: STEM Education for Young Engineers with a wooden robot

Robotistan, a pioneer in innovative educational solutions, has introduced a new STEM robot called BerryBot. Designed to help children develop coding and robotics skills, this creative and educational robot offers practical experiences in science, technology, engineering, and mathematics (STEM).

A New Era in Robotics Education

BerryBot is more than just a robot; it’s a learning platform that nurtures creativity and problem-solving skills. With its compact and customizable design, BerryBot allows users to paint and personalize their robot, thanks to its wooden body.

The wooden structure not only reflects an eco-friendly design approach but also allows children to shape their robots according to their own style. BerryBot is designed to be flexible enough for both classroom and home use.

Key Features

BerryBot’s innovative features support the development of both technical and creative skills:

- Customizable Wooden Body:

- Kids can paint their robots to reflect their unique style.

- Durable and sustainable construction.

- Versatile Coding Options:

- Block-based programming for beginners.

- Advanced programming with Python and Arduino IDE.

- User-friendly interface for an easy learning process.

- Multi-Mode Movement:

- Line-following, sumo, and free movement modes.

- Real-time visual feedback via the LED matrix display.

- Wireless control through Bluetooth connectivity.

An Educational Tool Combining Coding Skills with Creativity

BerryBot offers young aspiring engineers a fun and educational experience. While creating different movement scenarios, children not only enhance their problem-solving skills but also develop creative projects.

Thanks to BerryBot’s multi-mode structure, users can program the robot’s movement capabilities in various ways. This feature transforms BerryBot from being just a toy to a valuable educational tool that encourages creative thinking.

Mehmet Akçalı, Marketing and Product Director at Robotistan, highlighted the educational features of BerryBot:

„BerryBot offers a practical and fun way for children to step into the world of STEM. Combining coding skills with creative projects, this robot will become an indispensable educational tool for both teachers and parents.“

He also mentioned a special opportunity for early supporters:

„We’re thrilled to announce our Kickstarter campaign, where backers can take advantage of the Early Bird offer. Additionally, as part of our commitment to supporting STEM education, for every 10 pledges, we will gift one BerryBot to a school or an educational organization in need. This way, our supporters not only get an amazing educational robot but also help inspire the next generation of young innovators.“

Shaping the Engineers of the Future

As the importance of STEM education continues to grow, innovative tools like BerryBot are preparing young minds for the future. With its fun yet educational nature, BerryBot strengthens children’s coding, algorithmic thinking, and problem-solving skills while also inspiring creative projects.

Robotistan emphasizes that BerryBot is not just an educational robot but also a platform where children can express themselves. Produced with this vision in mind, BerryBot is ready to make a difference both at home and in educational environments.

To learn more about BerryBot and to be among the first to own it and take advantage of the Early Bird offer, visit the Kickstarter page!

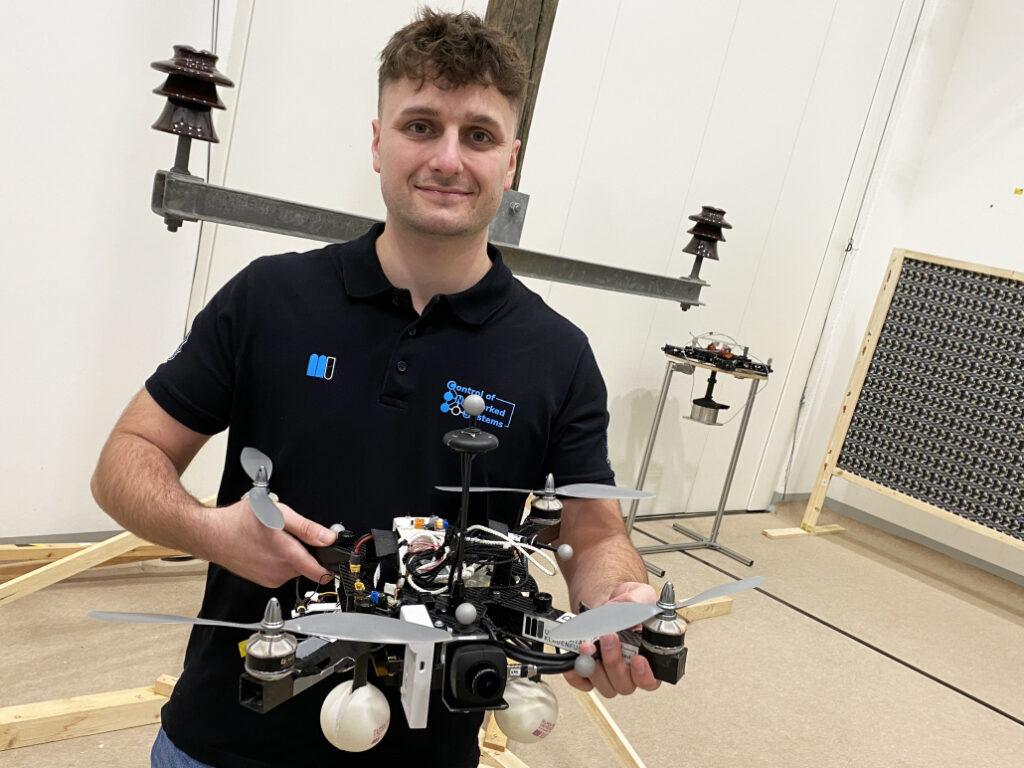

Enhancing Drone Navigation with AI and IDS uEye Camera Technology

AI-driven drone from University of Klagenfurt uses IDS uEye camera for real-time, object-relative navigation—enabling safer, more efficient, and precise inspections.

The inspection of critical infrastructures such as energy plants, bridges or industrial complexes is essential to ensure their safety, reliability and long-term functionality. Traditional inspection methods always require the use of people in areas that are difficult to access or risky. Autonomous mobile robots offer great potential for making inspections more efficient, safer and more accurate. Uncrewed aerial vehicles (UAVs) such as drones in particular have become established as promising platforms, as they can be used flexibly and can even reach areas that are difficult to access from the air. One of the biggest challenges here is to navigate the drone precisely relative to the objects to be inspected in order to reliably capture high-resolution image data or other sensor data.

A research group at the University of Klagenfurt has designed a real-time capable drone based on object-relative navigation using artificial intelligence. Also on board: a USB3 Vision industrial camera from the uEye LE family from IDS Imaging Development Systems GmbH.

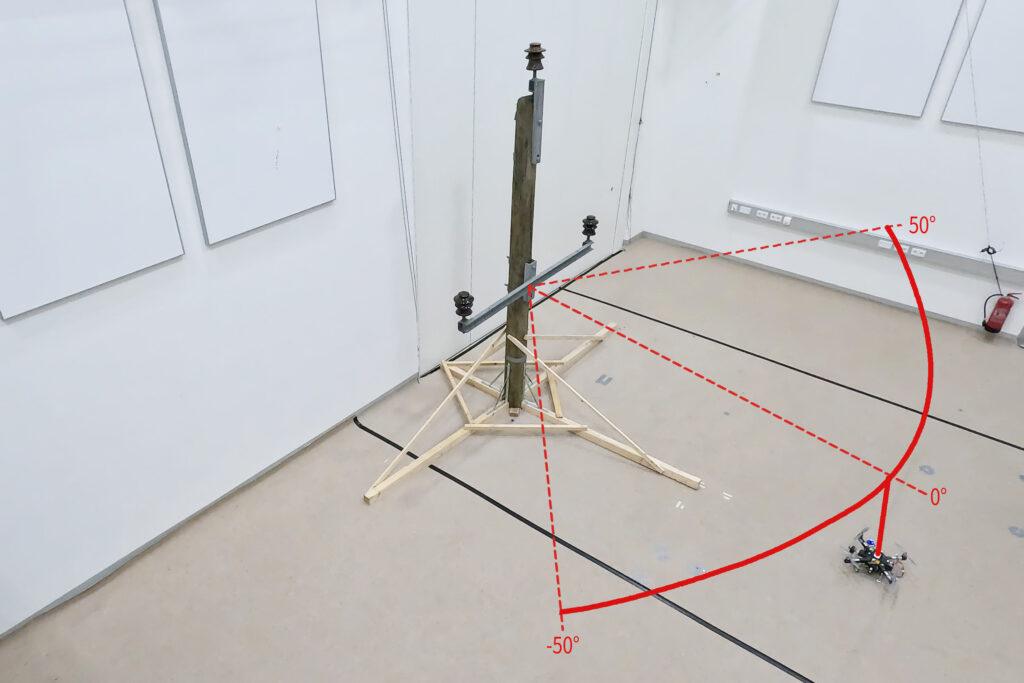

As part of the research project, which was funded by the Austrian Federal Ministry for Climate Action, Environment, Energy, Mobility, Innovation and Technology (BMK), the drone must autonomously recognise what is a power pole and what is an insulator on the power pole. It will fly around the insulator at a distance of three meters and take pictures. „Precise localisation is important such that the camera recordings can also be compared across multiple inspection flights,“ explains Thomas Georg Jantos, PhD student and member of the Control of Networked Systems research group at the University of Klagenfurt. The prerequisite for this is that object-relative navigation must be able to extract so-called semantic information about the objects in question from the raw sensory data captured by the camera. Semantic information makes raw data, in this case the camera images, „understandable“ and makes it possible not only to capture the environment, but also to correctly identify and localise relevant objects.

In this case, this means that an image pixel is not only understood as an independent colour value (e.g. RGB value), but as part of an object, e.g. an isolator. In contrast to classic GNNS (Global Navigation Satellite System), this approach not only provides a position in space, but also a precise relative position and orientation with respect to the object to be inspected (e.g. „Drone is located 1.5m to the left of the upper insulator“).

The key requirement is that image processing and data interpretation must be latency-free so that the drone can adapt its navigation and interaction to the specific conditions and requirements of the inspection task in real time.

Semantic information through intelligent image processing

Object recognition, object classification and object pose estimation are performed using artificial intelligence in image processing. „In contrast to GNSS-based inspection approaches using drones, our AI with its semantic information enables the inspection of the infrastructure to be inspected from certain reproducible viewpoints,“ explains Thomas Jantos. „In addition, the chosen approach does not suffer from the usual GNSS problems such as multi-pathing and shadowing caused by large infrastructures or valleys, which can lead to signal degradation and thus to safety risks.“

How much AI fits into a small quadcopter?

The hardware setup consists of a TWINs Science Copter platform equipped with a Pixhawk PX4 autopilot, an NVIDIA Jetson Orin AGX 64GB DevKit as on-board computer and a USB3 Vision industrial camera from IDS. „The challenge is to get the artificial intelligence onto the small helicopters.

The computers on the drone are still too slow compared to the computers used to train the AI. With the first successful tests, this is still the subject of current research,“ says Thomas Jantos, describing the problem of further optimising the high-performance AI model for use on the on-board computer.

The camera, on the other hand, delivers perfect basic data straight away, as the tests in the university’s own drone hall show. When selecting a suitable camera model, it was not just a question of meeting the requirements in terms of speed, size, protection class and, last but not least, price. „The camera’s capabilities are essential for the inspection system’s innovative AI-based navigation algorithm,“ says Thomas Jantos. He opted for the U3-3276LE C-HQ model, a space-saving and cost-effective project camera from the uEye LE family. The integrated Sony Pregius IMX265 sensor is probably the best CMOS image sensor in the 3 MP class and enables a resolution of 3.19 megapixels (2064 x 1544 px) with a frame rate of up to 58.0 fps. The integrated 1/1.8″ global shutter, which does not produce any ‚distorted‘ images at these short exposure times compared to a rolling shutter, is decisive for the performance of the sensor. „To ensure a safe and robust inspection flight, high image quality and frame rates are essential,“ Thomas Jantos emphasises. As a navigation camera, the uEye LE provides the embedded AI with the comprehensive image data that the on-board computer needs to calculate the relative position and orientation with respect to the object to be inspected. Based on this information, the drone is able to correct its pose in real time.

The IDS camera is connected to the on-board computer via a USB3 interface. „With the help of the IDS peak SDK, we can integrate the camera and its functionalities very easily into the ROS (Robot Operating System) and thus into our drone,“ explains Thomas Jantos. IDS peak also enables efficient raw image processing and simple adjustment of recording parameters such as auto exposure, auto white Balancing, auto gain and image downsampling.

To ensure a high level of autonomy, control, mission management, safety monitoring and data recording, the researchers use the source-available CNS Flight Stack on the on-board computer. The CNS Flight Stack includes software modules for navigation, sensor fusion and control algorithms and enables the autonomous execution of reproducible and customisable missions. „The modularity of the CNS Flight Stack and the ROS interfaces enable us to seamlessly integrate our sensors and the AI-based ’state estimator‘ for position detection into the entire stack and thus realise autonomous UAV flights. The functionality of our approach is being analysed and developed using the example of an inspection flight around a power pole in the drone hall at the University of Klagenfurt,“ explains Thomas Jantos.

Precise, autonomous alignment through sensor fusion

The high-frequency control signals for the drone are generated by the IMU (Inertial Measurement Unit). Sensor fusion with camera data, LIDAR or GNSS (Global Navigation Satellite System) enables real-time navigation and stabilisation of the drone – for example for position corrections or precise alignment with inspection objects. For the Klagenfurt drone, the IMU of the PX4 is used as a dynamic model in an EKF (Extended Kalman Filter). The EKF estimates where the drone should be now based on the last known position, speed and attitude. New data (e.g. from IMU, GNSS or camera) is then recorded at up to 200 Hz and incorprated into the state estimation process.

The camera captures raw images at 50 fps and an image size of 1280 x 960px. „This is the maximum frame rate that we can achieve with our AI model on the drone’s onboard computer,“ explains Thomas Jantos. When the camera is started, an automatic white balance and gain adjustment are carried out once, while the automatic exposure control remains switched off. The EKF compares the prediction and measurement and corrects the estimate accordingly. This ensures that the drone remains stable and can maintain its position autonomously with high precision.

Outlook

„With regard to research in the field of mobile robots, industrial cameras are necessary for a variety of applications and algorithms. It is important that these cameras are robust, compact, lightweight, fast and have a high resolution. On-device pre-processing (e.g. binning) is also very important, as it saves valuable computing time and resources on the mobile robot,“ emphasises Thomas Jantos.

With corresponding features, IDS cameras are helping to set a new standard in the autonomous inspection of critical infrastructures in this promising research approach, which significantly increases safety, efficiency and data quality.

The Control of Networked Systems (CNS) research group is part of the Institute for Intelligent System Technologies. It is involved in teaching in the English-language Bachelor’s and Master’s programs „Robotics and AI“ and „Information and Communications Engineering (ICE)“ at the University of Klagenfurt. The group’s research focuses on control engineering, state estimation, path and motion planning, modeling of dynamic systems, numerical simulations and the automation of mobile robots in a swarm: More information

Model used:USB3 Vision Industriekamera U3-3276LE Rev.1.2

Camera family: uEye LE

Image rights: Alpen-Adria-Universität (aau) Klagenfurt

© 2025 IDS Imaging Development Systems GmbH

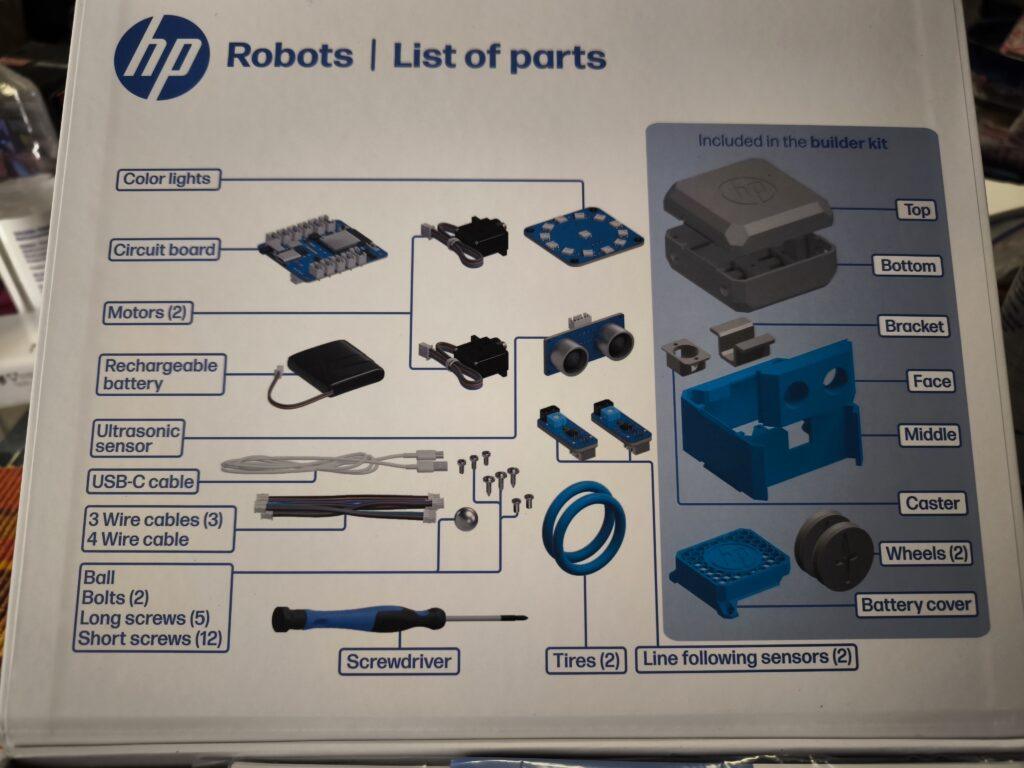

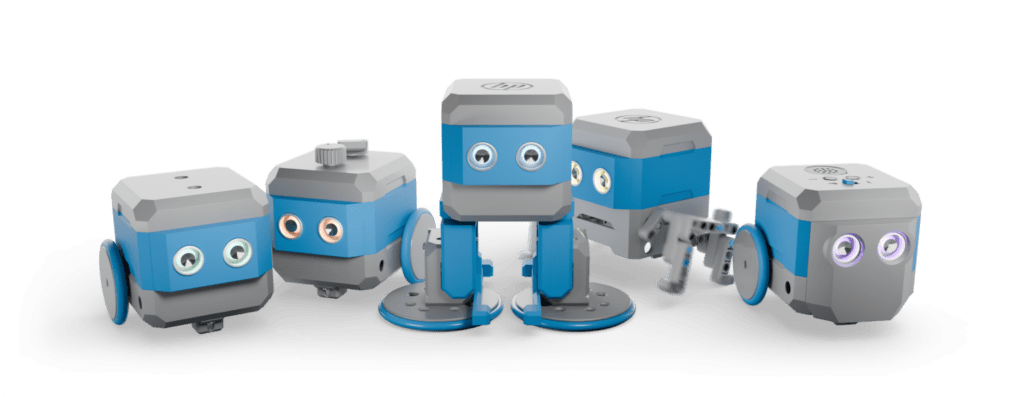

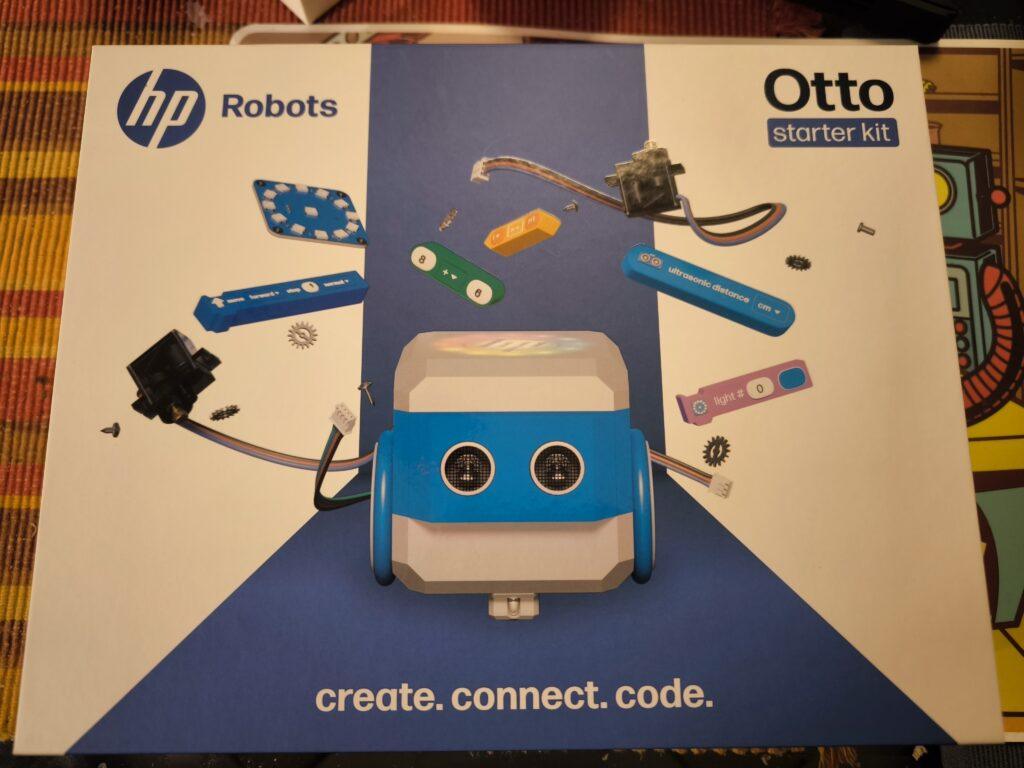

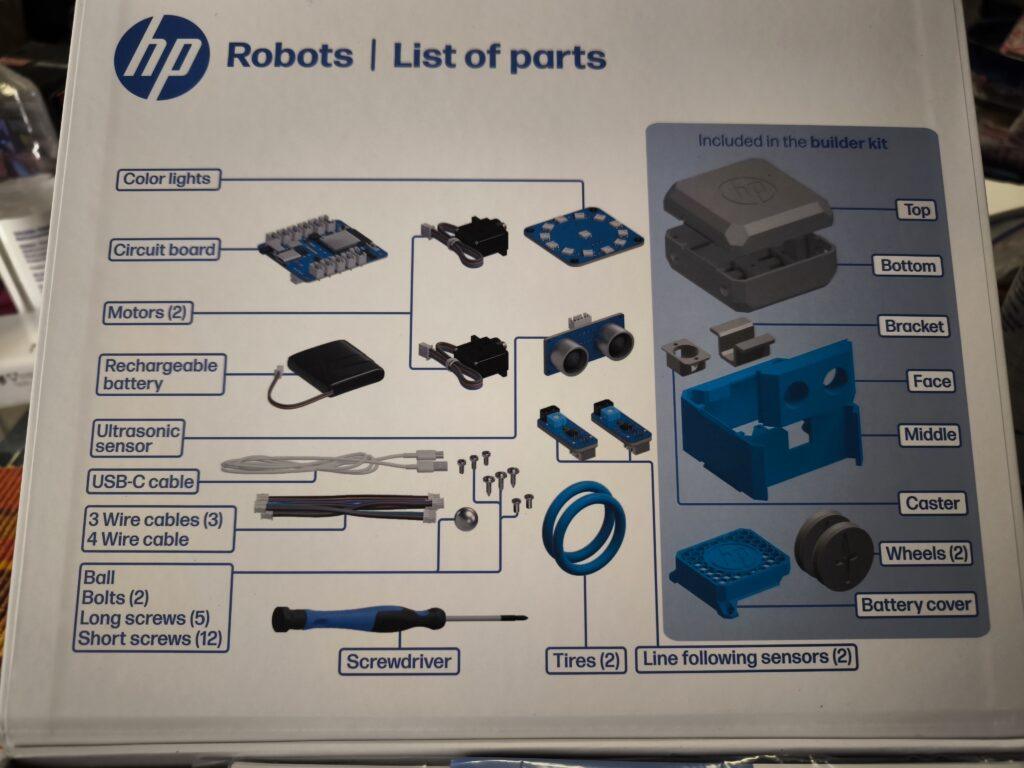

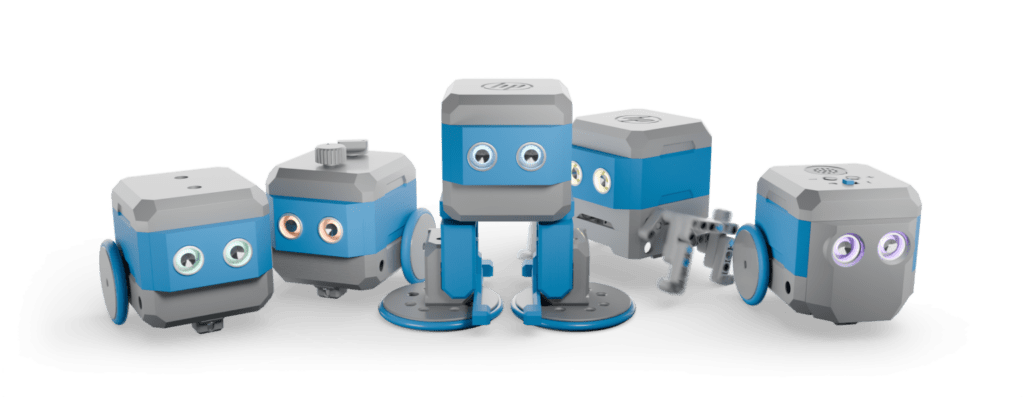

Creativity in motion: The modular robot Otto from HP Robots

The HP Robots Otto is a versatile, modular robot designed specifically for educational purposes. It offers students and teachers an exciting opportunity to immerse themselves in the world of robotics, 3D printing, electronics and programming. The robot was developed by HP as part of their robotics initiative and is particularly suitable for use in science, technology, engineering and mathematics (STEM) classes.

Key features of Otto:

- Modular design: Otto is a modular robot that allows students to build, program and customize it through extensions. This promotes an understanding of technology and creativity. The modular structure allows various components such as motors, sensors and LEDs to be added or replaced, which increases the learning curve for students.

- Programmability: The robot can be programmed with various programming languages, including block-based programming for beginners and Python and C++ for advanced programmers. This diversity allows students to continuously improve their coding skills and adapt to the complexity of the tasks.

- Sensors and functions: Equipped with ultrasonic sensors for obstacle detection, line tracking sensors and RGB LEDs, Otto offers numerous interactive possibilities. These features allow students to program complex tasks such as navigating courses or tracing lines. The sensors help to detect the environment and react accordingly.

- 3D printing and customizability: Students can design Otto’s outer parts themselves and produce them with a 3D printer. This allows for further personalization and customization of the robot. This creative freedom not only promotes technical understanding, but also artistic skills. Own parts can be designed and sensors can be attached to desired locations.

Educational approach:

Otto is ideal for use in schools and is aimed at students from the age of 8. Younger students can work under supervision, while older students from the age of 14 can also use and expand the robot independently. The kit contains all the necessary components to build a functioning robot, including motors, sensors, and a rechargeable battery.

Programming environments:

Otto is programmed via a web-based platform that runs on all operating systems. This platform offers different modes:

- Block-based programming: Similar to Scratch Jr., ideal for beginners. This visual programming makes it easier to get started in the world of programming and helps students understand basic concepts such as loops and conditions.

- Python: A Python editor is available for advanced users. Python is a popular language that works well for teaching because it is easy to read and write. Students can use Python to develop more complex algorithms and expand their programming skills.

- C++: Compatible with the Arduino IDE for users who have deeper programming knowledge. C++ offers a high degree of flexibility and allows students to access the hardware directly, allowing for their own advanced projects.

Expansion Kits:

In addition to the Starter Kit, there are several expansion kits. All expansion kits require the starter kit, as they are built on top of it.

Emote Expansion Kit:

- It includes components such as an LED matrix display, OLED display, and an MP3 player that allow the robot to display visual and acoustic responses.

- This kit is particularly suitable for creative projects where Otto should act as an interactive companion.

- The emote kit allows Otto to show emotions, mirror human interactions, and develop different personalities.

Sense Expansion Kit:

- With the Sense Kit, Otto can perceive its surroundings through various sensors.

- Included are sensors for temperature, humidity, light and noise as well as an inclination sensor. These enable a wide range of interactions with the environment.

- The kit is ideal for projects that focus on environmental detection and data analysis.

Interact Expansion Kit:

- The Interact kit expands Otto’s tactile interaction capability through modules such as push buttons, rotary knobs and accelerometers.

- It enables precise inputs and reactions, as well as measurement of acceleration.

- This kit is great for playful activities and interactive games.

Invent Expansion Kit:

- The Invent kit is specifically designed to encourage users‘ creativity. It allows the individual adaptation of Otto’s functionalities and design through 3D printing and additional modules as well as compatible clamping blocks.

- Users can design and print new accessories to make the robot unique.

- Equip Otto with legs and teach him to walk or make him fit for outdoor use off-road with chains.

Use in the classroom:

Otto comes with extensive resources developed by teachers. These materials help teachers design effective STEM lessons without the need for prior knowledge. The robot can be used both in the classroom and at home. The didactic materials include:

- Curricula: Structured lesson plans that help teachers plan and execute lessons.

- Project ideas and worksheets: A variety of projects that encourage students to think creatively and expand their skills.

- Tutorials and videos: Additional learning materials to help students better understand complex concepts.

Conclusion:

The HP Robots Otto is an excellent tool for fostering technical understanding and creativity in students. Thanks to its modular design and diverse programming options, it offers a hands-on learning experience in the field of robotics and electronics. Ideal for use in schools, Otto provides teachers with a comprehensive platform to accompany students on an exciting journey into the world of technology. In particular, Otto’s versatility through the 3D-printed parts and expansion packs offers the opportunity to build the personal learning robot.

Kreativität in Bewegung: Der modulare Roboter Otto von HP Robots

Der HP Robots Otto ist ein vielseitiger, modularer Roboter, der speziell für Bildungszwecke entwickelt wurde. Er bietet Schülern und Lehrern eine spannende Möglichkeit, in die Welt der Robotik, 3D-Druck, Elektronik und Programmierung einzutauchen. Der Roboter wurde von HP als Teil ihrer Robotik-Initiative entwickelt und ist besonders für den Einsatz im MINT-Unterricht (Mathematik, Informatik, Naturwissenschaften und Technik) geeignet.

Hauptmerkmale von Otto:

- Modularer Aufbau: Otto ist ein modularer Roboter, der es Schülern ermöglicht, ihn zu bauen, zu programmieren und durch Erweiterungen individuell anzupassen. Dies fördert das Verständnis für Technik und Kreativität. Die modulare Struktur erlaubt es, verschiedene Komponenten wie Motoren, Sensoren und LEDs hinzuzufügen oder zu ersetzen, was die Lernkurve für Schüler erweitert.

- Programmierbarkeit: Der Roboter kann mit verschiedenen Programmiersprachen programmiert werden, darunter blockbasierte Programmierung für Anfänger sowie Python und C++ für Fortgeschrittene. Diese Vielfalt ermöglicht es Schülern, ihre Programmierfähigkeiten kontinuierlich zu verbessern und sich an die Komplexität der Aufgaben anzupassen.

- Sensoren und Funktionen: Ausgestattet mit Ultraschallsensoren zur Hinderniserkennung, Linienverfolgungssensoren und RGB-LEDs bietet Otto zahlreiche interaktive Möglichkeiten. Diese Funktionen ermöglichen es Schülern, komplexe Aufgaben wie das Navigieren durch Parcours oder das Verfolgen von Linien zu programmieren. Die Sensoren helfen dabei, die Umgebung zu erkennen und entsprechend zu reagieren.

- 3D-Druck und Anpassbarkeit: Schüler können Ottos äußere Teile selbst entwerfen und mit einem 3D-Drucker herstellen. Dies ermöglicht eine weitere Personalisierung und Anpassung des Roboters. Diese Kreativfreiheit fördert nicht nur technisches Verständnis, sondern auch künstlerische Fähigkeiten. Eigene Teile können entworfen und Sensoren an gewünschten Stellen angebracht werden.

Bildungsansatz:

Otto ist ideal für den Einsatz in Schulen gedacht und richtet sich an Schüler ab 8 Jahren. Jüngere Schüler können unter Aufsicht arbeiten, während ältere Schüler ab 14 Jahren den Roboter auch eigenständig nutzen und erweitern können. Das Kit enthält alle notwendigen Komponenten, um einen funktionierenden Roboter zu bauen, einschließlich Motoren, Sensoren und einer wiederaufladbaren Batterie.

Programmierumgebungen:

Die Programmierung von Otto erfolgt über eine webbasierte Plattform, die auf allen Betriebssystemen läuft. Diese Plattform bietet verschiedene Modi:

- Blockbasierte Programmierung: Ähnlich wie Scratch Jr., ideal für Anfänger. Diese visuelle Programmierung erleichtert den Einstieg in die Welt der Programmierung und hilft Schülern, grundlegende Konzepte wie Schleifen und Bedingungen zu verstehen.

- Python: Für fortgeschrittene Benutzer steht ein Python-Editor zur Verfügung. Python ist eine beliebte Sprache, die sich gut für den Unterricht eignet, da sie einfach zu lesen und zu schreiben ist. Schüler können mit Python komplexere Algorithmen entwickeln und ihre Fähigkeiten im Bereich der Programmierung erweitern.

- C++: Kompatibel mit der Arduino IDE für Nutzer, die tiefere Programmierkenntnisse haben. C++ bietet eine hohe Flexibilität und ermöglicht es Schülern, direkt auf die Hardware zuzugreifen, was eigene fortgeschrittene Projekte ermöglicht.

Expansion/Erweiterungs Kits:

Zusätzlich zum Starter Kit gibt es mehrere Erweiterungskits. Alle Erweiterungskits setzen das Starter-Kit voraus, da sie auf dessen Basis aufgebaut werden.

Emote Expansion Kit:

- Es enthält Komponenten wie ein LED-Matrix-Display, OLED Display und einen MP3-Player, die es dem Roboter ermöglichen, visuelle und akustische Reaktionen darzustellen.

- Dieses Kit eignet sich besonders für kreative Projekte, bei denen Otto als interaktiver Begleiter fungieren soll.

- Das Emote-Kit ermöglicht es Otto, Emotionen zu zeigen, menschliche Interaktionen zu spiegeln und verschiedene Persönlichkeiten zu entwickeln.

Sense Expansion Kit:

- Mit dem Sense-Kit kann Otto seine Umgebung durch verschiedene Sensoren wahrnehmen.

- Enthalten sind Sensoren für Temperatur, Luftfeuchtigkeit, Licht und Geräusche sowie ein Neigungssensor. Diese ermöglichen vielfältige Interaktionen mit der Umwelt.

- Das Kit ist ideal für Projekte, die sich auf Umwelterkennung und Datenanalyse konzentrieren.

Interact Expansion Kit:

- Das Interact-Kit erweitert Ottos Fähigkeit zur taktilen Interaktion durch Module wie Drucktasten, Drehknöpfe und Beschleunigungsmesser.

- Es ermöglicht präzise Eingaben und Reaktionen sowie Messung der Beschleunigung.

- Dieses Kit eignet sich hervorragend für spielerische Aktivitäten und interaktive Spiele.

Invent Expansion Kit:

- Das Invent-Kit ist speziell darauf ausgelegt, die Kreativität der Benutzer zu fördern. Es erlaubt die individuelle Anpassung von Ottos Funktionalitäten und Design durch 3D-Druck und zusätzliche Module sowie kompatible Klemmbausteine.

- Benutzer können neue Zubehörteile entwerfen und drucken, um den Roboter einzigartig zu machen.

- Statte Otto mit Beinen aus und bring ihm das Laufen bei oder mache ihn mit Ketten fit für den Outdoor Einsatz im Gelände.

Einsatz im Unterricht:

Otto wird mit umfangreichen Ressourcen geliefert, die von Lehrern entwickelt wurden. Diese Materialien unterstützen Lehrer dabei, einen effektiven MINT-Unterricht zu gestalten, ohne dass Vorkenntnisse erforderlich sind. Der Roboter kann sowohl im Klassenraum als auch zu Hause eingesetzt werden. Die didaktischen Materialien umfassen:

- Lehrpläne: Strukturierte Unterrichtspläne, die den Lehrern helfen, den Unterricht zu planen und durchzuführen.

- Projektideen und Arbeitsblätter: Eine Vielzahl von Projekten, die Schüler dazu anregen, kreativ zu denken und ihre Fähigkeiten zu erweitern.

- Tutorials und Videos: Zusätzliche Lernmaterialien, die Schülern helfen, komplexe Konzepte besser zu verstehen.

Fazit:

Der HP Robots Otto ist ein hervorragendes Werkzeug zur Förderung von technischem Verständnis und Kreativität bei Schülern. Durch seine modulare Bauweise und die vielfältigen Programmiermöglichkeiten bietet er eine praxisorientierte Lernerfahrung im Bereich der Robotik und Elektronik. Otto ist ideal für den Einsatz in Schulen und bietet Lehrern eine umfassende Plattform, um Schüler auf eine spannende Reise in die Welt der Technologie zu begleiten. Besonders Ottos Vielseitigkeit durch die 3D-gedruckten Teile und Erweiterungspakete bieten die Möglichkeit, den persönlichen Lernroboter zu bauen.

Open-Source Robot pib wins German Design Award 2025

The world of robotics is evolving – and right in the middle of it: pib. This humanoid robot, entirely 3D-printable, has received a prestigious award. The German Design Award 2025 has been granted to the printable intelligent bot, recognizing not only its technological sophistication but also its innovative design. But what makes pib so special?

A Robot for Everyone – and by Everyone

Imagine a robot that anyone can build and program themselves. A robot that isn’t just a technical gadget but an inspiration to create, research, and explore new paths in robotics. That’s exactly what pib is. Its open-source approach has a central goal: to make robotics and AI more accessible while breaking down technological barriers. Whether you’re a tinkerer, a student, or simply a technology enthusiast, pib invites everyone to be part of its ever-growing community.

German Design Award 2025: Recognition for Visionary Product Design

The German Design Award is one of the most prestigious awards for outstanding design. Every year, an international panel of experts honors innovative concepts in product design, communication, and architecture. This year, pib impressed the jury with its “Excellent Product Design” in the category „AI in Product Design Processes“ – a testament to how technology and aesthetics can go hand in hand.

Technology Meets Creativity

pib is more than just a robot – it is a platform for innovative technologies. The project enables curious minds to experiment with 3D printing, robotics, and artificial intelligence in a playful and hands-on way. No prior knowledge is required; anyone can contribute, co-create, and learn. The community plays a crucial role: the newly designed, human-like body that won the German Design Award was developed by a community member using CAD software.

Jürgen Baier, founder of pib, is thrilled about the recognition: „We are proud that pib has won the German Design Award! For us, this confirms that we are on the right path to making robotics and AI more accessible and tangible for everyone. It’s great to see that our vision of inspiring people to create and explore resonates so well.“

Learning with pib: Schools and Media Centers Adopt the Humanoid Robot

But it’s not just the maker community that’s excited about pib. More than 35 schools and media centers are already using it as an innovative learning platform. Students and teachers alike are leveraging this humanoid robot to explore future technologies in an interactive, hands-on manner. The focus goes beyond technical skills to include creative problem-solving and teamwork. By bringing knowledge to life, pib makes robotics and AI tangible – opening doors to the careers of tomorrow.

Open Source and Limitless Possibilities

Behind pib stands isento GmbH, a Nuremberg-based company specializing in software development and AI solutions. However, the robot thrives not only due to the work of isento employees but also through the contributions of its community. 3D printing files, detailed assembly instructions, programming code, AI skills, and a knowledge database are all freely available online – an open invitation to help shape the future of robotics.

Winning the German Design Award is a well-deserved honor for pib. But for this project, the award means much more: it is motivation to push the boundaries of what’s possible with open-source robotics even further. So if you’ve ever wondered how to create your own humanoid robot – pib has the answer.

Robots-Blog showing all the robots at Spielwarenmesse Nuremberg 2025

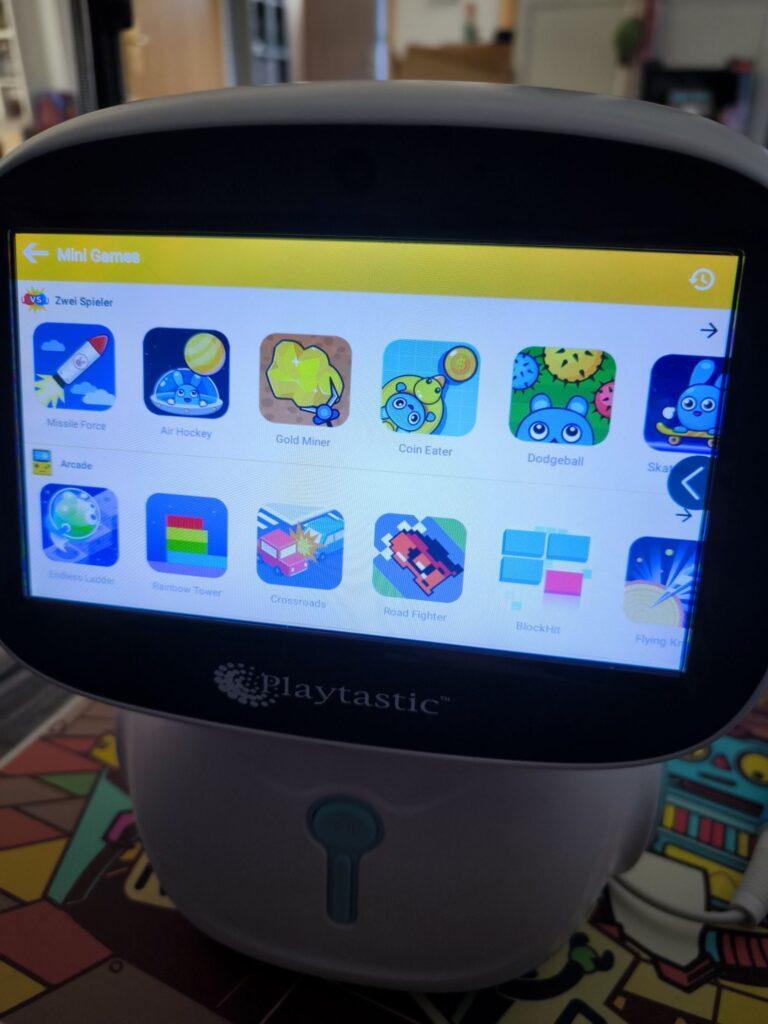

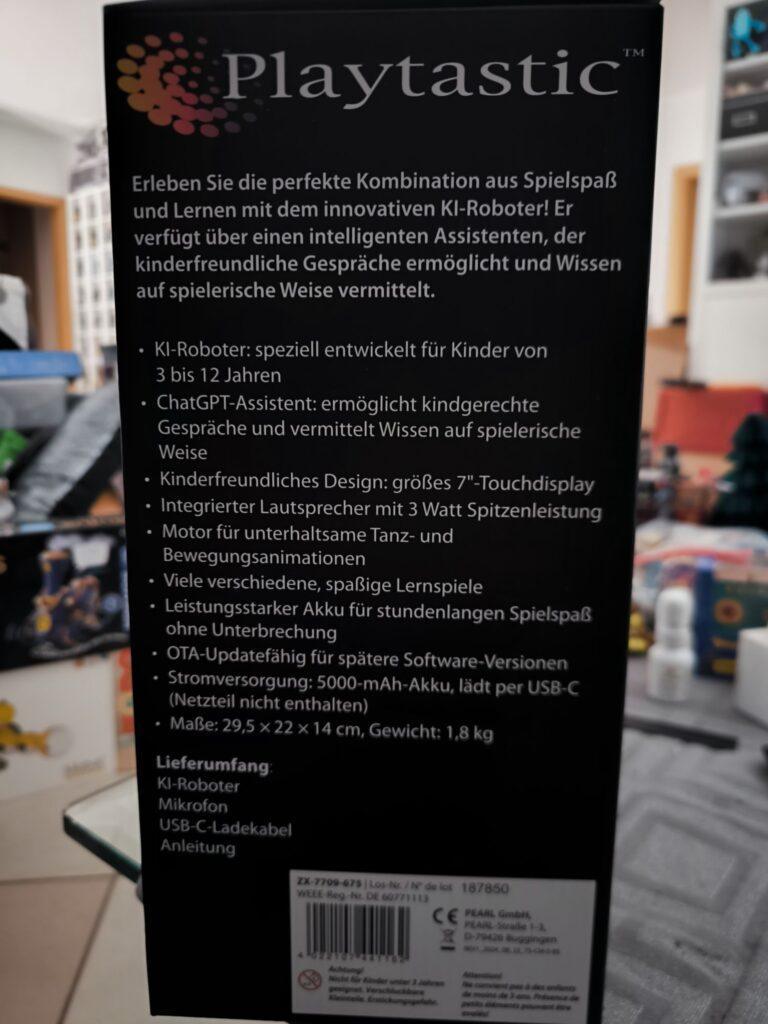

Playtastic KI-Roboter mit ChatGPT-Assistent

Nach dem Auspacken des Roboters hatte ich den Eindruck, ein Tablet auf Rädern zu meiner Robotersammlung hinzuzufügen. Der kleine Roboter, der sich selbst „Anna“ nennt, wie ich später herausfinden sollte, hatte auf jeden Fall ein Android-Tablet als Gesicht. Ein Tablet-Roboter.

Nach dem Einschalten erwartete mich jedoch nicht der übliche Einrichtungsprozess, wie er bei Android-Geräten üblich ist. Stattdessen wurde ich mit Musik und einem kurzen Animationsvideo begrüßt. Danach landete ich, nach einer kurzen Wartezeit (die nur beim ersten Start auftrat), auf einer kindlich-verspielten App-Übersicht. Meine erste Idee war, im Einstellungsmenü zunächst eine Verbindung zum WLAN herzustellen. Im Handbuch hatte ich bereits gelesen, dass der Roboter nur mit einem 2,4-GHz-WLAN kompatibel ist. Das WLAN meiner FritzBox arbeitet im Dual-Mode und stellt sowohl ein 5-GHz- als auch ein 2,4-GHz-Signal zur Verfügung. Der Roboter fand dieses WLAN, fragte nach dem Passwort, bestätigte die richtige Eingabe und verband sich – allerdings nur für wenige Sekunden, bevor er wieder „nicht verbunden“ anzeigte. Anscheinend mag er ausschließlich reines 2,4-GHz-WLAN. Nachdem ich mein reines 2,4-GHz-WLAN ausgewählt hatte, gab es keine weiteren Verbindungsprobleme.

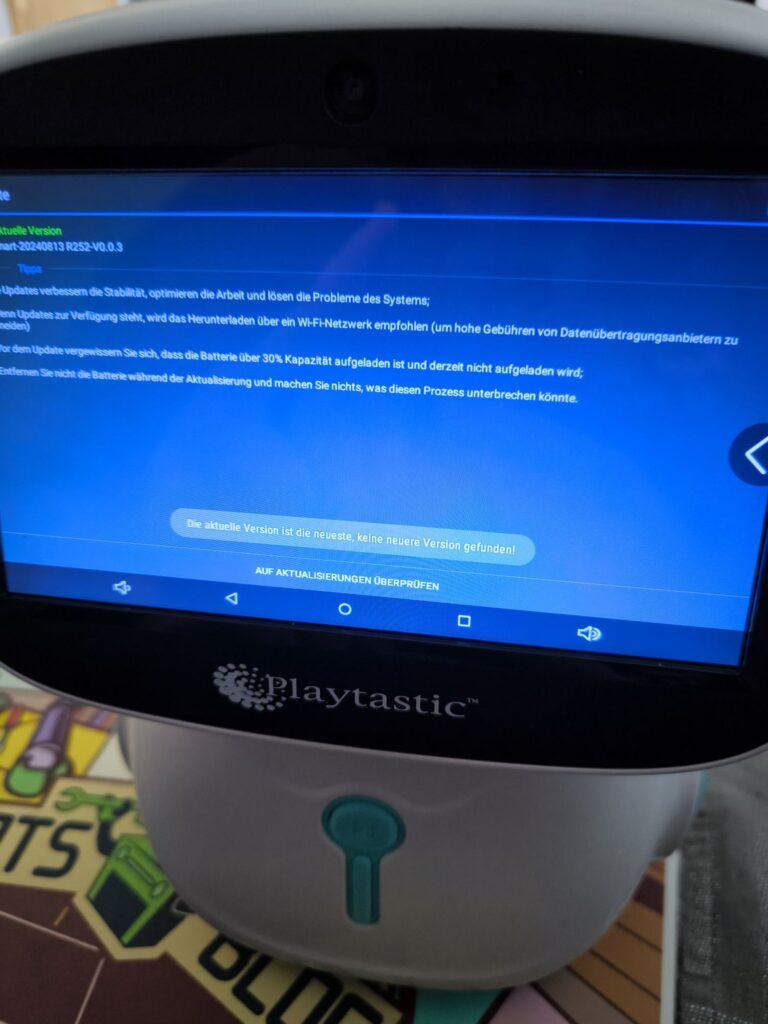

Die Android-Betriebssystemversion und die installierten Apps waren anscheinend aktuell; zumindest wurden keine Updates gefunden. Neben den vorinstallierten Lern-, Musik- und Spiele-Apps fielen mir direkt die YouTube-(Kids)- und Spotify-App auf. Hier ahnte ich auch etwas Spaß für Erwachsene!

Der erste Start der YouTube-App (nachdem das WLAN eine Internetverbindung bot) forderte leider ein Update der Google-Dienste, was wiederum die Anmeldung mit einem Google-Konto erforderte. Macht es besser nicht wie ich und legt kein neues Google-Konto direkt über das Display des Roboters an. Nutzt stattdessen einen Computer oder euer Smartphone und gebt dem Roboter anschließend nur die Zugangsdaten. Das geht deutlich schneller als über das etwas träge „Tablet“ des Roboters.

Nach der Anmeldung gelang dann auch der Start der YouTube-App. Dabei stellte ich fest, dass es sich um die YouTube-Kids-App handelte, die ich bisher nicht kannte. Die App bietet kindgerechte Videos für verschiedene Altersstufen, aber nicht das vollwertige YouTube-Erlebnis, wie man es beispielsweise vom Fernseher kennt. Es können verschiedene Kinder-/Nutzerprofile angelegt werden, und mit einem „Eltern-Account“ lässt sich genau steuern, welche Videos und Kanäle verfügbar sind oder ob das Kind eigenständig andere Kanäle suchen darf.

Für erwachsene Nutzer bleiben immerhin alle Spotify-Inhalte verfügbar. Die vorinstallierte Spotify-App funktioniert identisch zu der Version auf meinem Smartphone. Der Klang des Roboters ist laut und basslastig; manchmal hört man dadurch das Plastikgehäuse etwas vibrieren. Für Kinder und ältere Karaoke-Fans gibt es in der App „KinderFernsehen“ eine Karaoke-Videosammlung. Ein mitgeliefertes Mikrofon lässt sich an der Rückseite des Roboters einstecken. Nach dem Einschalten des Mikrofons wird der eigene Gesang mit ordentlich Hall-Effekt durch den Roboter wiedergegeben. Ein Anschluss für ein zweites Mikrofon für Duett-Partner ist ebenfalls vorhanden; allerdings wird nur ein Mikrofon mitgeliefert – ein Tablet-Karaoke-Musik-Video-Roboter.

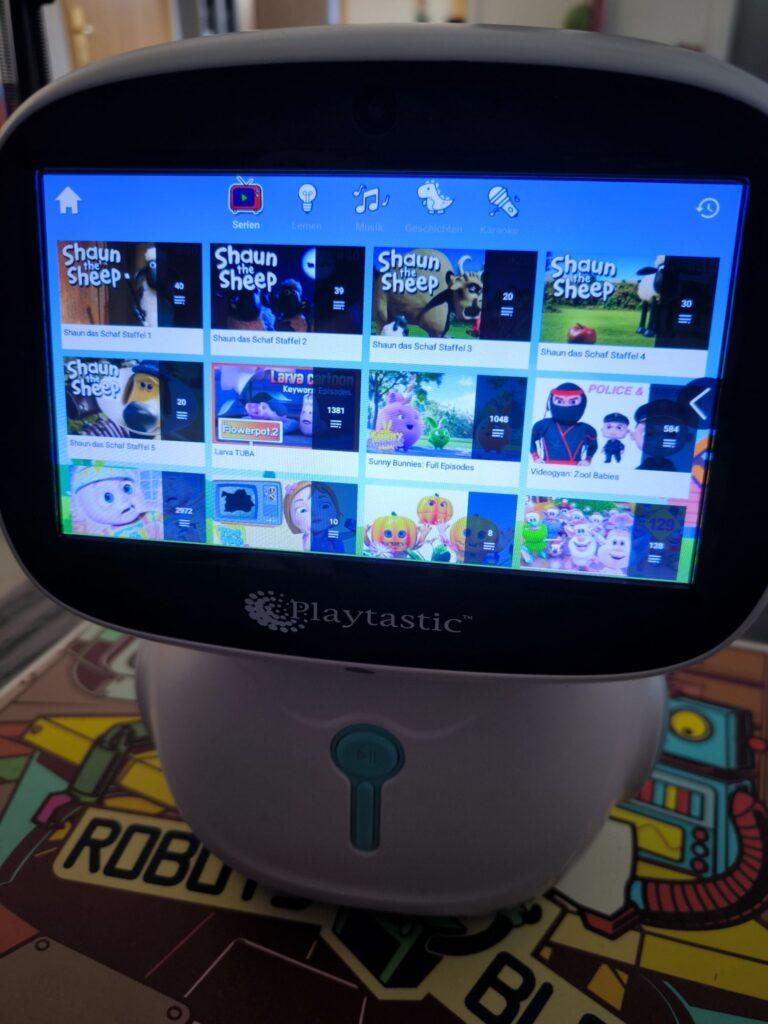

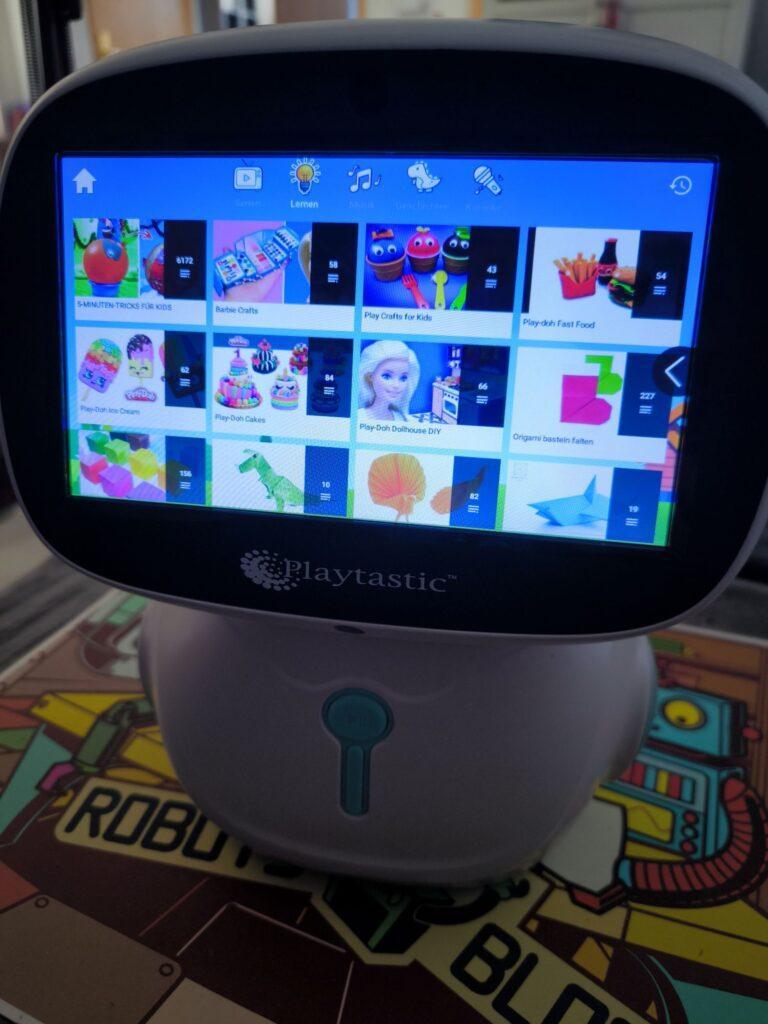

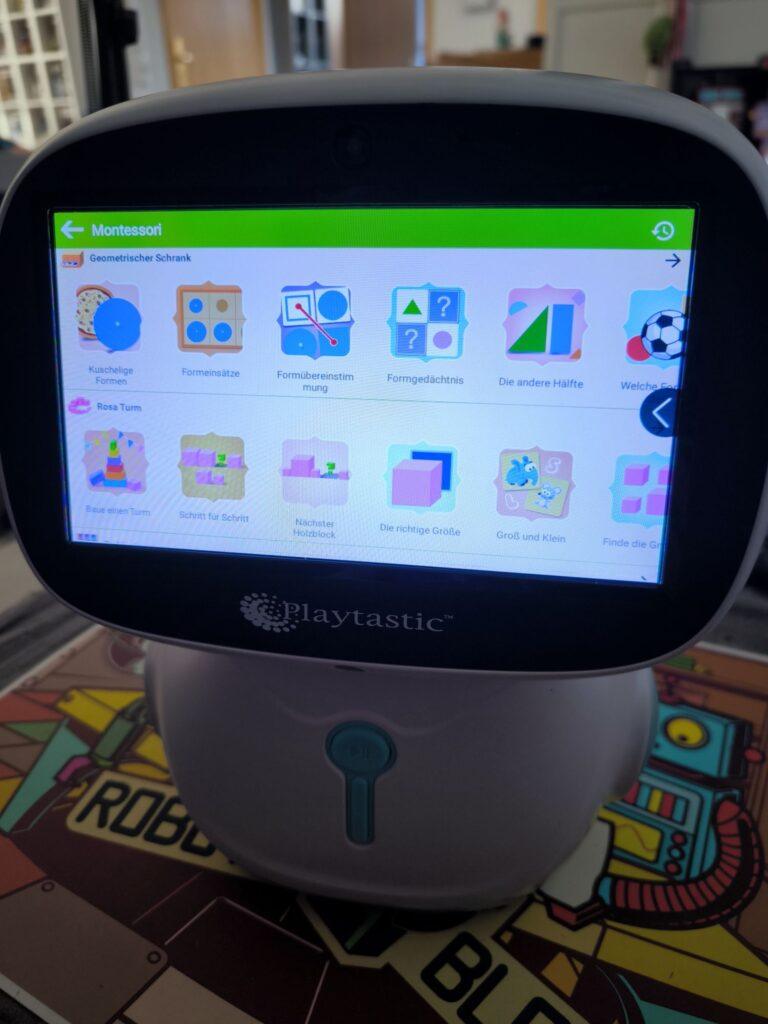

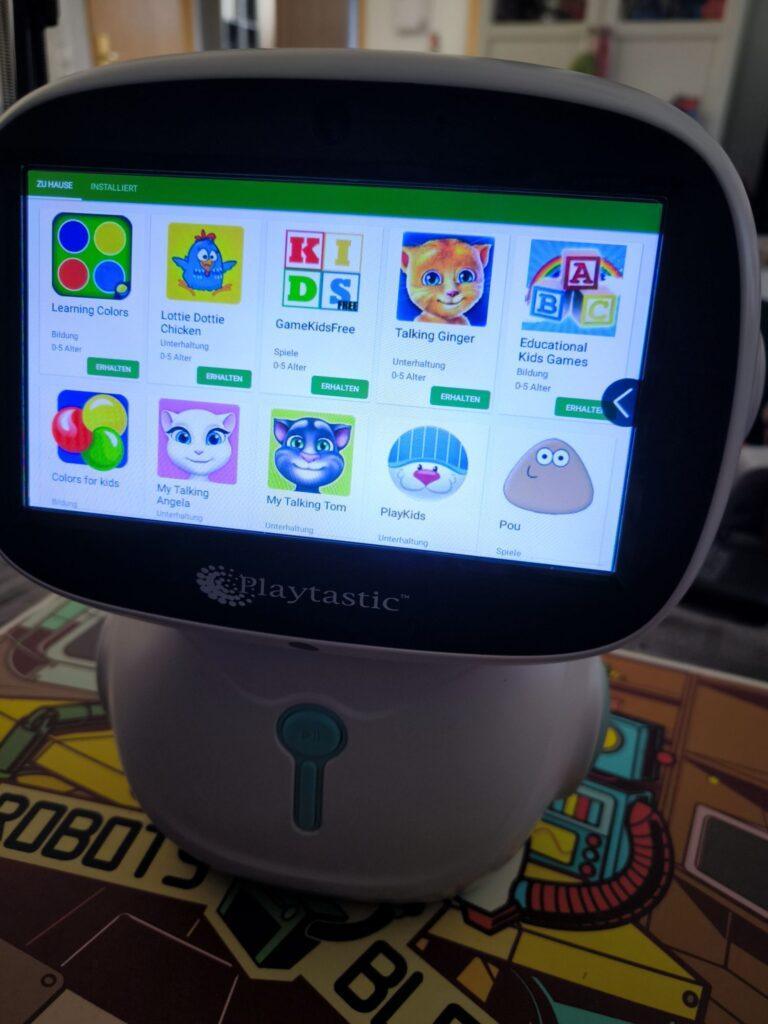

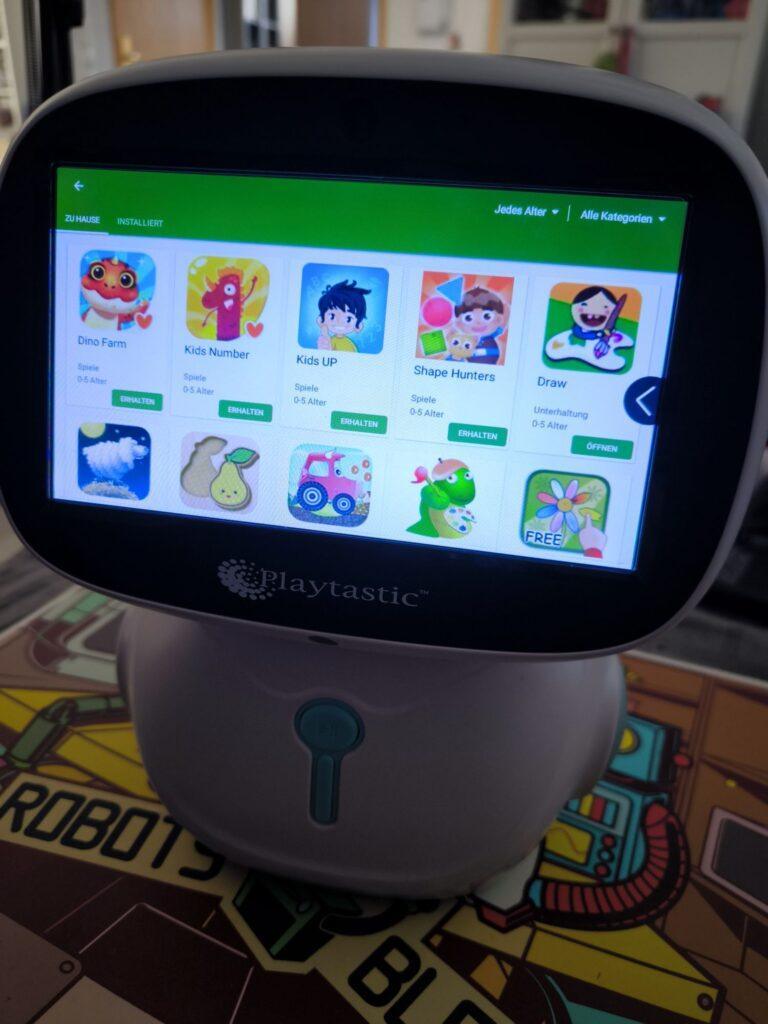

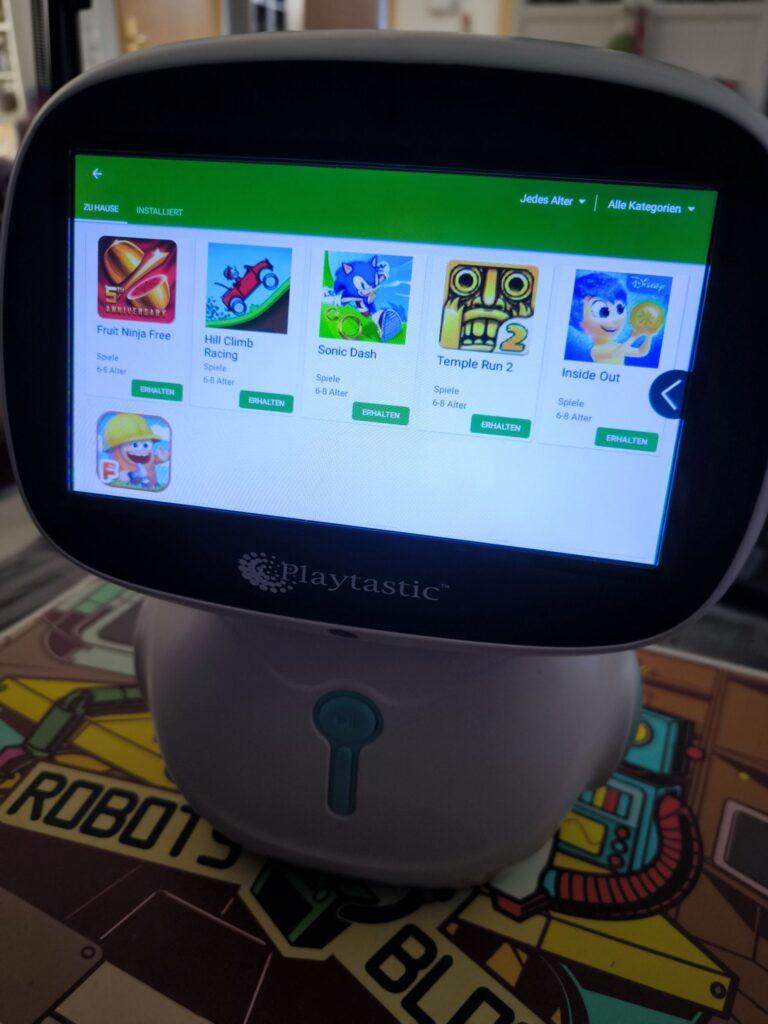

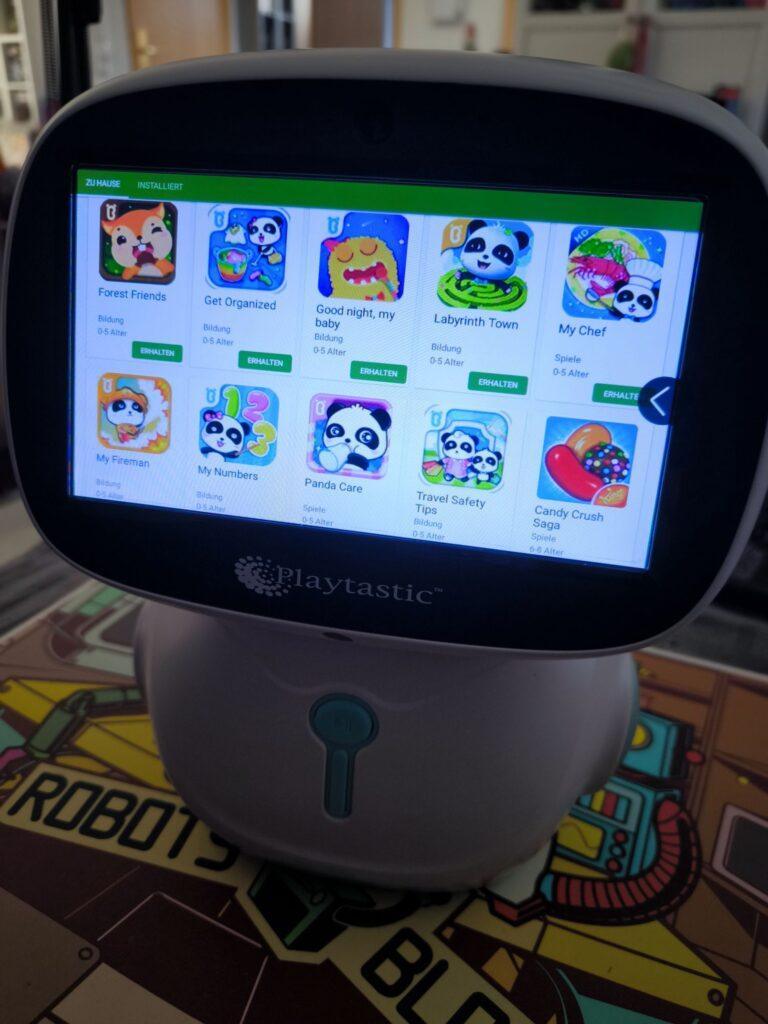

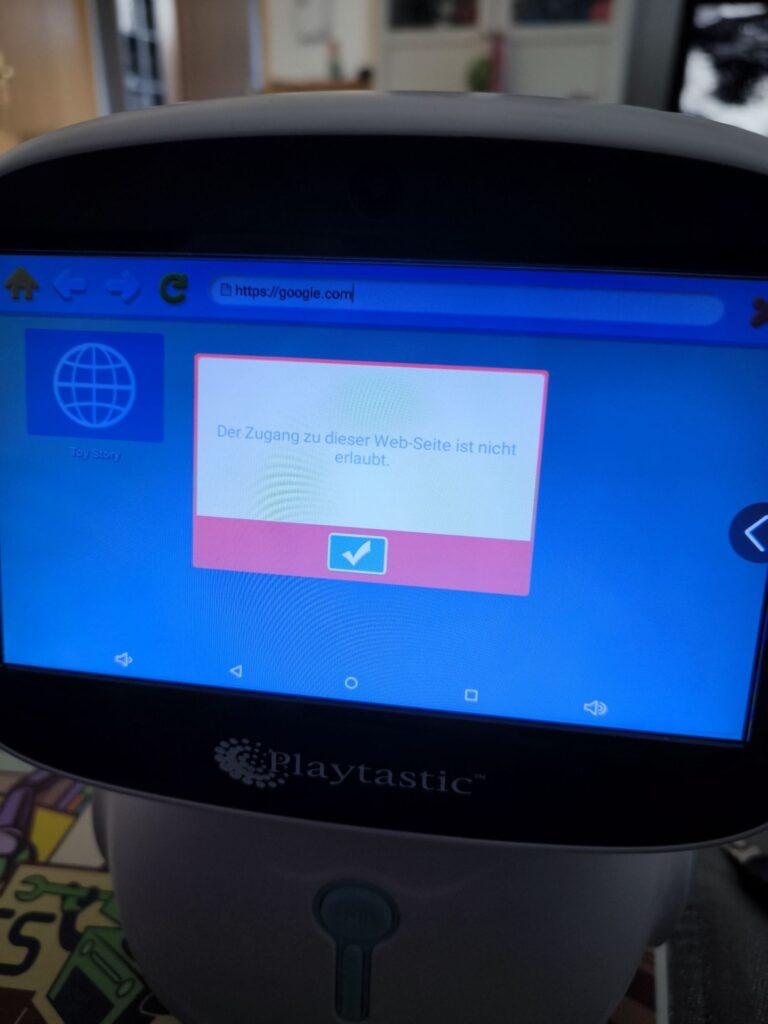

In der KinderFernsehen-App finden sich bekannte Videoreihen (wie Shaun das Schaf), Musik- und Lerninhalte sowie Spiele. Außerhalb dieser App gibt es die üblichen Anwendungen wie Wecker, Stoppuhr oder Bildergalerie sowie diverse weitere Lern-Apps: Rechnen, Malen, Schreiben, Musizieren oder Sprachen lernen – für fast alles gibt es eine App. Und wenn nicht, bietet der „Kinderladen“ eine abgespeckte Version des App-Stores mit Spielen, Lern-Apps und anderen kinderfreundlichen Inhalten. Ein Tablet-Karaoke-Musik-Video-Lern-Roboter also! Andere Android-Apps lassen sich hier jedoch nicht finden. Mir ist es auch nicht gelungen, fremde Apps zu installieren – weder per SD-Karte noch per Browser-Download –, da der integrierte Browser nur vorher freigegebene Webseiten öffnet. Wie man diese hinzufügt, habe ich nicht herausgefunden. Im PIN-geschützten „Elternmodus“ konnte ich zwar installierte Apps ausblenden (quasi vor Kindern verstecken), aber keine neuen Apps „sideloaden“. Es gibt einen erweiterten Modus, der nach mehrfachem Tippen auf die Versionsnummer des Roboters in den Einstellungen erscheint – leider geschützt durch ein mir unbekanntes Passwort. Was sich wohl dahinter verbirgt? Vielleicht die Möglichkeit zum Installieren eigener Apps?

Die App „Musik und Tanz“ öffnet einen Musikplayer, mit dem MP3s – auch von einer eingesteckten SD-Karte – abgespielt werden können. Der Unterschied zur normalen „Musik“-App: Der Roboter tanzt zur abgespielten Musik und fährt mehr oder weniger wild „tanzend“ durch die Gegend. Ich hätte mir an dieser Stelle gewünscht, eigene Bewegungsabläufe programmieren zu können – oder sogar eine Lern-App, die mir das Programmieren des Roboters beibringt und die Möglichkeiten der integrierten Motoren meines „Roboter-Tablets“ nutzbar macht. Vielleicht sogar in Kombination mit der integrierten Kamera einen Linienfolger programmieren? Vielleicht wird hierfür ja irgendwann noch eine passende App entwickelt.

Die integrierte Kamera lässt sich zum Aufnehmen von Fotos und Videos in niedriger Auflösung nutzen. Leider habe ich keine App gefunden, die die Kamera für Bewegungsspiele nutzt – so wie beim Miko 3-Roboter bekannt. Vielleicht dürfen wir auch hier noch auf Erweiterungen per App hoffen?

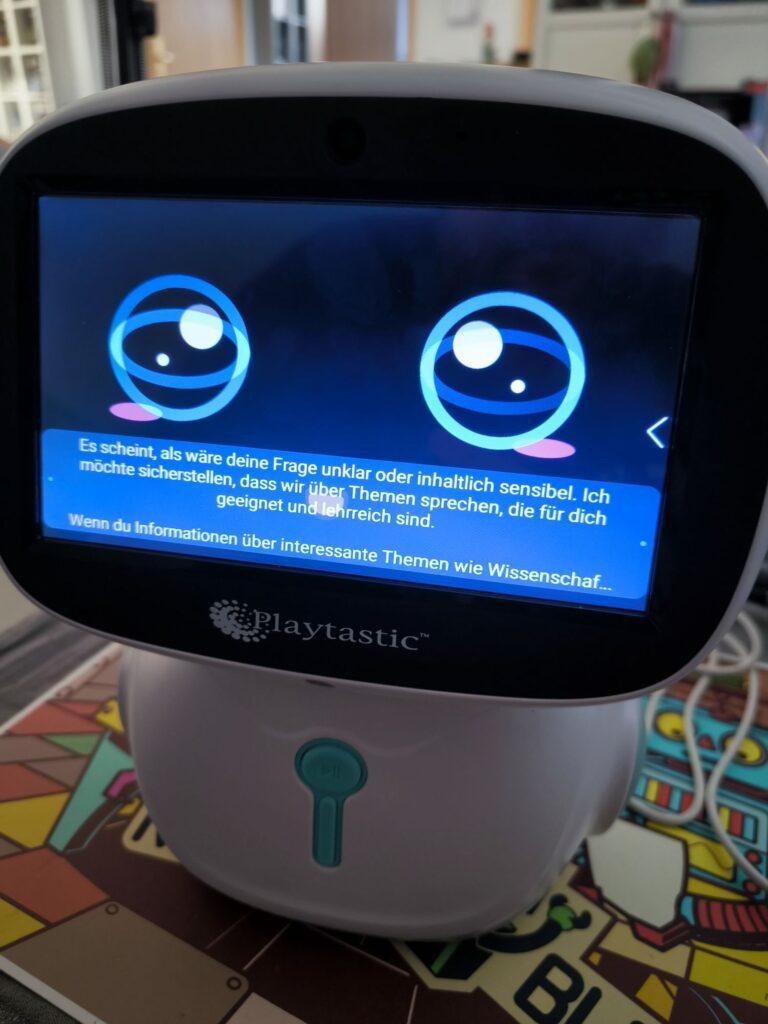

Und dann gibt es noch den ChatGPT-Assistenten-Modus: Auf dem Display erscheint ein Robotergesicht, mit dem man sich auch ohne eingestecktes Mikrofon unterhalten kann. Die Antworten kommen dabei nach etwas Verzögerung von einer ChatGPT-Instanz. Diese scheint auf Unterhaltungen mit Kindern spezialisiert zu sein und schlägt automatisch Themen wie Dinosaurier, Weltraum oder Tiere vor. Jede Antwort liefert direkt Ideen für neue Nachfragen oder Themenvorschläge und führt so aktiv durch das Gespräch. Die ChatGPT-Instanz hat keinen Zugriff auf aktuelle Online-Inhalte und ist ausreichend moderiert: Nicht kindgerechte Themen werden in vielen Fällen ignoriert oder übergangen. Zu genaue Nachfragen oder geschicktes Prompting können jedoch manchmal zumindest fragwürdige Inhalte liefern – allerdings bleiben aktiv vorgeschlagene Themen stets kindgerecht (besonders gerne Dinosaurier). Auch Rekorde aus der Tierwelt oder Umweltphänomene werden als Gesprächsthemen vorgeschlagen.

Ein Tablet-Karaoke-Musik-Video-Lern-KI-Assistenten-Roboter.

Der Roboter ist ein vielseitiges Spielzeug mit gut funktionierenden vorinstallierten Apps. Für Erwachsene gibt es nur wenige Inhalte; diese sind hier aber definitiv nicht die Zielgruppe. Als auffälliger Spotify-Player mit einigen Zusatzfeatures ist der Roboter jedoch auch für Erwachsene interessant – erwartet aber keine Höchstleistung vom integrierten Tablet! Es ist eindeutig nur für die mitgelieferten Apps ausgelegt; diese sind dafür kindgerecht und sicher … solange man keine allzu neugierigen Fragen an den ChatGPT-Assistenten stellt. Insgesamt handelt es sich um ein lehrreiches Spielzeug für Kinder – auch um erste Erfahrungen im Umgang mit KI zu sammeln. Für den Preis bekommt man sonst nur ein günstiges Tablet; hier gibt es jedoch gleich einen ganzen Roboter dazu!

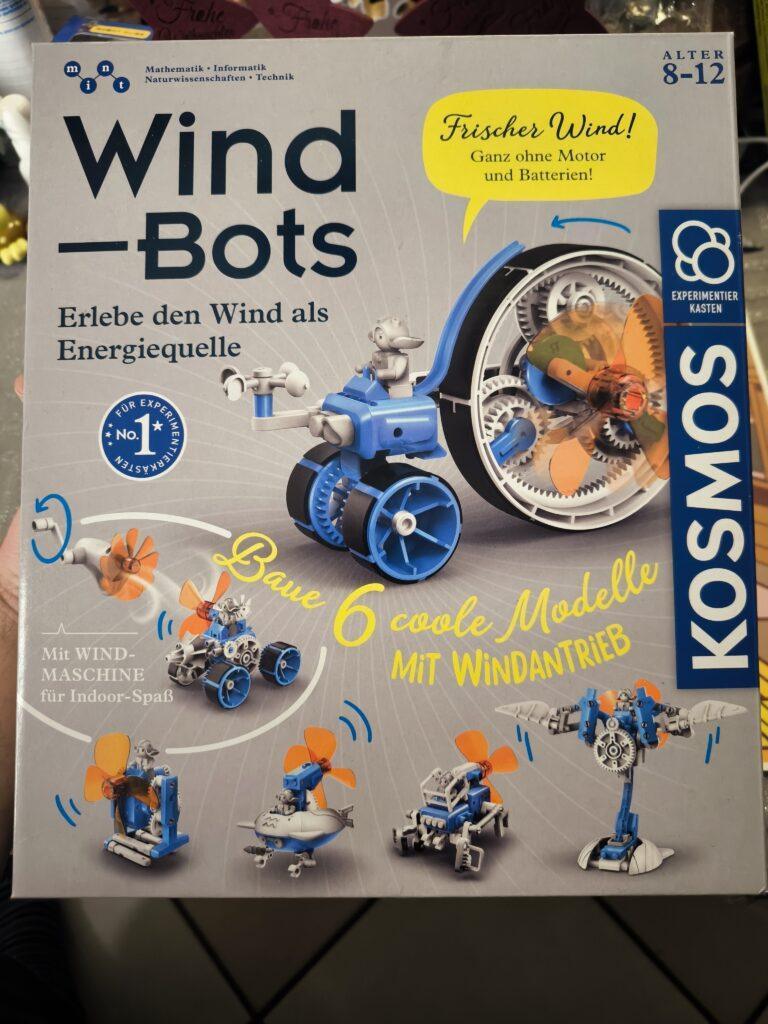

Kosmos Wind-Bots: Viel Wind um kleine Bots

Der Kosmos Wind-Bots Experimentierkasten ist ein faszinierendes Lernspielzeug, das Kinder und Jugendliche auf spannende Weise in die Welt der Mechanik, Physik und Robotik einführt. Dieser Baukasten ermöglicht es, aus einfachen Bauteilen energieeffiziente Roboter zu konstruieren, die allein durch die Kraft des Windes angetrieben werden. Hier erfahren Sie alles Wissenswerte über dieses Produkt.

Was sind Wind-Bots?

Wind-Bots sind kleine Roboter, die durch Windkraft angetrieben werden. Der Experimentierkasten von Kosmos enthält alle notwendigen Materialien und Anleitungen, um bis zu sechs verschiedene Modelle zu bauen. Dabei lernen Kinder spielerisch, wie Energie aus der Umwelt genutzt werden kann, um Bewegung zu erzeugen. Die Bots bewegen sich durch die Luftströmung eines mitgelieferten aufbaubaren „Ventilators“ oder kräftiges Anpusten, wenn man nicht gerade bei Sturm vor die Tür möchte. – eine nachhaltige und innovative Idee.

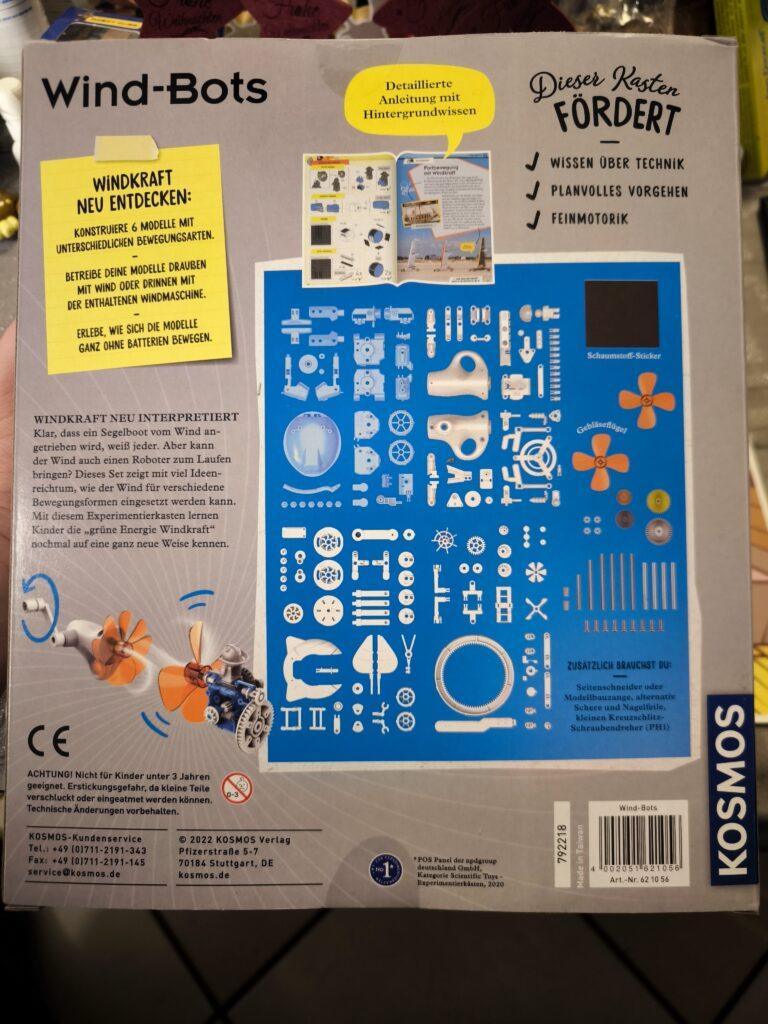

Inhalt des Experimentierkastens

Der Kosmos Wind-Bots Baukasten bietet eine Vielzahl von Komponenten, die speziell für junge Tüftler entwickelt wurden. Dazu gehören:

- Bauteile aus Kunststoff: Zahnräder, Achsen und Verbindungsstücke für die mechanischen Konstruktionen.

- Getriebe und Rotoren: Diese ermöglichen die Umwandlung von Windenergie in Bewegungsenergie.

- Anleitung: Eine detaillierte Schritt-für-Schritt-Anleitung mit farbigen Illustrationen, die den Aufbau der Modelle erleichtert.

- benötigt wird ein Schraubenzieher und ein Seitenschneider

Die Anleitung erklärt nicht nur den Bau der Modelle, sondern vermittelt auch physikalische Grundlagen wie den Zusammenhang zwischen Windkraft und Bewegung.

Mögliche Modelle

Mit dem Wind-Bots Baukasten können bis zu zehn verschiedene Roboter gebaut werden. Die Modelle umfassen unter anderem eine Flugmaschine, einen Lauf-Roboter, ein Tricycle, einen Surf-Bo(o)t, einen Quad-Läufer und einen Bohrer-Truck. Alle diese Roboter können aus den über 100 enthaltenen Bauteilen zusammengesetzt und immer wieder umgebaut werden

Jedes Modell zeigt unterschiedliche Prinzipien der Mechanik und Aerodynamik auf, was den Lernfaktor erhöht.

Lernziele und Vorteile

Der Kosmos Wind-Bots Experimentierkasten ist nicht nur ein Spielzeug, sondern auch ein wertvolles Lernwerkzeug. Zu den wichtigsten Vorteilen zählen:

- Förderung des technischen Verständnisses: Kinder lernen grundlegende physikalische Konzepte wie Energieumwandlung und Aerodynamik.

- Kreativität und Problemlösung: Beim Zusammenbau der Modelle werden logisches Denken und Kreativität gefördert.

- Nachhaltigkeitsbewusstsein: Die Nutzung von Windkraft sensibilisiert Kinder für erneuerbare Energien.

- Spaß am Experimentieren: Die interaktiven Modelle machen Wissenschaft greifbar und spannend.

Für wen ist der Baukasten geeignet?

Der Kosmos Wind-Bots Experimentierkasten richtet sich an Kinder ab 8 Jahren. Dank der klaren Anleitungen können auch Anfänger problemlos mit dem Set arbeiten. Es eignet sich hervorragend für technikbegeisterte Kinder und als gemeinsames Projekt für Eltern und Kinder.