Technik verstehen – ganz ohne Fachchinesisch

Roboter, künstliche Intelligenz, Maschinen, die lernen können – das klingt erst einmal ziemlich kompliziert. Genau hier setzt „Roboter und KI“ an. Das Buch zeigt, dass Technik nicht einschüchternd sein muss, sondern neugierig machen kann. Und zwar so, dass Kinder ab etwa 8 Jahren problemlos folgen können – und Erwachsene oft gleich mitlesen.

Schon nach den ersten Seiten wird klar: Hier geht es nicht darum, alles perfekt zu verstehen. Es geht ums Entdecken, Staunen und Fragenstellen. Und genau das macht den Reiz dieses Buches aus.

Was dich im Buch erwartet

Statt streng von vorne nach hinten gelesen zu werden, lädt dieses Buch zum Querlesen ein. Du kannst selbst entscheiden, welches Thema dich gerade interessiert – fast so, als würdest du durch ein Technik-Museum schlendern und an den Stationen stehen bleiben, die dich am meisten ansprechen.

Im Buch geht es unter anderem darum,

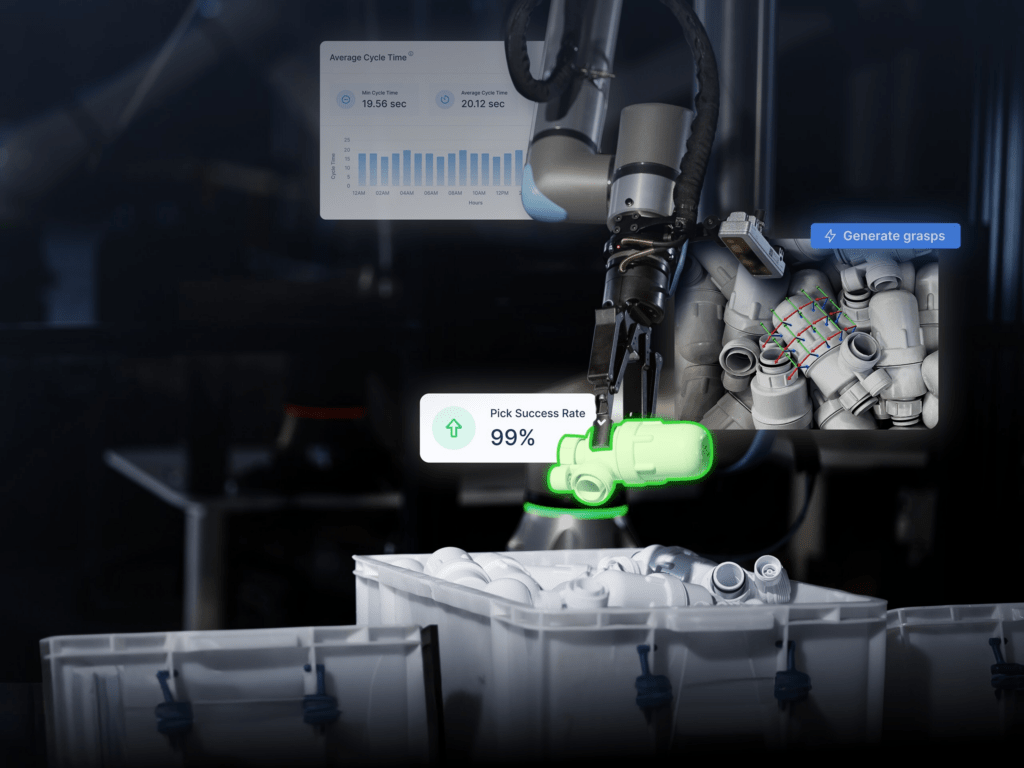

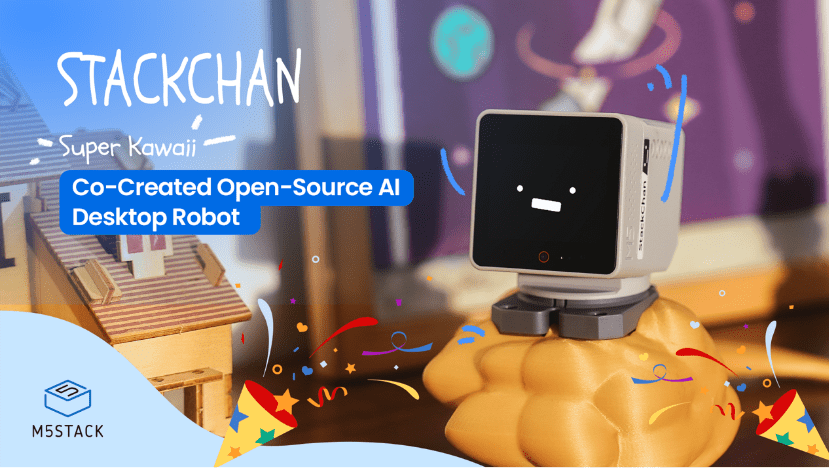

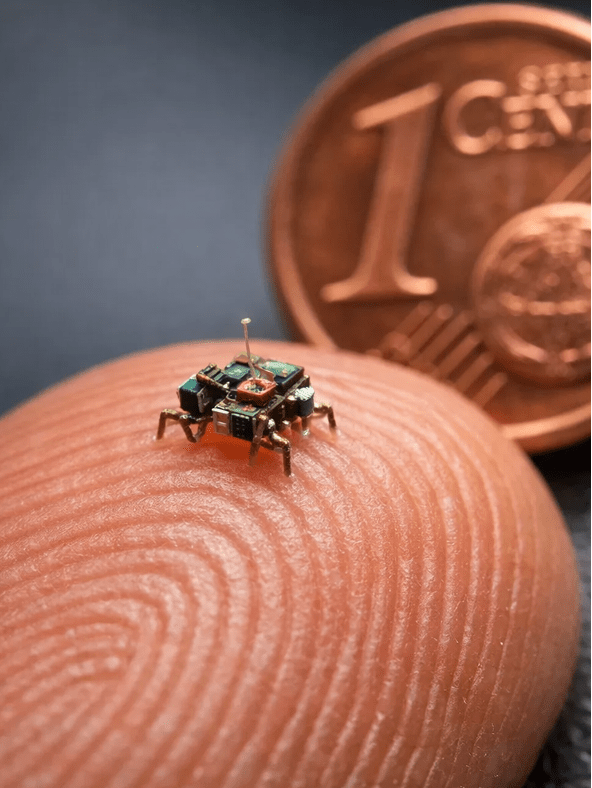

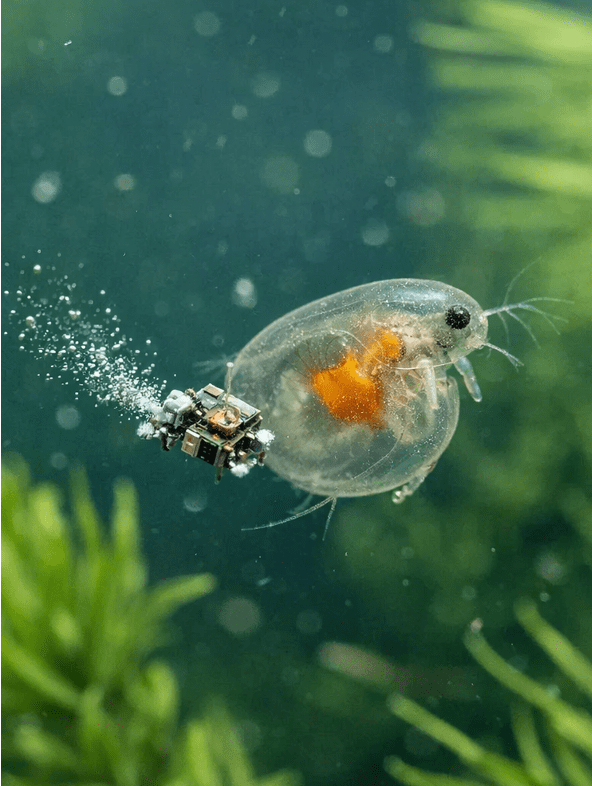

- was Roboter eigentlich sind und wo sie uns heute schon begegnen

- wie künstliche Intelligenz funktioniert – ganz einfach erklärt

- warum Roboter im Weltall, in Krankenhäusern oder sogar beim Spielen helfen

- wie Maschinen lernen können und was das mit unserem eigenen Lernen zu tun hat

Die Texte sind bewusst kurz gehalten, werden durch Bilder, Infokästen und kleine Zusatzinfos ergänzt und lassen sich auch gut in Etappen lesen. Ideal also für zwischendurch – oder für einen gemütlichen Lesenachmittag.

Warum Leser:innen das Buch mögen

In Rezensionen auf Plattformen wie Thalia, Hugendubel oder Amazon liest man immer wieder, dass das Buch Kinder richtig gut abholt. Besonders positiv fällt auf, dass Technik hier nicht trocken erklärt wird, sondern in kleinen Häppchen, die neugierig machen.

Viele Eltern berichten, dass ihre Kinder selbstständig im Buch stöbern, hin- und herblättern und immer wieder neue Seiten entdecken. Genau dieses freie Lesen motiviert – vor allem Kinder, die bei klassischen Sachbüchern schnell die Lust verlieren.

Auch die Erklärweise wird häufig gelobt. Fachbegriffe werden nicht einfach hingeschrieben, sondern so erklärt, dass man sie wirklich versteht. Oft helfen Vergleiche aus dem Alltag dabei, zum Beispiel aus Spielen, Schule oder dem eigenen Zuhause.

Ein weiterer Pluspunkt ist die Gestaltung: Die Seiten sind farbig, übersichtlich und hochwertig gestaltet. Das Buch fühlt sich stabil an, liegt gut in der Hand und eignet sich auch hervorragend als Geschenk.

Mein Fazit

„Kosmos SchlauFUX – Roboter und KI“ ist ein Buch, das Lust auf Zukunft macht. Es erklärt große Themen verständlich, ohne sie zu vereinfachen, und zeigt, dass Technik nichts Abgehobenes ist, sondern längst zu unserem Alltag gehört.

Besonders schön: Man muss kein Technik-Profi sein, um Spaß an diesem Buch zu haben. Es reicht Neugier – der Rest kommt beim Lesen fast von allein. Ein Buch, das man immer wieder zur Hand nimmt und jedes Mal etwas Neues entdeckt.

Hier gehts zum Buch

👉 „Roboter & KI“ aus der SchlauFUX-Reihe vom Kosmos Verlag

https://amzn.to/46IMeKn