Archiv der Kategorie: Industrial Robots

Volker Spanier präsentiert neuen Epson 6-Achs-Roboter Cobot AX6 im Robots-Blog Interview auf automatica 2025

Spielerische Robotik-Ausbildung: igus Low-Cost-Automation bewährt sich im Schulalltag

Georg-Simon-Ohm-Berufskolleg setzt auf ReBeL Cobots und Education Kits von igus, um Schülern einen einfachen Einstieg in die Roboter-Programmierung zu ermöglichen

Köln, 17. Juni 2025 – Junge Menschen für Technik begeistern: Dieses Ziel verfolgt der Kunststoffspezialist und Robotikhersteller igus mit seinen Bildungsangeboten speziell für Schulen, Hochschulen und Universitäten. Dazu zählt auch das ReBeL Education Kit: Ein Lernpaket, das Schülern und Studierenden den spielerischen Einstieg in die Robotik mithilfe des ReBeL Cobots ermöglichen soll. Zum Einsatz kommen die Education Kits unter anderem am Georg-Simon-Ohm-Berufskolleg in Köln. So bekommen die Schüler die Möglichkeit, erste Programmierkenntnisse zu erwerben und praxisnahe Anwendungen zu erproben.

Von Elektrotechnik über Datenbankwissen bis hin zur Softwareentwicklung: Die Ausbildung zum Informationstechnischen Assistenten am Georg-Simon-Ohm-Berufskolleg in Köln umfasst ein vielseitiges Lehrprogramm. Dazu gehört auch das Programmieren von Robotern, um den Schülern besondere Qualifikationen in der Automatisierungstechnik zu vermitteln. „Für unsere Robotik-Klasse kamen bisher humanoide Robotiksysteme zum Einsatz, die jedoch mit der Zeit störungsanfällig geworden sind“, erklärt Kevin Meyer, Lehrer für Elektrotechnik und Robotik am Georg-Simon-Ohm-Berufskolleg. „Daher brauchten wir Ersatz für die alten Systeme und haben uns gezielt auf die Suche nach Roboterarmen gemacht, die einfach zu bedienen sind und realitätsnahe Anwendungsszenarien ermöglichen.“ Fündig wurde das Berufskolleg schließlich beim Kölner Kunststoffspezialisten igus.

Programmieren lernen mit realitätsnahen Anwendungsbeispielen

„igus war uns bereits für seine Energieketten bekannt, doch bei unserer Suche sind wir dann auch auf das Low-Cost-Automation-Angebot gestoßen und haben gleich einen Beratungstermin vor Ort ausgemacht“, erzählt Kevin Meyer. Auf der 400 Quadratmeter großen Customer Test Area können Kunden zahlreiche Automationslösungen aus der Praxis in Aktion sehen und gemeinsam mit den Robotik-Experten von igus die Machbarkeit ihrer geplanten Anwendung testen. Die Wahl fiel schließlich auf zehn ReBeL Cobots mit sechs Achsen inklusive Education Kits. „Roboter gibt es auf dem Markt zwar viele, aber die Alternativen waren für unsere Zwecke entweder zu klein oder zu teuer. Zudem war für uns auch eine leichte Bedienbarkeit wichtig.“ Der ReBeL Cobot mit einem Gewicht von nur 8,2 Kilogramm, einer Traglast von zwei Kilogramm und einer Reichweite von 664 Millimetern ist in der vollausgestatteten Plug-and-Play-Variante bereits für 4.970 Euro erhältlich. Im Education Kit enthalten sind über 100 Stunden Lernmaterial und Projektplatten, die auf eine Arbeitsfläche montiert werden. Anhand derer lassen sich unterschiedliche Szenarien mit Realitätsbezug programmieren: ob Behälter in ein Hochregal sortieren, Bauteile eines Fahrrads vom Förderband nehmen und an der entsprechenden Stelle einsetzen oder die Qualitätskontrolle am Fahrrad. Die kostenlose und lizenzfreie igus Robot Control Software ermöglicht zudem eine einfache Bedienbarkeit und erleichtert den Einstieg in die Roboterprogrammierung.

Lernende gezielt auf die moderne Arbeitswelt vorbereiten

Die ReBeL Cobots und Education Kits sind inzwischen seit einem Jahr in vier Robotik-Klassen des Berufskollegs im Einsatz. „Die meisten Schüler arbeiten sehr gerne mit den Robotern. Die Bedienung war am Anfang für manche noch eine Herausforderung, aber am Ende haben es alle geschafft“, erzählt Kevin Meyer. Die Software sei visuell sehr anschaulich und ermögliche den Schülern, schnell kleine Fortschritte zu machen. Alexander Mühlens, Leiter Geschäftsbereich Low-Cost-Automation bei igus betont: „Uns liegt die Förderung des Roboternachwuchses sehr am Herzen, daher freuen uns solche Projekte immer besonders. Mit unserem breiten Bildungsangebot möchten wir Schulen, Hochschulen und Universitäten dabei unterstützen, theoretisches Wissen praxisnah zu vermitteln und Lernende gezielt auf die moderne Arbeitswelt vorzubereiten.“

Mehr Informationen zum Robotik-Bildungsangebot von igus finden Sie hier:

KI-Gestenerkennung mit IDS NXT Kamera lässt igus ReBel Roboter Stein, Schere, Papier gegen Mensch spielen

Automatica 2025: Vention erweitert Angebot mit Robotiklösungen von Franka Robotics

MÜNCHEN, 17. Juni 2025 /PRNewswire/ — Vention, Anbieter der weltweit einzigen vollständig integrierten Software- und Hardware-Plattform für industrielle Automatisierung, erweitert sein Robotik-Portfolio um kollaborative Roboter der Franka Robotics GmbH, einer Tochtergesellschaft der in München ansässigen Agile Robots SE.

- Vention hat sein Roboterangebot um kollaborative Roboter der Franka Robotics GmbH erweitert, einem in Deutschland ansässigen Hersteller von Präzisions-Cobots, die in der Forschung und Entwicklung beliebt sind.

- Vention und Franka Robotics zeigen auf der Automatica PCB-Tests mit einem Franka Research 3 (FR3)-Roboter für die präzise und sichere Automatisierung empfindlicher Elektronik.

- Darüber hinaus präsentiert Vention KI-gestütztes Bin-Picking und ein All-in-One-Steuerungssystem für Bewegung, Bildverarbeitung, Sensorik und KI.

- MachineMotion™ AI, Ventions Steuerung der dritten Generation, feiert ihre Europapremiere mit einer KI-gestützten Bin-Picking-Demonstration auf einem ABB GoFa – inklusive intelligenter Teileerkennung und Greifpräzision im Submillimeterbereich.

- Modulare Roboterzellen für Maschinenbestückung und Palettierung werden ebenfalls gezeigt – mit führenden Robotermarken wie Universal Robots und FANUC.

- Besucher von Stand B4.307 erhalten kostenlosen Zugang zu MachineBuilder 101™, dem neuen Zertifikatskurs von Vention zur Planung, Simulation und Inbetriebnahme von Automatisierungslösungen auf der Vention-Plattform.

Franka Robotics hat sich mit seinem beliebten FR3-Roboterarm als führende Plattform in der akademischen Forschung etabliert und ist mittlerweile die bevorzugte Wahl für Doktoranden, KI-Forscher und Robotik-Labore. Mit der Aufnahme von Franka Robotics-Anwendungen in das eigene Portfolio erweitert Vention sein Angebot gezielt, um der starken Nachfrage von Hochschulen, Forschungseinrichtungen und innovationsgetriebenen Unternehmen gerecht zu werden, die bereits im Vention-Ökosystem arbeiten.

Vention präsentiert auf der Automatica 2025 (vom 24. bis 27. Juni) in München erstmalig eine Live-Demonstration mit einem FR3-Roboter von Franka Robotics (Stand B4.307).

„Wir sind stolz, Franka Robotics im Vention-Ökosystem begrüßen zu dürfen“, sagt Francois Giguere, Chief Technology Officer von Vention. „Der sehr gute Ruf von Franka Robotics im akademischen Umfeld passt perfekt zu unserer Mission, die industrielle Automatisierung zugänglicher und intuitiver zu gestalten. Wir freuen uns über die Zusammenarbeit mit einer angesehenen deutschen Marke – Deutschland hat die Geschichte von Vention von Anfang an maßgeblich geprägt, und diese Partnerschaft markiert ein spannendes neues Kapitel auf unserem Weg.“

„Die Partnerschaft mit Vention ermöglicht es uns, die Reichweite unseres Roboters Franka Research 3 einem breiteren Anwenderkreis im akademischen Bereich und in innovativen Anwendungen zugänglich zu machen“, erklärt Henrik Hermann, Vertriebsleiter bei Franka Robotics. „Gemeinsam setzen wir uns dafür ein, innovative, benutzerfreundliche Automatisierungslösungen zu liefern, die unseren Kunden neue Möglichkeiten in der Robotik und KI eröffnen.“

Der FR3 ist ein benutzerfreundlicher, kompakter und leichter (18 kg) Roboterarm mit sieben Freiheitsgraden. Er ist sicher, hochflexibel und damit ideal für Laborumgebungen mit begrenztem Platzangebot. Dank seiner drehmomentgeregelten Gelenke verfügt er über eine Echtzeit-Kraftsensorik, mit der er Kräfte wahrnehmen und darauf reagieren kann. Dies ist entscheidend für die Forschung zur Mensch-Roboter-Interaktion, das Lernen durch Demonstration sowie die Durchführung kontaktintensiver Aufgaben mit empfindlichen Komponenten.

Vention auf der Automatica 2025

Vention zeigt auf der Automatica insgesamt vier Live-Demonstrationen, die die vollständig integrierte Automatisierungsplattform des Unternehmens in der Praxis erlebbar machen – durch die Kombination aus intuitiver Software, modularer Hardware und den KI-gestützten Funktionen von MachineMotion™ AI.

MachineMotion™ KI & NVIDIA-Technologie – Leistungsstarke Bewegungssteuerung

Nach der NVIDIA GTC 2025 und der Automate in den USA stellt Vention seine KI-gestützten Bin-Picking-Demonstration mit einem ABB GoFa CRB 15000 erstmals auf einer europäischen Messe vor. Auf Basis von MachineMotion™ AI, NVIDIA Jetson Computing sowie CUDA-beschleunigten Isaac-Bibliotheken und -Modellen von NVIDIA deckt die Live-Demonstration von Vention fortschrittliche Robotik, KI-basierte Bewegungssteuerung und skalierbare Schulungsszenarien ab – und zeigt, welchen konkreten Mehrwert KI bei der praktischen Implementierung robotergestützter Lösungen in der Fertigung bietet. Die Anwendung erreicht eine Greifgenauigkeit im Submillimeterbereich bei ungeordneten Fertigungsteilen – ideal für High-Mix-/Low-Volume-Produktionsumgebungen.

Modulare Demos für praxisnahe Anwendungen

Im Rahmen Automatica wird Vention den FR3-Arm von Franka Robotics bei Leiterplattentests auf einer Vention-Workstation vorführen und die Präzision und schonende Handhabung für empfindliche Elektronik und feinmotorische Aufgaben demonstrieren.

Darüber hinaus erleben Besucher vollständig integrierte, anpassbare Roboterzellen für:

- 7th Axis Range Extender – für mehr Reichweite und Flexibilität bei Anwendungen wie Maschinenbestückung, Montage und Verpackung.

- Rapid Series Palletizer – aufgebaut auf einer Teleskopsäule und optimiert mit der neuesten Version 4.5 der MachineApp-Software von Vention.

Die Live-Demonstrationen finden in Halle B4, Stand 307 statt.

Weitere Informationen auf Vention.com.

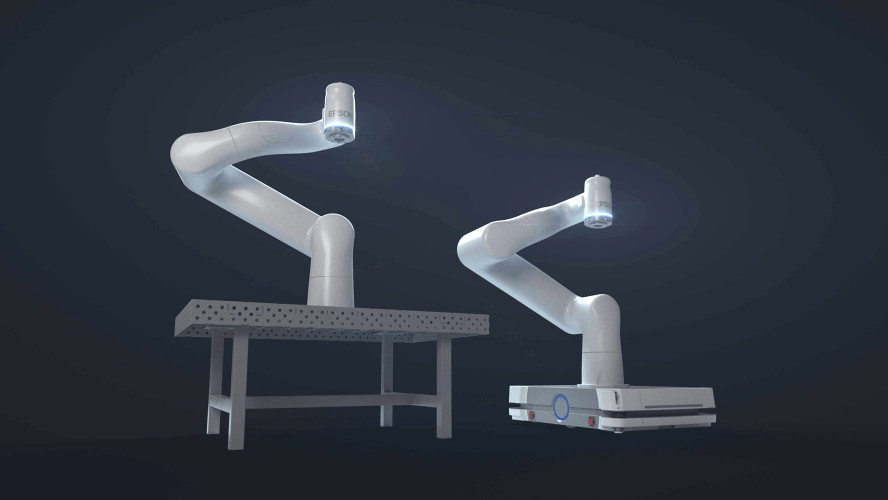

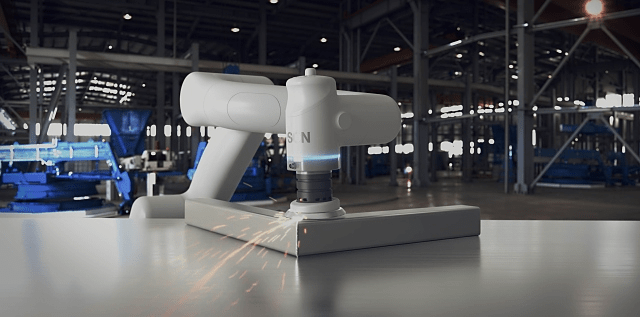

automatica 2025: erster kollaborativer Roboter von Epson

Düsseldorf, 10. Juni 2025 – Epson, ein führender Anbieter von Roboter- und Automatisierungstechnik, stellt auf der automatica 2025 seine erste kollaborative Industrieroboterlösung vor. Diese ermöglicht in Branchen wie Fertigung, Logistik und dem sich schnell entwickelnden Life-Science-Sektor eine wirkungsvolle Interaktion zwischen Mensch und Maschine und steigert so die Effizienz und Produktivität. Die Lösung wird ab Herbst 2025 als erstes kollaboratives Roboter-Komplettpaket von Epson angeboten, welches den neuen, aus Carbon-Leichtbau bestehenden 6-Achs-Roboter AX6-A901S sowie die kompakte Epson RC-A101-Steuerung inklusive dem Programmiersystem AX-Portal umfasst.

„In den stark wachsenden Bereichen Biowissenschaften und pharmazeutische Industrie sind präzise Arbeitsabläufe und ein strenges Hygienemanagement von größter Bedeutung“, erklärt Volker Spanier, Head of Manufacturing Solutions von Epson. „Um auch diese Anforderungen zu erfüllen, ist der neue kollaborative Roboter von Epson reinraumtauglich. Dank seiner präzisen Bewegungen erlaubt die Maschine daher auch in Laboren und pharmazeutischen Einrichtungen die Verrichtung selbst komplizierter Aufgaben.“

Wichtige Produktmerkmale des kollaborativen Roboters AX6-A901S von Epson:

- Ausbalanciertes Design: Der AX6-A901S bewegt eine Nutzlast von bis zu 6 kg bei einer Armlänge von 900 mm. Er besitzt ein besonders leichtes und kompaktes Design, sodass sowohl sein Transport als auch seine Integration in bestehende Produktionslinien sehr einfach sind. Dank der kompakten Abmessungen lässt er sich auch in beengten Umgebungen einsetzen.

- Kompakter und leichter Controller: Der Epson RC-A101-Controller ist für die Installation auf fahrerlosen Transportfahrzeugen (AGVs) und autonomen, mobilen Robotern (AMRs) geeignet. Er hat die Abmessungen B 440 x T 205 x H 135 mm und wiegt weniger als 6 kg. Auch dieses kompakte Design ermöglicht eine sehr platzsparende Installation.

- Kompatibel zu verschiedenen Stromquellen: Der kollaborative Roboter ist mit Stromquellen von 100 bis 230 VAC bzw. 48 VDC kompatibel, sodass er in Umgebungen mit verschiedenen Stromquellen installiert werden kann.

- Reinraumkompatibilität: Der AX6-A901S besitzt die Reinraumklasse 5 nach ISO 14644-1 und die Schutzart IP54. Das glatte Gehäusedesign ohne Schraubenlöcher und scharfe Kanten minimiert die Staubansammlung und damit das Kontaminationsrisiko in Reinraumumgebungen.

- Python-Programmierung: Die Programmierumgebung unterstützt die weit verbreitete Programmiersprache Python. Diese Kompatibilität vereinfacht die Integration in alle F&E-Umgebungen und die Inbetriebnahme. Auch wird so das Erlernen einer neuen Programmiersprache unnötig.

Spanier fasst zusammen: „Epsons Engagement für die Weiterentwicklung der Robotik resultiert in diesem kollaborativen Roboter, der auch sehr komplexe Aufgaben sicher ausführt. Damit erfüllen wir die wachsende Nachfrage der Labor- und Pharmaindustrie und weiteren Branchen. Diese Maschine stellt einen bedeutenden Fortschritt auf dem Weg zur Verbesserung des Epson Angebotes im Bereich der industriellen Automatisierung dar. Unsere Roboter erfüllen dabei auch die strikten Anforderungen des Life-Science-Sektors und gewährleisten Sicherheit und Präzision bei jeder Interaktion zwischen Mensch und Maschine.“

Zu den neuen Robotern gibt es am 24. Juni eine Pressekonferenz am Epson Stand 311 in Halle B5

Weitere Informationen zu den Robotiklösungen von Epson:

automatica 2025 | Epson Europe

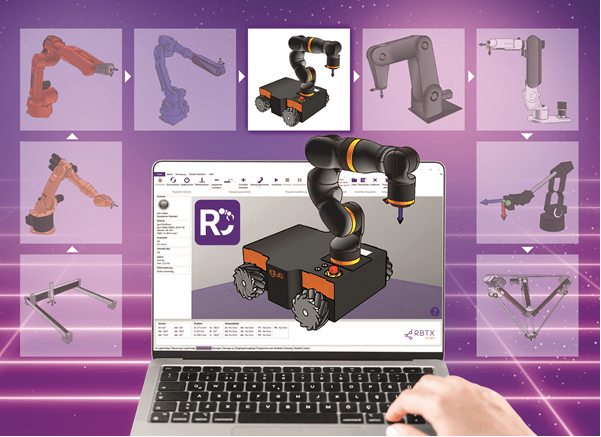

RobotCtrl: Einfachere Steuerung für alle Robotik-Hersteller

Die igus Steuerungssoftware für herstellerunabhängige Robotik wächst – Lebai, Hitbot und Lynx Motion jetzt verfügbar

Köln, 3. Juni 2025 – Automatisierung muss nicht kompliziert sein – mit RobotCtrl wird sie für Unternehmen jeder Größe noch zugänglicher. Durch die intuitive Steuerungssoftware von igus lassen sich auf dem Online-Robotik-Marktplatz RBTX erhältliche Roboter unabhängig vom Hersteller einheitlich bedienen und Zubehör wie Kameras, Greifer oder Roboterzellen integrieren. Damit reduziert RobotCtrl die Bedienungskomplexität und den Integrationsaufwand für Einsteiger und Profis erheblich. Neu hinzugekommen ist die Unterstützung der Robotikhersteller Lebai, Hitbot und Lynx Motion.

Als führender Marktplatz für Robotik und Automatisierung vereint RBTX über 175 Anbieter und mehr als 850 Roboter und Komponenten an einem Ort. Ob Greifer, Sensoren oder komplette Robotersysteme – hier finden Interessierte alles, was sie für ihre Automatisierung benötigen. Mit der von igus entwickelten RobotCtrl wird die Integration und Steuerung von Low-Cost-Automatisierung noch flexibler und einfacher als je zuvor. Auf RBTX erhältliche Roboter können mit der Software einheitlich programmiert und gesteuert werden. Nutzer profitieren von einer verringerten Einarbeitungszeit, da sie nur eine einzige Software beherrschen müssen. Die Möglichkeit, Roboter verschiedenster Hersteller mit nur einer Steuerung zu programmieren, spart allerdings nicht nur Zeit und Schulungskosten, sondern eröffnet Unternehmen auch neue Möglichkeiten für eine herstellerunabhängige Automatisierungsstrategie. Dank des modularen Aufbaus unterstützt RobotCtrl verschiedene Roboterkinematiken unterschiedlicher Hersteller, darunter igus, Fanuc, KUKA und viele mehr. Dies ermöglicht eine nahtlose Integration verschiedener Robotiksysteme in bestehende Produktions- und Automatisierungslösungen. Die Bewegungsabläufe der Roboter können auf einer 3D-Oberfläche simuliert werden – ohne dass der Roboter physisch angeschlossen sein muss. „Dies erleichtert die Planung und Entwicklung neuer Prozesse und ermöglicht es Automatisierungsstrategien effizient zu testen bevor sie in die Praxis umgesetzt werden“, macht Alexander Mühlens, Leiter Geschäftsbereich Low-Cost-Automation bei igus, deutlich. „Unternehmen können somit schneller auf Marktanforderungen reagieren, Produktionsprozesse effizienter gestalten und so Kosten sparen.“

Roboter-Programmierung leicht gemacht

RobotCtrl wurde bereits erfolgreich mit führenden Herstellern getestet. Nutzer können somit sicher sein, dass sie mit einer bewährten und zuverlässigen Software arbeiten. Ein weiterer Vorteil von RobotCtrl ist die benutzerfreundliche grafische Oberfläche, die eine intuitive Programmierung erlaubt. Dank einer Drag-and-Drop-Funktion können Bewegungsabläufe einfach erstellt und angepasst werden. Dies reduziert den Programmieraufwand und macht die Software auch für Anwender ohne tiefgehende Programmierkenntnisse leicht verständlich. Besonders für kleine und mittelständische Unternehmen, die bisher vor der Komplexität der Robotik zurückgeschreckt sind, bietet RobotCtrl eine praxisnahe und kosteneffiziente Lösung. „Unser Ziel ist es, Automatisierung so einfach und zugänglich wie möglich zu gestalten“, stellt Alexander Mühlens heraus. „Mit RobotCtrl ermöglichen wir Unternehmen jeder Größe, einen kostengünstigen und flexiblen Einstieg in die Automatisierung.“

Weitere Informationen zu RobotCtrl und mehr als 650 erfolgreich durchgeführte Anwendungsbeispiele finden sich auf der Plattform RBTX: rbtx.com

Fast Food automatisiert zubereitet: ABB und BurgerBots präsentieren Burger-Roboter

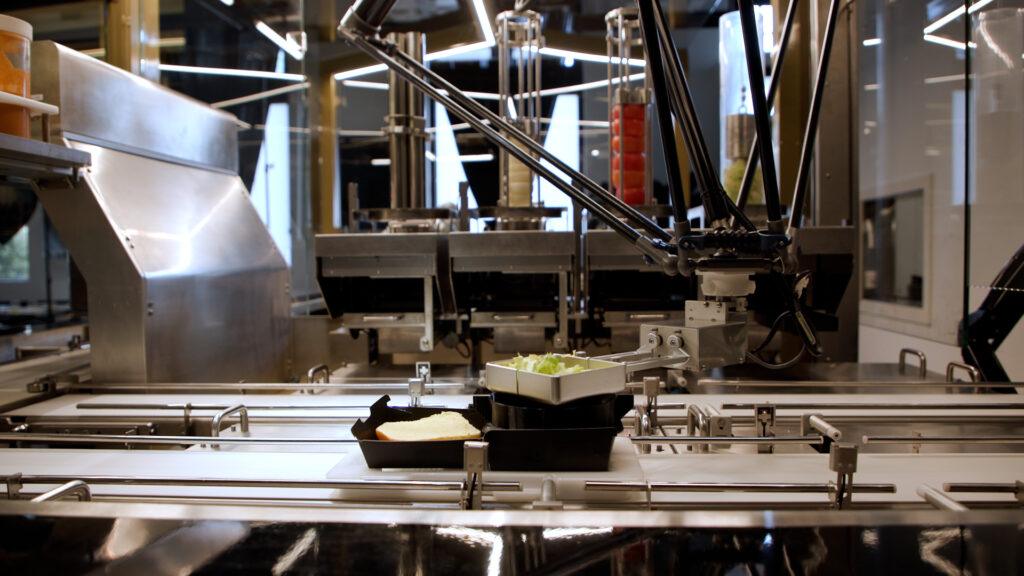

Mit BurgerBots, einem richtungsweisenden Restaurantkonzept, das im kalifornischen Los Gatos realisiert wurde, serviert ABB die Zukunft des Fast Food. In der automatisierten Küche, die stets perfekt zubereitete Burger produziert, stellen der ABB-Deltaroboter IRB 360 FlexPicker sowie der kollaborative ABB-Roboter YuMi die Speisen mit hoher Präzision und Geschwindigkeit zusammen. Gleichzeitig wird der Bestand an Zutaten genau überwacht, sodass sich das Personal ganz auf das Kundenerlebnis konzentrieren kann.

„Die Integration von ABB-Robotern in das Restaurantkonzept von BurgerBots zeigt, welches enorme Potenzial die Automatisierung über das Fabrikumfeld hinaus bietet“, betont Marc Segura, Leiter der Robotics-Division von ABB. „Die Gastronomiebranche ist äußerst dynamisch und anspruchsvoll, und unsere Technologie ermöglicht ihr eine Konsistenz, Effizienz und Zuverlässigkeit auf industriellem Niveau. Laut unserer Umfrage sind 89 Prozent der Führungskräfte und 73 Prozent der Arbeitskräfte im Gastgewerbe offen für die Integration von Robotik, um Aufgaben innerhalb ihres Betriebs zu automatisieren2. Wenn Roboter wiederkehrende und zeitaufwändige Aufgaben übernehmen, kann sich das Personal auf das konzentrieren, worauf es am meisten ankommt – dem Gast ein unvergessliches gastronomisches Erlebnis zu bieten.“

Die kompakte Roboterzelle ist ein Novum in der automatisierten Essenszubereitung, da sie zwei Robotertypen nahtlos mit einem intelligenten Bestandsüberwachungssystem verknüpft. Bei jedem Bestelleingang wird ein frisch gebratenes Burger-Patty auf einem Brötchen in eine Burger-Box gelegt. Die Box wird anschließend auf einem Transporttablett platziert, das mit einem QR-Code versehenen ist. Während sich das Tablett auf einem Förderband bewegt, gibt der IRB 360 FlexPicker in Windeseile und auf hygienische Weise die gewünschten Beläge hinzu – gemäß der im QR-Code gespeicherten Daten. Anschließend übernimmt YuMi die Fertigstellung des Burgers. Pro Burger dauert der gesamte Vorgang lediglich 27 Sekunden.

Die ABB-Robotersteuerung lässt sich zudem nahtlos in nicht-robotische Systeme einbinden. Sie ermöglicht eine Bestandsüberwachung der Zutaten, darunter Zwiebeln, Tomaten, Salat und Saucen, in Echtzeit und sorgt so für einen reibungslosen Ablauf und ein effizientes Küchenmanagement.

Eine der größten Herausforderungen für Restaurantbesitzer besteht heutzutage darin, Personal zu finden und an sich zu binden3. Eine hohe Fluktuation, steigende Lohnkosten und die Monotonie bestimmter Aufgaben im sogenannten „Back-of-House“-Bereich setzen Gastronomiebetriebe nach wie vor unter Druck. Die Automatisierung bietet nicht nur eine Möglichkeit, Personallücken zu schließen, sondern kann durch Reduzierung manueller Tätigkeiten und Verbesserung von Arbeitsabläufen auch dabei helfen, Jobs in der Gastronomie nachhaltiger und attraktiver zu gestalten.

Eine kürzlich von ABB Robotics in Auftrag gegebene Umfrage zeigt, dass ein Umdenken in diese Richtung stattfindet. Demnach sind 67 Prozent der Beschäftigten im Gastgewerbe der Ansicht, dass Robotik und Automatisierung zum Einsatz kommen sollten, um den Umfang an monotonen, schmutzigen und gefährlichen Arbeiten zu reduzieren4. Während 63 Prozent den Gedanken, dass Robotik ihren Job vereinfachen könnte, interessant finden, würden 65 Prozent der Befragten Roboter an ihrem Arbeitsplatz begrüßen, wenn dies die Arbeitssicherheit erhöhen würde.

Die Idee zu BurgerBots stammt von der Unternehmerin Elizabeth Truong, die den Standort in Los Gatos als ersten Schritt zu einem breiteren kommerziellen Rollout sieht. „Die Vision war es, Konsistenz, Transparenz und Effizienz in die Gastronomie zu bringen. Für Restaurantbesitzer bedeutet das einen besseren Einblick in die Lebensmittelkosten, genauere Prognosen und letztendlich eine bessere Entscheidungsfindung. Ich glaube, dass in den kommenden fünf Jahren die meisten Restaurants über irgendeine Form der robotergestützten Automatisierung verfügen werden, sei es bei der Zubereitung im Back-of-House-Bereich, der Zusammenstellung oder auch im Front-of-House-Service. Es wird dann weniger eine Neuheit als vielmehr eine Notwendigkeit sein.“

BurgerBots ist die neueste in einer Reihe robotergestützter Innovationen für den Gastronomiebereich. Die Zusammenarbeit von ABB mit dem Unternehmen RoboEatz an der ARK – einer autonomen robotergestützten Küche, die in der Lage ist, Hunderte von Mahlzeiten mit minimalem menschlichem Eingriff zuzubereiten – demonstriert das Potenzial für eine hocheffiziente, hygienische und individualisierbare Essenszubereitung. Darüber hinaus unterstützt ABB das Unternehmen Makr Shakr bei der Realisierung von Barkeeper-Robotern, die schon bald in Lokalitäten rund um den Globus auf gekonnte Weise Getränke mixen werden. Diese Anwendungen sind nur zwei Beispiele dafür, wie die Robotik das Gastgewerbe dank Schnelligkeit und Konsistenz transformiert.

Die erste BurgerBots-Zelle ist mittlerweile in einem Restaurant in der Innenstadt von Los Gatos in Kalifornien in Betrieb. Weitere Informationen stehen unter www.burgerbots.com zur Verfügung.

Roboter automatisiert Pick-and-Place-Prozesse mit KI-gestützter Bildverarbeitung

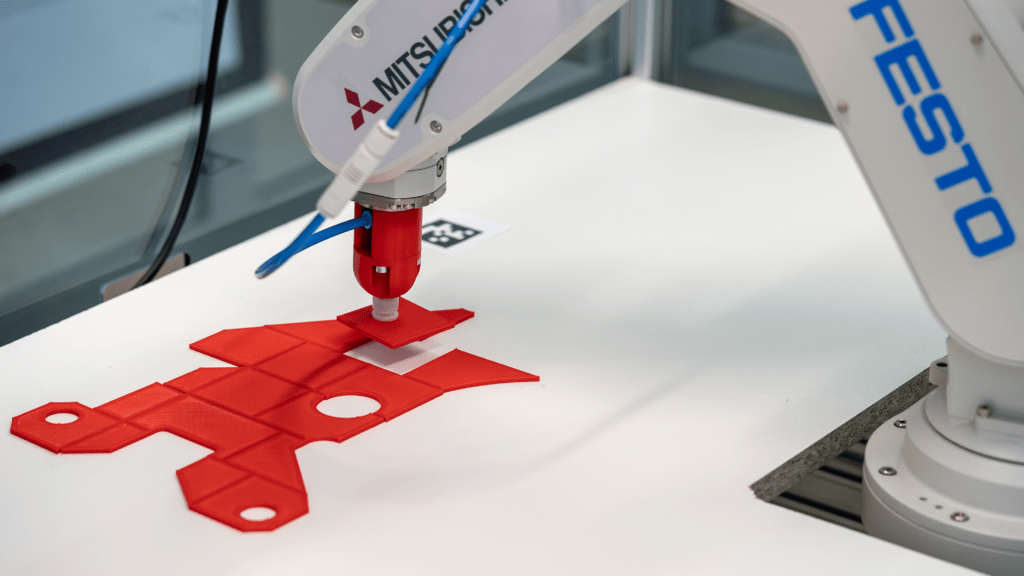

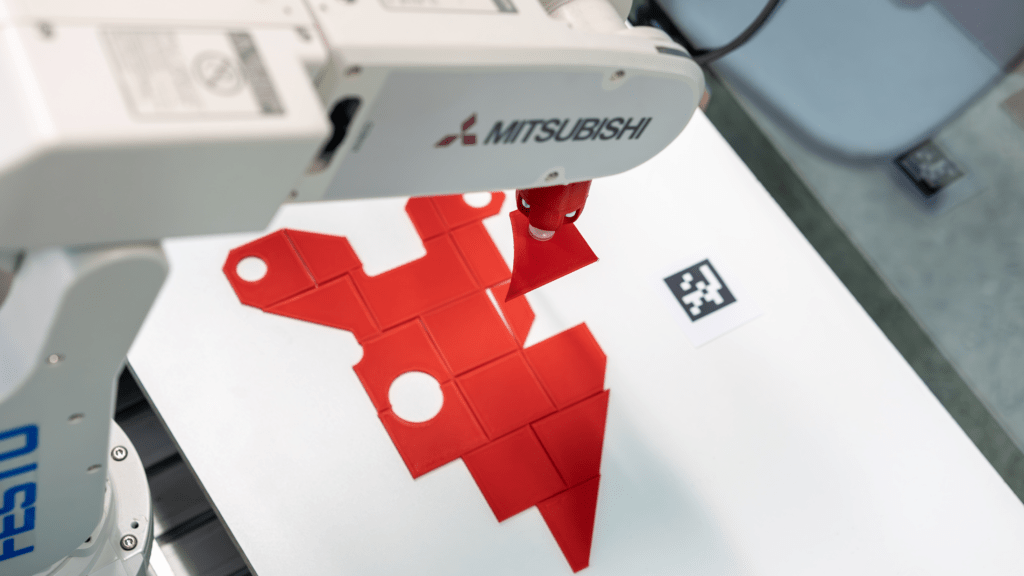

Pick-and-Place-Anwendungen sind ein zentrales Einsatzgebiet der Robotik. Sie werden häufig in der Industrie genutzt, um Montageprozesse zu beschleunigen und manuelle Tätigkeiten zu reduzieren – ein spannendes Thema für Informatik Masteranden des Instituts für datenoptimierte Fertigung der Hochschule Kempten. Sie entwickelten einen Roboter, der Prozesse durch den Einsatz von künstlicher Intelligenz und Computer Vision optimiert. Auf Basis einer Montagezeichnung ist das System in der Lage, einzelne Bauteile zu greifen und an vorgegebener Stelle abzulegen – vergleichbar mit einem Puzzle. Anschließend können die Teile dort manuell durch einen Mitarbeiter verklebt werden.

Zwei IDS Industriekameras liefern die nötigen Bildinformationen

Mithilfe von zwei uEye XC Kameras und einer KI-gestützten Bildverarbeitung analysiert das System die Umgebung und berechnet präzise Aufnahme- sowie Ablagekoordinaten. Eine der Kameras wurde dazu über der Arbeitsfläche platziert, die andere über der Entnahmestelle. Konkret verarbeitet eine KI-Pipeline die Bilder der beiden Kameras in mehreren Schritten, um die exakte Lage und Ausrichtung der Objekte zu bestimmen. Mithilfe der Computer-Vision-Algorithmen und neuronalen Netzen erkennt das System relevante Merkmale, berechnet die optimalen Greifpunkte und generiert präzise Koordinaten für die Aufnahme und Ablage der Objekte. Zudem identifiziert das System die Teile eindeutig, indem es ihre Oberfläche segmentiert und die Konturen mit einer Datenbank abgleicht. Darüber hinaus nutzt es die Ergebnisse, um eine Annäherung an bereits abgelegte Teile zu ermöglichen. Die Automatisierungslösung reduziert damit die Abhängigkeit von Expertenwissen, verkürzt Prozesszeiten und wirkt dem Fachkräftemangel entgegen.

Kameraanforderungen

Schnittstelle, Sensor, Baugröße und Preis waren die Kriterien, die für die Wahl des Kameramodells entscheidend waren. Die uEye XC kombiniert die Benutzerfreundlichkeit einer Webcam mit der Leistungsfähigkeit einer Industriekamera. Sie erfordert lediglich eine Kabelverbindung für den Betrieb. Ausgestattet mit einem 13-MP-onsemi-Sensor (AR1335) liefert die Autofokus-Kamera hochauflösende Bilder und Videos. Eine wechselbare Makro-Aufsatzlinse ermöglicht eine verkürzte Objektdistanz, wodurch die Kamera auch für Nahbereichsanwendungen geeignet ist. Auch ihre Einbindung war denkbar einfach, wie Raphael Seliger, Wissenschaftlicher Mitarbeiter der Hochschule Kempten, erklärt: „Wir binden die Kameras über die IDS peak Schnittstelle an unser Python Backend an.“

Ausblick

Zukünftig soll das System durch Reinforcement Learning weiterentwickelt werden – einer Methode des maschinellen Lernens, die auf Lernen durch Versuch und Irrtum beruht. „Wir möchten gerne die KI-Funktionen ausbauen, um die Pick-and-Place Vorgänge intelligenter zu gestalten. Unter Umständen benötigen wir dafür eine zusätzliche Kamera direkt am Roboterarm“, erläutert Seliger. Geplant ist zudem eine automatische Genauigkeitsprüfung der abgelegten Teile. Langfristig soll der Roboter allein anhand der Montagezeichnung alle erforderlichen Schritte eigenständig ausführen können.

Inklusionsprojekt mit Low-Cost-Roboter gewinnt ROIBOT Award von igus

| Wittekindshofer Werkstätten realisieren behindertengerechten Arbeitsplatz mit Low-Cost-Roboter für 4.970 Euro Köln, 10. April 2025 – Daniel Hillebrand leidet an einer Tetraspastik, die eine kontrollierte Bewegung der Extremitäten unmöglich macht. Trotzdem kann er selbstbestimmt arbeiten – dank eines automatisierten Arbeitsplatzes, den die Diakonische Stiftung Wittekindshofer Werkstätten aus Bad Oeynhausen trotz engen Budgets mit einem Low-Cost-Roboter von igus realisiert hat. Für dieses kreative Inklusionsprojekt erhielt die Stiftung jetzt den ROIBOT Award. Der Wettbewerb zeichnet innovative und wirtschaftliche Automatisierungsprojekte aus, die mithilfe von igus Produkten erfolgreich umgesetzt wurden. Zu den weiteren Preisträgern zählen das niederländische Unternehmen Paperfoam, das französische Forschungsinstitut CNRS und die Universität Politecnico aus Mailand. Daniel Hillebrand sitzt im Rollstuhl und bewegt mit seinem Kinn einen Joystick. Damit steuert er einen Roboterarm, der Kunststoffbauteile sortiert. Mehrere Stunden pro Tag, ohne fremde Hilfe. „Daniel ist es gewohnt, in seinem Leben fast vollständig auf Hilfe angewiesen zu sein“, sagt Torsten Jeschke, Elektriker und Erzieher in den Wittekindshofer Werkstätten. „Dank der neuen Anlage kann er nun trotz seiner schweren Lähmung selbstbestimmt arbeiten.“ Das sei für ihn der Himmel auf Erden. „Der Roboter ist cool“, bestätigt Daniel Hillebrand. „Ich musste in die Technik erst reinkommen, aber mittlerweile läuft alles richtig gut. Am schönsten ist es, wenn der Sack nach langer Arbeit voll ist.“ „Ein Automationsprojekt, das für uns bei igus besonders ergreifend ist.“ Marktübliche Industrieroboter wären für die Wittekindshofer Werkstätten unerschwinglich und in der Steuerung zu komplex gewesen. Jeschke hat deshalb eine günstigere Lösung zusammengestellt, die sich ähnlich leicht bedienen lässt wie ein Computerspiel – mithilfe der Low-Cost-Robotik-Plattform RBTX von igus. Herzstück und Daniel Hillebrands Armersatz ist dabei der ReBeL, ein Gelenkarmroboter aus Hochleistungskunststoff für nur 4.970 Euro. igus hatte den ROIBOT-Wettbewerb zum mittlerweile dritten Mal ausgeschrieben, um Unternehmen und Organisationen auszuzeichnen, die mithilfe des RBTX-Marktplatzes besonders smarte und wirtschaftliche Automationsprojekte realisieren. Die Gewinner erhalten Gutscheine für Robotik-Hardware im Wert von bis zu 5.000 Euro. „Für uns ist es wirklich ergreifend zu sehen, wie es die Wittekindshofer Werkstätten geschafft haben, mit begrenzten finanziellen Ressourcen und dafür umso mehr Fantasie ein Automationsprojekt auf die Beine zu stellen, welches das Leben eines Menschen so sehr verbessert. Wir hoffen, dass sie den 5.000 Euro-Gutschein nutzen können, um in Zukunft noch weitere Projekte dieser Art umzusetzen“, sagt Alexander Mühlens, Leiter des Geschäftsbereichs Low-Cost-Automation bei igus und Schirmherr der ROIBOT Awards. igus selbst hat die Good Work Charter des Verband Deutscher Maschinen- und Anlagenbauer unterschrieben und sich damit dem positiven Beitrag von Robotik zur Gesellschaft verpflichtet. Die Charta betont, dass Robotik und Automatisierungstechnologien nicht nur die Produktivität steigern, sondern auch das Leben der Menschen verbessern können, indem sie Arbeitsbedingungen optimieren und neue Möglichkeiten schaffen. Die weiteren Preisträger: Roboterkomponenten für die Qualitätssicherung, Astroteilchenphysik und automatisierte Obsternte Platz zwei und 2.500 Euro für Robotik-Hardware gehen an Paperfoam. Die niederländische Firma hat den Gelenkarmroboter ReBeL von igus mit einer Kamera ausgestattet, um ihre biobasierten und recycelbaren Verpackungen stichprobenweise auf Produktionsfehler zu prüfen. Die Lösung reduziert die körperliche Belastung der Mitarbeiter und erhöht gleichzeitig die Qualität der Produktion. Über Platz drei und 1.000 Euro freut sich das französische Forschungsinstitut Centre national de la recherche scientifique (CNRS) für die Entwicklung einer Kalibriervorrichtung eines Teleskops für die Astroteilchenphysik. Durch den Einsatz von schmierfreien Linearachsen von igus erreichen die Konstrukteure eine hohe Präzision und Wartungsfreundlichkeit. Der Sonderpreis für Bildungseinrichtungen und ebenfalls 1.000 Euro gehen an die wissenschaftliche-technische Universität Politecnico in Mailand. Sie hat mit dem ReBeL Roboterarm einen mobilen Manipulator konstruiert, der die Obsternte durch Automatisierung effizienter und weniger arbeitsintensiv gestaltet. „Die Gewinner beweisen, dass Automation heute nicht mehr nur eine Frage des Geldes ist“, so Mühlens abschließend. „Auch mit kleinen Budgets und Kreativität lassen sich wirtschaftliche Automationslösungen mit einem schnellen Return on Invest realisieren. Wir freuen uns schon darauf weitere spannende und kostengünstige Automatisierungsprojekte beim nächsten ROIBOT Award kennenzulernen.“ Erfahren Sie mehr über den ROIBOT Award und die Gewinner auf: https://www.igus.de/automation/service/gewinner-roibot |