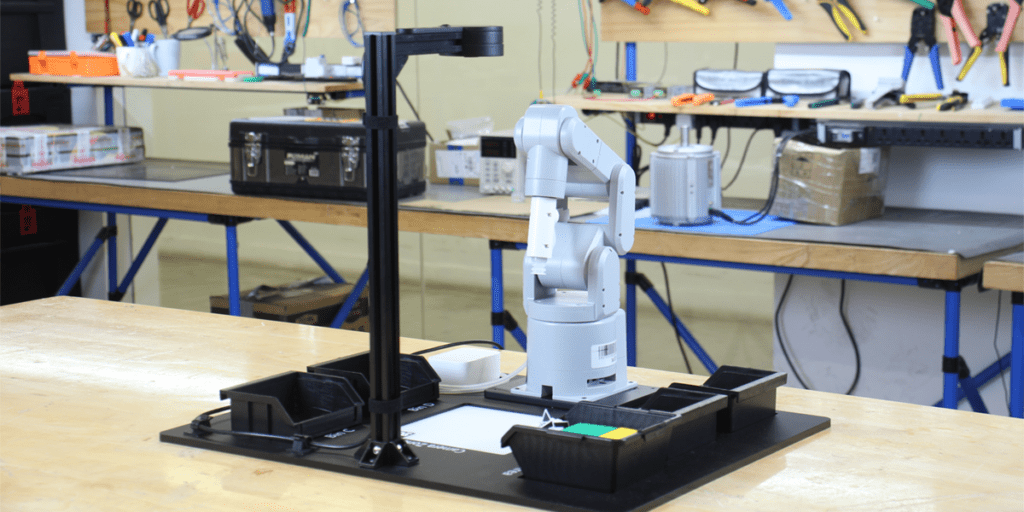

Konstanz, 28.02.2023 – Bis zu 8 Kilogramm Traglast, eine Reichweite von 1018 Millimetern, kurze Taktzeiten: fruitcore robotics bringt mit HORST1000 einen neuen Roboter auf den Markt, der mit seinen Leistungsparametern eine Vielzahl an weiteren Anwendungen ermöglicht und dem wachsenden Markt für Industrieprozesse wie Maschinenbestückung und Pick & PlaceAnwendungen noch besser entspricht.

HORST1000 ist eine vollständig neu entwickelte Roboterkinematik, in die sämtliche Erkenntnisse der letzten Jahre aus der industriellen Praxis eingeflossen sind. An bestehende Technologieinnovationen anknüpfend, konnte das patentierte Robotergetriebe von fruitcore robotics für HORST1000 mit Hilfe eines Machine-Learning-Algorithmus weiter optimiert werden, was zu einer deutlichen Leistungssteigerung führt. Beim Design setzt fruitcore robotics wie bei den bereits in der Vergangenheit mehrfach mit Preisen wie dem Fokus Open Award und dem German Innovation Award ausgezeichneten Robotern auf einen kompakten Footprint und Ästhetik. Mit der Einführung des neuen Modells wird der Vorgänger HORST900 nicht mehr weitergeführt.

Leistungsverbesserung auf Grundlage bestehender Technologieinnovationen

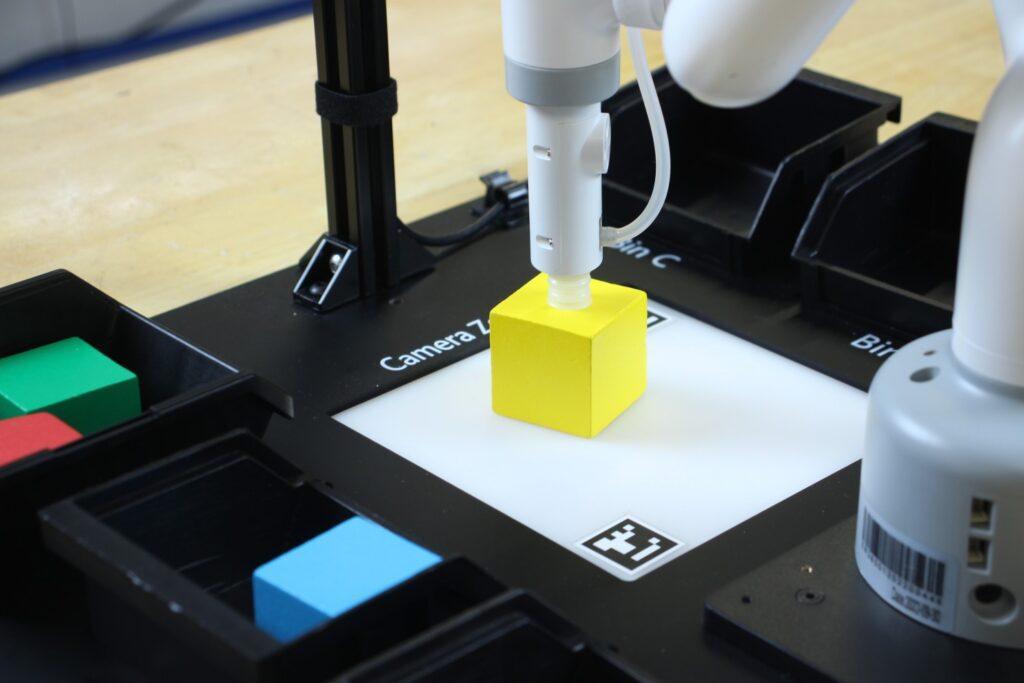

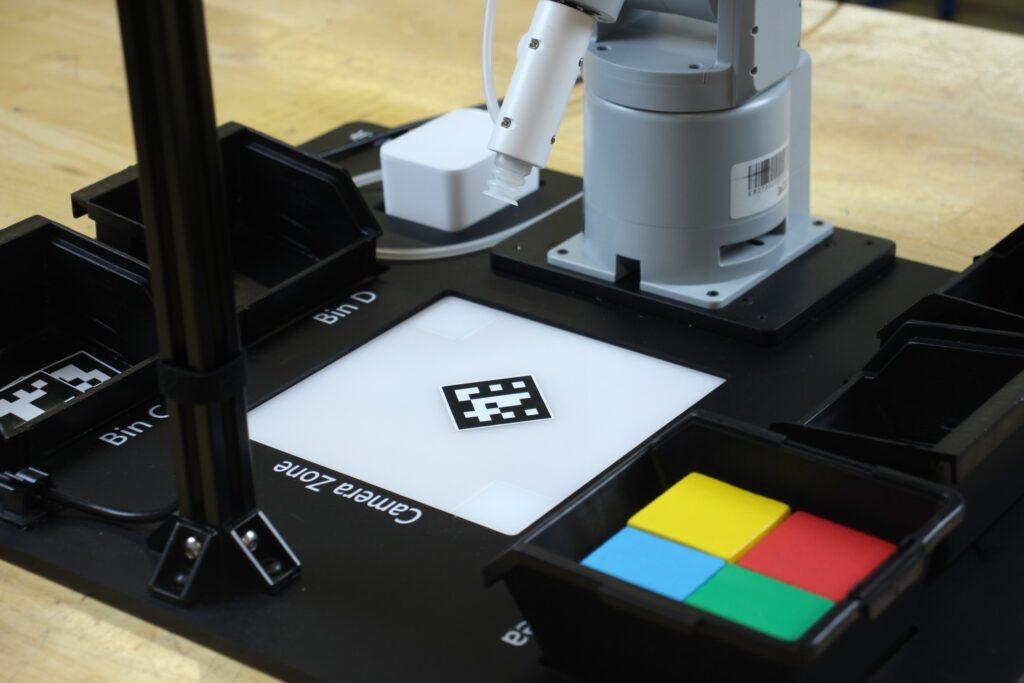

Bei HORST1000 konnten die wesentlichen Leistungsmerkmale wie Traglast, Reichweite und Arbeitsraum deutlich verbessert werden. Der neue Allrounder hat eine Traglast von bis zu 8 Kilogramm und eine Reichweite von 1018 Millimetern. Besonderen Fokus legten die Entwickler:innen auf den Arbeitsraum von HORST1000. Der dreidimensionale Arbeitsraum hat sich im Vergleich zu HORST900 um 40 % vergrößert, sodass 50 % größere Trays bearbeitet werden können. Vom Sockel aus kann HORST1000 rund 230 Millimeter weiter nach vorne fahren als sein Vorgänger, was einer 43 % längeren Linearbahn entspricht. Dadurch können Kund:innen besser in Maschinen einfahren. Höhere Beschleunigungswerte der einzelnen Achsen im Nennlastbereich sorgen außerdem für kürzere Taktzeiten. Bei einem klassischen Pick & Place-Prozess verbessert sich die Taktzeit dadurch um bis zu 20%.

„Die technologischen Innovationen von HORST1000 lassen uns den Leistungsunterschied zu den gängigen Cobots weiter erhöhen“, erklärt Jens Riegger, Geschäftsführer (CEO) und Mitgründer von fruitcore robotics. Patrick Heimburger, Geschäftsführer (Chief Revenue Officer) und Mitgründer von fruitcore robotics, ergänzt: „Wir ermöglichen nun ein noch größeres Spektrum an Anwendungen und helfen unseren Kund:innen dabei, Industrieprozesse wie Maschinenbestückung und Pick & Place noch einfacher und effizienter umzusetzen.“

Optimiert für Maschinenbestückung und Pick & Place

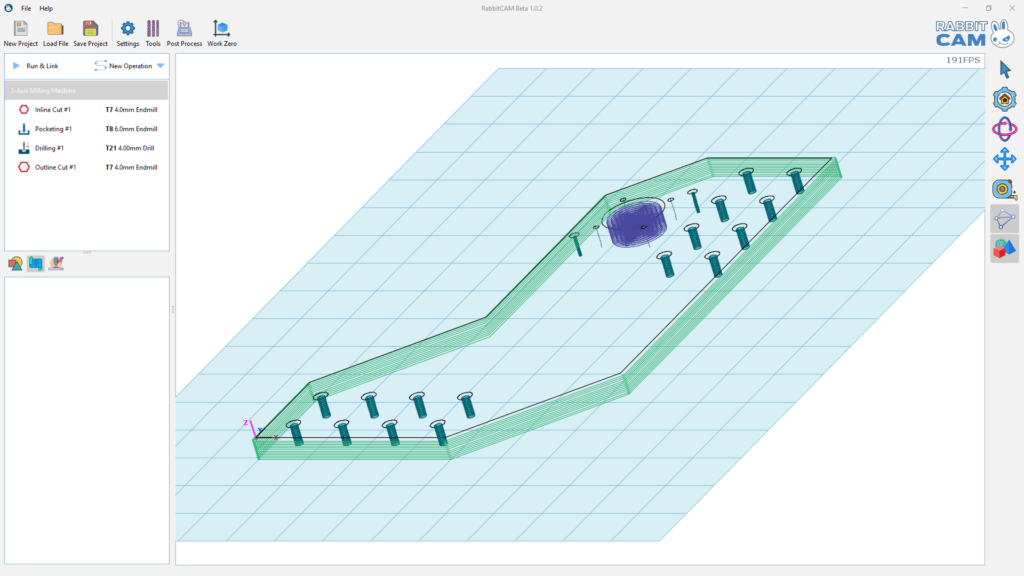

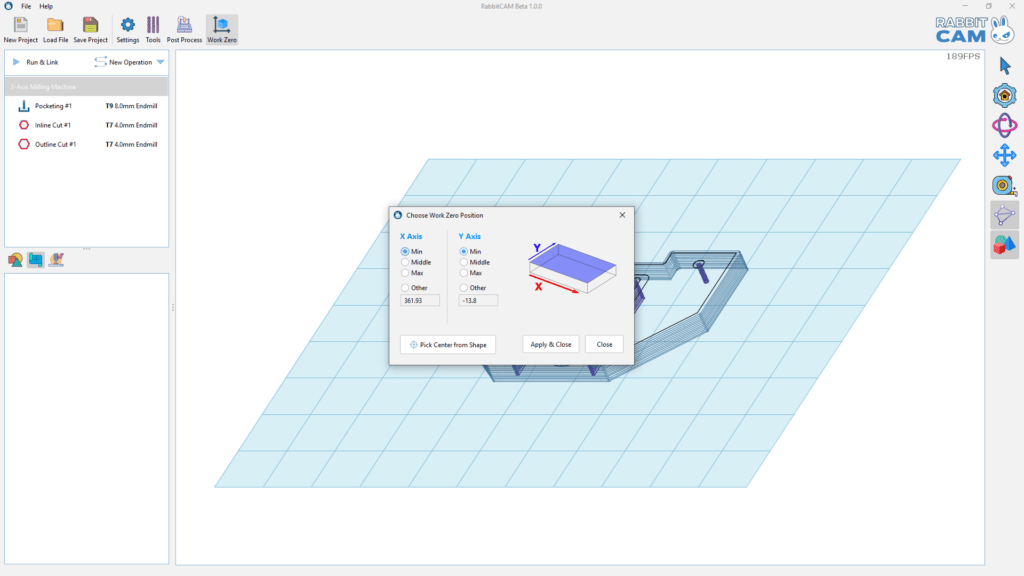

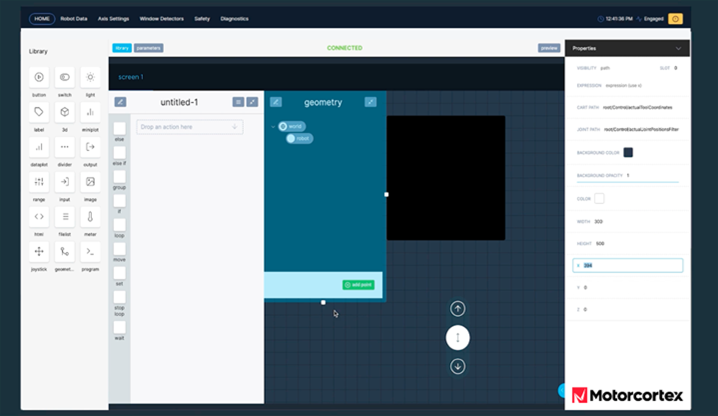

Dank seiner Reichweite und Arbeitsraumgestaltung ist HORST1000 wie geschaffen für die Be- und Entladung jeglicher Werkzeugmaschinen, insbesondere für Dreh- und Fräsmaschinen ist der Roboter auch aufgrund der Software und seiner Schnittstellen optimal geeignet. Der Roboter kann tief in die Maschinen eingreifen, die hohen Achsbeschleunigungen ermöglichen eine kurze Taktzeit. Darüber hinaus erlaubt die maximale Traglast von 8 Kilogramm auch den Einsatz von schweren Tools und komplexen Mehrfachgreifer-Systemen. Als Automatisierungs-Lösung umfasst Digital Robot HORST1000 wie schon sein Vorgänger HORST900 und seine Brüder HORST600 und HORST1400 nicht nur eine leistungsstarke und preisgünstige Hardware. Er folgt einem in sich abgestimmten Bedienkonzept, durch welches nicht nur die Bedienung des Roboters besonders einfach ist, sondern auch die Umsetzung der gesamten Anwendung. Alle am Prozess beteiligten Komponenten, wie Greifer, CNC-Anlagen und Sicherheitssysteme werden über die grafische Bedienoberfläche horstFX bedient und zentral mit der IIoT-Plattform horstCOSMOS vernetzt. So kann zum Beispiel die Werkzeugmaschine als 3D-Modell in horstFX eingebunden werden und Bauteilvarianten ganz einfach über die Programmverwaltung der Bediensoftware gehandelt werden. Der Wechsel zwischen zwei Tools kann softwareseitig über das Multi-Tool-Feature abgebildet werden. Neben der Anbindung an die IIoT-Plattform ist bei allen Robotern von fruitcore robotics ein IIoT-Surfstick mit SIM-Karte standardmäßig im Lieferumfang enthalten. Dieser bietet Unternehmen die Möglichkeit, mit dem Robotersystem online zu gehen, ohne es in ihr Firmennetzwerk einbinden zu müssen. Kund:innen können nach Bedarf eine Internetverbindung aufbauen und via horstCOSMOS auf Dashboards ihre Roboterflotte samt Prozessdaten der Roboteranwendung einsehen. So können Prozesse eigenständig oder in Abstimmung mit fruitcore robotics optimiert werden. Zudem erhöht sich die Verfügbarkeit, weil Wartungen per Predictive Maintenance erfolgen und bei Servicefällen schnell per Fernwartung reagiert werden kann.

Vorbestellungen ab sofort möglich

HORST1000 kann ab sofort beim Hersteller vorbestellt werden. Die Auslieferung erfolgt ab 01.06.2023. Der Preis für den neuen Allrounder kann der Website des Herstellers entnommen werden.

Kenngrößen HORST1000:

| Kenngröße | HORST1000 |

| Max. Traglast | 8 kg |

| Nennlast | 5 kg |

| Max. Reichweite | 1018 mm |

| Aufstellfläche | 380 x 380 mm |

| Gewicht | ca. 70k g |

| Wiederholgenauigkeit | +/- 0,05 mm |

| Schutzart | IP54 |

| Schallpegel | < 70 dB (A) |

| Stromversorgung | 230VAC, 50-60Hz, typ. 350W |

| Umgebungstemperatur | 5-40 °C |

| Standardfarbe | RAL 5021 (Wasserblau) |