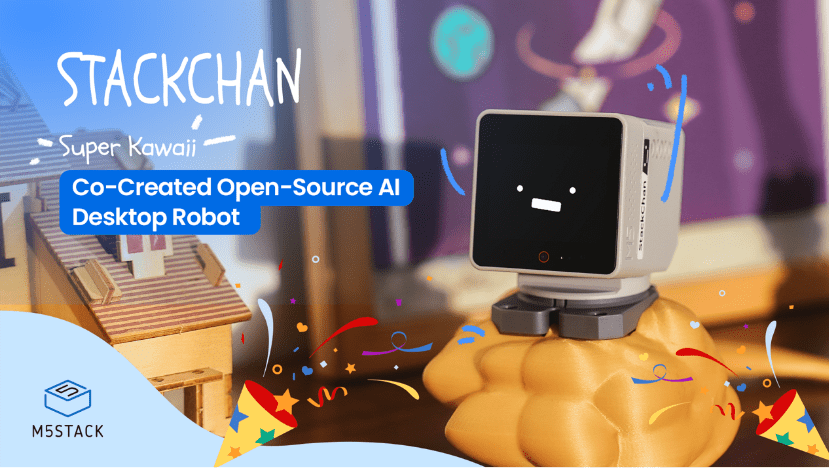

M5Stack Stackchan is now available at @Kickstarter

See my short review Video by @RobotsBlog and get your own Stackchan now!

#robot #ai #stackchan #opensource #desktop #desktoprobot #diy #companion

M5Stack Stackchan is now available at @Kickstarter

See my short review Video by @RobotsBlog and get your own Stackchan now!

#robot #ai #stackchan #opensource #desktop #desktoprobot #diy #companion

January, 2026 — M5Stack, a global leader in modular IoT and embedded development platforms, today launched StackChan, the first community-co-created open-source AI desktop robot, built on a proven ESP32 platform and designed to be endlessly hackable by makers worldwide.

Unlike closed, concept-driven AI robots, StackChan exposes its hardware, firmware, and interaction logic from day one — turning a playful desktop companion into a real development platform.

StackChan is now live on Kickstarter with a $65 Super Early Bird offer available for the first 72 hours.

From Community to the Globe: How StackChan Was Born

Before its official launch by M5Stack, StackChan had already existed as a community-driven project since 2021. Built on M5Stack standard controller, Core series, it began as a personal open-source project by maker Shinya Ishikawa, sustained and shaped through ongoing community contributions.

As more enthusiasts joined the project, contributors like Takao, who helped popularize the DIY kits, and Robo8080, who introduced AI capabilities, played key roles in expanding StackChan beyond its original form.

Inspired by StackChan’s expandability and creative potential, M5Stack officially brought the project to life as its first ready-to-play yet endlessly hackable desktop robot—while keeping its community-driven spirit at the core.

What Remains: Core Computing & Interaction Capabilities

As with the original version, StackChan continues to use the M5Stack flagship Core Series (CoreS3) as its main controller. CoreS3 is powered by an ESP32-S3 SoC with a 240 MHz dual-core processor, 16 MB Flash, and 8 MB PSRAM, and supports both Wi-Fi and BLE connectivity.

To enable richer interactions, the main unit integrates a 2.0-inch capacitive touch display, a 0.3 MP camera, a proximity sensor, a 9-axis IMU (accelerometer + gyroscope + magnetometer). It also includes a microSD card slot, a 1W speaker, dual microphones, and power/reset buttons. Together, these hardware components form a solid foundation for StackChan’s audio-visual interactive experiences.

For more technical details, please refer to the StackChan documentation: https://docs.m5stack.com/en/StackChan

What’s New: Ready-to-Play Functions Powered by Advanced Hardware

For the robot body, several advancements have been made to make it easier to get hands-on and improve the out-of-box experience. It features:

Power & connectivity: A USB-C interface for both power and data, paired with a built-in 700 mAh battery.

Movement system: 2 feedback servos supporting 360° continuous rotation on the horizontal axis and 90° vertical tilt—enabling expressive movements with real-time position feedback.

Visual feedback: 2 rows totaling 12 RGB LEDs for expressive system and interaction feedback.

Sensors & interaction: Infrared transmission and reception, a three-zone touch panel, and a full-featured NFC module enabling touch- and identity-based interactions.

On the software side, StackChan is ready-to-play for starters with no coding required. The pre-installed factory firmware delivers:

Expressive faces and motions: Preloaded with vivid facial expressions and coordinated movements that bring personality and liveliness to StackChan.

Built-in AI agent: Integrates an AI agent for natural voice-based interaction and conversational experiences.

App-based remote interaction: Supports official iOS app for video calls, remote avatar control, and real-time interaction with StackChan.

Chan-to-Chan Friends Map: Enables discovery of nearby StackChan devices, unlocking playful multi-device and social interaction scenarios.

Open for customization: While beginner-friendly by default, the firmware supports further development via Arduino and UiFlow2, making it easy to create custom applications.

100% Open-Source: Built to Be Customized and Extended

In an era filled with closed, concept-driven “AI robot” products, StackChan stands out with its open-source core. From firmware and hardware interfaces to development tools, every layer is designed to be explored, modified, and extended by users.

Beyond code, StackChan also encourages physical customization. With 3D printing and creative accessories, users can personalize their StackChan’s appearance and turn it into a unique desktop companion.

Open-source repository: https://github.com/m5stack/StackChan

Fun with Global Community: Share, Extend, and Evolve Together

Since its birth, StackChan has grown into a vibrant global community of makers, developers, and enthusiasts. From sharing projects and source code online to hosting meetups and anniversary events offline, the community continues to expand what StackChan can be.

Owning a StackChan is not just about building a robot—it’s about being part of an open ecosystem where ideas and creativity evolve together.

StackChan is not built to its end at launch. It is built to grow—through open technology, creative experimentation, and a global community that continues to redefine what a desktop robot can be.

Discover your StackChan on Kickstarter now: https://www.kickstarter.com/projects/m5stack/stackchan-the-first-co-created-open-source-ai-desktop-robot?ref=d5iznw&utm_source=PR

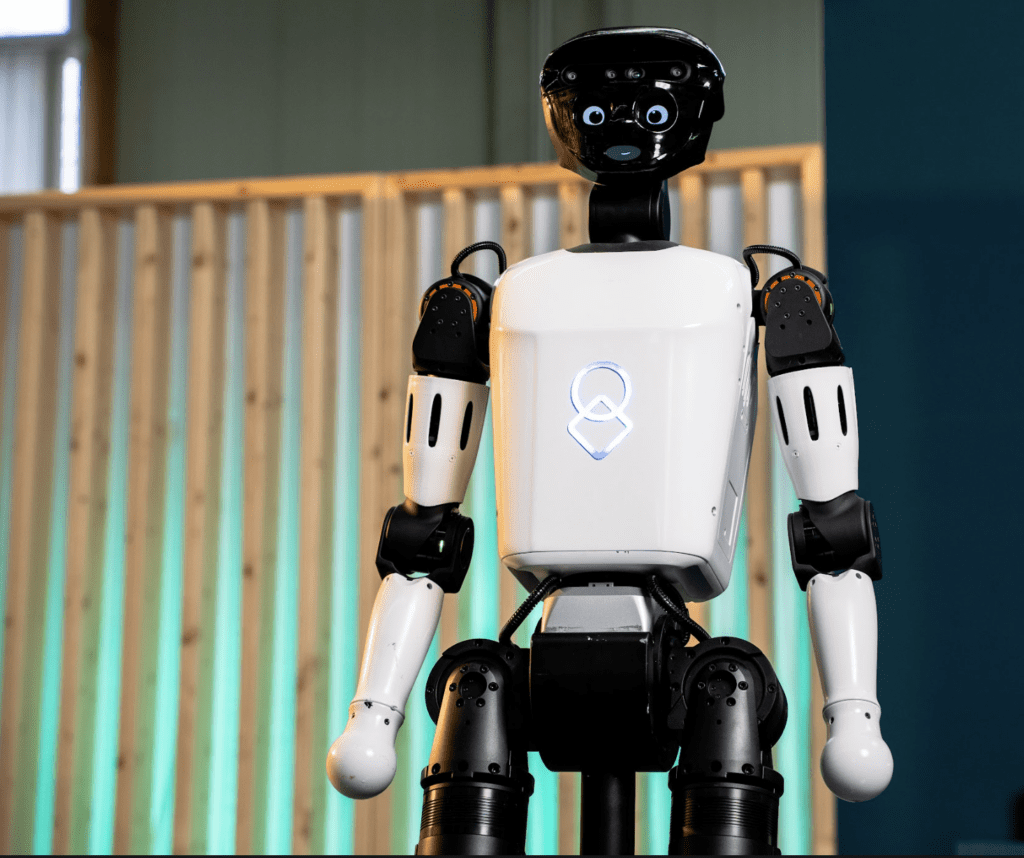

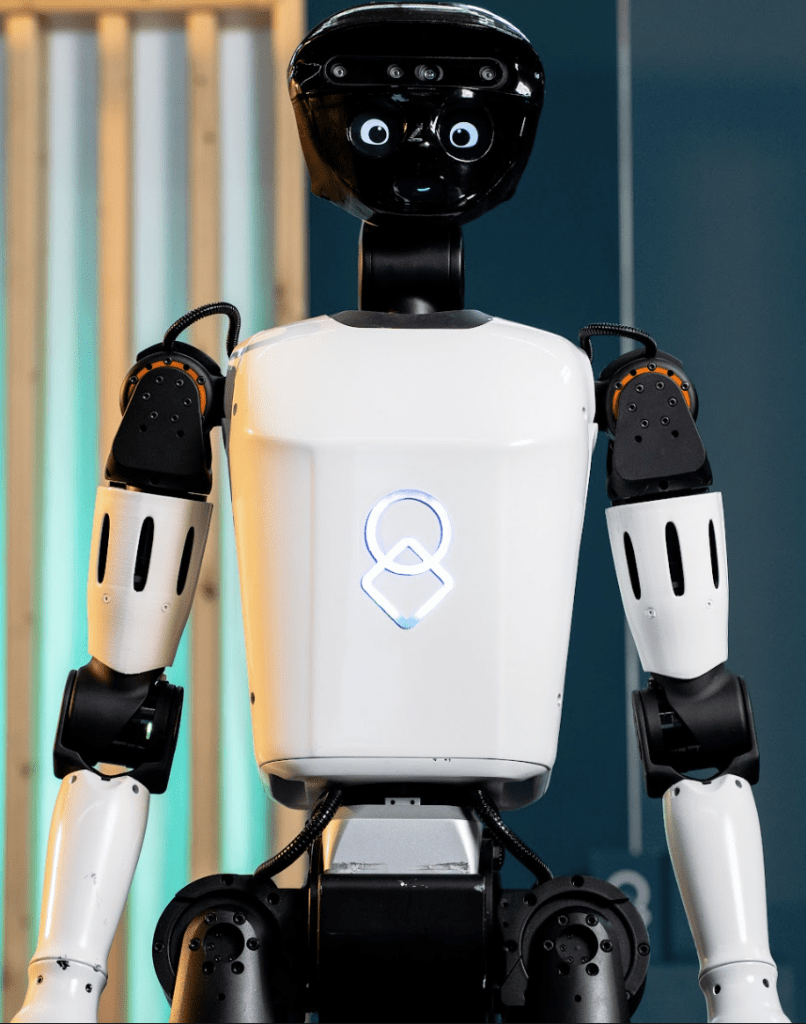

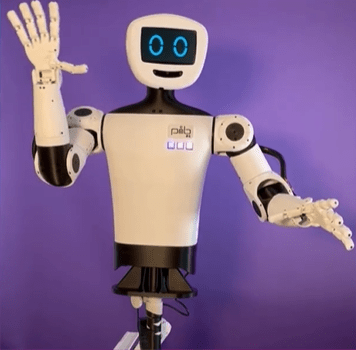

Stuhr, 06.01.2026 – Die United Robotics Group (URG) präsentiert auf der CES 2026 erstmals ihren humanoiden Roboter uMe. Der technologische Prototyp ergänzt das bestehende Portfolio aus mobilen Service- und Gesundheitsrobotern und zeigt, wie humanoide Robotik sinnvoll in reale Arbeitsumgebungen integriert werden kann. uMe demonstriert auf der Messe erste Kernfunktionen wie sprachbasierte Interaktion, vorprogrammierte Bewegungsabläufe und sensorbasierte Wahrnehmung. Dazu gehören unter anderem hochauflösende Kameras, Tiefensensorik, ein Mikrofonarray sowie ein interaktives Display, über das Inhalte und Dialoge dargestellt werden können. uMe ist softwareseitig vollständig in die URG Plattform uGo+ integriert und wurde von Beginn an so konzipiert, dass er sich nahtlos in bestehende Datenflüsse, Geräteanbindungen und Workflows einfügt.

Humanoide Robotik für Bildung, Pflege und Forschung

Als humanoide Erweiterung des Portfolios adressiert uMe vor allem Umgebungen, in denen soziale Interaktion und Zugänglichkeit im Mittelpunkt stehen. Dazu gehören Bildungseinrichtungen, in denen uMe Lerninhalte unterstützt und technische Zusammenhänge erlebbar macht, sowie Pflegeumgebungen, in denen der Roboter Routinen begleitet und durch Gespräche, Aktivierung und Orientierung entlastende Unterstützung bietet. Auch Forschungsteams eröffnet uMe neue Möglichkeiten für die Entwicklung und Erprobung von Robotikfunktionen.

Wassim Saeidi, Gründer und CEO der United Robotics Group, erklärt: „uMe ist ein wichtiger Schritt in der Entwicklung unserer Plattform. Er macht deutlich, wie humanoide Robotik künftig einen Beitrag zu gesellschaftlichen Herausforderungen leisten kann. Entscheidend ist für uns nicht das Spektakuläre, sondern der praktische Nutzen. Wir zeigen, wie sich ein humanoides System in bestehende Prozesse integrieren lässt und echten Mehrwert für Pflegekräfte, Lehrende und Forschende schaffen kann.“

uGo+ als zentrale Software-Plattform zwischen Hardware und Anwendung

uMe ist vollständig in die Software-Plattform uGo+ integriert, die mobile und humanoide Robotersysteme über eine gemeinsame Architektur miteinander verbindet. uGo+ ist dabei bewusst als anwenderzentrierte Plattform konzipiert, die sich kontinuierlich weiterentwickelt und künftig einen klaren No-Code-Charakter erhalten soll. Ziel ist es, Nutzer:innen zu befähigen, Robotik-Workflows selbstständig, sicher und ohne Programmierkenntnisse zu konfigurieren und anzupassen. Die Weiterentwicklung von uGo+ ist – neben dem humanoiden Prototyp uMe – einer der zentralen Entwicklungsschwerpunkte der United Robotics Group, da hier die Brücke zwischen Hardware, konkreten Anwendungen und Alltagstauglichkeit entsteht. uMe ist zudem als offene, erweiterbare Plattform ausgelegt und bietet Partner:innen aus Industrie, Forschung und Bildung die Möglichkeit, eigene Module zu entwickeln, Funktionen zu testen und neue Szenarien zu pilotieren. So entsteht ein durchgängiges Zusammenspiel aus Software-Plattform und spezialisierten Robotersystemen, zu denen uLab Mobile, uServe, uLog und uClean bereits mehrere spezialisierte Serviceroboter für Labor-, Klinik- und Logistikumgebungen gehören. Gemeinsam bilden sie ein durchgängiges System, in dem mobile und humanoide Robotik über eine gemeinsame Infrastruktur zusammenwirken können.

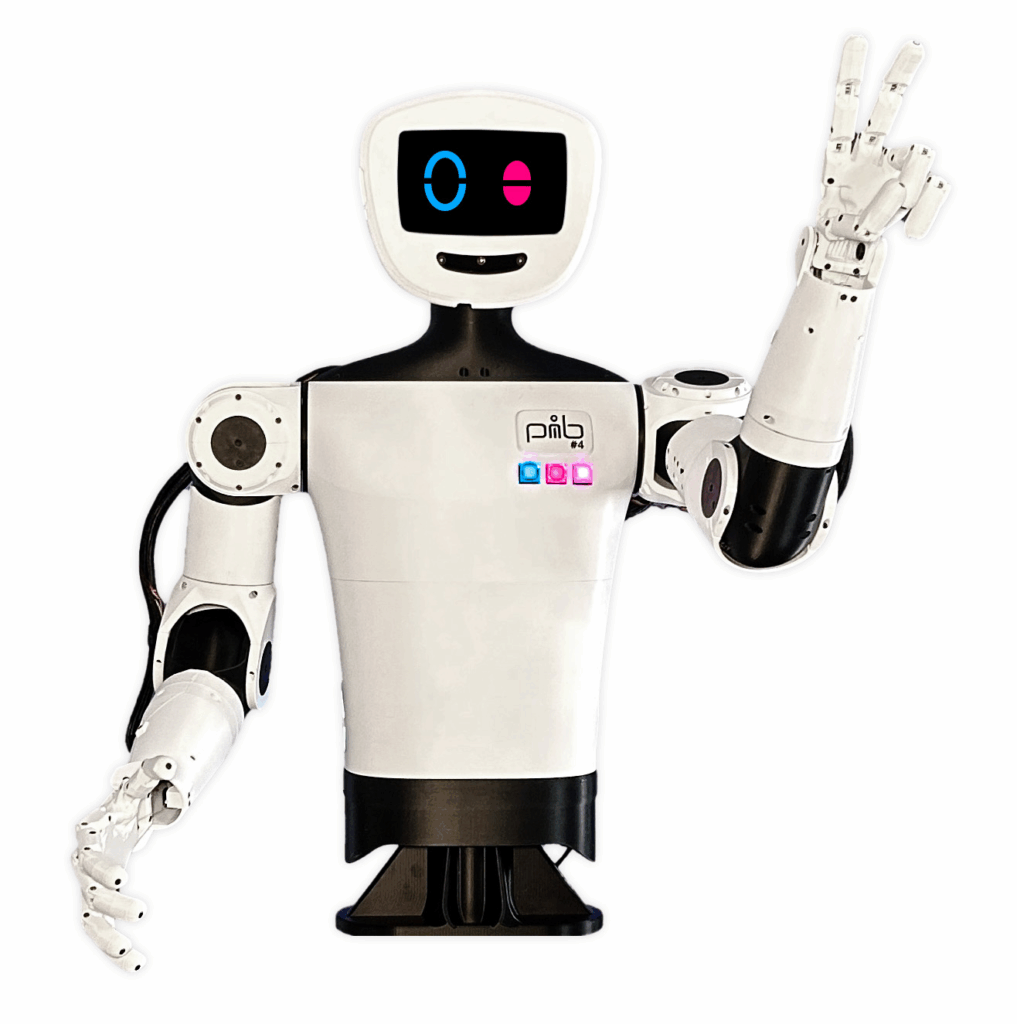

Nürnberg, 11.11.2025 +++ Die vierte Version von pib (printable intelligent bot) ist ab sofort verfügbar. Der humanoide Open Source Roboter aus dem 3D-Drucker lässt sich von jedem selbst bauen, programmieren und mit KI erweitern. Alle 3D-Druckdaten und Anleitungen stehen auf der Projekt-Website zur freien Verfügung, Unterstützung und Austausch gibt es durch die mehr als 1.800 Community-Mitglieder. Das Projekt hat bereits mehrere renommierte Auszeichnungen gewonnen, darunter den German Design Award 2025 und den German Innovation Award 2025.

Der humanoide Roboter pib wurde von der Nürnberger isento GmbH entwickelt und richtet sich an Technik-Enthusiasten, Bildungseinrichtungen sowie Maker-Communities. Mit einem handelsüblichen 3D-Drucker lassen sich sämtliche mechanischen Komponenten herstellen. Alle STL-Dateien, Materiallisten und detaillierten Bauanleitungen stehen frei zur Verfügung.

pib kombiniert eine modulare humanoide Struktur mit Servomotoren, Sensorik und offenen Software-Komponenten. Er kann gedruckt, zusammengebaut, programmiert und individuell erweitert werden. Als Open-Source-Projekt bietet pib einen einfachen Einstieg in Robotik und KI – frei von hohen Kosten und geschlossenen Systemen. Die internationale Community treibt die kontinuierliche Weiterentwicklung voran, sodass pib ideal für Maker, Forschung und Bildung ist. Das Ziel: Robotik und KI für alle zugänglich zu machen und die Einstiegshürden nachhaltig zu senken.

Die neue Version ist deutlich einfacher und flexibler aufgebaut. Die Kalibrierung der Motoren wurde erleichtert, der Zugang zur Elektronik und zum Power-Button komfortabler gestaltet. Viele dieser Verbesserungen gehen direkt auf das wertvolle Feedback der aktiven Community zurück.

pib ist nun mit einem Mikrofon-Array ausgestattet, das nicht nur die Audioqualität verbessert, sondern auch die Richtung von Geräuschen erkennt. Neue Lautsprecher sorgen für natürlichere Interaktion und setzen mit blauer Beleuchtung ein Design-Highlight. Drei programmierbare RGB-Buttons am Oberkörper ermöglichen individuelle Steuerbefehle.

„Mit pib verfolgen wir die Vision, Robotik für alle zugänglich zu machen. Das neue Release zeigt, wie Open Source Innovation vorantreibt: ein humanoider Roboter, den man selbst bauen, erweitern und verstehen kann. Besonders stolz sind wir darauf, dass viele Verbesserungen direkt aus dem wertvollen Feedback unserer Community entstanden sind“, sagt Dr. Jürgen Baier, Co-Founder und CEO von pib.rocks.

pib richtet sich an Maker, Robotik-Interessierte und KI-Tüftler gleichermaßen. Darüber hinaus wird der Roboter bereits in mehr als 70 Schulen und Bildungseinrichtungen eingesetzt: als fächerübergreifende Lernplattform für Zukunftsthemen wie Robotik, 3D-Druck und künstliche Intelligenz.

Weitere Infos, Baupläne und Anleitungen: www.pib.rocks

3D-printed robot becomes simpler, smarter, and even more flexible

Nuremberg, November 11, 2025 +++ The fourth version of pib (printable intelligent bot) is now available. The humanoid open-source robot can be 3D-printed, built, programmed, and enhanced with AI by anyone. All 3D printing files and assembly instructions are freely available on the project website, with support and exchange provided by a community of more than 1,800 members. The project has already received several prestigious awards, including the German Design Award 2025 and the German Innovation Award 2025.

The humanoid robot pib was developed by isento GmbH in Nuremberg and is aimed at tech enthusiasts, educational institutions, and maker communities. Using a standard 3D printer, all mechanical components can be produced. All STL files, material lists, and detailed assembly guides are freely available.

pib combines a modular humanoid structure with servo motors, sensors, and open software components. It can be printed, assembled, programmed, and customized. As an open-source project, pib offers an accessible entry point into robotics and AI—free from high costs and proprietary systems. The international community continuously drives its development forward, making pib ideal for makers, research, and education. The goal: to make robotics and AI accessible to everyone and to lower entry barriers sustainably.

The new version features a significantly simpler and more flexible design. Motor calibration has been made easier, and access to the electronics and power button is now more convenient. Many of these improvements are direct results of valuable feedback from the active community.

pib now includes a microphone array that not only improves audio quality but also detects the direction of sound. New speakers provide a more natural interaction experience and feature blue accent lighting as a design highlight. Three programmable RGB buttons on the torso allow for customizable control commands.

“With pib, we pursue the vision of making robotics accessible to everyone. The new release demonstrates how open source drives innovation: a humanoid robot that anyone can build, extend, and understand. We’re especially proud that many improvements came directly from our community’s valuable feedback,” says Dr. Jürgen Baier, Co-Founder and CEO of pib.rocks.

pib appeals equally to makers, robotics enthusiasts, and AI tinkerers. Beyond that, the robot is already being used in more than 70 schools and educational institutions—as a cross-disciplinary learning platform for future-focused topics such as robotics, 3D printing, and artificial intelligence.

More information, building plans, and guides: www.pib.rocks

MONTREAL, 29. Oktober 2025 /PRNewswire/ — Vention, Entwickler der weltweit einzigen KI-gestützten Full-Stack-Software- und Hardware-Automatisierungsplattform, kündigte heute die nächste Entwicklungsstufe der intelligenten Fertigung an, die Vention seiner Vision der Zero-Shot Automation™ näherbringt. Auf dem 6. jährlichen Demo Day stellte Vention neue Funktionen vor, mit denen Unternehmen automatisieren können, ohne auf herkömmliche Hardware-Integration oder komplexe Programmierung angewiesen zu sein. Die Neuerungen umfassen Werkzeuge, die die Plattform für eine globale Community von Entwicklern und Robotik-Experten weiter öffnen, sowie erweiterte Simulations- und KI-Funktionen, die Unternehmen helfen, die Phasen vom Design bis zur Inbetriebnahme schneller zu durchlaufen.

Seit dem ersten Demo Day im Jahr 2020 hat Vention seine Plattform in eine softwaredefinierte Automatisierungsumgebung verwandelt, die Hardware, Software und KI in einem einheitlichen Kundenerlebnis vereint. Heute wird die Vention-Plattform von mehr als 25.000 Maschinen in 4.000 Fabriken weltweit genutzt – für individuelle Projekte und schlüsselfertige Automatisierungslösungen wie Palettieren, Schweißen und Maschinenbestückung. Das Ergebnis sind nachweisbare Leistung, schnellere Amortisierung und ein deutlich verkürzter Weg von der Idee zur Produktion.

„Unsere Mission war es von Anfang an, Automatisierung für alle zugänglich zu machen“, sagte Etienne Lacroix, Gründer und CEO von Vention, auf dem Demo Day 2025. „Mit Zero-Shot Automation bauen wir den Technologie-Stack der Zukunft für die Industrieautomation . Hardware und Software sind vollständig vereint und KI ist nahtlos von der Cloud bis zum Edge integriert. Das ist ein wichtiger Schritt hin zu einfacher, intelligenter und leistungsstarker Automatisierung.“

Vention führt AI Operator ein und stellt Schlüsselfunktionen der Plattform vor

Ein Highlight des diesjährigen Demo Day war die weltweite Einführung des AI Operator , der neuesten Automatisierungslösung von Vention, die fortschrittliche KI-Modelle direkt auf die Fertigungsebene bringt – für unstrukturierte Anwendungen wie Bin Picking, d.h. dem Greifen von Gegenständen unterschiedlicher Form und Größe. AI Operator ist nun auf der Vention-Plattform verfügbar; die Implementierungen in Fertigungsumgebungen werden bis Anfang 2026 weltweit ausgerollt.

Angetrieben vom MachineMotion AI Controller, der bereits auf dem Demo Day 2024 vorgestellt wurde, basiert AI Operator auf NVIDIA-Infrastruktur sowie den NVIDIA Isaac -Bibliotheken und KI-Modellen. Damit steht die Rechenleistung zur Verfügung, die für anspruchsvolle industrielle KI-Anwendungen erforderlich ist.

Auf dem Demo Day 2025 stellte Vention außerdem wichtige Weiterentwicklungen vor, die die Plattform für Hersteller, Entwickler und Robotik- Experten noch intuitiver und besser zugänglich machen:

NVIDIA erläutert die Rolle von KI in der agilen Fertigung; Kunden berichten über ihre Erfolge

Amit Goel, Head of Robotics & Edge Computing bei NVIDIA, nahm am Demo Day teil, um über die wachsende Bedeutung von KI in der agilen Fertigung und die technologischen Fortschritte zu sprechen, die den AI Operator von Vention antreiben. Er betonte, dass GPU-beschleunigtes Edge Computing sowie CUDA-beschleunigte Bibliotheken und KI-Modelle die Art und Weise neu definieren, wie Automatisierungssysteme in Echtzeit wahrnehmen, sich anpassen und agieren.

„Mit dem AI Operator von Vention ist es jetzt möglich, Robotik in Anwendungen einzusetzen, die kontinuierliche Aktualisierungen und höhere Flexibilität erfordern“, sagte Goel. „All diese Funktionen stehen nun direkt zur Verfügung.“

Führungskräfte von Cripps & Sons Woodworking, McAlpine & Co. Ltd. und Solestial, Inc. stellten auf dem Demo Day die Erfolge vor, die sie in Zusammenarbeit mit Vention erzielt haben: von verkürzten Designzyklen bis hin zu vollständig implementierten Automatisierungssystemen, die zu messbaren Verbesserungen in der Produktion führen.

Der Demo Day 2025 ist ab 29. Oktober um 16:00 Uhr MEZ unter vention.io/demo-day online aufrufbar

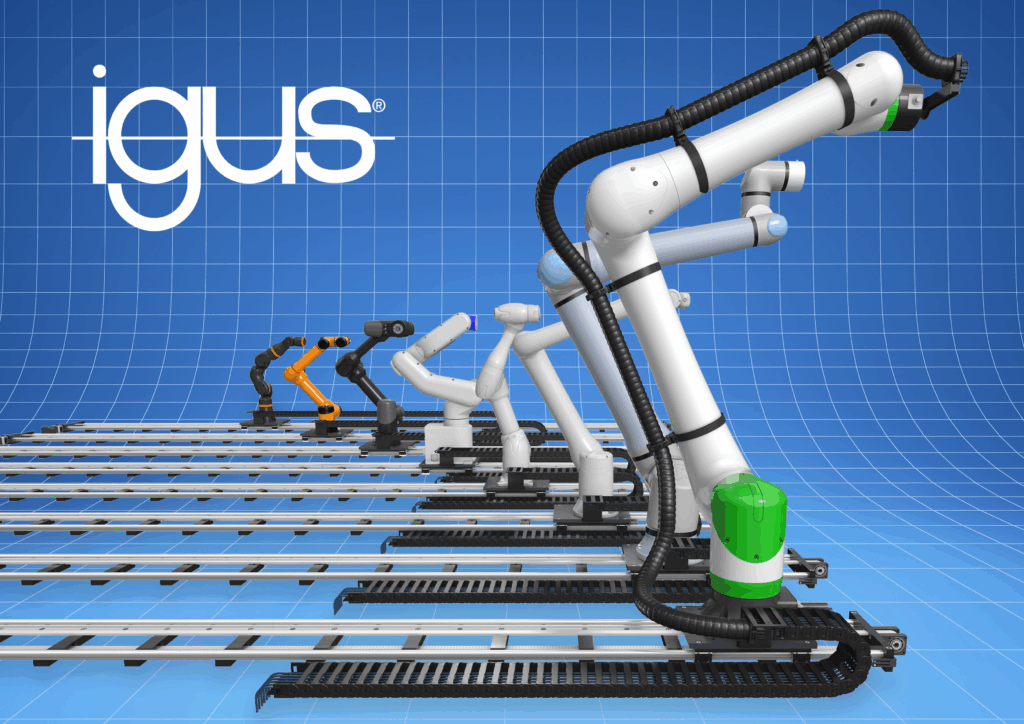

Linearachse mit Plug-to-program Anbindung spart bis zu 10.000 Euro an Entwicklungskosten – Neues Update für UR und Fanuc

Köln, September 2025 – Viele Betriebe, die den Aktionsraum von Leichtbau-Gelenkarmrobotern vergrößern möchten, kennen das Problem: Eine 7. Achse, auf der ein Roboter linear verfahren kann, ist schnell gefunden. Ihre Integration in die Robotersteuerung erfordert jedoch zusätzlichen Programmieraufwand. Die Lösung von igus: eine 7. Achse, die den Aktionsraum vervierfacht und so einfach integrierbar ist wie eine App. Bereits 500 Systeme sind weltweit im Einsatz. Mithilfe eines neuen Updates für UR 20, UR 30 und Fanuc CRX-Serien sollen weitere folgen.

Automatisierung kann kompliziert sein. Besonders dann, wenn sich Produktionsbedingungen ändern. Das zeigt das Beispiel eines Feinmechanik-Betriebs, der zwei identische CNC-Fräsmaschinen betreibt: Wegen des fortschreitenden Arbeitskräftemangels übernimmt ein Gelenkarmroboter bereits seit einiger Zeit das Beladen einer der beiden Maschinen. Um den Aktionsradius des Roboters auch auf die zweite Maschine zu erweitern, soll eine motorisierte Achse für die horizontale Verstellung zum Einsatz kommen. Die Achse ist schnell gefunden, lässt sich jedoch nicht an die Robotersteuerung anschließen. Deshalb ist ein Programmierer 1,5 Wochen damit beschäftigt, eine Schnittstelle zu programmieren. „Wir haben von vielen Betrieben gehört, dass die aufwendige Anbindung einer 7. Achse derzeit ein Pain-Point ist, der Projekte unnötig kompliziert macht“, sagt Alexander Mühlens, Prokurist und Geschäftsbereichsleiter Low-Cost-Automation bei igus. Sein Geschäftsbereich möchte mit der Onlineplattform RBTX die Komplexität in der Automatisierung reduzieren, um den Mittelstand in Zeiten steigenden Kostendrucks zu entlasten und produktiver zu machen. Die neueste Errungenschaft auf diesem Weg ist eine Linearachse, die sich über ein Plug-to-program in Sekundenschnelle mit den Robotersteuerungen der gängigsten Hersteller wie Epson, Dobot, igus und Omron verbinden lässt. Auch mit den Universal Robots UR 20 und UR 30 sowie den Fanuc CRX-Serien ist die 7. Achse nun kompatibel. „Erste Anwender berichten, dass sie dank des Plug-to-program-Prinzips bis zu 10.000 Euro Entwicklungskosten gespart haben“, erklärt der Robotik-Experte.

Vervierfachter Aktionsradius dank 7. Achse ab 2.800 Euro

Die 7. Achse von igus ermöglicht Leichtbau-Gelenkarmrobotern mit einem Gewicht von bis zu 55 Kilogramm, ihren Aktionsradius zu vervierfachen. Die Basis ist eine bis zu 6.000 Millimeter lange Linearschiene aus Aluminium, auf der ein Schlitten über vier Buchsen aus schmierfreiem Hochleistungskunststoff gleitet – bewegt von einem Elektromotor mit Zahnriemenantrieb, der eine Geschwindigkeit von bis zu 0,6 m/s und eine Positionierungsgenauigkeit von ±0,3 Millimetern ermöglicht. Auf diesen Schlitten können Anwender ihren Roboter über ein Adapterkit montieren. igus liefert zudem passende Energieketten aus Hochleistungskunststoff, um Energie- und Datenleitungen in der Bewegung zu schützen. „Dieser Schutz ist empfehlenswert, da rund 35 Prozent der Roboterausfälle auf mangelhaftes Leitungsmanagement zurückzuführen sind“, betont Alexander Mühlens. Erhältlich ist die Achse ab 2.313 Euro, hinzu kommen weitere 2.800 Euro für die Schaltschrankintegration. Zurückzuführen sind die niedrigen Kosten unter anderem auf den Einsatz von Hochleistungskunststoffen.

So leicht integrierbar wie eine App

Integrieren lässt sich die 7. Achse von igus über ein Software-Plugin direkt in die Robotersteuerung, jeweils angepasst an den Roboterhersteller. Die Steuerung erkennt die Achse nach der Installation automatisch. Der Anwender kann sie dann unmittelbar über das vertraute Bedienpanel des Roboters programmieren und steuern. Die Ansteuerung erfolgt dabei flexibel über digitale I/Os, über UR Cap oder über die igus Robot Control. Zudem sind alle sicherheitsrelevanten Komponenten wie Not-Aus-Relais bereits berücksichtigt, sodass keine zusätzliche Engineering-Arbeit erforderlich ist. Alexander Mühlens: „Auf diese Weise wird die Erweiterung des Arbeitsraumes von Leichtbau-Gelenkarmrobotern unkomplizierter denn je.“ Auslegen lässt sich die 7. Achse ganz einfach mithilfe eines Online-Konfigurators. Hier kann der Nutzer seinen Robotertypen und die entsprechende Einbaulage auswählen, Länge und Geschwindigkeit der Anwendung eingeben und erhält im Anschluss direkt einen Preis inklusive Angebot und Muster.

Erfahren Sie mehr zu den Lösungen für die 7. Achse am Roboter unter:

7. Achse | Linearachse für alle Roboter

Erleben Sie die 7. Achse live in Aktion bei einem Hersteller von Schokolade:

„ChocoMatic“ die automatische Pralinenausgabe