https://circuitmess.com/pages/butter-bot-teaser

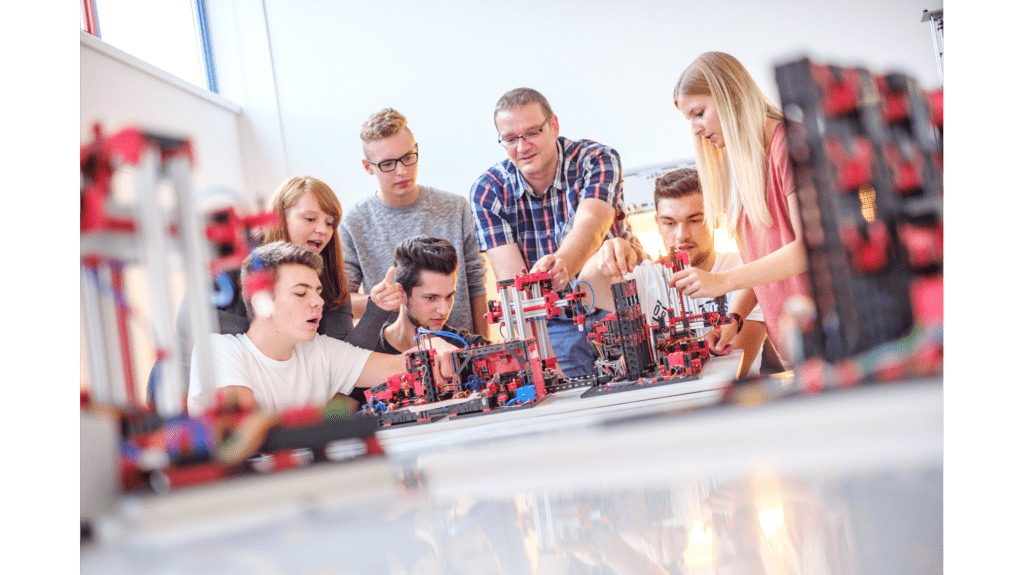

Die Forschung zur Anwendung von Künstlicher Intelligenz in der Produktionssteuerung wird an der Universität in Potsdam mit einer Fabriksimulationsanlage von fischertechnik simuliert.

Marcus Grum ist Juniorprofessor für Wirtschaftsinformatik, insbesondere für KI-basierte Anwendungssysteme. Er beugt sich über ein ungefähr ein mal ein Meter großes Modell aus fischertechnik Bausteinen. Fasziniert schaut er zu, wie ein roter Holzstein von einem kleinen Hochregallager aus über ein Transportband zu verschiedenen Fertigungsstätten transportiert wird. Das Simulationsmodell von fischertechnik wird an Universitäten und in der Ausbildung eingesetzt, um den Bestellprozess, den Produktionsprozess und den Lieferprozess in digitalisierten und vernetzten Prozessschritten abzubilden.

An der Universität Potsdam wurde die fischertechnik Lernfabrik 4.0 in Kombination mit anderen Simulationstools und einem neuronalen Zwilling dazu verwendet, globale Fertigungssteuerungsprozesse nachzustellen. In einer Forschungsreihe wurde beispielsweise eine Marmeladenproduktion simuliert. Es wurde angenommen, dass Produkte weltweit an vier verschiedenen Fertigungsstätten gefertigt werden, die jedoch über unterschiedliche IT-Systeme verfügen.

Beleuchtet wurden sämtliche Prozesse, vom Beschaffen der Früchte bis hin zum Vertrieb an den Kunden. Die fischertechnik Lernfabrik 4.0 stellte eine von vier der vernetzten haptischen Fertigungsstationen dar. In der Anlage wurde der Prozess vom Einlagern der Früchte über das Einführen in die Kochmaschine zur Marmeladeherstellung bis hin zur Befüllung der Gläser und

das Ausliefern der Produkte simuliert. Das haptische Modell wurde an ein neuronales Netzwerk (ANN – Artificial Neural Network) angeschlossen. „Damit führten wir Versuchsreihen und Experimente durch, die valide Ergebnisse liefern und Produktionsineffizienzen aufzeigen. Wir können aus diesen Ergebnissen ableiten, wie derartige Ineffizienzen vermieden werden können“, erklärt Prof. Grum. Der Jungwissenschaftler wurde im vergangenen Jahr von der Stiftung Werner-von-Siemens-Ring für die Entwicklung eines methodischen Ansatzes geehrt, der es ermöglicht, Maschinen- und Geschäftsprozesse mit Hilfe von künstlichen neuronalen Netzen (KNN) zu modellieren.

Die zukünftige Forschung wird sich mit der empirischen Überprüfung der Anweisungen von neuronalen Netzen und entsprechenden Managementinterventionen befassen, die in realen Echtzeitproduktionen entstehen. „Auch hier wird die Fabriksimulationsanlage von fischertechnik zum Einsatz kommen“, sagt Prof. Grum.

Weiterführende Informationen zu den fischertechnik Fabriksimulationsanlagen: Simulationsmodelle für Industrie und Hochschulen – fischertechnik

Fraunhofer-Institute, Lamarr Institut, igus und Uni Bonn entwickeln Sprachmodell für kostengünstige Automatisierungslösungen in der Kommissionierung Köln, 1. Oktober 2024 – Mitte September fand bei igus in Köln ein Hackathon statt. Unter dem Motto „Künstliche Intelligenz trifft Robotics“ arbeiteten 17 Teilnehmer in drei interdisziplinären Teams daran, fortschrittliche Automatisierungslösungen für die Logistik zu entwickeln. Ziel des Hackathons war es, mithilfe eines großen KI-basierten Sprachmodells (Large Language Models, kurz: LLM) eine automatisierte Methode zum Verpacken von Pizzen zu schaffen. Die Veranstaltung fand in Zusammenarbeit mit dem Fraunhofer-Institut für Intelligente Analyse- und Informationssysteme IAIS, der Universität Bonn, dem Lamarr Institut und dem Fraunhofer-Institut für Materialfluss und Logistik IML statt. 20-mal Tonno, 10-mal Salami und 25-mal Margherita: So lautet die Bestellung des Supermarkts um die Ecke bei einem großen Hersteller von TK-Pizzen. Das klingt nach einer einfachen Aufgabe, ist jedoch immer noch Handarbeit, die aktuell manuell erledigt wird. Eine einfache und wenig anspruchsvolle Arbeit, für die sich oftmals kein Personal findet. Eine Lösung hierfür entwickelten 17 Teilnehmer der Fraunhofer Institute IAIS und IML, des Lamarr-Instituts für Maschinelles Lernen und Künstliche Intelligenz sowie Mitarbeitende der Universität Bonn innerhalb eines 5-tägigen Hackathons bei igus in Köln. Und zwar mithilfe von kosteneffizienter „Low Cost Robotic“ made in Cologne. Die Aufgabe des Hackathons lautete: Entwickelt eine Automatisierungslösung, die mithilfe von Künstlicher Intelligenz (KI) die Pizzen automatisch verpackt. Die Herausforderung bestand darin, einen Roboter so zu steuern, dass er über Sprachanweisungen direkt von Mitarbeitenden die richtigen Produkte erkennt, greift und in Mischpakete verpackt. Durch die Kombination von Generativen KI (GenAI) und Robotik sollte eine Lösung entwickelt werden, die diese repetitive Arbeit effizienter und kostengünstiger gestaltet. Automatisierung der Industrie mit KI und kostengünstiger Robotik Während des Hackathons arbeiteten drei Teams an einem realen Use Case, bei dem ein ReBeL Roboterarm vor einem Förderband mit verschiedenen Pizzaprodukten platziert wurde. Mithilfe einer Webcam und einem KI-basierten Segmentierungssystem (Segment Anything Model, SAM) erkannten die Systeme die verschiedenen Produkte auf dem Förderband und identifizierten ihre Position. Das Sprachmodell ordnete diese Objekte den gewünschten Produkten zu, basierend auf den natürlichsprachlichen Anweisungen. Anschließend legte der Roboter die Produkte in die Boxen, indem er die Anweisungen des Sprachmodells befolgte. Alexander Zorn vom Fraunhofer IAIS zeigte sich begeistert von den Ergebnissen des Hackathons: „Wir freuen uns sehr, mit dem igus Robotik-Know-how reale Proof-of-Concepts für Kunden in der Industrie zu entwickeln. Die Kombination von Künstlicher Intelligenz und Robotik bietet enorme Potenziale, um Arbeitsprozesse zu automatisieren und effizienter zu gestalten.“ Auch Alexander Mühlens, Prokurist und Leiter der Abteilung Low Cost Automation bei der igus GmbH, betonte die Bedeutung des Hackathons: „Die Zusammenarbeit mit den Instituten gibt uns die Möglichkeit, unseren Kunden zu zeigen, was alles mithilfe von KI und Low-Cost-Robotic möglich ist. Unser Traum ist es, Roboter über einen Sprachbefehl einfach steuern zu können, und das in jeder Anwendung.“ Der Hackathon zeigte, dass durch den Einsatz von LLMs und Robotik viele weitere Automatisierungsmöglichkeiten denkbar sind, wie beispielsweise das gleichzeitige Packen mehrerer Boxen, das Sortieren von Produkten nach speziellen Anweisungen oder das Überprüfen von Inhaltsstoffen auf Allergene mithilfe von Kamerasystemen. Die erfolgreiche Zusammenarbeit zwischen igus, dem Fraunhofer IAIS, dem Lamarr-Institut der Universität Bonn und dem Fraunhofer IML unterstreicht das Potenzial dieser Technologien für die industrielle Automatisierung. **Über die Partner** Das Fraunhofer IAIS ist eines der führenden Forschungsinstitute auf den Gebieten Künstliche Intelligenz (KI), Maschinelles Lernen und Big Data, während die Universität Bonn als Zentrum für Künstliche Intelligenz und Robotik bekannt ist. Das Fraunhofer IML in Dortmund brachte seine Fachexpertise in der Logistikautomatisierung und im Materialfluss ein. Während das Lamarr-Institut führend in der internationalen KI-Forschung und dem Maschinellen Lernen ist. |

siehe auch meinen Vergleich zur ersten Generation: https://robots-blog.com/2024/08/22/unterschiede-zwischen-vex-iq-1st-generation-und-vex-iq-2nd-generation/

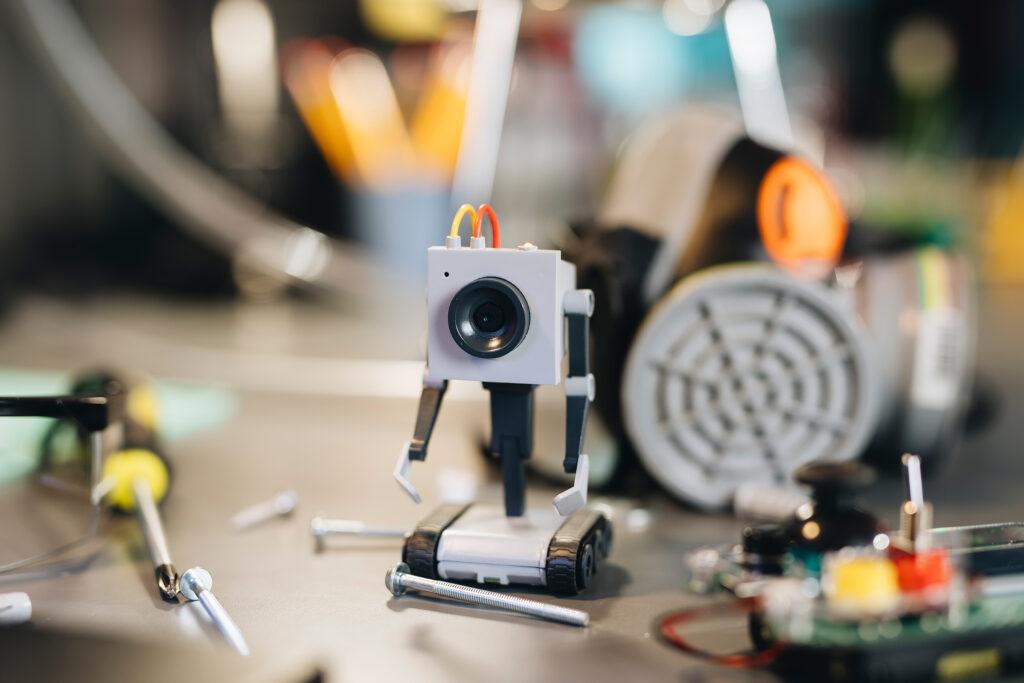

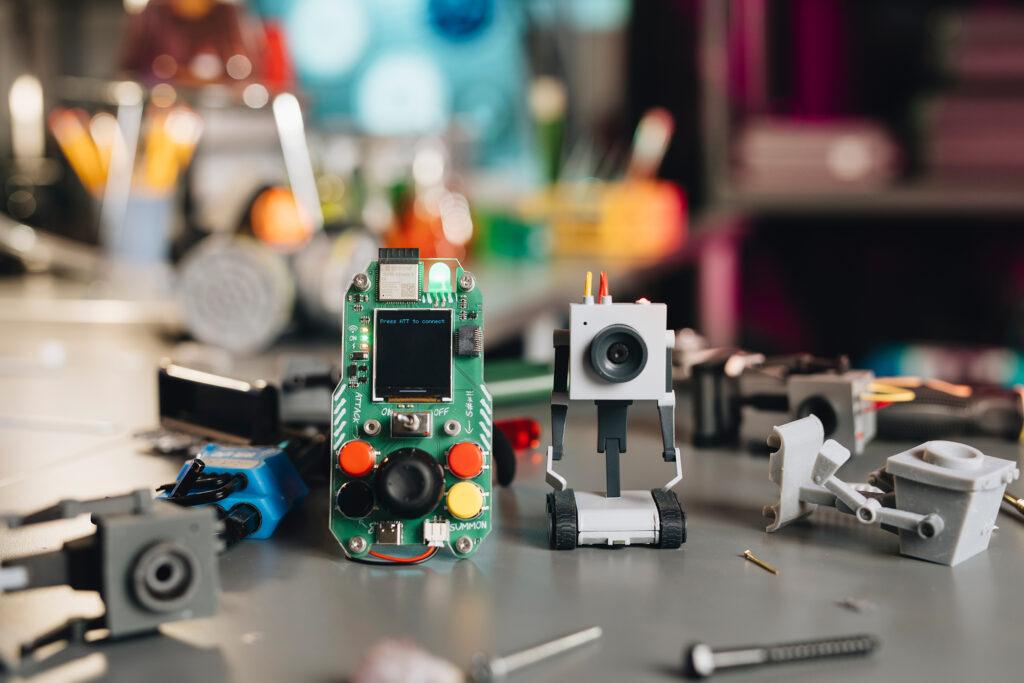

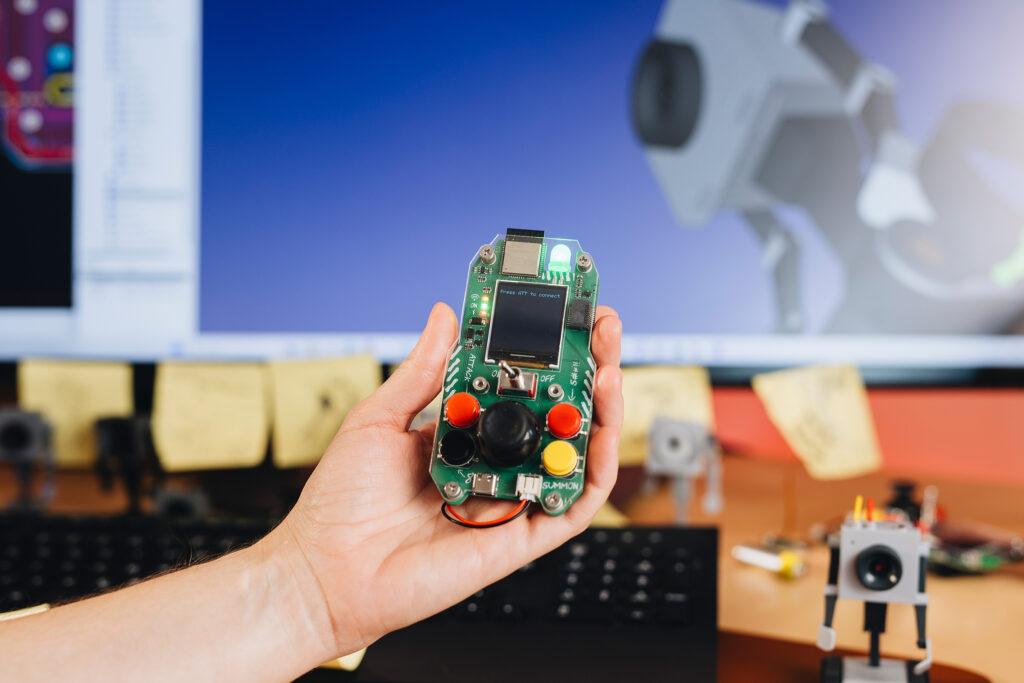

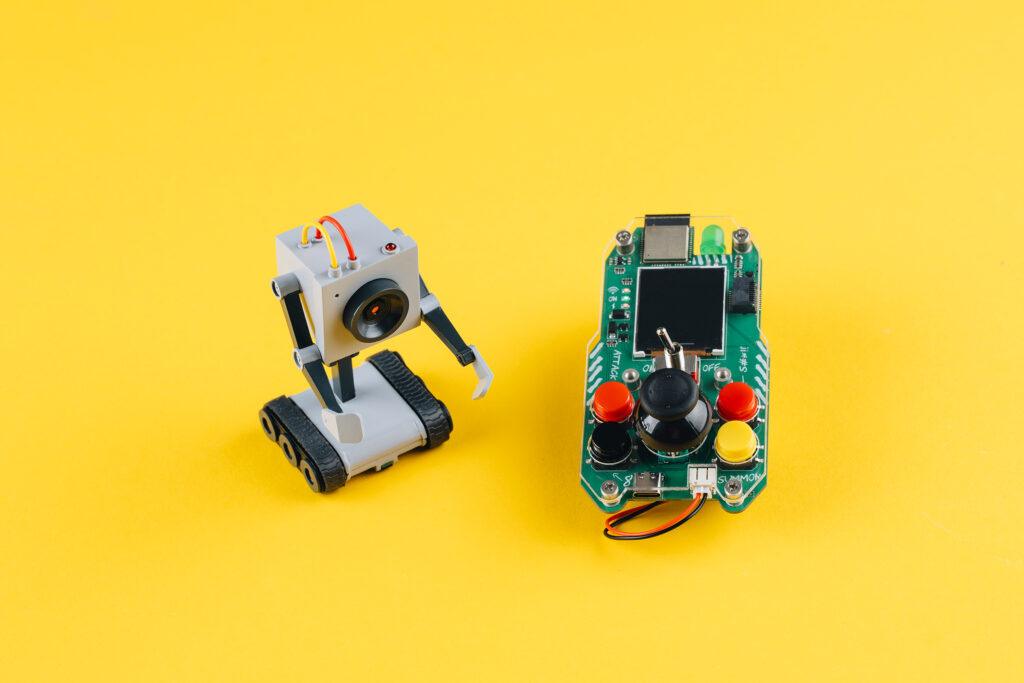

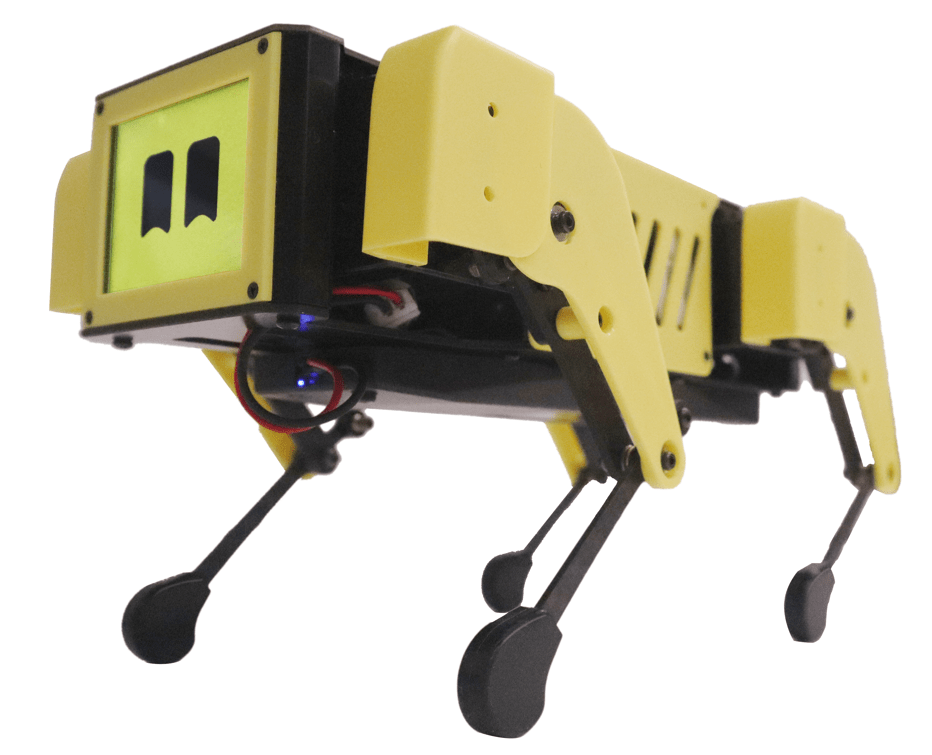

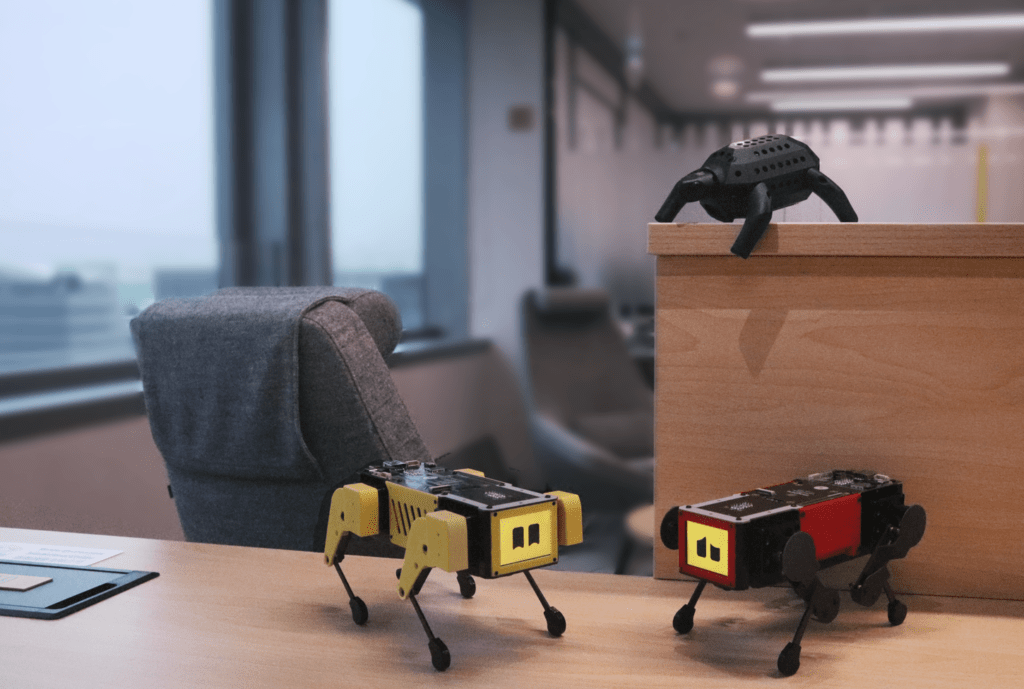

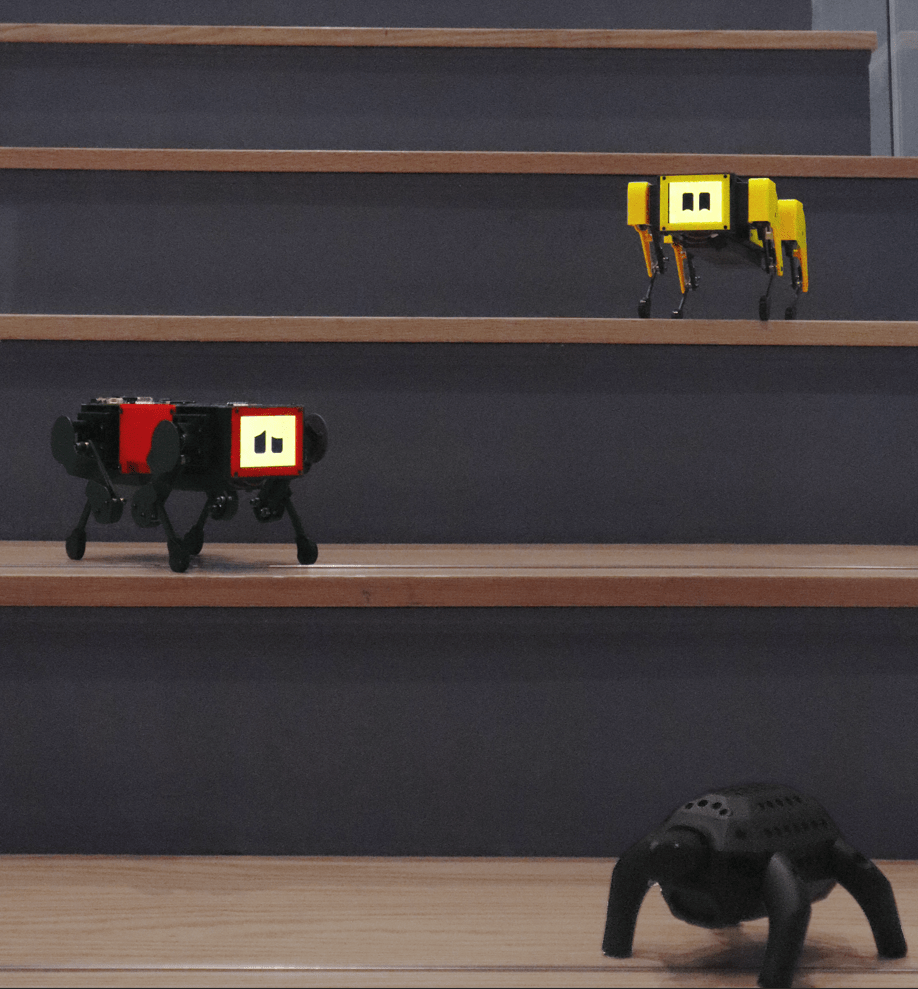

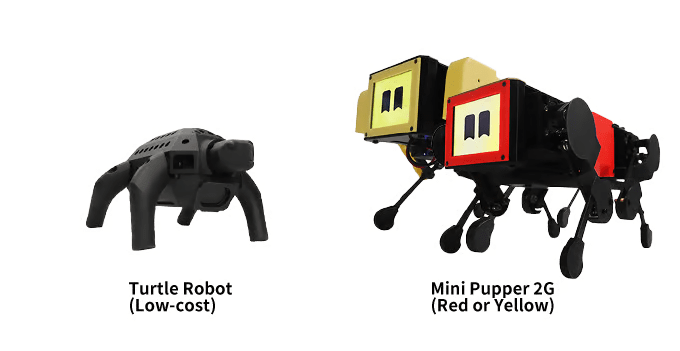

MangDang’s Kickstarter project „MD Robot Kit: Unlock your AI Robot Engineering Dream Job“ aims to promote the creativity and technical know-how of robotics enthusiasts. It offers two main robots, each addressing different needs and interests.

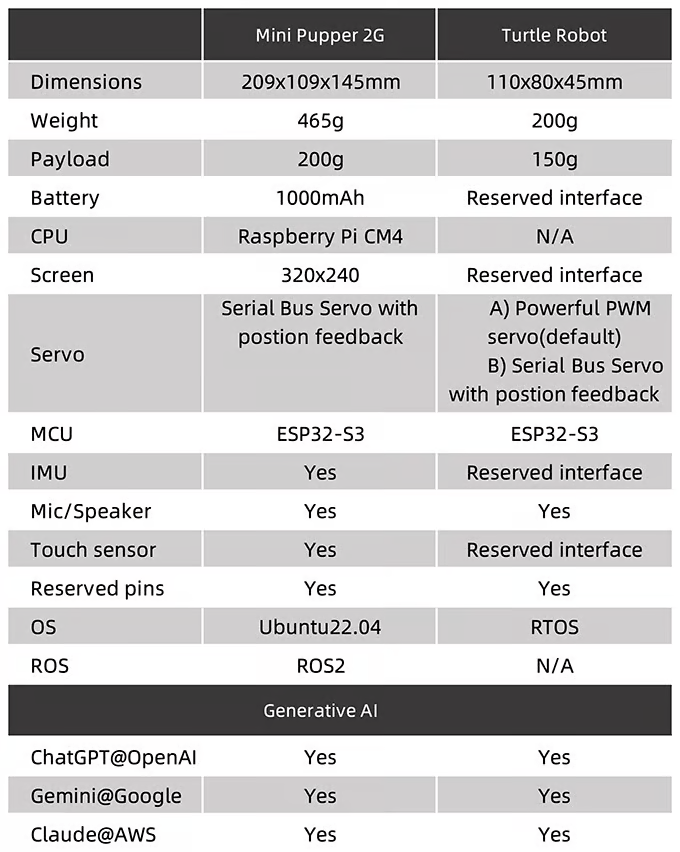

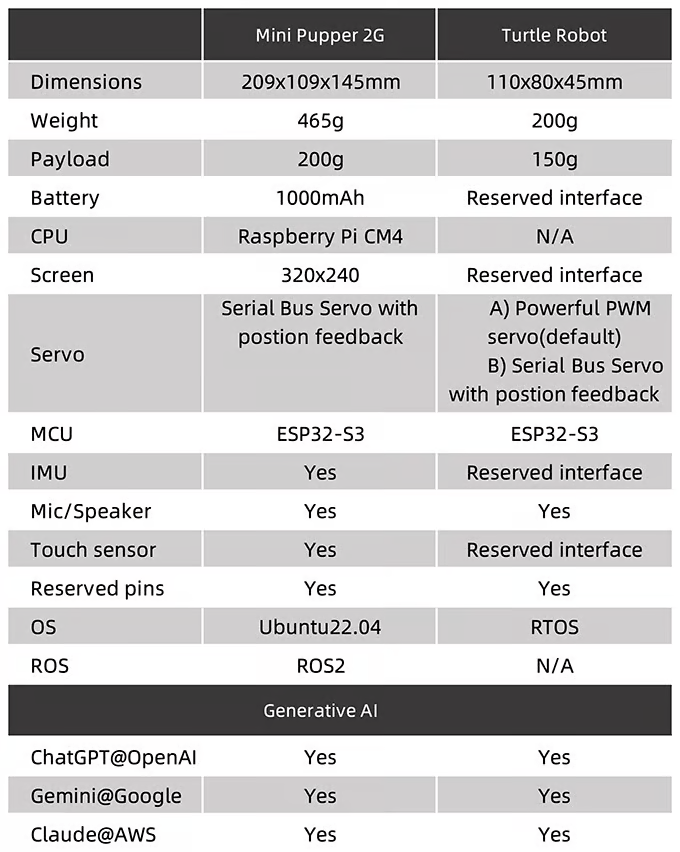

The first robot, the Mini Pupper, is available in several versions, including Mini Pupper 1, Mini Pupper 2, and the 2G and 2GA models. This robot is a low-cost, personal quadruped kit that comes with open-source software. The Mini Pupper supports multimodal generative AI platforms such as OpenAI’s ChatGPT, Google’s Gemini, and AWS’s Claude. It is also compatible with ROS1 and ROS2, which expands its capabilities in the areas of SLAM (Simultaneous Localization and Mapping) and navigation. The integration of OpenCV allows the robot to perform deep learning with cameras. Thanks to the use of Raspberry Pi and Arduino, the Mini Pupper offers high adaptability and expandability, making it ideal for developers who want to realize their own projects.

The second robot presented is the Turtle Robot, which will be available soon. This robot is specifically aimed at schools, homeschooling families, and robot enthusiasts. While detailed specifications have not yet been fully released, it is clear that the Turtle Robot also aims to support learning and creativity in the field of robotics.

The campaign itself has set a funding goal of 9000€ and has clearly exceeded it with a sum of just under 19000€, which corresponds to over 200% of the original goal. The campaign runs from September 5, 2024 to October 5, 2024 and has attracted 80 supporters so far. A standout feature of the MD Robot Kits is their open-source nature, which allows users to assemble the robots in less than an hour. This makes them particularly accessible to a wide range of audiences, ranging from educational institutions to DIY enthusiasts. The project is designed not only to impart technical knowledge, but also to promote the joy of creating and customizing robots.

2. Turtle Robot:

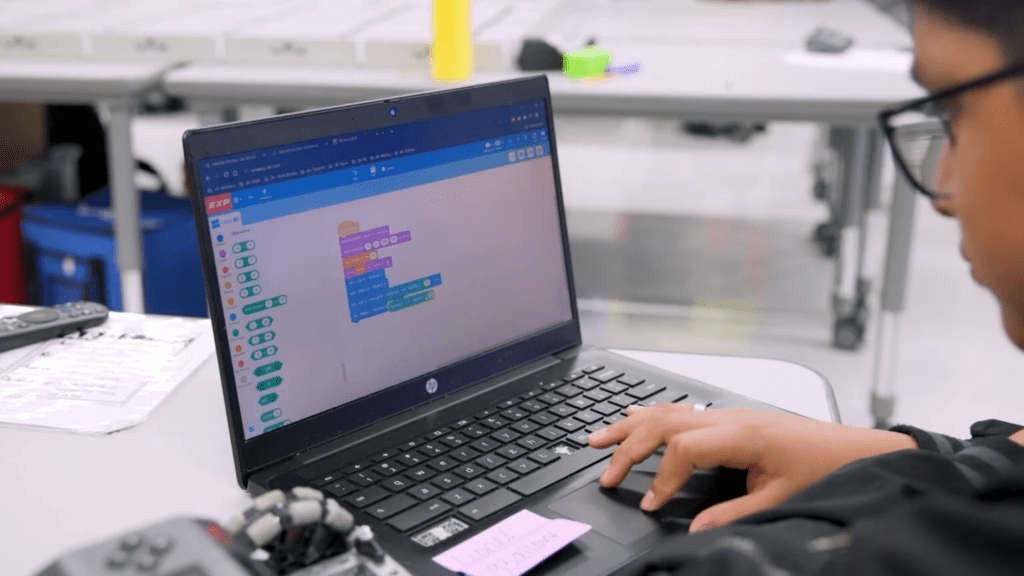

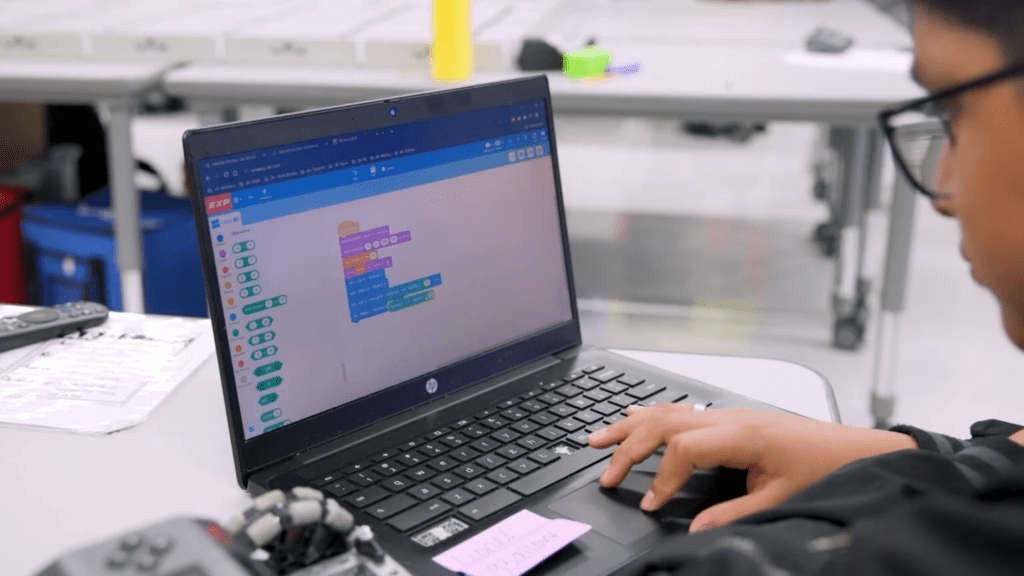

VEX Robotics hat VEXcode für ein neues Jahr des Programmierens aktualisiert! VEXcode 4.0 für VEX IQ, VEX EXP und VEX V5 bringt den Benutzern einige aufregende neue Funktionen! Diese Bemühungen zielen darauf ab, die Benutzererfahrung zu optimieren und zusätzliche Optionen für die Barrierefreiheit zu unterstützen. Entdecken Sie die neuen Funktionen für jede Plattform unten und in den begleitenden VEX Library-Artikel!

VEXcode IQ 4.0 führt wichtige Updates ein. Zu den bemerkenswerten Ergänzungen gehören Switch Blocks, die einen nahtlosen Übergang von blockbasierter zu textbasierter Codierung auf einem physischen Roboter ermöglichen, verbesserte Speicher- und Ladefunktionen für webbasierte VEXcodeund neue Barrierefreiheitsoptionen wie „Blöcke vorlesen“. Diese Updates wurden entwickelt, um die Benutzererfahrung zu optimieren und Anfänger und fortgeschrittene Benutzer zu unterstützen.

Erfahren Sie hier mehr über diese Updates: https://kb.vex.com/hc/en-us/articles/29278709186708-New-Features-in-VEXcode-IQ-4-0

VEXcode EXP 4.0 bietet umfassende Updates, die das Bildungserlebnis für Lehrer und Schüler verbessern sollen. Diese Version bietet volle Unterstützung für den CTE Workcell, der eine nahtlose Integration von Industrierobotik in den Unterricht ermöglicht. Die neue Funktion „Blöcke wechseln“ ermöglicht einen reibungslosen Übergang von blockbasierter zu textbasierter Codierung und erleichtert so fortgeschrittenes Lernen. Darüber hinaus ermöglichen webbasierte drahtlose Projekt-Downloads effizientere Arbeitsabläufe, indem sie es Benutzern ermöglichen, direkt über ihren Webbrowser eine Verbindung zu einem EXP Brain herzustellen. Verbesserte Barrierefreiheitsfunktionen wie (Vor-)Leseblöcke, anpassbare Stimmen und kontrastreiche Themen machen VEXcode inklusiver und benutzerfreundlicher. Der aktualisierte AI Vision Sensor unterstützt jetzt AprilTags und AI Classifications, wodurch die autonomen Fähigkeiten verbessert werden. Mit diesen Verbesserungen unterstützt VEXcode EXP 4.0 weiterhin eine breite Palette von Bildungsanforderungen, von Anfängern bis hin zu fortgeschrittenen Roboterprogrammierungen.

Erfahren Sie hier mehr über diese Updates: https://kb.vex.com/hc/en-us/articles/29373428548372-New-Features-in-VEXcode-V5-4-0

VEX Robotics updated VEXcode for a new year of coding! VEXcode 4.0 for VEX IQ, VEX EXP, and VEX V5 brings users some exciting new features! These efforts aim to streamline user experience and support added accessibility options. Explore the new features for each platform below and in their accompanying VEX Library articles!

VEXcode IQ 4.0 introduces major updates. Notable additions include Switch Blocks, which enable a seamless transition from block-based to text-based coding on a physical robot, enhanced save and load features for web-based VEXcode, and new accessibility options like Read Blocks Aloud. These updates are designed to streamline the user experience and support beginners and advanced users.

Learn more about these updates here: https://kb.vex.com/hc/en-us/articles/29278709186708-New-Features-in-VEXcode-IQ-4-0

VEXcode EXP 4.0 offers comprehensive updates designed to elevate the educational experience for teachers and students. This release includes full support for the CTE Workcell, enabling seamless integration of industrial robotics into the classroom. The new Switch Blocks feature allows for a smooth transition from block-based to text-based coding, facilitating advanced learning. Additionally, web-based wireless project downloads enable more efficient workflows by allowing users to connect to an EXP Brain directly from their web browser. Enhanced accessibility features like Read Blocks Aloud, customizable voices, and high-contrast themes make VEXcode more inclusive and user-friendly. The updated AI Vision Sensor now supports AprilTags and AI Classifications, enhancing autonomous capabilities. With these enhancements, VEXcode EXP 4.0 continues to support a wide range of educational needs, from introducing beginners to advanced robotic programming.

Learn more about these updates here: https://kb.vex.com/hc/en-us/articles/29373428548372-New-Features-in-VEXcode-V5-4-0

Das Kickstarter-Projekt „MD Robot Kit: Unlock your AI Robot Engineering Dream Job“ von MangDang zielt darauf ab, die Kreativität und das technische Know-how von Robotik-Enthusiasten zu fördern. Es bietet zwei Hauptroboter, die jeweils unterschiedliche Bedürfnisse und Interessen ansprechen.

Der erste Roboter, der Mini Pupper, ist in mehreren Versionen erhältlich, darunter Mini Pupper 1, Mini Pupper 2 sowie die Modelle 2G und 2GA. Dieser Roboter ist ein kostengünstiges, persönliches Quadruped-Kit, das mit Open-Source-Software ausgestattet ist. Der Mini Pupper unterstützt multimodale generative KI-Plattformen wie ChatGPT von OpenAI, Gemini von Google und Claude von AWS. Zudem ist er mit ROS1 und ROS2 kompatibel, was seine Fähigkeiten in den Bereichen SLAM (Simultaneous Localization and Mapping) und Navigation erweitert. Die Integration von OpenCV ermöglicht es dem Roboter, Deep Learning mit Kameras durchzuführen. Dank der Nutzung von Raspberry Pi und Arduino bietet der Mini Pupper eine hohe Anpassungsfähigkeit und Erweiterbarkeit, was ihn ideal für Entwickler macht, die ihre eigenen Projekte realisieren möchten.

Der zweite vorgestellte Roboter ist der Turtle Robot, der bald verfügbar sein wird. Dieser Roboter richtet sich speziell an Schulen, Homeschooling-Familien und Roboter-Enthusiasten. Während detaillierte Spezifikationen noch nicht vollständig veröffentlicht wurden, ist klar, dass der Turtle Robot ebenfalls darauf abzielt, das Lernen und die Kreativität im Bereich der Robotik zu unterstützen.

Die Kampagne selbst hat ein Finanzierungsziel von 9000€ gesetzt und dieses mit einer erreichten Summe von knapp 19000€ , was über 200% des ursprünglichen Ziels entspricht, deutlich übertroffen. Die Kampagne läuft vom 5. September 2024 bis zum 5. Oktober 2024 und zog bisher 80 Unterstützer an. Ein herausragendes Merkmal der MD Robot Kits ist ihre Open-Source-Natur, die es den Nutzern ermöglicht, die Roboter in weniger als einer Stunde zusammenzubauen. Dies macht sie besonders zugänglich für eine breite Zielgruppe, die von Bildungseinrichtungen bis hin zu DIY-Enthusiasten reicht. Das Projekt ist darauf ausgelegt, nicht nur technisches Wissen zu vermitteln, sondern auch die Freude an der Schaffung und Anpassung von Robotern zu fördern.

1. Mini Pupper:

2. Turtle Robot:

Friday, September 13th marks the kick-off day for Maker Days Eindhoven. The day begins with the launch of the Future Makers program in collaboration with the Novalis high school from Eindhoven, followed by Maker Night in the evening—a premiere of a mind-blowing experience featuring unique Sound Machines.

On Friday, September 13th, the Future Makers Factory will debut, a unique program aimed at young people, developed in collaboration with schools and partners. This day is all about innovation, technology, and creativity and serves as a significant lead-up to Maker Days Eindhoven, which will take place on Saturday, September 14th, and Sunday, September 15th.

In the morning, the Maker Days organization will host four classes from Novalis high school in Eindhoven for an inspiring and educational program. Students will participate in various workshops designed to challenge and inspire them to discover and develop their own creativity. The workshops focus on themes such as Sound Machines, virtual reality, the metaverse, video, music, upcycling, sustainable living, kinetic art, cyber fashion, gaming, transformer, and robot art.

The Future Makers Factory is not just an event; it is a powerful statement promoting creative technology and the development of 21st-century skills. As a side event of Maker Days Eindhoven, this program puts maker education firmly on the map, offering young people aged 14 to 25 the chance to discover and develop their talents.

The kick-off day continues into the evening, where all youth under the age of 23 are invited. Maker Night is a special performance program developed specifically for this age group. During this evening, they can enjoy spectacular and interactive performances, a perfect way to conclude a day full of innovation. Tickets for this evening are available at makerdays.nl.