Mehr Informationen unter: https://www.iais.fraunhofer.de/de/branchen-themen/themen/intelligente-prozessautomatisierung/gen-ai-robotersteuerung.html

Archiv der Kategorie: AI

Wo Ideen tanzen und Technik begeistert – Riesige Ballerina tanzt auf der Maker Faire Hannover

Hannover, 30. Juni 2025 – Technik, Kunst und gesellschaftliche Botschaft verschmelzen in einem außergewöhnlichen Projekt der spanischen Theatergruppe Antigua i Barbuda auf dem DIY-Event Maker Faire Hannover, das am 23. und 24. August im HCC stattfindet. Mit „La Danseuse“, einer über fünf Meter hohen mechanischen Ballerina, setzen die Künstlerinnen ein kraftvolles Zeichen für weibliches Empowerment – umgesetzt mit beeindruckender Ingenieurskunst.

Das größte Maker-Treffen im deutschsprachigen Raum verwandelt das Hannover Congress Centrum (HCC) bereits zum elften Mal in ein kreatives Ideenlabor. Eine der Hauptattraktionen in diesem Jahr: die faszinierende Performance von „La Danseuse“, die technische Feinheit und anmutige Bewegung auf eindrucksvolle Weise vereint.

„Diese einzigartige Theatererfahrung aus Objekten in Bewegung symbolisiert Freiheit und weibliche Stärke”, erklärt die Theatergruppe, die ihre monumentale Maschinenfrau erstmals in Deutschland präsentiert.

Sicher ist: „La Danseuse“ wird mit ihrer Präsenz und Ausdruckskraft für Staunen sorgen – und zeigen, wie Maschinen nicht nur funktionieren, sondern auch berühren können. „Passend zu unserem Show Act und der Projektvielfalt unserer Aussteller steht die diesjährige Maker Faire unter dem Motto ‚Wo Ideen tanzen und Technik begeistert‘, erklärt Daniel Rohlfing, Leiter Events & Sales Maker Faire Deutschland. „Das macht neugierig und trifft den Kern der Veranstaltung.“

Seit ihrer Premiere im Jahr 2013 hat die Maker Faire Hannover über 140.000 Besucherinnen und Besucher begeistert. Mit interaktiven Stationen, Workshops und Präsentationen bietet sie den idealen Rahmen für ein Projekt wie „La Danseuse“. Neben der Maschinenperformance erwarten die Gäste an rund 230 Ständen zahlreiche weitere kreative Ideen von Makern, Erfinderinnen und Forschern, die zum Mitmachen und Staunen einladen.

Tickets für die Maker Faire Hannover sind im Onlineshop oder an der Tageskasse (bargeldlos) erhältlich. Der Eintritt für Erwachsene kostet 24 Euro, ermäßigt 19 Euro. Kinder unter 10 Jahren können kostenlos dabei sein. Die Veranstaltung öffnet am Samstag von 10 bis 18 Uhr und am Sonntag von 10 bis 17 Uhr. Weitere Infos unter: maker-faire.de

Über die Maker Faire Hannover:

Seit 2013 begeistert die Maker Faire Hannover als Plattform für Inspiration, Kreativität und Innovation Teilnehmer aller Altersgruppen. Die Veranstaltung bringt Technik, Handwerk und Kunst zusammen und hat sich zu einem festen Termin im Kalender der internationalen Maker-Szene etabliert.

KI-Gestenerkennung mit IDS NXT Kamera lässt igus ReBel Roboter Stein, Schere, Papier gegen Mensch spielen

Automatica 2025: Vention erweitert Angebot mit Robotiklösungen von Franka Robotics

MÜNCHEN, 17. Juni 2025 /PRNewswire/ — Vention, Anbieter der weltweit einzigen vollständig integrierten Software- und Hardware-Plattform für industrielle Automatisierung, erweitert sein Robotik-Portfolio um kollaborative Roboter der Franka Robotics GmbH, einer Tochtergesellschaft der in München ansässigen Agile Robots SE.

- Vention hat sein Roboterangebot um kollaborative Roboter der Franka Robotics GmbH erweitert, einem in Deutschland ansässigen Hersteller von Präzisions-Cobots, die in der Forschung und Entwicklung beliebt sind.

- Vention und Franka Robotics zeigen auf der Automatica PCB-Tests mit einem Franka Research 3 (FR3)-Roboter für die präzise und sichere Automatisierung empfindlicher Elektronik.

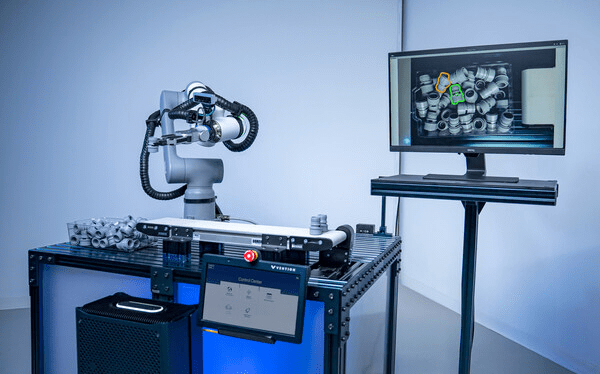

- Darüber hinaus präsentiert Vention KI-gestütztes Bin-Picking und ein All-in-One-Steuerungssystem für Bewegung, Bildverarbeitung, Sensorik und KI.

- MachineMotion™ AI, Ventions Steuerung der dritten Generation, feiert ihre Europapremiere mit einer KI-gestützten Bin-Picking-Demonstration auf einem ABB GoFa – inklusive intelligenter Teileerkennung und Greifpräzision im Submillimeterbereich.

- Modulare Roboterzellen für Maschinenbestückung und Palettierung werden ebenfalls gezeigt – mit führenden Robotermarken wie Universal Robots und FANUC.

- Besucher von Stand B4.307 erhalten kostenlosen Zugang zu MachineBuilder 101™, dem neuen Zertifikatskurs von Vention zur Planung, Simulation und Inbetriebnahme von Automatisierungslösungen auf der Vention-Plattform.

Franka Robotics hat sich mit seinem beliebten FR3-Roboterarm als führende Plattform in der akademischen Forschung etabliert und ist mittlerweile die bevorzugte Wahl für Doktoranden, KI-Forscher und Robotik-Labore. Mit der Aufnahme von Franka Robotics-Anwendungen in das eigene Portfolio erweitert Vention sein Angebot gezielt, um der starken Nachfrage von Hochschulen, Forschungseinrichtungen und innovationsgetriebenen Unternehmen gerecht zu werden, die bereits im Vention-Ökosystem arbeiten.

Vention präsentiert auf der Automatica 2025 (vom 24. bis 27. Juni) in München erstmalig eine Live-Demonstration mit einem FR3-Roboter von Franka Robotics (Stand B4.307).

„Wir sind stolz, Franka Robotics im Vention-Ökosystem begrüßen zu dürfen“, sagt Francois Giguere, Chief Technology Officer von Vention. „Der sehr gute Ruf von Franka Robotics im akademischen Umfeld passt perfekt zu unserer Mission, die industrielle Automatisierung zugänglicher und intuitiver zu gestalten. Wir freuen uns über die Zusammenarbeit mit einer angesehenen deutschen Marke – Deutschland hat die Geschichte von Vention von Anfang an maßgeblich geprägt, und diese Partnerschaft markiert ein spannendes neues Kapitel auf unserem Weg.“

„Die Partnerschaft mit Vention ermöglicht es uns, die Reichweite unseres Roboters Franka Research 3 einem breiteren Anwenderkreis im akademischen Bereich und in innovativen Anwendungen zugänglich zu machen“, erklärt Henrik Hermann, Vertriebsleiter bei Franka Robotics. „Gemeinsam setzen wir uns dafür ein, innovative, benutzerfreundliche Automatisierungslösungen zu liefern, die unseren Kunden neue Möglichkeiten in der Robotik und KI eröffnen.“

Der FR3 ist ein benutzerfreundlicher, kompakter und leichter (18 kg) Roboterarm mit sieben Freiheitsgraden. Er ist sicher, hochflexibel und damit ideal für Laborumgebungen mit begrenztem Platzangebot. Dank seiner drehmomentgeregelten Gelenke verfügt er über eine Echtzeit-Kraftsensorik, mit der er Kräfte wahrnehmen und darauf reagieren kann. Dies ist entscheidend für die Forschung zur Mensch-Roboter-Interaktion, das Lernen durch Demonstration sowie die Durchführung kontaktintensiver Aufgaben mit empfindlichen Komponenten.

Vention auf der Automatica 2025

Vention zeigt auf der Automatica insgesamt vier Live-Demonstrationen, die die vollständig integrierte Automatisierungsplattform des Unternehmens in der Praxis erlebbar machen – durch die Kombination aus intuitiver Software, modularer Hardware und den KI-gestützten Funktionen von MachineMotion™ AI.

MachineMotion™ KI & NVIDIA-Technologie – Leistungsstarke Bewegungssteuerung

Nach der NVIDIA GTC 2025 und der Automate in den USA stellt Vention seine KI-gestützten Bin-Picking-Demonstration mit einem ABB GoFa CRB 15000 erstmals auf einer europäischen Messe vor. Auf Basis von MachineMotion™ AI, NVIDIA Jetson Computing sowie CUDA-beschleunigten Isaac-Bibliotheken und -Modellen von NVIDIA deckt die Live-Demonstration von Vention fortschrittliche Robotik, KI-basierte Bewegungssteuerung und skalierbare Schulungsszenarien ab – und zeigt, welchen konkreten Mehrwert KI bei der praktischen Implementierung robotergestützter Lösungen in der Fertigung bietet. Die Anwendung erreicht eine Greifgenauigkeit im Submillimeterbereich bei ungeordneten Fertigungsteilen – ideal für High-Mix-/Low-Volume-Produktionsumgebungen.

Modulare Demos für praxisnahe Anwendungen

Im Rahmen Automatica wird Vention den FR3-Arm von Franka Robotics bei Leiterplattentests auf einer Vention-Workstation vorführen und die Präzision und schonende Handhabung für empfindliche Elektronik und feinmotorische Aufgaben demonstrieren.

Darüber hinaus erleben Besucher vollständig integrierte, anpassbare Roboterzellen für:

- 7th Axis Range Extender – für mehr Reichweite und Flexibilität bei Anwendungen wie Maschinenbestückung, Montage und Verpackung.

- Rapid Series Palletizer – aufgebaut auf einer Teleskopsäule und optimiert mit der neuesten Version 4.5 der MachineApp-Software von Vention.

Die Live-Demonstrationen finden in Halle B4, Stand 307 statt.

Weitere Informationen auf Vention.com.

Enhancing Drone Navigation with AI and IDS uEye Camera Technology

AI-driven drone from University of Klagenfurt uses IDS uEye camera for real-time, object-relative navigation—enabling safer, more efficient, and precise inspections.

The inspection of critical infrastructures such as energy plants, bridges or industrial complexes is essential to ensure their safety, reliability and long-term functionality. Traditional inspection methods always require the use of people in areas that are difficult to access or risky. Autonomous mobile robots offer great potential for making inspections more efficient, safer and more accurate. Uncrewed aerial vehicles (UAVs) such as drones in particular have become established as promising platforms, as they can be used flexibly and can even reach areas that are difficult to access from the air. One of the biggest challenges here is to navigate the drone precisely relative to the objects to be inspected in order to reliably capture high-resolution image data or other sensor data.

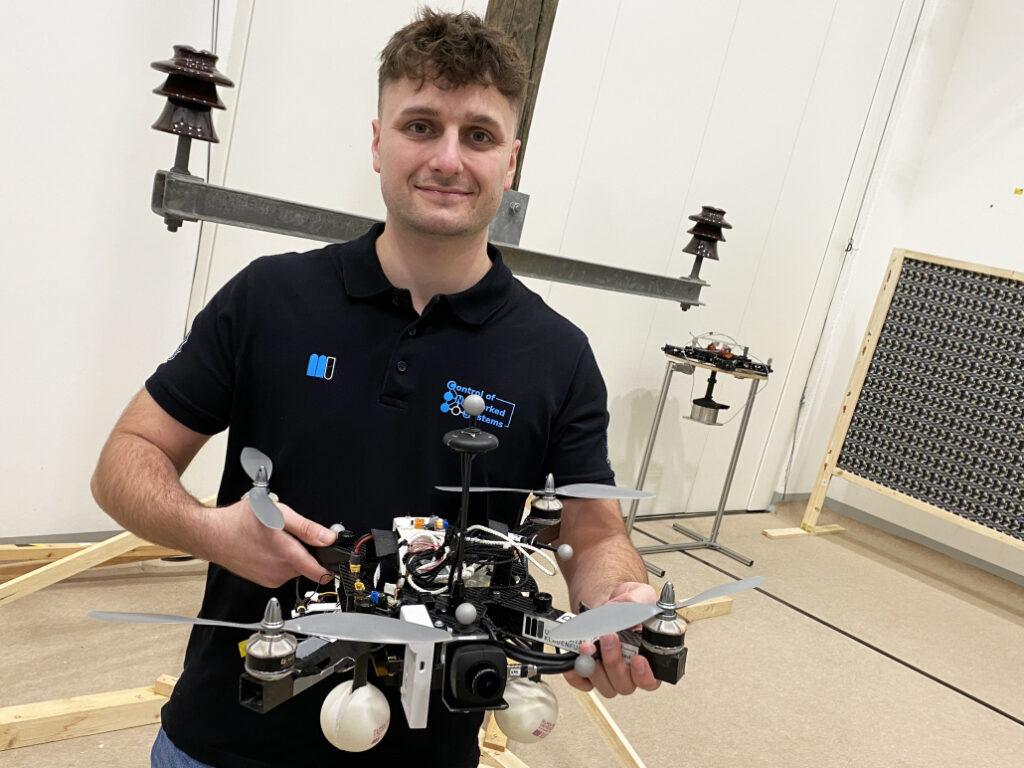

A research group at the University of Klagenfurt has designed a real-time capable drone based on object-relative navigation using artificial intelligence. Also on board: a USB3 Vision industrial camera from the uEye LE family from IDS Imaging Development Systems GmbH.

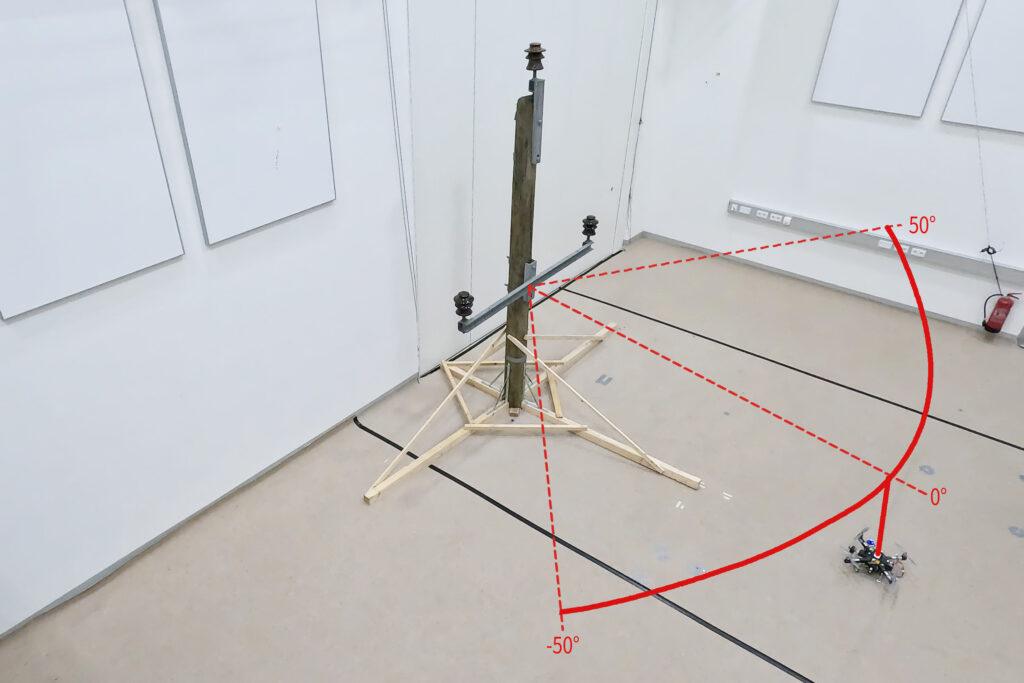

As part of the research project, which was funded by the Austrian Federal Ministry for Climate Action, Environment, Energy, Mobility, Innovation and Technology (BMK), the drone must autonomously recognise what is a power pole and what is an insulator on the power pole. It will fly around the insulator at a distance of three meters and take pictures. „Precise localisation is important such that the camera recordings can also be compared across multiple inspection flights,“ explains Thomas Georg Jantos, PhD student and member of the Control of Networked Systems research group at the University of Klagenfurt. The prerequisite for this is that object-relative navigation must be able to extract so-called semantic information about the objects in question from the raw sensory data captured by the camera. Semantic information makes raw data, in this case the camera images, „understandable“ and makes it possible not only to capture the environment, but also to correctly identify and localise relevant objects.

In this case, this means that an image pixel is not only understood as an independent colour value (e.g. RGB value), but as part of an object, e.g. an isolator. In contrast to classic GNNS (Global Navigation Satellite System), this approach not only provides a position in space, but also a precise relative position and orientation with respect to the object to be inspected (e.g. „Drone is located 1.5m to the left of the upper insulator“).

The key requirement is that image processing and data interpretation must be latency-free so that the drone can adapt its navigation and interaction to the specific conditions and requirements of the inspection task in real time.

Semantic information through intelligent image processing

Object recognition, object classification and object pose estimation are performed using artificial intelligence in image processing. „In contrast to GNSS-based inspection approaches using drones, our AI with its semantic information enables the inspection of the infrastructure to be inspected from certain reproducible viewpoints,“ explains Thomas Jantos. „In addition, the chosen approach does not suffer from the usual GNSS problems such as multi-pathing and shadowing caused by large infrastructures or valleys, which can lead to signal degradation and thus to safety risks.“

How much AI fits into a small quadcopter?

The hardware setup consists of a TWINs Science Copter platform equipped with a Pixhawk PX4 autopilot, an NVIDIA Jetson Orin AGX 64GB DevKit as on-board computer and a USB3 Vision industrial camera from IDS. „The challenge is to get the artificial intelligence onto the small helicopters.

The computers on the drone are still too slow compared to the computers used to train the AI. With the first successful tests, this is still the subject of current research,“ says Thomas Jantos, describing the problem of further optimising the high-performance AI model for use on the on-board computer.

The camera, on the other hand, delivers perfect basic data straight away, as the tests in the university’s own drone hall show. When selecting a suitable camera model, it was not just a question of meeting the requirements in terms of speed, size, protection class and, last but not least, price. „The camera’s capabilities are essential for the inspection system’s innovative AI-based navigation algorithm,“ says Thomas Jantos. He opted for the U3-3276LE C-HQ model, a space-saving and cost-effective project camera from the uEye LE family. The integrated Sony Pregius IMX265 sensor is probably the best CMOS image sensor in the 3 MP class and enables a resolution of 3.19 megapixels (2064 x 1544 px) with a frame rate of up to 58.0 fps. The integrated 1/1.8″ global shutter, which does not produce any ‚distorted‘ images at these short exposure times compared to a rolling shutter, is decisive for the performance of the sensor. „To ensure a safe and robust inspection flight, high image quality and frame rates are essential,“ Thomas Jantos emphasises. As a navigation camera, the uEye LE provides the embedded AI with the comprehensive image data that the on-board computer needs to calculate the relative position and orientation with respect to the object to be inspected. Based on this information, the drone is able to correct its pose in real time.

The IDS camera is connected to the on-board computer via a USB3 interface. „With the help of the IDS peak SDK, we can integrate the camera and its functionalities very easily into the ROS (Robot Operating System) and thus into our drone,“ explains Thomas Jantos. IDS peak also enables efficient raw image processing and simple adjustment of recording parameters such as auto exposure, auto white Balancing, auto gain and image downsampling.

To ensure a high level of autonomy, control, mission management, safety monitoring and data recording, the researchers use the source-available CNS Flight Stack on the on-board computer. The CNS Flight Stack includes software modules for navigation, sensor fusion and control algorithms and enables the autonomous execution of reproducible and customisable missions. „The modularity of the CNS Flight Stack and the ROS interfaces enable us to seamlessly integrate our sensors and the AI-based ’state estimator‘ for position detection into the entire stack and thus realise autonomous UAV flights. The functionality of our approach is being analysed and developed using the example of an inspection flight around a power pole in the drone hall at the University of Klagenfurt,“ explains Thomas Jantos.

Precise, autonomous alignment through sensor fusion

The high-frequency control signals for the drone are generated by the IMU (Inertial Measurement Unit). Sensor fusion with camera data, LIDAR or GNSS (Global Navigation Satellite System) enables real-time navigation and stabilisation of the drone – for example for position corrections or precise alignment with inspection objects. For the Klagenfurt drone, the IMU of the PX4 is used as a dynamic model in an EKF (Extended Kalman Filter). The EKF estimates where the drone should be now based on the last known position, speed and attitude. New data (e.g. from IMU, GNSS or camera) is then recorded at up to 200 Hz and incorprated into the state estimation process.

The camera captures raw images at 50 fps and an image size of 1280 x 960px. „This is the maximum frame rate that we can achieve with our AI model on the drone’s onboard computer,“ explains Thomas Jantos. When the camera is started, an automatic white balance and gain adjustment are carried out once, while the automatic exposure control remains switched off. The EKF compares the prediction and measurement and corrects the estimate accordingly. This ensures that the drone remains stable and can maintain its position autonomously with high precision.

Outlook

„With regard to research in the field of mobile robots, industrial cameras are necessary for a variety of applications and algorithms. It is important that these cameras are robust, compact, lightweight, fast and have a high resolution. On-device pre-processing (e.g. binning) is also very important, as it saves valuable computing time and resources on the mobile robot,“ emphasises Thomas Jantos.

With corresponding features, IDS cameras are helping to set a new standard in the autonomous inspection of critical infrastructures in this promising research approach, which significantly increases safety, efficiency and data quality.

The Control of Networked Systems (CNS) research group is part of the Institute for Intelligent System Technologies. It is involved in teaching in the English-language Bachelor’s and Master’s programs „Robotics and AI“ and „Information and Communications Engineering (ICE)“ at the University of Klagenfurt. The group’s research focuses on control engineering, state estimation, path and motion planning, modeling of dynamic systems, numerical simulations and the automation of mobile robots in a swarm: More information

Model used:USB3 Vision Industriekamera U3-3276LE Rev.1.2

Camera family: uEye LE

Image rights: Alpen-Adria-Universität (aau) Klagenfurt

© 2025 IDS Imaging Development Systems GmbH

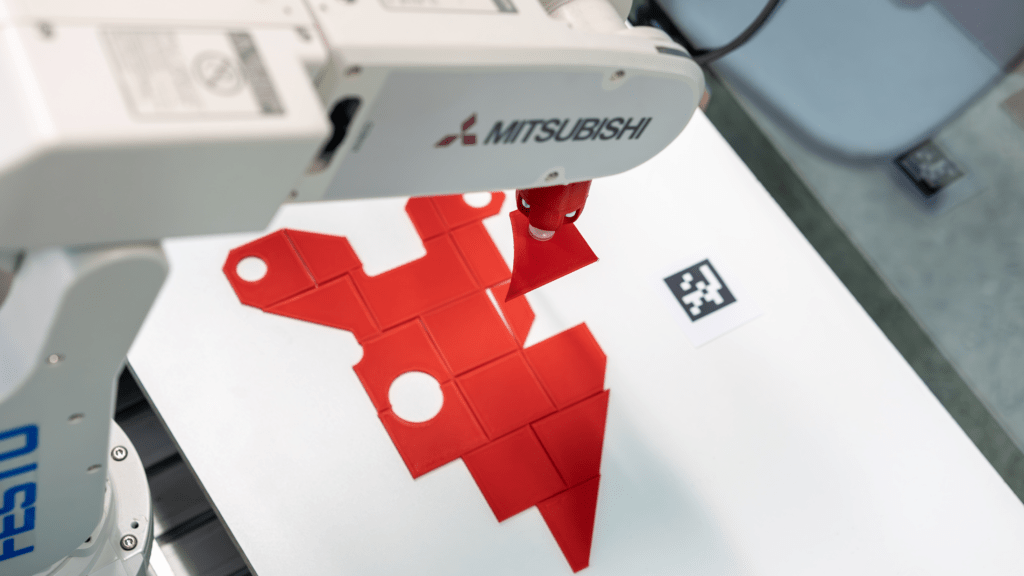

Roboter automatisiert Pick-and-Place-Prozesse mit KI-gestützter Bildverarbeitung

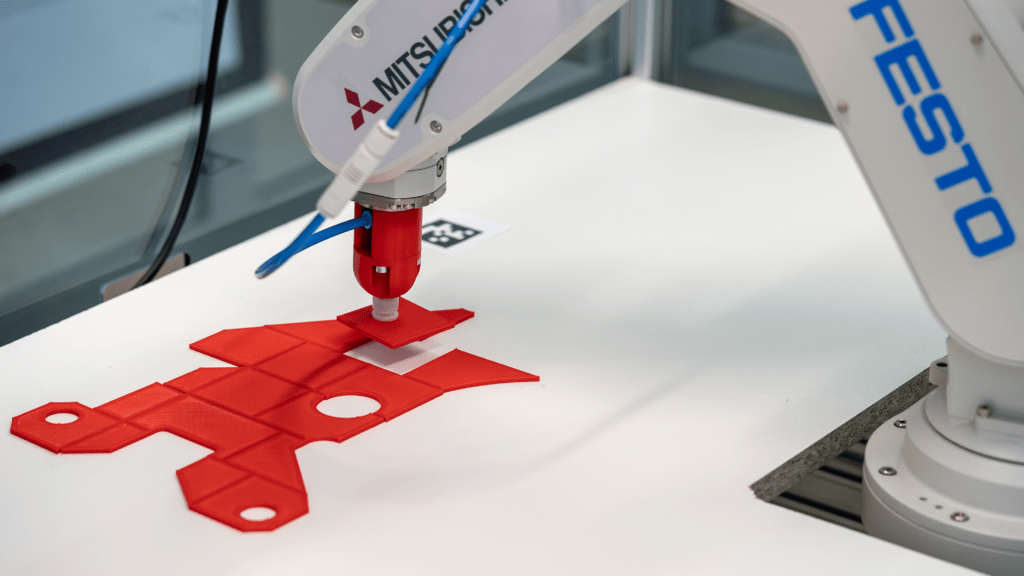

Pick-and-Place-Anwendungen sind ein zentrales Einsatzgebiet der Robotik. Sie werden häufig in der Industrie genutzt, um Montageprozesse zu beschleunigen und manuelle Tätigkeiten zu reduzieren – ein spannendes Thema für Informatik Masteranden des Instituts für datenoptimierte Fertigung der Hochschule Kempten. Sie entwickelten einen Roboter, der Prozesse durch den Einsatz von künstlicher Intelligenz und Computer Vision optimiert. Auf Basis einer Montagezeichnung ist das System in der Lage, einzelne Bauteile zu greifen und an vorgegebener Stelle abzulegen – vergleichbar mit einem Puzzle. Anschließend können die Teile dort manuell durch einen Mitarbeiter verklebt werden.

Zwei IDS Industriekameras liefern die nötigen Bildinformationen

Mithilfe von zwei uEye XC Kameras und einer KI-gestützten Bildverarbeitung analysiert das System die Umgebung und berechnet präzise Aufnahme- sowie Ablagekoordinaten. Eine der Kameras wurde dazu über der Arbeitsfläche platziert, die andere über der Entnahmestelle. Konkret verarbeitet eine KI-Pipeline die Bilder der beiden Kameras in mehreren Schritten, um die exakte Lage und Ausrichtung der Objekte zu bestimmen. Mithilfe der Computer-Vision-Algorithmen und neuronalen Netzen erkennt das System relevante Merkmale, berechnet die optimalen Greifpunkte und generiert präzise Koordinaten für die Aufnahme und Ablage der Objekte. Zudem identifiziert das System die Teile eindeutig, indem es ihre Oberfläche segmentiert und die Konturen mit einer Datenbank abgleicht. Darüber hinaus nutzt es die Ergebnisse, um eine Annäherung an bereits abgelegte Teile zu ermöglichen. Die Automatisierungslösung reduziert damit die Abhängigkeit von Expertenwissen, verkürzt Prozesszeiten und wirkt dem Fachkräftemangel entgegen.

Kameraanforderungen

Schnittstelle, Sensor, Baugröße und Preis waren die Kriterien, die für die Wahl des Kameramodells entscheidend waren. Die uEye XC kombiniert die Benutzerfreundlichkeit einer Webcam mit der Leistungsfähigkeit einer Industriekamera. Sie erfordert lediglich eine Kabelverbindung für den Betrieb. Ausgestattet mit einem 13-MP-onsemi-Sensor (AR1335) liefert die Autofokus-Kamera hochauflösende Bilder und Videos. Eine wechselbare Makro-Aufsatzlinse ermöglicht eine verkürzte Objektdistanz, wodurch die Kamera auch für Nahbereichsanwendungen geeignet ist. Auch ihre Einbindung war denkbar einfach, wie Raphael Seliger, Wissenschaftlicher Mitarbeiter der Hochschule Kempten, erklärt: „Wir binden die Kameras über die IDS peak Schnittstelle an unser Python Backend an.“

Ausblick

Zukünftig soll das System durch Reinforcement Learning weiterentwickelt werden – einer Methode des maschinellen Lernens, die auf Lernen durch Versuch und Irrtum beruht. „Wir möchten gerne die KI-Funktionen ausbauen, um die Pick-and-Place Vorgänge intelligenter zu gestalten. Unter Umständen benötigen wir dafür eine zusätzliche Kamera direkt am Roboterarm“, erläutert Seliger. Geplant ist zudem eine automatische Genauigkeitsprüfung der abgelegten Teile. Langfristig soll der Roboter allein anhand der Montagezeichnung alle erforderlichen Schritte eigenständig ausführen können.

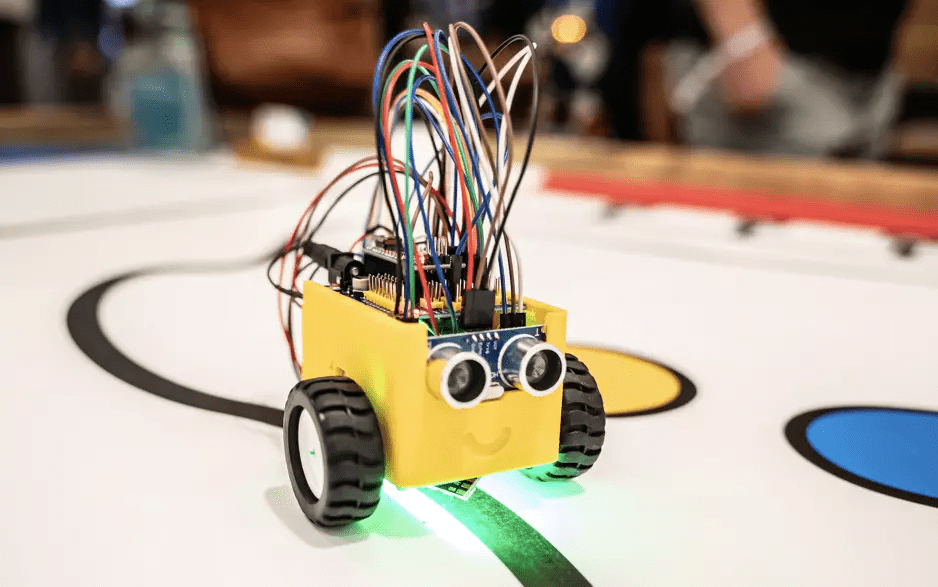

Maker-Bewegung prägt die digitale Transformation

Hannover, 25. März 2025 ‒ Was in einer kalifornischen Garage begann, prägt heute die globale Innovationslandschaft: 2025 feiert das US-Make-Magazin sein 20-jähriges Bestehen und gleichzeitig die Maker-Bewegung als bedeutenden Treiber der digitalen Transformation. Die deutsche Maker Faire in Hannover ist nach San Francisco und Rom zur drittgrößten weltweit gewachsen und lockte in über 10 Jahren mehr als 140.000 Besucher an.

„Die Maker-Bewegung existierte schon immer, aber erst das Make Magazin gab ihr 2005 einen Namen und eine Identität”, erklärt Dale Dougherty, Gründer des US-Make-Magazins. Was als Zeitschrift begann, entwickelte sich schnell zu einem globalen Phänomen: Seit der ersten Maker Faire 2006 fanden weltweit 1.497 Events mit über 131.000 ausstellenden Makern und mehr als 7,6 Millionen Teilnehmern statt.

Die deutsche Erfolgsgeschichte begann 2011 mit „c’t Hardware Hacks”, dem Vorläufer des heutigen Make-Magazins . „Die Maker-Bewegung hat eine neue Form der Produktionsorganisation etabliert, die auf Internet und Peer-Netzwerken basiert. Durch den offenen Zugang zu digitalen Fertigungstechnologien ist eine moderne, demokratische Innovationskultur entstanden”, erklärt Daniel Bachfeld, Chefredakteur des deutschen Make-Magazins. „Jeder kann heute mit 3D-Druckern, Laser-Cuttern und Open-Source-Elektronik eigene Produkte entwickeln und herstellen.“

In FabLabs und Makerspaces entstehen neue Produktionsinfrastrukturen, die intelligente Robotik mit kollaborativen Arbeitsweisen verbinden. Der „Do-It-With-Others”-Ansatz führt zu einer dezentralen, lokalen Fertigung. Dabei entwickeln sich flexible Wertschöpfungsketten, die durch moderne Software gesteuert werden.

Die Bewegung prägt auch die Bildungslandschaft: „Making verbindet digitale und handwerkliche Fähigkeiten und fördert kreative Problemlösung”, sagt Bachfeld. Immer mehr Schulen und Universitäten integrieren Maker-Projekte in ihre Lehrpläne oder eröffnen genau wie viele Bibliotheken eigene Makerspaces.

Auch im Make-Magazin wird der Bildungsansatz forciert: In Kooperation mit dem Schweizer Hersteller Oxon entstand beispielsweise das Make Innovators Kit mit Playbook. Gemeinsam mit dem Umweltcampus der Hochschule Trier wurde das Makey:Lab entwickelt, das Schülern ab 14 Jahren den Einstieg in digitale Umweltforschung und Programmierung ermöglicht.

Die Maker Faire Hannover hat sich seit 2013 als inspirierender Ideenpool etabliert. „Der Mix aus Wissenschaftsmesse und buntem DIY-Festival bringt Menschen jeden Alters und Hintergrunds zusammen, um die vielseitigen Kreationen zu präsentieren oder zu bestaunen – von selbstgebauten Robotern bis zu kinetischen Skulpturen”, unterstreicht Daniel Rohlfing, Leiter Events & Sales Maker Faire Deutschland. “Auch die MINT-Bildung kommt nicht zu kurz. Kinder und Jugendliche werden auf der Maker Faire für die digitale Welt, IT, KI und Technik nachhaltig begeistert”.

Seit vielen Jahren übernimmt das Bundesbildungsministerium die Schirmherrschaft für die Maker Faire, für Rohlfing ein großes Zeichen der Wertschätzung.

Die nächste Maker Faire Hannover findet am 23. und 24. August 2025 im Hannover Congress Centrum statt, der Call for Makers ist noch bis Ende Mai geöffnet, auch Unternehmen können sich für eine Teilnahme anmelden.

Im DACH-Raum wächst die Bewegung ebenfalls: Die Maker Faire Ruhr lädt für den 29. und 30. März in die DASA Arbeitswelt Ausstellung nach Dortmund ein. In der Schweiz öffnet die Maker Faire Solothurn am 28. und 29. Juni 2025 ihre Tore in der Enter Technikwelt.

Vention stellt KI-gestützte Bin-Picking-Technologie vor – Live auf der NVIDIA GTC 2025

SAN JOSÉ, Kalifornien, 18. März 2025 /PRNewswire/ — Vention, Entwickler der weltweit einzigen Full-Stack-Software- und Hardware-Automatisierungsplattform, präsentiert seine KI-gestützte Bin-Picking-Technologie erstmals auf der NVIDIA GTC, der weltweit führenden Entwicklerkonferenz für Künstliche Intelligenz (KI).

Dieses neue, KI-gesteuerte Verfahren ersetzt aufwendige und kostenintensive individuelle Programmierlösungen und erleichtert Unternehmen die Einführung von Automatisierungstechnologie. Die Markteinführung der KI-gestützten Bin-Picking-Technologie ist im weiteren Verlauf des Jahres geplant.

In einer Live-Demonstration wird ein ABB GoFa™ CRB 15000-Roboter – ausgestattet mit einem Vision-System, Finger-Greifern und verbunden mit einem Vention MachineMotion AI-Controller – seine autonomen Fähigkeiten unter Beweis stellen. Mithilfe einer hochgeladenen CAD-Datei des zu verarbeitenden Bauteils versteht der Roboter, wie er das Bauteil erkennen, auswählen, greifen und mit branchenführender Präzision organisieren kann. Diese autonome Funktionalität wird durch leistungsstarke KI-Modelle ermöglicht.

„KI entwickelt sich in rasantem Tempo weiter und hilft Vention dabei, Automatisierung für Unternehmen jeder Größe noch zugänglicher zu machen“, erklärt Etienne Lacroix, Gründer und CEO von Vention. „Unsere neueste Innovation, die Hardware-Integration mit NVIDIA-KI-Modellen kombiniert, geht über reines Identifizieren und Greifen hinaus – sie fügt Intelligenz und Organisation hinzu, wodurch teure Integrations- und Programmieraufwände reduziert werden. Das macht Bin-Picking-Automatisierung für Hersteller erschwinglicher.“

„Generative KI und Simulationstechnologien haben einen Wendepunkt erreicht, um physische KI-Anwendungen in der Produktion voranzutreiben“, sagt Deepu Talla, VP of Robotics bei NVIDIA. „Mit der NVIDIA Isaac Robotics-Plattform bringt Vention die neuesten KI-Innovationen in Fabriken jeder Größe – sowohl für High-Mix- als auch für High-Volume-Fertigung.“

Entdecken Sie hier das KI-gestützte Bin-Picking-Demo-Video.

KI zur Lösung realer Herausforderungen

Die Demonstration ist Teil eines laufenden Entwicklungsprojekts mit McAlpine & Co. Ltd, einem langjährigen Vention-Kunden und führenden britischen Hersteller von Sanitärprodukten mit über 100 Jahren Erfahrung. Das Unternehmen sucht nach einer Automatisierungslösung für Bin-Picking und Maschinenbestückung.

John Gordon, General Manager von McAlpine & Co. Ltd, betont die Herausforderungen, die mit der Automatisierung des Bin-Picking-Prozesses verbunden sind, obwohl es sich auf den ersten Blick um eine einfache Aufgabe handelt: „McAlpine & Co. Ltd war auf der Suche nach einem Automatisierungspartner, dem wir vertrauen können, um unsere Vision umzusetzen: innovative Lösungen, die unseren hohen Qualitätsstandards entsprechen. Im Zentrum dieser Vision steht eine kollaborative Arbeitsumgebung, in der Maschinen arbeitsintensive und repetitive Aufgaben übernehmen, sodass sich unsere Mitarbeiter auf wertschöpfende Tätigkeiten konzentrieren können. Nach dem erfolgreichen Abschluss unseres ersten Automatisierungsprojekts mit Vention sind wir überzeugt, dass nun der richtige Zeitpunkt gekommen ist, um gemeinsam eine hochmoderne, KI-gestützte Bin-Picking-Lösung zu entwickeln.“

Vention Intelligence – Schnellere Wertschöpfung für Hersteller

Der MachineMotion AI-Controller von Vention, basierend auf der NVIDIA Jetson Orin Module-on-Compute-Plattform, bildet das Rückgrat der neuen Entwicklung – er ermöglicht die Echtzeitverarbeitung, die für eine autonome Bin-Picking-Automatisierung im industriellen Maßstab erforderlich ist. Dieses Steuerungssystem geht über herkömmliche SPS-basierte Automatisierung hinaus und verkürzt die Implementierungszeit erheblich.

Durch die Integration modernster, KI-gestützter NVIDIA Isaac CUDA-Bibliotheken und Modelle wie FoundationPose stellt Vention sicher, dass Hersteller von den neuesten KI-Fortschritten profitieren, die jetzt in den Markt eintreten.

„Unsere Strategie, KI-Technologien nahtlos in bestehende Automatisierungslösungen zu integrieren, stellt sicher, dass wir neue Modelle schnell in unsere schlüsselfertigen und anpassbaren Arbeitszellen einbinden können – und damit unseren Kunden aus der Fertigungsindustrie einen Wettbewerbsvorteil verschaffen.“ – François Giguère, Chief Technology Officer bei Vention.

Für weitere Informationen besuchen Sie: www.vention.com/autonomous-operator

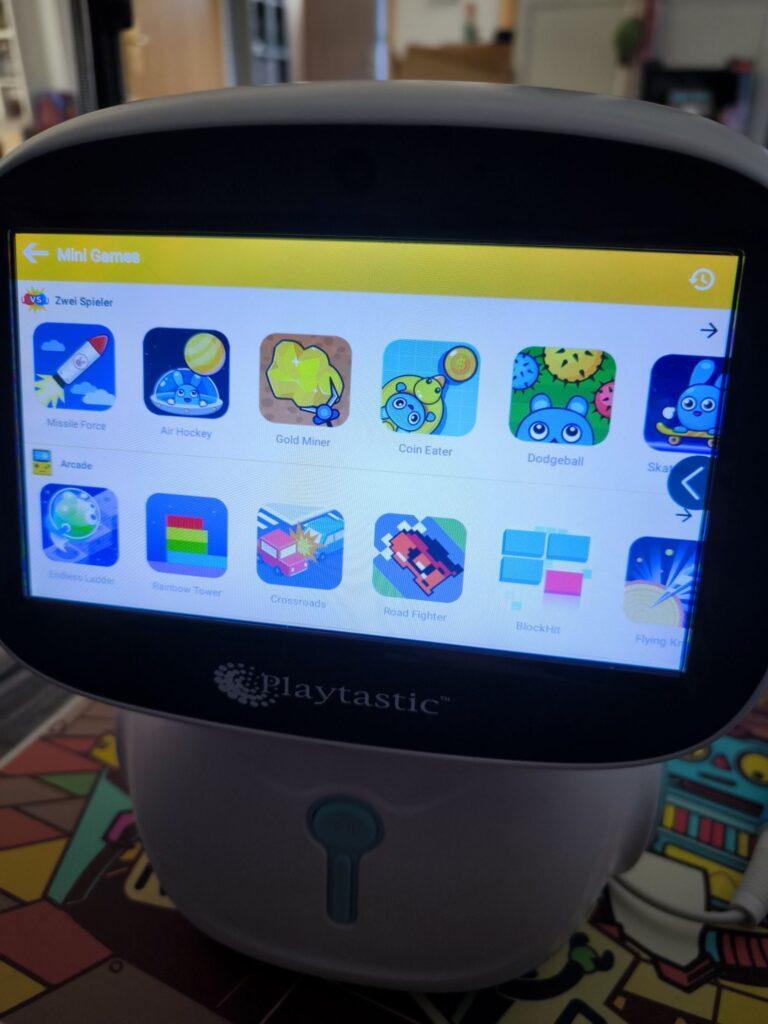

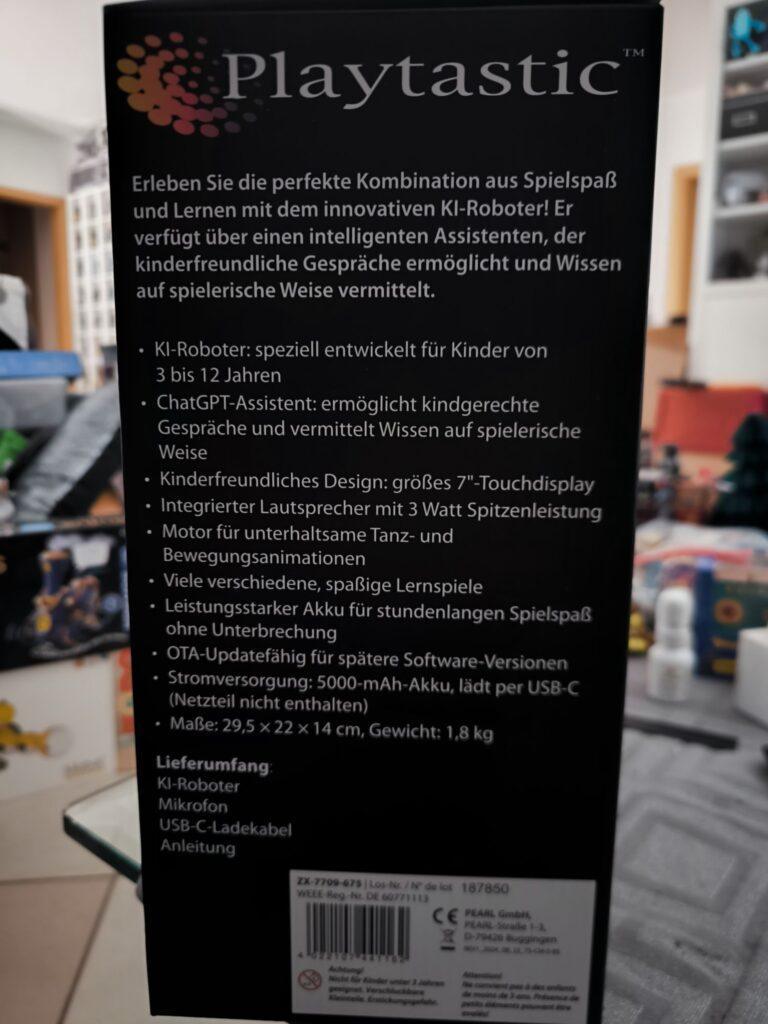

Playtastic KI-Roboter mit ChatGPT-Assistent

Nach dem Auspacken des Roboters hatte ich den Eindruck, ein Tablet auf Rädern zu meiner Robotersammlung hinzuzufügen. Der kleine Roboter, der sich selbst „Anna“ nennt, wie ich später herausfinden sollte, hatte auf jeden Fall ein Android-Tablet als Gesicht. Ein Tablet-Roboter.

Nach dem Einschalten erwartete mich jedoch nicht der übliche Einrichtungsprozess, wie er bei Android-Geräten üblich ist. Stattdessen wurde ich mit Musik und einem kurzen Animationsvideo begrüßt. Danach landete ich, nach einer kurzen Wartezeit (die nur beim ersten Start auftrat), auf einer kindlich-verspielten App-Übersicht. Meine erste Idee war, im Einstellungsmenü zunächst eine Verbindung zum WLAN herzustellen. Im Handbuch hatte ich bereits gelesen, dass der Roboter nur mit einem 2,4-GHz-WLAN kompatibel ist. Das WLAN meiner FritzBox arbeitet im Dual-Mode und stellt sowohl ein 5-GHz- als auch ein 2,4-GHz-Signal zur Verfügung. Der Roboter fand dieses WLAN, fragte nach dem Passwort, bestätigte die richtige Eingabe und verband sich – allerdings nur für wenige Sekunden, bevor er wieder „nicht verbunden“ anzeigte. Anscheinend mag er ausschließlich reines 2,4-GHz-WLAN. Nachdem ich mein reines 2,4-GHz-WLAN ausgewählt hatte, gab es keine weiteren Verbindungsprobleme.

Die Android-Betriebssystemversion und die installierten Apps waren anscheinend aktuell; zumindest wurden keine Updates gefunden. Neben den vorinstallierten Lern-, Musik- und Spiele-Apps fielen mir direkt die YouTube-(Kids)- und Spotify-App auf. Hier ahnte ich auch etwas Spaß für Erwachsene!

Der erste Start der YouTube-App (nachdem das WLAN eine Internetverbindung bot) forderte leider ein Update der Google-Dienste, was wiederum die Anmeldung mit einem Google-Konto erforderte. Macht es besser nicht wie ich und legt kein neues Google-Konto direkt über das Display des Roboters an. Nutzt stattdessen einen Computer oder euer Smartphone und gebt dem Roboter anschließend nur die Zugangsdaten. Das geht deutlich schneller als über das etwas träge „Tablet“ des Roboters.

Nach der Anmeldung gelang dann auch der Start der YouTube-App. Dabei stellte ich fest, dass es sich um die YouTube-Kids-App handelte, die ich bisher nicht kannte. Die App bietet kindgerechte Videos für verschiedene Altersstufen, aber nicht das vollwertige YouTube-Erlebnis, wie man es beispielsweise vom Fernseher kennt. Es können verschiedene Kinder-/Nutzerprofile angelegt werden, und mit einem „Eltern-Account“ lässt sich genau steuern, welche Videos und Kanäle verfügbar sind oder ob das Kind eigenständig andere Kanäle suchen darf.

Für erwachsene Nutzer bleiben immerhin alle Spotify-Inhalte verfügbar. Die vorinstallierte Spotify-App funktioniert identisch zu der Version auf meinem Smartphone. Der Klang des Roboters ist laut und basslastig; manchmal hört man dadurch das Plastikgehäuse etwas vibrieren. Für Kinder und ältere Karaoke-Fans gibt es in der App „KinderFernsehen“ eine Karaoke-Videosammlung. Ein mitgeliefertes Mikrofon lässt sich an der Rückseite des Roboters einstecken. Nach dem Einschalten des Mikrofons wird der eigene Gesang mit ordentlich Hall-Effekt durch den Roboter wiedergegeben. Ein Anschluss für ein zweites Mikrofon für Duett-Partner ist ebenfalls vorhanden; allerdings wird nur ein Mikrofon mitgeliefert – ein Tablet-Karaoke-Musik-Video-Roboter.

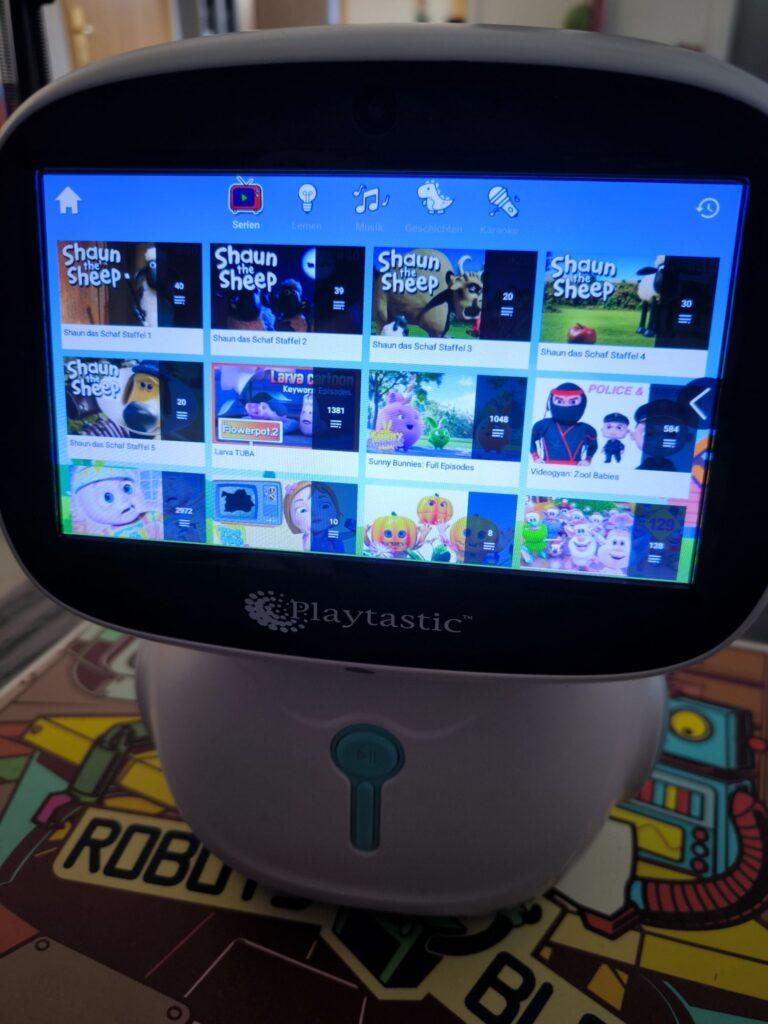

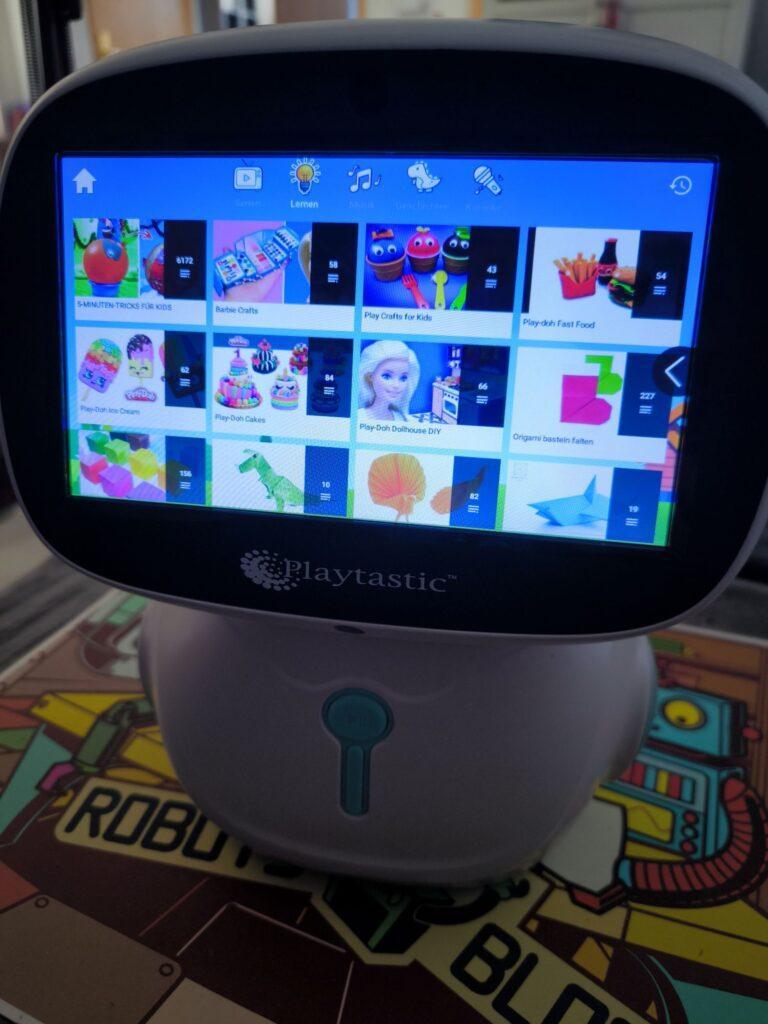

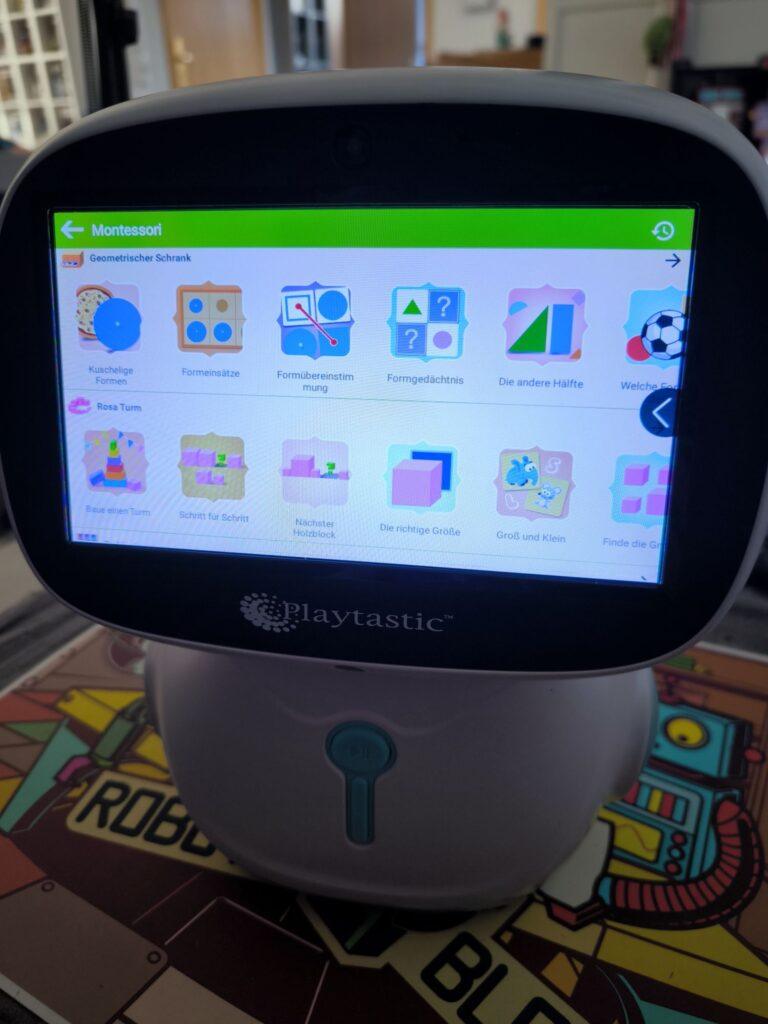

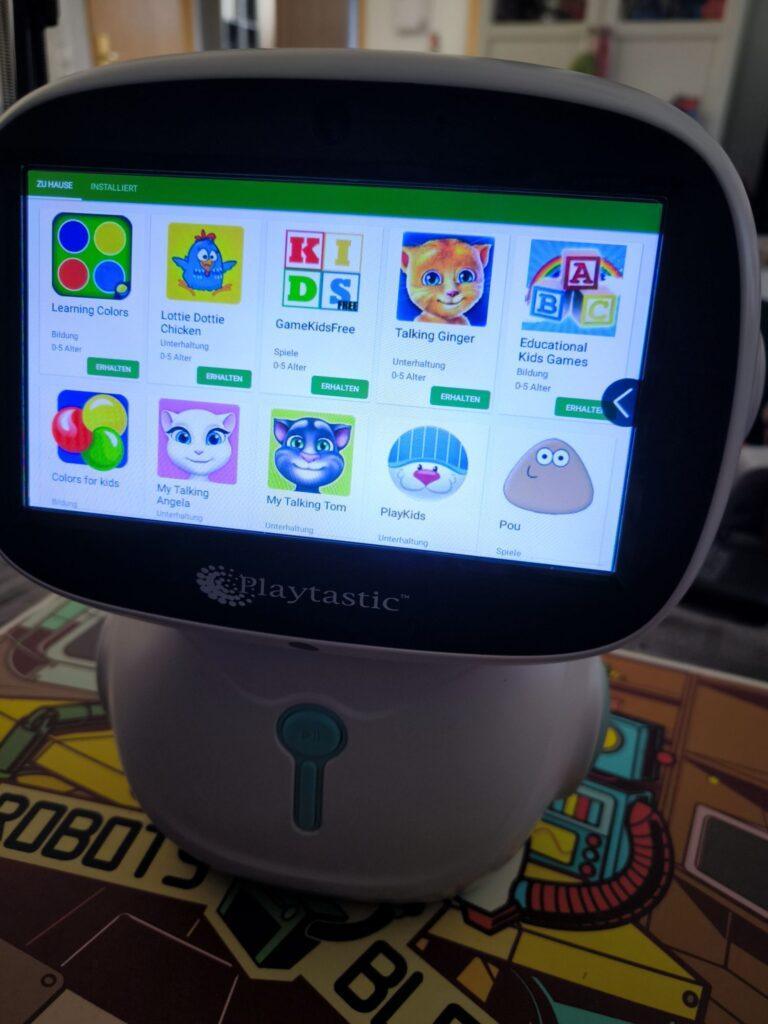

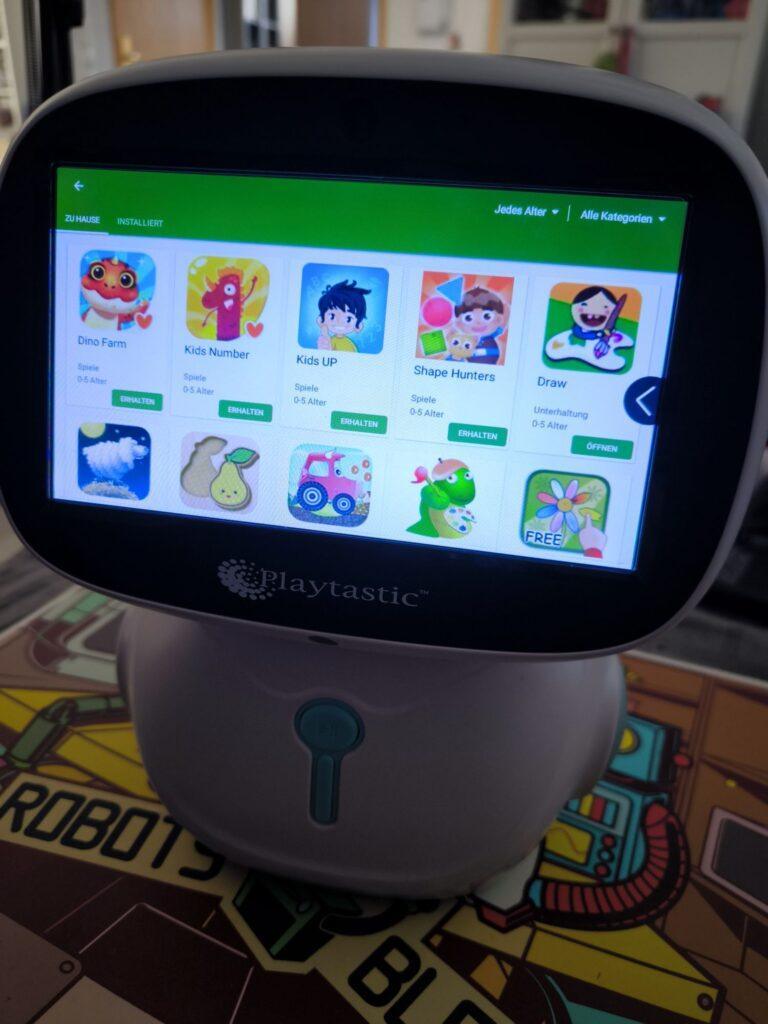

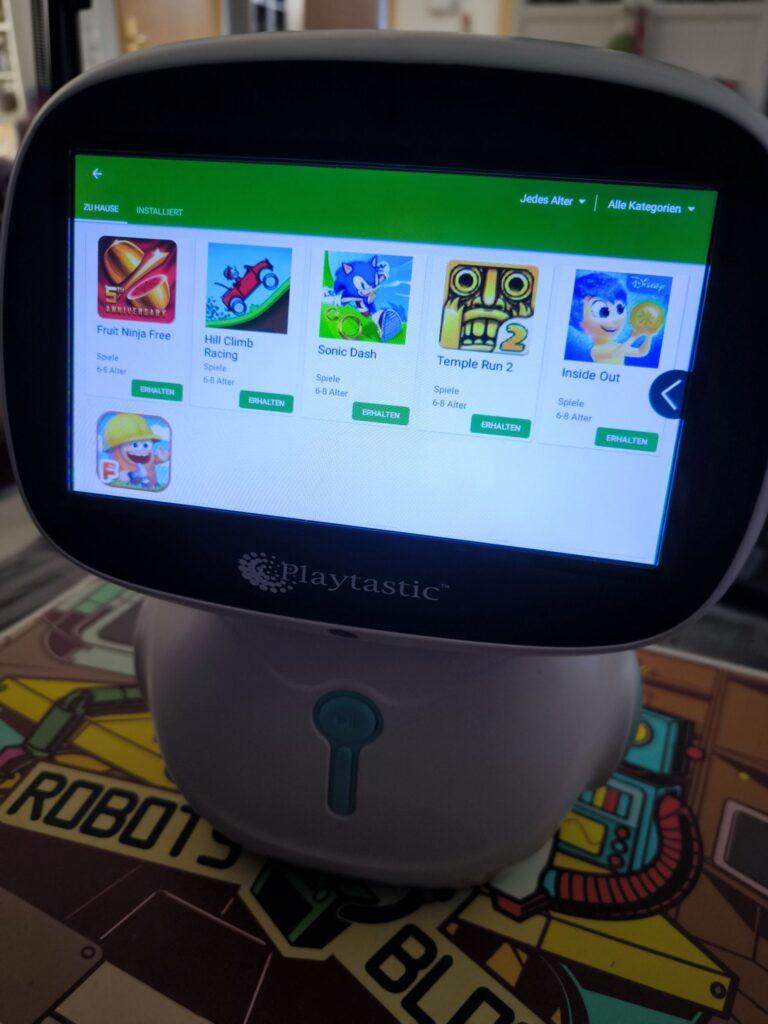

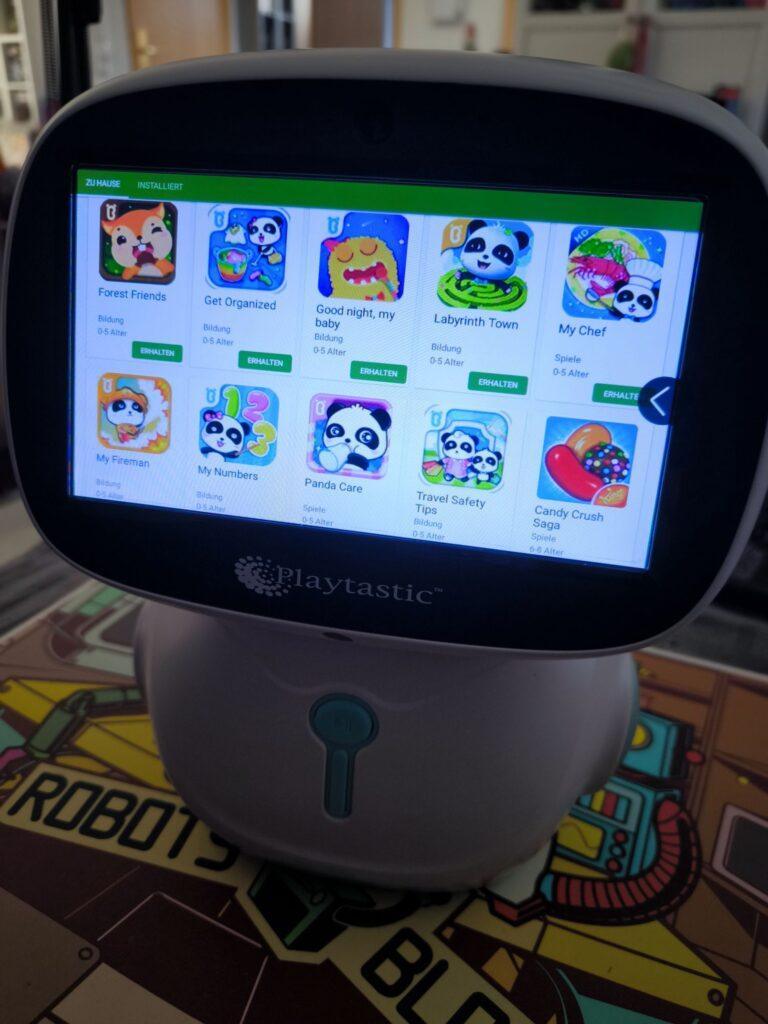

In der KinderFernsehen-App finden sich bekannte Videoreihen (wie Shaun das Schaf), Musik- und Lerninhalte sowie Spiele. Außerhalb dieser App gibt es die üblichen Anwendungen wie Wecker, Stoppuhr oder Bildergalerie sowie diverse weitere Lern-Apps: Rechnen, Malen, Schreiben, Musizieren oder Sprachen lernen – für fast alles gibt es eine App. Und wenn nicht, bietet der „Kinderladen“ eine abgespeckte Version des App-Stores mit Spielen, Lern-Apps und anderen kinderfreundlichen Inhalten. Ein Tablet-Karaoke-Musik-Video-Lern-Roboter also! Andere Android-Apps lassen sich hier jedoch nicht finden. Mir ist es auch nicht gelungen, fremde Apps zu installieren – weder per SD-Karte noch per Browser-Download –, da der integrierte Browser nur vorher freigegebene Webseiten öffnet. Wie man diese hinzufügt, habe ich nicht herausgefunden. Im PIN-geschützten „Elternmodus“ konnte ich zwar installierte Apps ausblenden (quasi vor Kindern verstecken), aber keine neuen Apps „sideloaden“. Es gibt einen erweiterten Modus, der nach mehrfachem Tippen auf die Versionsnummer des Roboters in den Einstellungen erscheint – leider geschützt durch ein mir unbekanntes Passwort. Was sich wohl dahinter verbirgt? Vielleicht die Möglichkeit zum Installieren eigener Apps?

Die App „Musik und Tanz“ öffnet einen Musikplayer, mit dem MP3s – auch von einer eingesteckten SD-Karte – abgespielt werden können. Der Unterschied zur normalen „Musik“-App: Der Roboter tanzt zur abgespielten Musik und fährt mehr oder weniger wild „tanzend“ durch die Gegend. Ich hätte mir an dieser Stelle gewünscht, eigene Bewegungsabläufe programmieren zu können – oder sogar eine Lern-App, die mir das Programmieren des Roboters beibringt und die Möglichkeiten der integrierten Motoren meines „Roboter-Tablets“ nutzbar macht. Vielleicht sogar in Kombination mit der integrierten Kamera einen Linienfolger programmieren? Vielleicht wird hierfür ja irgendwann noch eine passende App entwickelt.

Die integrierte Kamera lässt sich zum Aufnehmen von Fotos und Videos in niedriger Auflösung nutzen. Leider habe ich keine App gefunden, die die Kamera für Bewegungsspiele nutzt – so wie beim Miko 3-Roboter bekannt. Vielleicht dürfen wir auch hier noch auf Erweiterungen per App hoffen?

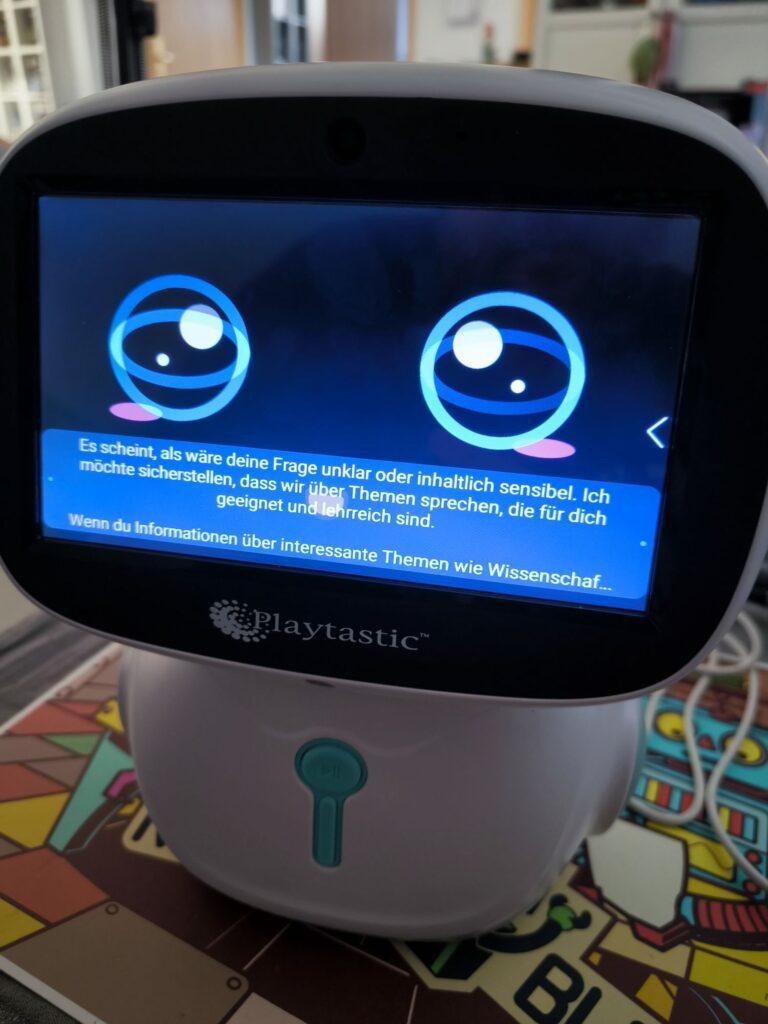

Und dann gibt es noch den ChatGPT-Assistenten-Modus: Auf dem Display erscheint ein Robotergesicht, mit dem man sich auch ohne eingestecktes Mikrofon unterhalten kann. Die Antworten kommen dabei nach etwas Verzögerung von einer ChatGPT-Instanz. Diese scheint auf Unterhaltungen mit Kindern spezialisiert zu sein und schlägt automatisch Themen wie Dinosaurier, Weltraum oder Tiere vor. Jede Antwort liefert direkt Ideen für neue Nachfragen oder Themenvorschläge und führt so aktiv durch das Gespräch. Die ChatGPT-Instanz hat keinen Zugriff auf aktuelle Online-Inhalte und ist ausreichend moderiert: Nicht kindgerechte Themen werden in vielen Fällen ignoriert oder übergangen. Zu genaue Nachfragen oder geschicktes Prompting können jedoch manchmal zumindest fragwürdige Inhalte liefern – allerdings bleiben aktiv vorgeschlagene Themen stets kindgerecht (besonders gerne Dinosaurier). Auch Rekorde aus der Tierwelt oder Umweltphänomene werden als Gesprächsthemen vorgeschlagen.

Ein Tablet-Karaoke-Musik-Video-Lern-KI-Assistenten-Roboter.

Der Roboter ist ein vielseitiges Spielzeug mit gut funktionierenden vorinstallierten Apps. Für Erwachsene gibt es nur wenige Inhalte; diese sind hier aber definitiv nicht die Zielgruppe. Als auffälliger Spotify-Player mit einigen Zusatzfeatures ist der Roboter jedoch auch für Erwachsene interessant – erwartet aber keine Höchstleistung vom integrierten Tablet! Es ist eindeutig nur für die mitgelieferten Apps ausgelegt; diese sind dafür kindgerecht und sicher … solange man keine allzu neugierigen Fragen an den ChatGPT-Assistenten stellt. Insgesamt handelt es sich um ein lehrreiches Spielzeug für Kinder – auch um erste Erfahrungen im Umgang mit KI zu sammeln. Für den Preis bekommt man sonst nur ein günstiges Tablet; hier gibt es jedoch gleich einen ganzen Roboter dazu!

Noch schneller zum günstigen Robotiksystem: Neuer KI-Roboterberater für RBTX.com ist online

Interaktiver KI-Berater nutzt Anwendungsdatenbank und verkürzt die Suche nach Komponenten für kostengünstige Roboterlösungen

Köln, 11. Dezember 2024 – igus hat die Online-Plattform RBTX.com um einen neuen KI-Chatbot erweitert. Der interaktive Berater soll es Unternehmen mit wenig Vorerfahrung und technologischem Know-how ermöglichen, schnell und sicher Low-Cost-Automationslösungen zusammenzustellen, um ihre Wettbewerbsfähigkeit zu stärken. Erste User zeigen sich von der intuitiven KI-Lösung begeistert.

Viele Unternehmen wissen bereits, dass Automation enorme Potenziale bietet, um den Herausforderungen einer sich schnell verändernden Arbeitswelt zu begegnen. Doch die entscheidende Frage bleibt: Wie setzt man sie um? RBTX liefert die Antwort: Auf dem Online-Marktplatz finden sich über 500 Roboterlösungen, von denen 95 Prozent weniger als 12.000 Euro kosten. Hier können auch Unternehmen ohne Vorkenntnisse in der Robotik kostengünstige Low-Cost-Automation-Lösungen (LCA) nach dem Plug-and-Programme-Prinzip zusammenstellen. „Mit RBTX wollen wir Schritt für Schritt alle Barrieren aus dem Weg räumen, die Unternehmen beim Einstieg in die Automation im Weg liegen“, sagt Alexander Mühlens, Prokurist und Leiter Geschäftsbereich Low-Cost-Automation bei igus. Entscheidend ist hier beispielsweise, für eine garantierte Interoperabilität aller angebotenen Komponenten zu sorgen, die Fehlkäufe nahezu unmöglich macht. „Ein weiterer Schritt auf diesem Weg ist nun die Einführung eines neuen KI-Beraters, der mit Interessierten in Interaktion tritt, um die Suche nach Komponenten in einem immer größer werdenden Sortiment zu verkürzen.“

KI-Berater arbeitet mit Erfahrungsdaten hunderter erfolgreicher LCA-Projekte

Der neue KI-Chatbot auf https://chat.rbtx.de unterstützt Nutzer durch eine schriftliche Interaktion dabei, passende LCA-Komponenten zu finden. Dabei greift die Künstliche Intelligenz auf die Erfahrungsdaten von hunderten Projekten zurück, die Unternehmen mithilfe von RBTX bereits erfolgreich automatisiert haben. Entsprechend zielführend sind die Antworten. Ein Beispiel: Eine kleine Werkstatt leidet unter Arbeitskräftemangel und möchte die Beladung ihrer CNC-Maschine mit Rohlingen automatisieren. Der Technikleiter des Betriebs bemüht den neuen KI-Chatbot und stellt ihm die Frage: „Welcher Roboter eignet sich für die Beladung meiner CNC-Maschine?“ Innerhalb weniger Sekunden liefert die KI die Antwort: „Der robolink Roboterarm von igus wäre hier eine geeignete Lösung. Der Arm bewegt sich über fünf Achsen, hat eine Reichweite von 790 Millimetern, eine Geschwindigkeit von sieben Picks pro Minute und kann die Lage der Bauteile mithilfe einer 3D-Kamera wahrnehmen. Der Preis beginnt bei 2.766 Euro.“ Nach dieser Antwort fragt der Nutzer, welcher Greifer passend wäre. Der KI-Berater antwortet: „Ein Parallelgreifer von Zimmer wäre eine geeignete Wahl.“ In einem solchen natürlich anmutenden Dialog stellen sich Nutzer sukzessive ihre individuelle LCA-Lösung zusammen.

„Erste Nutzer zeigen sich vom neuen KI-Berater begeistert“

Unternehmen, die mit Automation experimentieren, geben sich vom neuen KI-Chatbot begeistert. „Viele Kunden haben uns bereits das Feedback gegeben, dass sie mit dem KI-Roboterberater in einen Dialog getreten sind. Er hat ihnen ein besseres Gespür für die Möglichkeiten der Low-Cost-Automation gegeben und die Suche nach den passenden Komponenten wesentlich beschleunigt“, freut sich Mühlens. „Wir planen deshalb, den KI-Berater in Zukunft um zusätzliche Funktionen zu erweitern.“ So soll es beispielsweise möglich sein, dass der Berater Bilder und Videomaterial von Referenzen in seine Antworten einbettet und LCA-Komplettlösungen mit einem Richtpreis entwickeln kann.